hxwfromdjtu / blog Goto Github PK

View Code? Open in Web Editor NEW🌈 技术博客,记录日常工作学习的整理~欢迎star

🌈 技术博客,记录日常工作学习的整理~欢迎star

select select/poll epoll

摘自《NodeJS深入浅出》

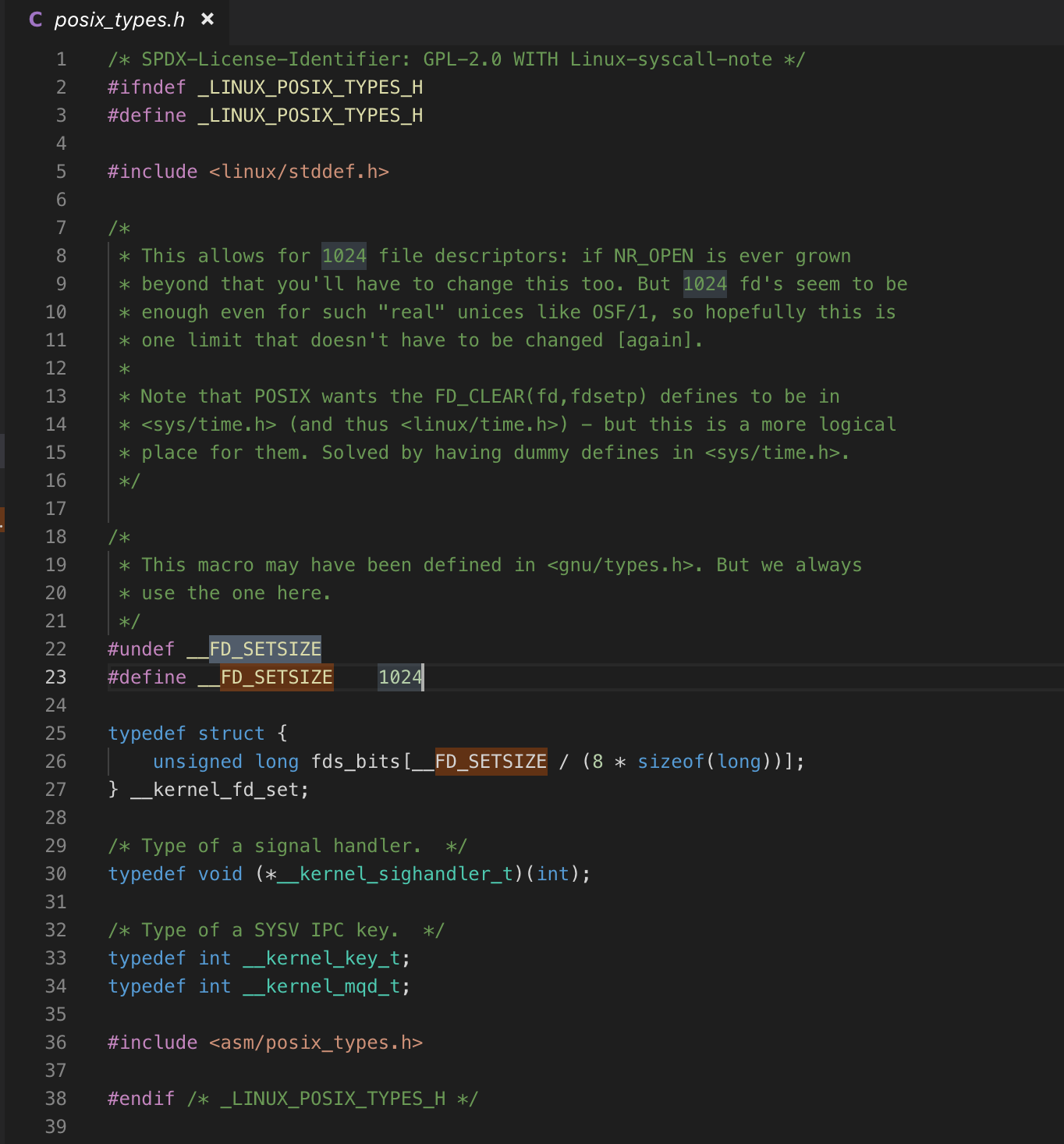

select poll epoll都是I/O多路复用的一种机制。fd_set到�内核空间__pollwait函数,I/O操作的过程中,当前进程就被挂在等待队列中,直到操作完成,当前进程就再次被释放出来socket_poll方法,进而根据情况调用tcp_poll,udp_poll或者datagram_poll。若fd_set很大的时候,操作开销会特别大。poll机制和select运行的机制上没有区别,但是poll是基于l链表来存储的文件描述符,所以没有最大连接数的限制。epoll既然是以上两种方案的改进版,自然没有以上方案的缺点。

epoll_create:用于创建一个epoll句柄epoll_ctl:用于注册要�监听的事件类型epoll_wait:则是等待事件的发生重复拷贝" 那么在Windows平台下的状况如何呢?而实际上,Windows有一种独有的内核异步IO方案:IOCP。IOCP的思路是真正的异步I/O方案,调 用异步方法,然后等待I/O完成通知。IOCP内部依旧是通过线程实现,不同在于这些线程由系统内核接手管理。IOCP的异步模型与Node.js的异步 调用模型已经十分近似。"

以上文字摘自《异步I/O - NodeJS深入浅出 第三章》

[1] select、poll、epoll之间的区别总结[整理]

[2] Java 与 NIO

[3] 《异步I/O - NodeJS深入浅出 第三章》

[4] IO模型及select、poll、epoll和kqueue的区别

前面一篇文章聊过了最常用的跨域手段 CORS (跨域资源共享)。这次再看看工作中其他的跨域资源获取手段,proxy 和 JSONP。

同源策略的是浏览器本身管理资源的安全策略,并且以域来划分管理。但是当企业发展、业务变得繁杂之后,一个页面需要的资源来源,可能是数十个。

与每个接口的提供方进行进行沟通,让其进行在响应中添加对应的 Access-Controll-Allow-xxxx 的响应头是在过于繁琐,万一自己网站的域名做了调整,又需要对所有的接口提供方进行更新。

通过一个中间服务器为我们的 web服务 进行请求转发。Proxy 与数据接口之间可以直接调用,Proxy Server 与 web应用 之间且存在的跨域问题,只需要使用一次 跨域响应头 的设置即可。

Proxy Server 是一个最简化的 http Server,不进行任何的业务处理,只对请求原封不动地转发,对相应数据也原封不动地返回给请求方。

常用的实际方案是 Node.js 转发 与 nginx 转发,为啥选她俩?因为足够轻量足够快,前端可以闭环。

cors-anywhere 是一个开箱即用的 Node.js 转发服务,专门为中转请求而设计。前端开发将其部署到自己的服务器上

return axios.get('https://cors-anywhere.your-server.com/https://api.other-domain.com/price', {

params: { ids: tokens.join(',') },

withCredentials: false,

})#进程, 可更具cpu数量调整

worker_processes 1;

events {

#连接数

worker_connections 1024;

}

http {

include mime.types;

default_type application/octet-stream;

sendfile on;

#连接超时时间,服务器会在这个时间过后关闭连接。

keepalive_timeout 10;

# gizp压缩

gzip on;

# 直接请求nginx也是会报跨域错误的这里设置允许跨域

# 如果代理地址已经允许跨域则不需要这些, 否则报错(虽然这样nginx跨域就没意义了)

add_header Access-Control-Allow-Origin *;

add_header Access-Control-Allow-Headers X-Requested-With;

add_header Access-Control-Allow-Methods GET,POST,OPTIONS;

# srever模块配置是http模块中的一个子模块,用来定义一个虚拟访问主机

server {

listen 80;

server_name localhost;

# 根路径指到index.html

location / {

root html;

index index.html index.htm;

}

# localhost/api 的请求会被转发到192.168.0.103:8080

location /api/ {

rewrite ^/b/(.*)$ /$1 break; # 去除本地接口/api前缀, 否则会出现404

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_pass ?; # 转发地址

}

# 重定向错误页面到/50x.html

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

}

}

假设代理服务始终是麻烦的,JSONP 方案的灵活性这体现了出来。淘宝、天猫、京东的等电商网站的首页数据,无一例外地使用了 JSONP 的数据请求方式。

原理则是“欺骗浏览器”,告诉浏览器我用换这个script 标签获取回来的只是一些执行脚本,并不是数据,而让浏览器不进行资源访问的域限制。

[1] JSONP - Wikipedia

[2] 跨源资源共享(CORS) - MDN

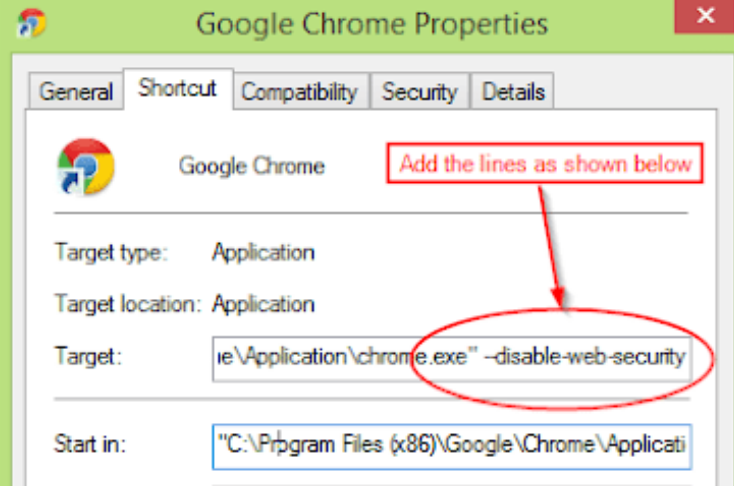

实习时第一次接触浏览器同源策略问题,是前后端准备联调需要访问后端Api,呆头呆脑的我再浏览器上发送了好久的 xhr 请求,却一直不成功.....头都麻了

一起实习的小伙伴让我在Chrome的启动程序上,加上--disable-web-security的小尾巴禁用掉同源策略,轻松加愉快地直接解决了问题......

作为web开发者,工作中不同阶段、不同场景都会遇到跨域的情况。这篇笔记📒在博客中也随着工作学习的推进,一次次地更新内容,更新自己对跨域这一问题的认识。

以下内容最后更新于2020.10,前文内容略有删改。由于这个问题体系比较繁杂,本片文章仅涉及

浏览器同源策略的由来为什么要同源策略,不设置会有什么安全问题。为什么客户端没有同源策略呢一些特殊的跨域场景想了解项目中如何进行跨域设置的小伙伴,请关注下一篇文章。

同源策略(same-origin policy)是一个重要的安全策略,它用于限制一个origin的文档或者它加载的脚本如何能与另一个源的资源进行交互。它能帮助阻隔恶意文档,减少可能被攻击的媒介。 --- MDN

资源URL的以下三项中都相同时才认为两个资源是同源的

协议: 比如http、https、ws、wss域名: 包括主域名和子域名,需要做到全匹配。端口号localStorage、IndexedDB 是浏览器常用的本地化存储方案,两者都是以源进行分割。每一个源下的脚本,都只能够访问同源中的缓存数据,不能实现跨域访问。Cookie的匹配规则与上面二者又略有差异,主要差异在于子域的cookie会默认使用在父域上。详细的规则可以参考另一篇笔记 浏览器原理 - 缓存之cookieDOM 如果两个网页不同源,就无法拿到对方的DOM。Telegram登录,授权Button是一段插入<Iframe>的脚本。Ifream本身的域名是auth.telegram.io。那么域名为abc.io的业务页面,则不能Ifream中的DOM进行访问。图片、css、js资源外,无法通过网络请求访问不同域的资源JSONP、CORS和Websocket的形式进行。SOP 本质上 SOP 并不是禁止跨域请求,而是浏览器在请求后拦截了请求的回应无论是在PC还是移动设备商,你的 Chrome 和 Firefox 是所有网站应用的载体。

你在访问 淘宝网 的时候,相当于从 www.taobao.com 的服务器上下载了 对应的 html、css、js资源,页面也从 api.taobao.com (JSONP 也好, CORS 也罢)获取了商品数据。

页面 JavaScript 把获取到的热门商品数据 缓存到了 本地的 localstorage 中,用于优化体验。

你点击登陆时,通过访问 api.taobao.com/login 接口完成了授权登录,服务器下发 Token 到 cookie 中。

同样的,在京东、在亚马逊、在你的个站、甚至在恶意网站进行访问后,网站的数据都会被下载到设备本地,并且通用 浏览器 这一个应用所管理着。

接触过客户端的同学一定知道,在安卓 和 iOS上的两个App的本地数据,没有对方的允许是不能够直接本访问的,控制权在于App开发方本身,而提供保障的则是系统(Android 和 iOS)本身。

相同的情况类比一下,把浏览器当做系统本身(Chrome Book 请给我打钱),把各个站点相当于“系统上”的一个个App。

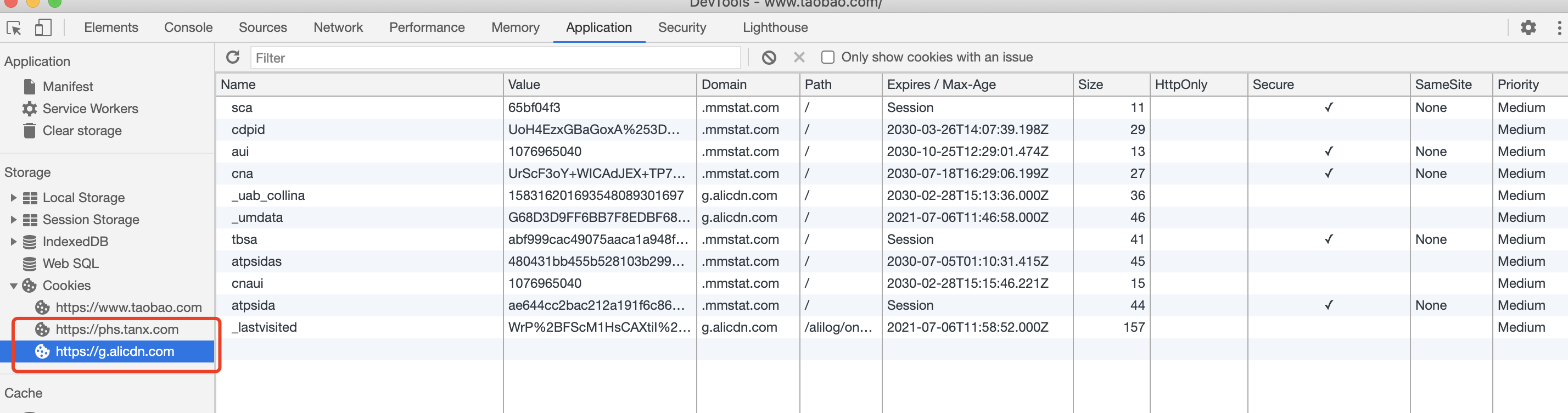

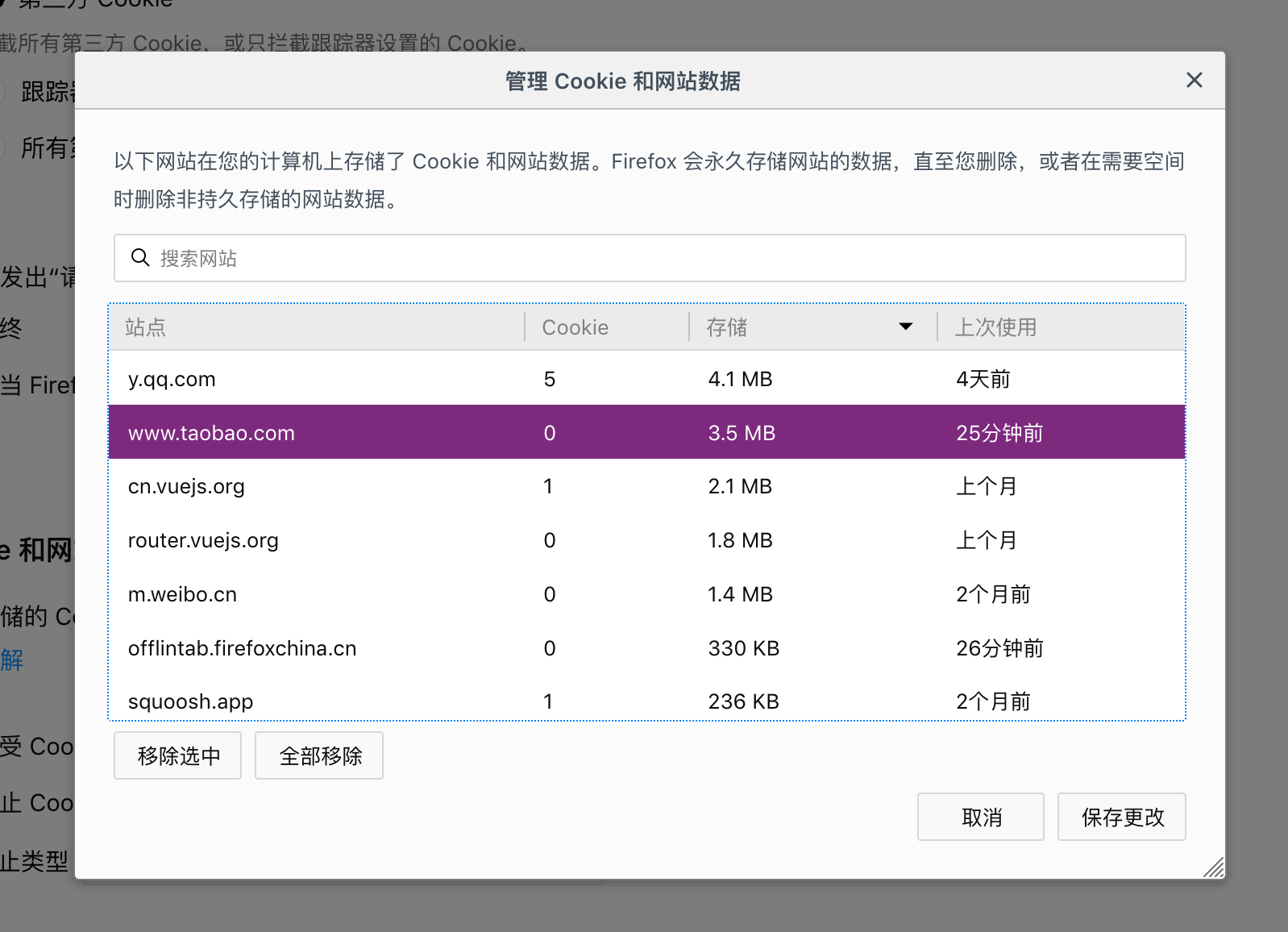

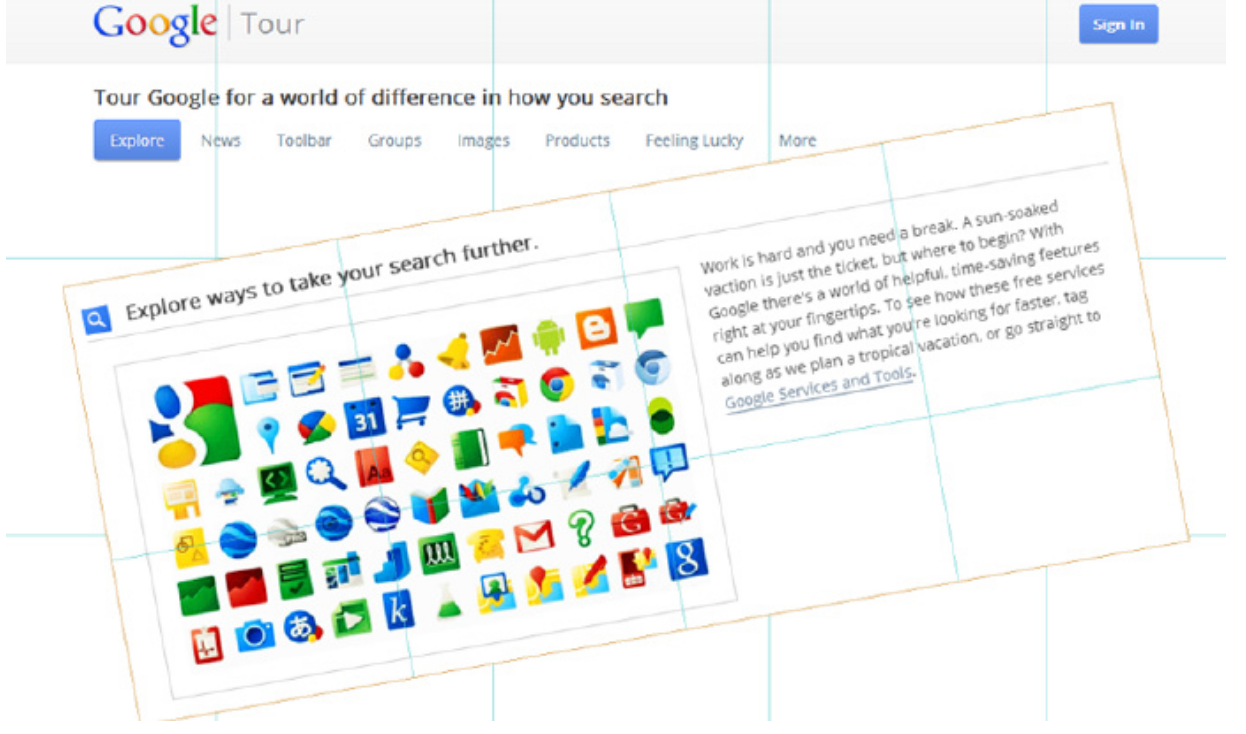

下面的页面各位 FEer一定很熟悉,这是Chrome浏览器对于页面中所有加载的静态资源的域名划分。

想想一下,不仅仅是静态的资源。WebStorage、Cookie、IndexDB,在浏览器层面上都是以域这一概念来划分管理的。而且这个划分管理行为,就是在浏览器本地生效,和服务器、其他客户端没有直接关系。

你在 your.company.com 对 data.abc.com 发起数据请求,通常我们会遇到浏览器跨域访问的提示,你的代码拿不到 返回的数据。

但其实对于跨域请求,浏览器并不是直接阻止了此次请求的发出,也没有隔断数据的返回。仅仅是阻止了你尝试跨越 “域” 这个本地 “沙箱” 去访问其他域 下刚刚获取回来的数据 罢了。

你的业务代码在 your.company.com 域下,请求回来的数据在 data.abc.com 域下,是不是?

你品品,你再品

在以前的理解中,我们总容易把跨域想想得跟服务端有很大关系,因为服务端总是要去设置什么 Access-Control-Allow-Origin 巴拉巴拉的好几个响应头(我猜你已经熟读全文,并能够默写了)。

总的来说,我们要将 页面HTML 脚本 样式 字体 等静态资源,和接口返回的数据都同等视为资源,而资源在浏览器的管理下,就是以域区划分管理的。

在同源策略中,<img> <script> 不受跨域访问限制 (熟悉的 打点上报 和 JSONP),是因为浏览器本地开放了这些途径返回的资源的访问权限。

而我们常见的 跨域响应头 们,相当于告诉了浏览器,这几个资源的管理权限应该 根据跨域响应头 来设置,所以本地的其他域下的 JavaScript 代码才能够访问得到这些返回的数据。

[1] 浏览器的同源策略 - MDN

[3] CORS - MDN

知乎上的疑问,也搬运一下过来 知乎原帖 - 为什么只有浏览器(或JS)是有所谓的同源策略? - SwainWong的回答 - 知乎

NODE_CHANNEL_FD告诉子进程这个IPC的文件描述符Domain Socket,所以与网络中的socket表现类似。SO_REUSEADDR 选项,使得不同进程可以就相同的网卡和端口进行监听newconn的内部消息,并附带客户端句柄net.Socket 创建实例,执行距离业务逻辑,并且返回NODE_UNIQUE_ID进行判断是否处于master进程 cluster.isWorker = ('NODE_UNIQUE_ID' in process.env)

cluster.isMaster = (cluster.isWorker === false)NODE_UNIQUE_IDSO_REUSEADDR 为1,实现多个子进程共享端口uncaughtException 事件,事件发生时利用IPC 通知父进程自己准备退出了SUICIDE消息后,马上创建新的worker进程,进行补位SUICIDE 消息后,子进程服务器关闭(停止接收新连接),所有已有的连接断开之后,使用process.exit(1)进行退出agent 进程PM2 模块是 cluster 模块的一个包装层,尽量将 cluster 模块抽象封装,让用户像是使用单进程一样部署多进程 Node 应用

"Node.js 从最一开始就支持模块化编程。然而,在 web,模块化的支持正缓慢到来。在 web 存在多种支持 JavaScript 模块化的工具,这些工具各有优势和限制。webpack 基于从这些系统获得的经验教训,并将_模块_的概念应用于项目中的任何文件。"

从 Webpack 4对模块化的面数来看,深知自己的历史任务深重,所以扛起了所有的前端几乎所有的模块化方案:

ES6的 import 与 export 语句CommonJS 的 require 与 module.exportsAMD 的 define 与 require 语句CMD 的 definecss/less/sass 中的 @import 语句根据CommonJS规范,全局中可以直接取到exports、require、module这三个经典的变量。再加上运行环境为node,所以多加两个__filename与__dirname

Webpack根据以上的基本需要,将当前模块封装在一个块级作用域中,并将这些变量当做模块的全局变量传入。

(function(exports, require, module, __filename, __dirname){

// YOUR MODULE CODE

});CommonJS规范下,代码是在运行时才确定依赖关系的,所以webpack在实现上也是依照规范去做。只能在打包编译的时候加入完整的模块到最后的bundle中,无法实现Tree Shaking.

对于ES6 Module的编译过程静态化处理,Webpack也以文件为维度对模块进行划分,得到module1、module2、module3等,最后还有入口模块moduleEntry。

这里的设计思维,有点像是

Javascript的作用域链.

// moduleA.js

export const A = 'A value'

// moduleB.js

export const B = 'B value'

// moduleC.js

export const C = 'C value'

// app.js

import { A } from './es6/moduleA'

import { B } from './es6/moduleB'

import { C } from './es6/moduleC'

console.log('==== entry.js ======')

console.log(A)

console.log(B)我们把app.js作为打包入口,则会得到以下结构的代码

// 入口模块

(function (modules) {

function webpackRequire(moduleId) {

// ...

}

webpackRequire(1);

})([module1, module2, module3, moduleEntry]);Webpack编译后的代码中,使用__webpack_require__()方法进行模块的调度,相当于Node.js版实现中的require()方法。

/******/ // The require function

/******/ function __webpack_require__(moduleId) {

/******/

/******/ // 使用内存进行模块缓存

/******/ if(installedModules[moduleId]) {

/******/ return installedModules[moduleId].exports;

/******/ }

/******/ // 若没有命中缓存,则新创建一个 module 实例

/******/ var module = installedModules[moduleId] = {

/******/ i: moduleId,

/******/ l: false,

/******/ exports: {}

/******/ };

/******/

/******/ // 执行模块

/******/ modules[moduleId].call(module.exports, module, module.exports, __webpack_require__);

/******/

/******/ // Flag the module as loaded

/******/ module.l = true;

/******/

/******/ // 返回模块

/******/ return module.exports;

/******/ }简单总结一下

使用了和内存进行模块单例缓存,类似于Node.js实现中的require.cache 与 Module._cache(建议和这篇文章的“源码概览”部分一起食用)

__webpack_require__参数为moduleId,该ID也为传入的模块数组下标的ID

创建模块部分,相当于Node.js 实现中的这部分内容👉

// /lib/internal/modules/cjs/loader.js#L912

const module = new Module(filename, parent); // /lib/internal/modules/cjs/loader.js#L1200

result = compiledWrapper.call(thisValue, exports, require, module,

filename, dirname);Webpack如何实现的异步加载,请参考这篇文章👉

__webpack_require__.d(其实应该为__webpack_require__.define),函数用于导出模块,也就是实现export语句的基础方法,编译后的源码如下。

__webpack_require__.d = function (exports, name, getter) {

/******/

if (!__webpack_require__.o(exports, name)) {

/******/

Object.defineProperty(exports, name, { enumerable: true, get: getter })

/******/

}

/******/

}我们在打包后的代码中,除了看到__webpack_require__.d方法的定义,也有对应的使用。蔽日我们引入了moduleA、moduleB、moduleC。

图中出现的__webpack_exports__则是表示暴露的整体对象,__webpack_require__.d负责给该对象添加属性。

打包后的代码中有这么一段代码如下,根据对应模块的类型,ES6 Module或者是CommonJS,进行不同的处理方式。

/******/

/******/ // getDefaultExport function for compatibility with non-harmony modules

/******/

__webpack_require__.n = function (module) {

/******/

var getter = module && module.__esModule ?

/******/ function getDefault () {

return module['default']

} :

/******/ function getModuleExports () {

return module

}

/******/

__webpack_require__.d(getter, 'a', getter)

/******/

return getter

/******/

}webpack还实现了AMD规范,说明熟悉的AMD引入也是可行的。

// 使用AMD规范引入模块包

require(['./list', './edit'], function(list, edit){

console.log(list)

console.log(edit)

});require.ensure 能够确保 webpack 进行打包的时候,会将异步引入的包和主包分离

// ./list/index.js

console.log('i am the separated module')

module.exports = {

abc: 123

}

// app.js

require.ensure([], function(require){

const list = require('./list');

console.log(list)

}, 'list');当然我们正在做 code spliting的时候一般会通过webpack.config.js来进行配置plugins或者optimization来实现

行为表现HTTP/1.1 协议里设计 100 (Continue) HTTP 状态码的的目的是,在客户端发送 Request Message 之前,HTTP/1.1 协议允许客户端先判定服务器是否愿意接受客户端发来的消息主体(基于 Request Headers)。

设计含义client 和 server 在 post (较大)数据之前,允许双方“握手”,如果匹配上了,Client 才开始发送(较大)数据。操作如果 client 预期等待“100-continue”的应答,那么它发的请求必须包含一个 " Expect: 100-continue" 的头域!

客户端 Request Header服务端处理表示访问当前资源需要更换协议进行数据传输,比如 Websocket 握手连接。

2xx 一类的状态码,表示你的请求已经被服务器正确地处理了,没有遇到其他问题,服务器选择性地返回一些内容

请求被服务器成功处理,服务器会根据不同的请求方式返回结果

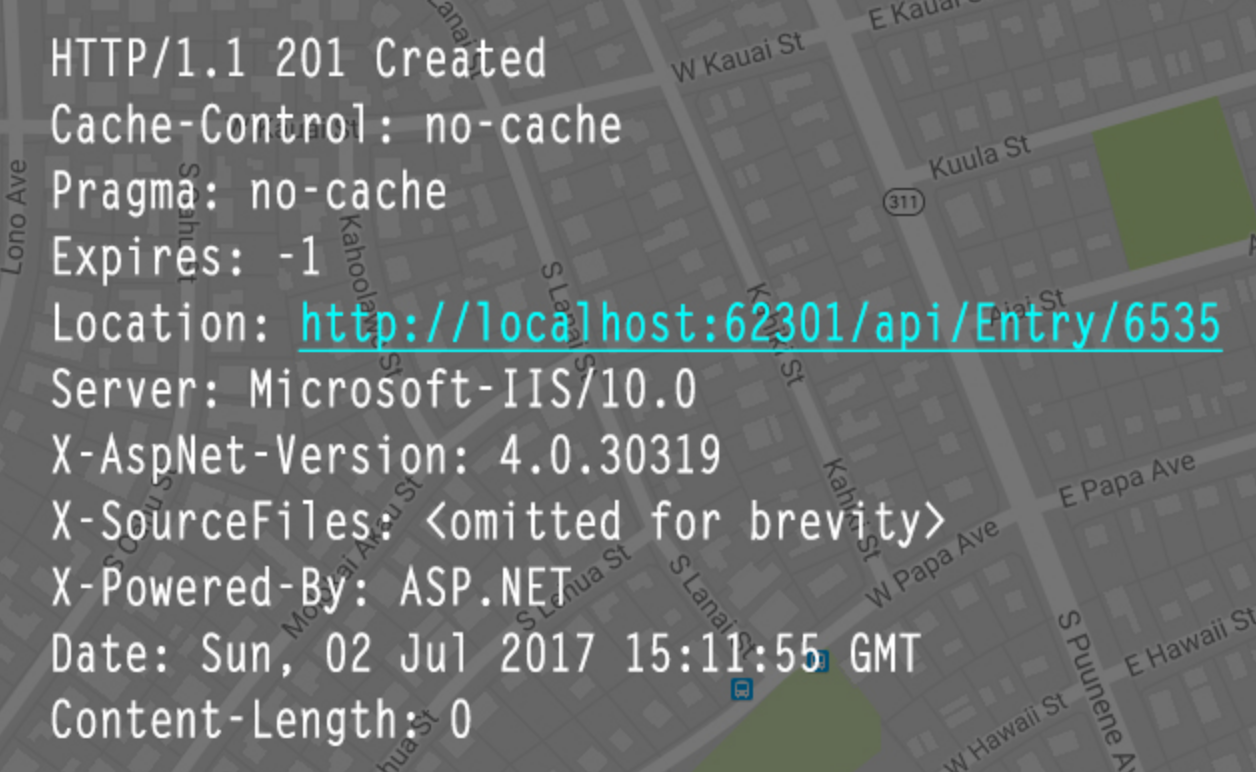

请求已经被实现,而且有一个新的资源已经依据请求的需要而建立,且其 URI 已经随Location 头信息返回。

200 状态下,没有实体返回的区别在于,浏览器处理 204 的状态码,只是回去读取报文头的更新信息UA 是一个浏览器,请求的时候是<a href="xxx">标签形式,204 则不会发生页面跳转,相对应 200 下则会发生跳转。范围请求,而服务器只成功处理了其中的一部分range字段,而服务端的报文中,必须包含由,Content-Range指定的实体内容(entity)Range字段含义增强校验If-Modified和If-Match这两套去保证分段的资源是可靠的,资源在分段过程中没有被修改

�If-Range去请求,总是跟 Range 头部一起使用。If-Range浏览器告诉 WEB 服务器

范围请求详细过程请参考这篇文章👉

表示服务器端已经接受到了请求,必须对请求进行一些特殊的处理之后,才能够顺利完成此处请求

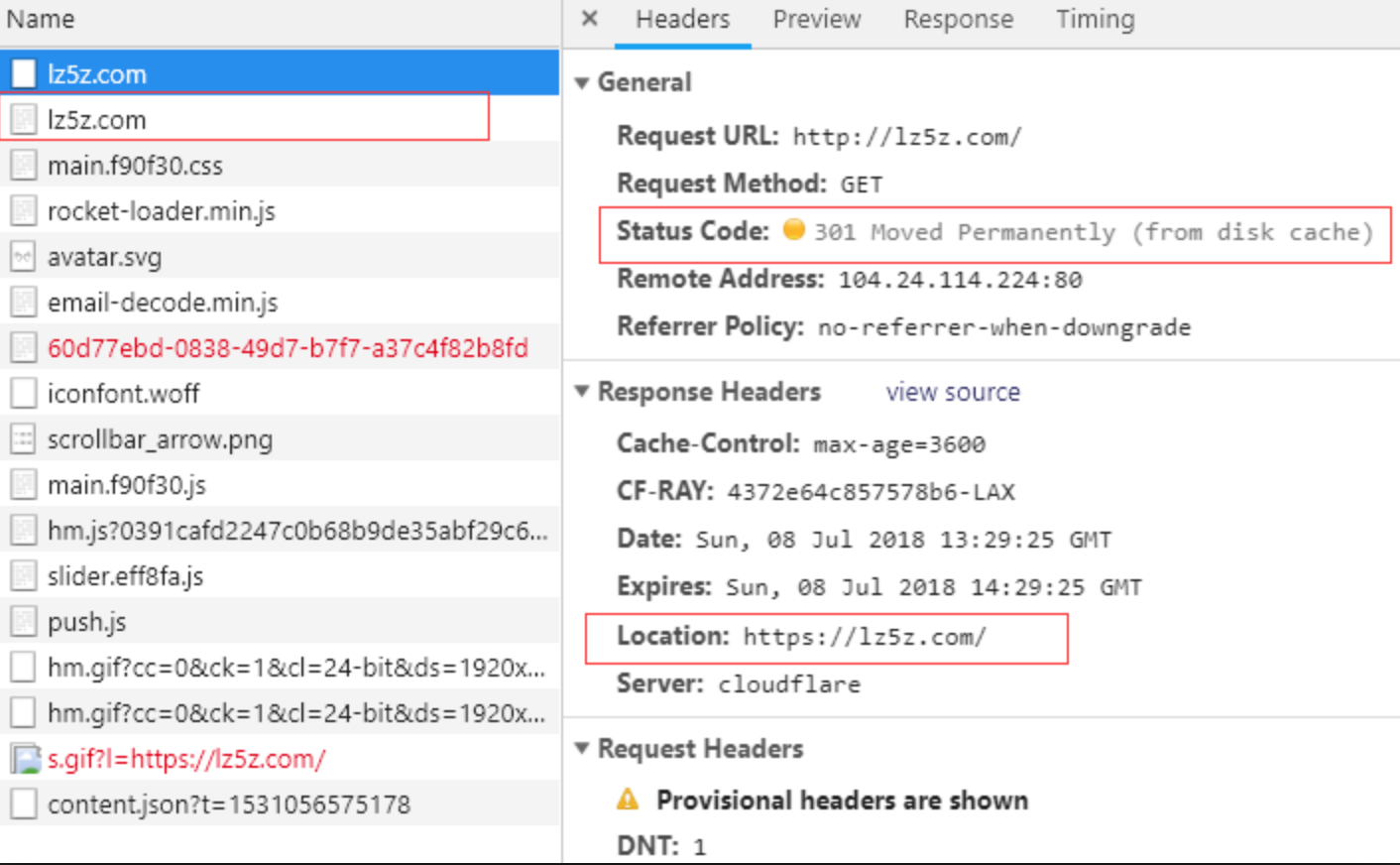

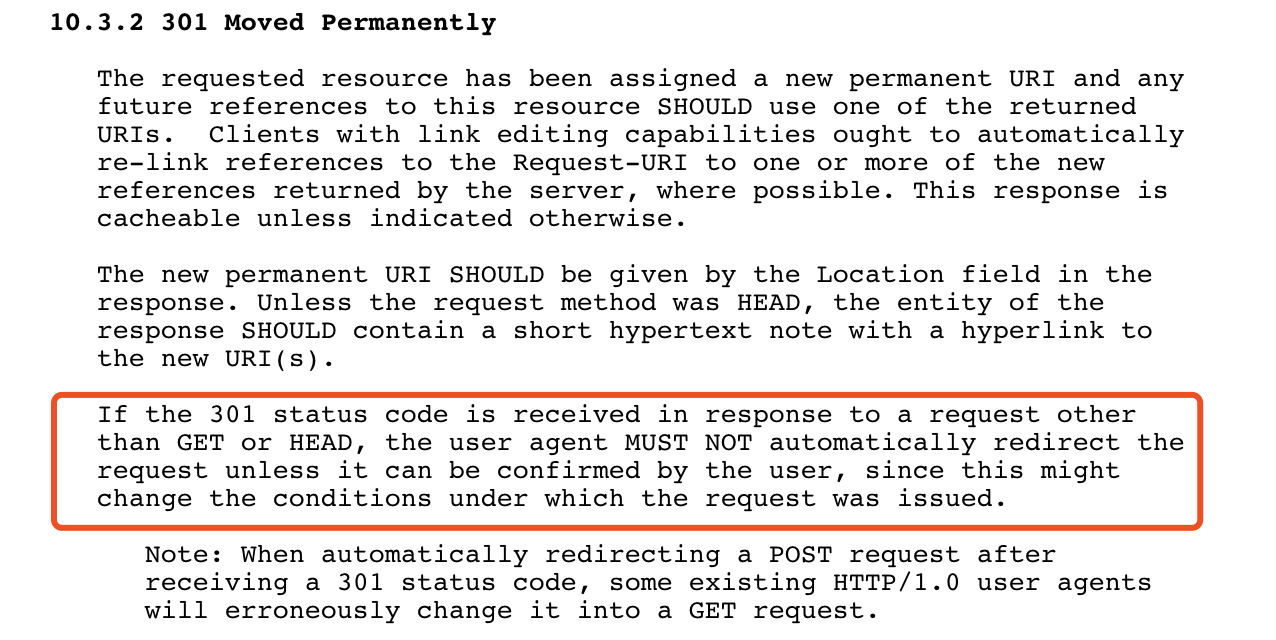

请求的资源已经被永久地重定向了,301 状态码的出现表示请求的URL对应的资源已经被分配了新的定位符。

Location字段中明确指出新的URILocation字段以外,还需要在相应体中,附上新的 URI 的链接文本POST 请求的话,服务端若是使用重定向,则需要经过客户的同意301 来说,资源除非额外指定,否则默认都是可缓存的。我们使用http访问一些只接受 https �资源的时候,浏览器设置了自动重定向到 https,那么首次访问就会返回 301 的状态码。

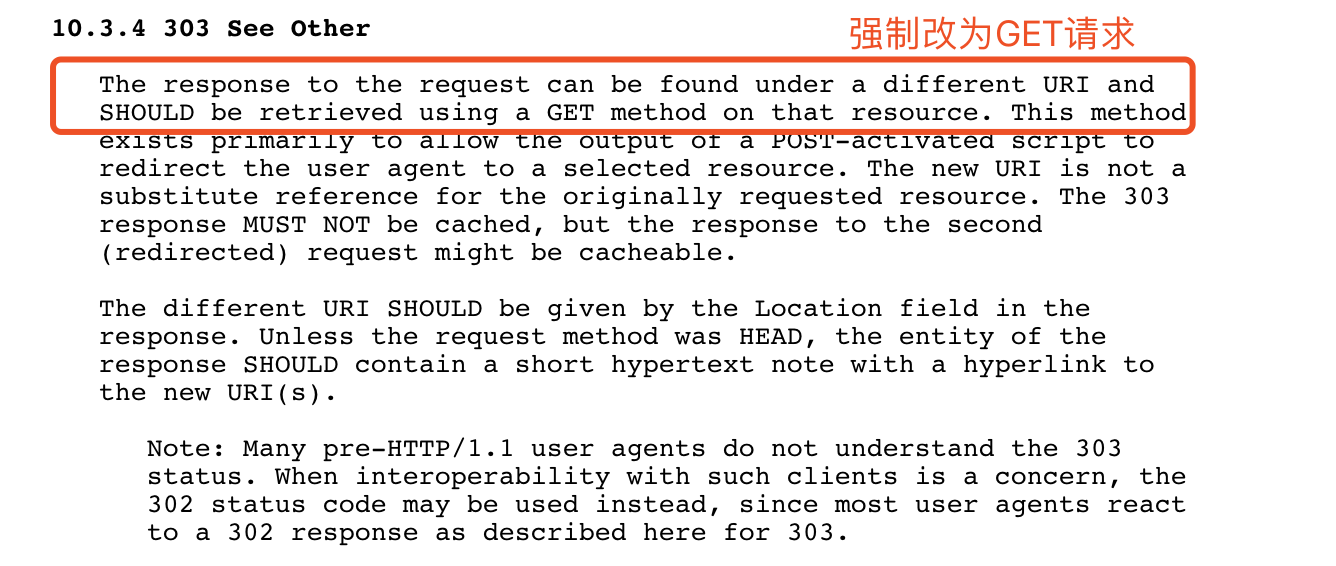

301状态码意思几乎一样,不同点在于302是临时的重定向,并只对本次的请求进行重定向URI 收藏了起来,不去修改书签中的指向。302 响应等同于 303 响应,并且在重定向的时候,使用 GET 方式返回报文中Location字段指明的URLCache-Control 或 Expires 中进行了指定的情况下,这个响应才是可缓存的。我们使用的网站短地址,访问的时候就会临时重定向到我们压缩前地址指向的页面。

(http 1.1)303 状态码同样处理为 302,而且是直接将非 GET、HEAD请求改为 GET 请求。GET 形式去进行(http1.1)302 状态码http1.0和http 1.1都规定,若客户端发送的是非 GET 或者 HEAD 请求,响应头中携带 301 或 302 的时候,浏览器不会自动进行重定向,而需要询问用户,因为此时请求的情况 很可能 已经发生变化。

但是实际上,所有的浏览器都会默认把 POST 请求直接改为 GET 请求。

�对于301状态码,搜索引擎在抓取新内容的同时,也将旧网址替换为重定向后的网址。而对于302状态码则会保留旧的网页内容。

兼容性:服务端考虑准备使用303的时候,一般还是会使用302代替,因为要兼容许多不支持http 1.1的浏览器,而对与要进行 307 返回的时候,浏览器一般会将要重定向的 URL 放到 response.body 中,让用户去进行下一步操作。

303和307的存在,就是细化了http 1.0中302的行为,归根结底是由于 POST(等对服务器有伤害的请求)方法的非幂等属性引起的。

表示该请求报文中存在语法错误,导致服务器无法理解该请求。客户端需要修改请求的内容后再次发送请求。

一般也可以用于用户提交的表单内容不完全正确,服务端也可以用 400 来响应客户端

www-authenticate:Basic表示一种简单的,有效的用户身份认证技术。

http 基本认证保护的资源。401 状态,要求客户端提供用户名和密码进行认证。(验证失败的时候,响应头会加上WWW-Authenticate: Basic realm="请求域"。)

401 Unauthorized

WWW-Authenticate: Basic realm="WallyWorld"

Base64进行编码后,采用非加密的明文方式传送给服务器。

Authorization: Basic xxxxxxxxxx.

401状态,要求重新进行认证。

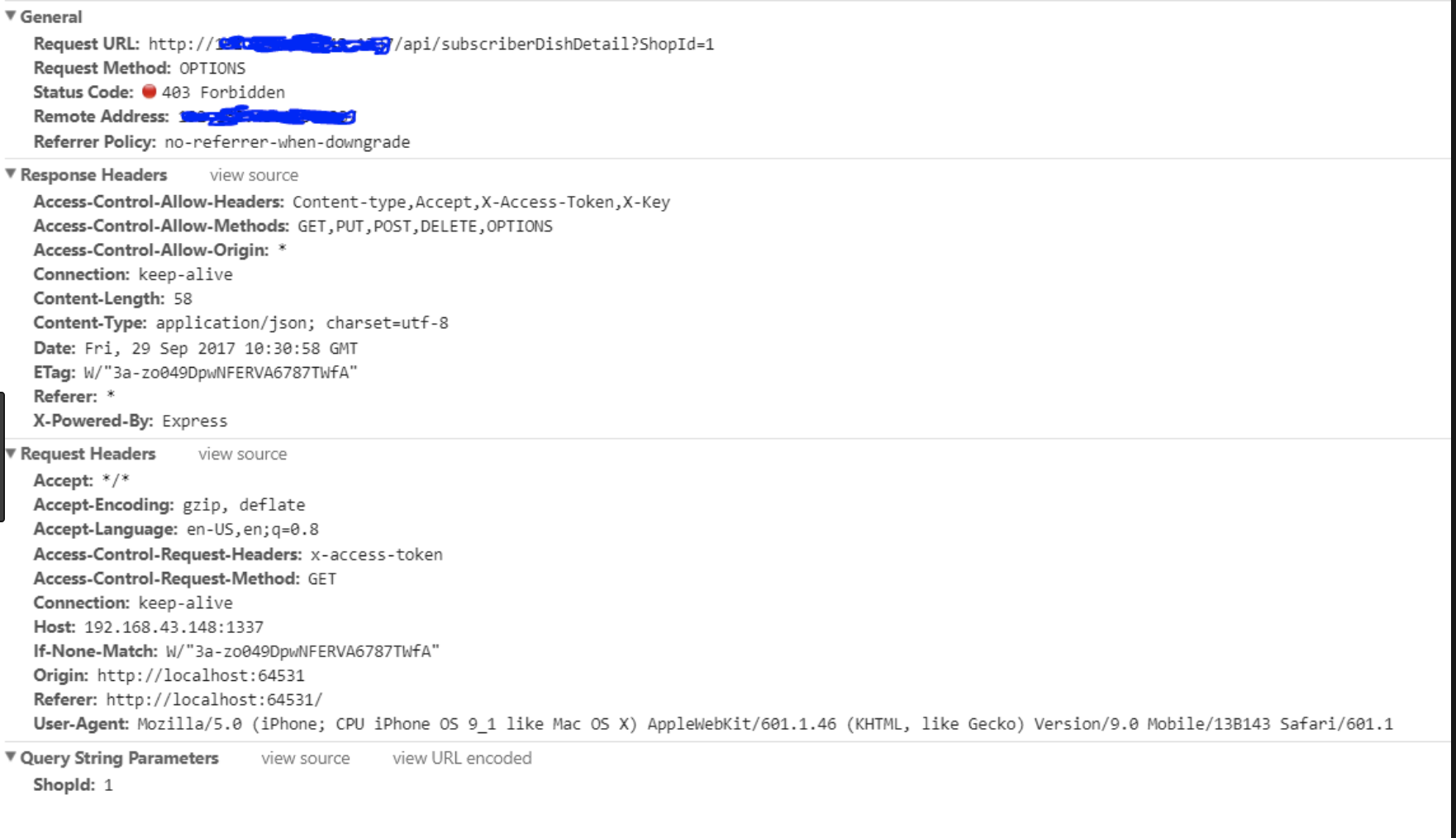

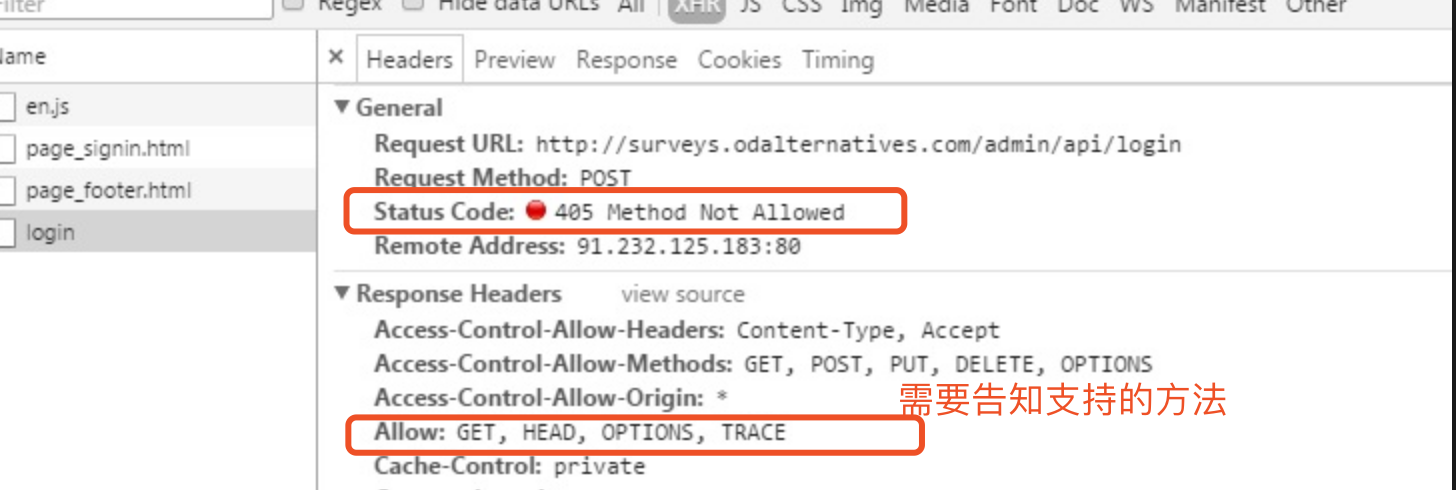

表示该资源不支持该形式的请求方式,在Response Header中返回 Allow 字段,携带支持的请求方式

在请求报文中的If-xxx字段发送到服务端后,服务端发现没有匹配上。比如,If-Match:asfdfsdzxc,希望匹配ETag值。

我们先来看看RFC是怎么定义的...

在请求头Expect中指定的预期内容无法被服务器满足,或者这个服务器是一个代理服务器,它有明显的证据证明在当前路由的下一个节点上,Expect 的内容无法被满足。

一般表示连接服务器的便捷路由器出问题了,导致请求不能到达。我们最常见的应该是这个页面

然后资源请求的时候,详细的报文

Ctrl + F5 进行强制刷新,多次从服务器重新拉取数据,排除是网关服务器偶尔波动引起的该状态码表示服务器已经处于一个超负荷的一个状态,或者是所提供的服务暂时不能够正常使用

若服务器端能够事先得知服务恢复时间的话,可以在返回503状态码的同时,把恢复时间写入Retry-After字段中

常见的页面形式

注意,要是503的报文返回时,没有携带Retry-After�的报文头,那么客户端应将次返回处理为500

[1] 100 continue 的秘密

[2] http状态码 -百度百科

[3] 301与302

[4] websocket探秘

[5] 200/204/206-302/303/307 -cnblog

[6] HTTP状态码302、303和307的故事

[7] RFC- HTTP1.1

[8] 206断续下载

[9] 断点续传-http协议里Header参数Range

上一篇主要总结了鉴权、签名、心跳的问题,这次我们着重过一下在封装请求库时遇到的以下问题。

1.对调用方透明,尽可能使用Promise封装

2.实现请求与响应的中间件

3.实现订阅机制

完整的demo代码在这里👉👉👉

export class RainbowWebsocket {

protected _serverUrl: string // 远端地址

protected _ws: WebSocket // 原生ws实例

constructor (option: IOption) {

// 初始化

this._serverUrl = option.url

this._ws = new WebSocket(this._serverUrl)

}

// 处理请求

request (data: any): Promise<any> {}

// 处理相应

response (msg: string) {}

}export interface IPromise {

resolve: Function,

reject: Function,

method: string

}

protected _promises: Map<string, IPromise> // 请求记录哈希表 export interface IRequest {

id: string,

jsonrpc: string,

method: string,

data: any

}request (data: any): Promise<any> {

return new Promise((resolve, reject): void => {

const payload = Object.assign(data, {

id: uniqueId(pkg.name + '-'),

jsonrpc: JSON_RPC_VERSION

})

// 登记请求

this._promises.set(data.id, {

resolve,

reject,

method: payload.method,

})

// 发送请求

this._ws.send(this._toDataString(data))

})

}export interface IResponse {

id: string,

jsonrpc: string,

method: string,

data: any,

errCode: number,

}

// error code

export enum ErrorCode {

SUCCESS = 0

}this._ws.onmessage = event => {

console.log(event.data)

// 简单的检测过后,进行相应处理

if (event.data && typeof event.data === 'string' && event.data.includes(JSON_RPC_VERSION)) {

this.response(event.data)

}

}response (msg: string) {

try {

const res: IResponse = JSON.parse(msg)

// 取出对应的响应

const promise: IPromise = this._promises.get(res.id)

// 删除对端已响应的promise

this._promises.delete(res.id)

// 根据errno决定执行哪一个reject还是resolve

if (res.errCode !== ErrorCode.SUCCESS) {

// 执行请求登记时的 resolve function

promise.reject(res.errCode)

}

else {

// 执行请求登记时的 resolve function

promise.resolve(res.data)

}

}

catch (err) {

this._logger.error('response msg parse fail')

return

}

}public interceptors: {

request: InterceptorManager

response: InterceptorManager

} _requestInterceptorExecutor (payload) {

let _payload = payload

this.interceptors.request.forEach((handler: Function) => {

_payload = handler(_payload)

})

return _payload

}

_responseInterceptorExecutor (payload) {

let _payload = payload

this.interceptors.response.forEach((handler: Function) => {

_payload = handler(_payload)

})

return _payload

}request (data: any): Promise<any> {

return new Promise((resolve, reject): void => {

// 拼接生成payload

// 通过请求拦截器

const _payload = this._requestInterceptorExecutor(payload)

// 登记请求 .....

// 若ws连接达成,则先缓存请求 ......

// 发送请求

this._ws.send(this._toDataString(data))

})

}

response (msg: string) {

const res: IResponse = JSON.parse(msg)

// 解析数据 ....

// 删除处理过的promise记录 .....

// 响应中间件

const _res = this._responseInterceptorExecutor(res)

// 根据errno决定执行哪一个reject还是resolve

}websocket建立需要时间,但作为接口层的调用方并不关心这些事,即使在websocket信道连通前发出的请求,也可以顺利发出。

protected _waitingQueue: Array<any> // websocket 未建立的时候,缓存请求request (data: any): Promise<any> {

return new Promise((resolve, reject): void => {

// 登记请求

// ........

// 若ws连接达成,则先缓存请求

if (this._ws.readyState === WEBSOCKET_STATE.CONNECTING) {

this._waitingQueue.push(payload)

return

}

// 发送请求

this._ws.send(this._toDataString(data))

})

}this._ws.onopen = event => {

this._logger.log(`RainbowWebsocket connected to ${this._serverUrl} successfully......`)

// ws通道联通后,发送前期未发送的请求(缓存队列中的请求,都已经注册登记过了,所以不需要再次登记)

this._waitingQueue.forEach(payload => {

this._ws.send(this._toDataString(payload))

})

}我们在使用http请求库(比如axios),发送了请求等待响应过程中,突然发现网络发生了异常,我们通常会收到不同的错误码,比如404等。

this._ws.onclose = event => {

this._logger.log(`RainbowWebsocket has close ......`)

// 将所有未处理的请求都reject调

for (const record of this._promises) { // 遍历Set

const request = record[1]

request.reject(ErrorCode.DISCONNECT)

}

}通知类型的通信,并不存在一发一收的对应机制,自然也不需要使用this._promises用于存储。但是通知自然是需要一个监听机制的存在。

import * as EventEmitter from 'eventemitter3'

export class RainbowWebsocket extend EventEmitter {

// .....

}response () {

this.$emit('notify')

}request (data: any, isNotify = false): Promise<any> {

return new Promise((resolve, reject): void => {

// data处理......

// 通过请求拦截器......

if (!isNotify) {

// 登记请求

this._promises.set(data.id, {

resolve,

reject,

method: _payload.method

})

}

// 若ws连接尚未达成,则先缓存请求......

// 发送请求......

})

}response (msg: string) {

try {

const res: IResponse = JSON.parse(msg)

const promise: IPromise = this._promises.get(res.id)

// todo: 删除处理过的promise......

// 响应中间件

const _res = this._responseInterceptorExecutor(res)

// 判断是否是通知性的消息

if (isNotifyMsg(res)) {

// 使用事件机制进行通知

this.emit(`notify:${ res.method }`, res.data)

}

else {

// todo: 根据errno决定执行哪一个reject还是resolve

if (_res.errCode !== ErrorCode.SUCCESS) {

promise.reject(_res.errCode)

}

else {

promise.resolve(_res.data)

}

}

}

catch (err) {

this._logger.error('response msg parse fail')

return

}

}const apiServer = new RainbowWebsocket({port: 9527, host: 'localhost'})

apiServer.on('notify:balance', data => {

// do something you like...

})koa-compose 作为koa实现中间件串联功能的关键函数,值得我们细细品味,话不多说先送上👉源码,别惊讶确实只有这么多行....

'use strict'

/**

* Expose compositor.

*/

module.exports = compose

/**

* Compose `middleware` returning

* a fully valid middleware comprised

* of all those which are passed.

* 👉 原文译: 将所有中间件组合,返回一个包含所有传入中间件的函数

*

* @param {Array} middleware

* @return {Function}

* @api public

*/

function compose (middleware) {

// 传入middware的必须为数组

if (!Array.isArray(middleware)) throw new TypeError('Middleware stack must be an array!')

// 任意数组元素也都必须为函数

for (const fn of middleware) {

if (typeof fn !== 'function') throw new TypeError('Middleware must be composed of functions!')

}

// 返回一个每个中间件依次串联的函数闭包

// 其实第一次调用 return fnMiddleware(ctx).then(handleResponse).catch(onerror); 时并没有传入第二个next参数,当然也传入不了

return function (context, next) {

// last called middleware #

// 这里的 index 是用于防止在一个中间件中重复调用 next() 函数,初始值设置为 -1

let index = -1

// 启动递归,遍历所有中间件

return dispatch(0)

// 递归包装每一个中间件,并且统一输出一个 Promise 对象

function dispatch (i) {

// 注意随着 next() 执行,i、index + 1、当前中间件的执下标,在进入每个中间件的时候会相等

// 每执行一次 next (或者dispatch) 上面三个值都会加 1

/* 原理说明:

* 当一个中间件中调用了两次 next方法,第一次next调用完后,洋葱模型走完,index的值从 -1 变到了 middlewares.length,

* 此时第一个某个中间件中的 next 再被调用,那么当时传入的 i + 1 的值,必定是 <= middlewares.length 的

*/

if (i <= index) return Promise.reject(new Error('next() called multiple times'))

// 通过校验后,index 与 i 的值同步

index = i

// 取出一个中间件函数

let fn = middleware[i]

// 若执行到了最后一个,(其实此时的next也一定为undefined),我认为作者是为何配合下一句一起判断中间件的终结

if (i === middleware.length) fn = next

// 遍历到了最后一个中间件,则返回一个 resolve 状态的 Promise 对象

if (!fn) return Promise.resolve()

try {

// 递归执行每一个中间件,当前中间件的 第二个 入参为下一个中间件的 函数句柄

// 这里注意:每一个 next 函数,都是下一个 dispatch函数,而这个函数会返回一个 Promise 对象

return Promise.resolve(fn(context, dispatch.bind(null, i + 1)));

} catch (err) {

// 中间件执行过程中出错的异常捕获

return Promise.reject(err)

}

}

}

}接下来是手摸手教你写 compose , 要是上面的看懂了,就节省时间不必往下看了 👻👻👻

前面的一些类型判断语句也就不做过多描述。

if (!Array.isArray(middlewares)) throw new TypeError('Middlewares must be an array')

for (const fn of middlewares) {

if (typeof fn !== 'function') {

throw new TypeError('item of middlewares must be an functions')

}

} return function (context) {

function dispatch(i) {

let fn = middlewares[i] // ① 取出当前的中间件,fn指向每一个中间件

if (!fn) return // ④ 为递归设定终结条件

fn(context) // ② 执行当前中间件

return dispatch(i + 1)// ③ 形成初步的递归调用

}

return dispatch(0) // ④ 设定一个递归启动点

}// 简单准备第三个中间件

const mid1 = () => console.log('mid1')

const mid2 = () => console.log('mid2')

const mid3 = () => console.log('mid3')

const fnx = compose([mid1, mid2, mid3])

fnx() // mid3 mid2 mid1next表示开启下个中间件的函数句柄bind对dispatch进行函数改造 return function (context, next) {

function dispatch(i) {

let fn = middlewares[i]

if (!fn) return

// ⑤ 改造当前中间件执行时传入的参数,将下一个中间件的含数句柄,作为第二个参数 next 传入

return fn(context, dispatch.bind(null, i + 1))

}

return dispatch(0)

}const mid1 = (ctx, next) => {

console.log('mid1')

setTimeout(()=>{

console.log('mid1 wait for 2s')

next()

}, 2000)

console.log('mid1 after')

}

const mid2 = (ctx, next) => {

console.log('mid2')

setTimeout(()=>{

console.log('mid2 wait for 2s')

next()

},2000)

console.log('mid2 after')

}

const mid3 = function (ctx, next) {

console.log('mid3')

console.log('mid3 after')

}

const fnx = compose([mid1, mid2, mid3])

fnx() // 输出结果我就不写了,你猜猜是什么研究清楚第二阶段的测试输出后,我们基本将异步中间件串联起来。那么源码中,dispatch函数,无论走哪一个分支,为何一定都要返回一个Promise对象呢?

想了好久不得其解,就把源码中返回Promise部分改为同步,跑了一下koa自带的测试用例。

# koa

$ npm run test 1) app.context

should merge properties:

Uncaught TypeError: Cannot read property 'then' of undefined

at Application.handleRequest (lib/application.js:166:29) // 👈👈 点开这里看了看

at Server.handleRequest (lib/application.js:148:19)

at parserOnIncoming (_http_server.js:779:12)

at HTTPParser.parserOnHeadersComplete (_http_common.js:117:17)

[use `--full-trace` to display the full stack trace]// application.js #line 160

handleRequest(ctx, fnMiddleware) {

const res = ctx.res;

res.statusCode = 404;

const onerror = err => ctx.onerror(err);

const handleResponse = () => respond(ctx);

onFinished(res, onerror);

// 上面的错误堆栈,追踪到的就是这里 #line 166 👇👇👇

return fnMiddleware(ctx).then(handleResponse).catch(onerror);

}

// application.js #line 141

callback() {

const fn = compose(this.middleware);

if (!this.listenerCount('error')) this.on('error', this.onerror);

const handleRequest = (req, res) => {

const ctx = this.createContext(req, res);

return this.handleRequest(ctx, fn);

};

return handleRequest;

}不难看出抛出错误的#line 161 fnMiddleware指的就是 compose之后的结果。说明在koa中,将所有中间件串联起来之后,希望得到的是一个thenable的对象。我们则需要继续添加对Promise的支持

return function (context, next) {

function dispatch(i) {

let fn = middlewares[i]

if (i === middlewares.length) fn = next

// ⑧ 调用最后一个中间件

if (!fn) return Promise.resolve()

try {

// ⑥ 成功调用

return Promise.resolve(fn(context, dispatch.bind(null, i + 1)))

} catch (err) {

// ⑦ 成功过程出错

return Promise.reject()

}

}

return dispatch(0)

}我们知道一次深入到最内层,再原路返回到最外层,就是一次完整的洋葱模型。对于代码设计中的index 与 i 的关系,也是一个设计巧妙的宝盒。如下测试代码,在mw1中调用多次next函数

async function mw1 (context, next) {

console.log('===== middleware 1 =====')

next()

next() // 预计这里是会爆出一个错误,但是为什么呢?是如何工作的呢?

}

function mw2 (context, next) {

console.log('===== middleware 2 =====')

next()

}

async function mw3 (context, next) {

console.log('===== middleware 3 =====')

}如上图我们可以知道,用index去标记i曾经到达过的最深层词的中间件的下标,那么就能有效防止再原路返回时,每个中间件再次出触发next深入深层次的情况。

return function (context, next) {

let index = -1 // ⑨ 表示初始的层次

function dispatch(i) {

// 10 当前调用的层次,是否小于曾经到过的最大层次(变相判断这一个中间件的next是否已经调用过了)

if (i <= index) return Promise.reject('next cant not be invoke multiple time')

// 11 通过了上面的校验,就标记本次到达的最深层次

index = i

let fn = middlewares[i]

if (i === middlewares.length) fn = next

if (!fn) return Promise.resolve()

try {

return Promise.resolve(fn(context, dispatch.bind(null, i + 1)))

} catch (err) {

return Promise.resolve()

}

}

return dispatch(0)

}若还是不太明白上面写法的原理,那我们来看看compose 组合 middlewares后的结果会是什么样子。

const [mid1, mid2, mid3] = middlewares

// compose 可以理解为

const fnMiddleware = function(ctx) {

return Promise.resolve(

mid1(ctx, function next () {

return Promise.resolve(

mid2(ctx, function next () {

return Promise.resolve(

mid3(ctx, function next() {

return Promise.resolve()

})

)

})

)

})

)

}[1] Koa源码 - github

[2] 大家觉得 Koa 框架还有什么不足的地方吗? - Starkwang的回答 - 知乎

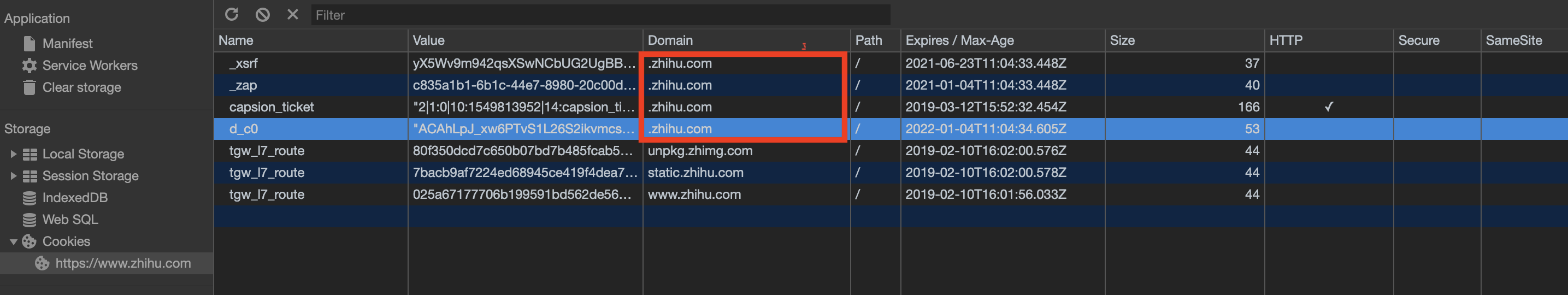

基于上一篇cookie的基本使用场景和用法,这回来记录下项目关于cookie中遇到的问题和解决方案。

cookie解决的基本问题是http的无状态性,项目中大多数的场景也利用这个特性用于标记用户。

auth token标明用户的登录态。ssid token,并通过整个广告联盟中的网站中上报的ssid token,收集用户的访问行为。简单滴说,session 是什么呢?

Session是一个临时的进程组群,目的是去完成一些任务,是直接存储在内存中的。OS接收到新任务的时候,就会调度进程去执行任务。Session会话。Session 一般有效期设置为20min,若超时时间内没有数据交互,服务器就会将Session对应的资源删除。当客户端首次向服务端请求的时候,服务端维护一个Session,生成一个sessionid,值可以随意约定,就是一个用于标记session的值。

server 通过 http 响应客户端,客户端接收到了并保存在Cookie中。

客户端结束掉了请求连接,服务端就会释放掉这些进程对资源的占用,本次会话的状态会被暂时保存在一个文件中,在一定的时间内,服务端会保留这个文件。

在超时时间范围内,客户端每次访问该域名都会用cookie携带sessionid到服务端。服务端再根据sessionid找对应的Session,并且根据这个状态中记录的内容,打开对应的资源。

cookieSession 并不能够被共享我们来逐个解决下这些问题。

cookie的情况下,用户访问服务器页面时,服务器可以下发token到前端,前端使用cookie以外的 web storage 技术进行 token 存储。Session不能共享的问题时,高速缓存工具就是首选,比较热门的有 Redis Memcached 等IP或者浏览器型号等等。明文信息 = 随机生成字符串 + 客户端独有信息后,通过服务端独有的私钥进行加密,最终生成下发的token.号分割

Header.Payload.Signature {

"alg": "HS256",

"typ": "JWT"

}{

"user_id":"8192qhgb6kmoh3bypbc9wp146jusho",

"session_id":"81928yaqk1sccfgwze4k718338z3ae",

"platform":"wechat",

"roles":"",

"props": {"botId":"850444981"},

"exp":1606291794,

"iat":1603699794

}私钥保存在服务器,以下是生成秘钥的示例。HMACSHA256(base64UrlEncode(header) + "." +base64UrlEncode(payload),secret)《浏览器原理 - 缓存之cookie》 这篇文章中聊到SameSite时提到了,欧美国家因为隐私安全问题,对Google涉及使用第三方Cookie来追踪用户行为的操作,进行了巨额的罚金。

某个 cookie 对应的 domain 值,和当前页面服务器所在的 doamin 不属于一个站点。那么对于这个站点来说,这个 cookie 就是一个第三方cookie。

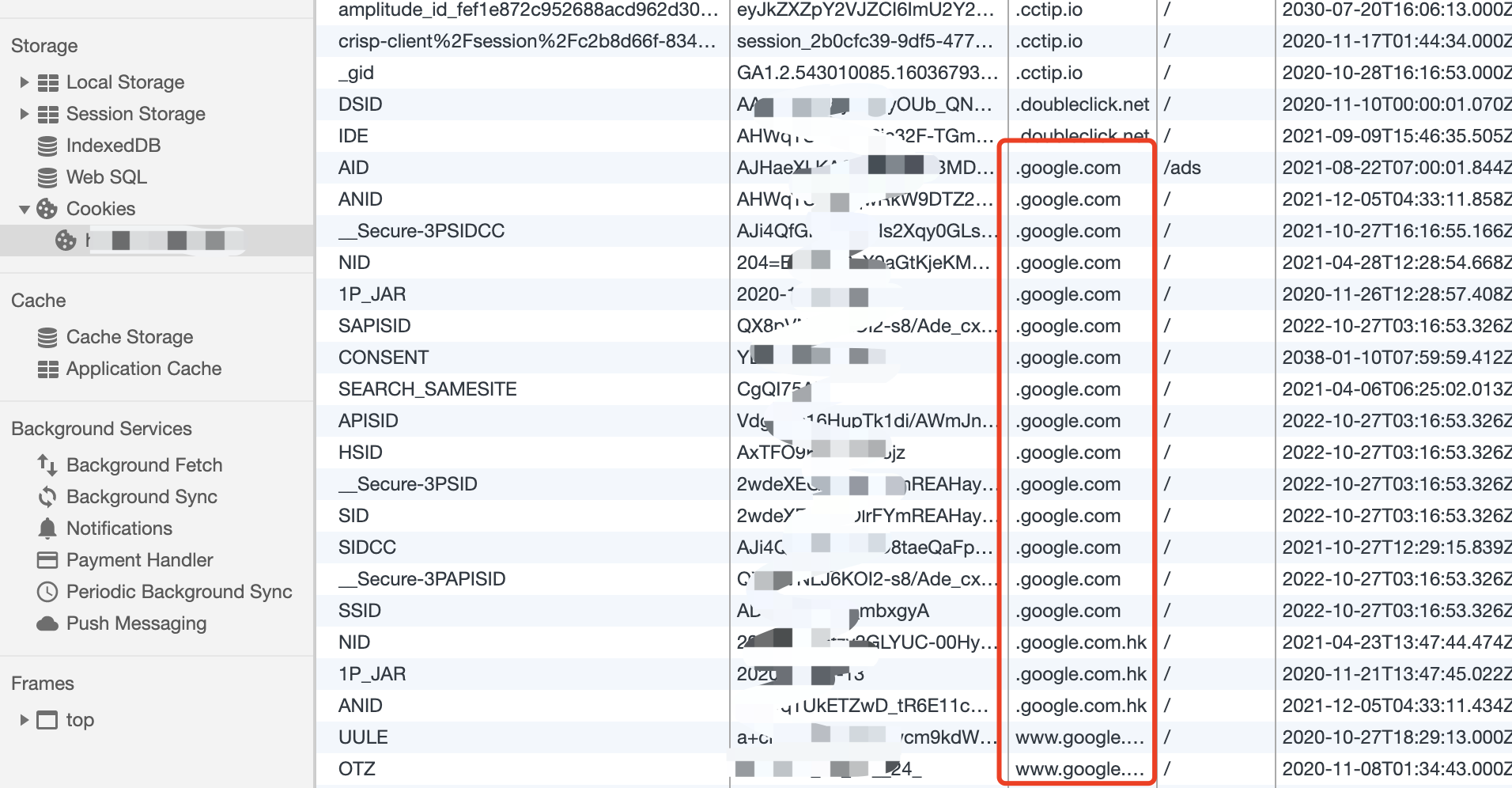

若上图,在淘宝主页面下,就存在hps.tanx.com和g.alicdn.com两个第三方cookie。分别是阿里旗下的阿里妈妈营销平台和阿里CDN。

说了这么多,像是欧美人和几家浏览器巨头在做商业利益和人权之间的权衡,远远影响不到我们。可事实真是这样吗?

广告营销

从上面阿里妈妈数据平台的第三方 cookie 看出,用户行为收集,数据分析,广告精准投放已经成为大多数平台类的主要收入。而他们标记用户的主要手段就是,在目标网站插入用户信息的脚本。

前端打点上报

与上述问题相同,使用过Google Analysis的童鞋应该知道,原理其实和广告追踪一样。更像是一种正义的数据收集 [滑稽脸.png]

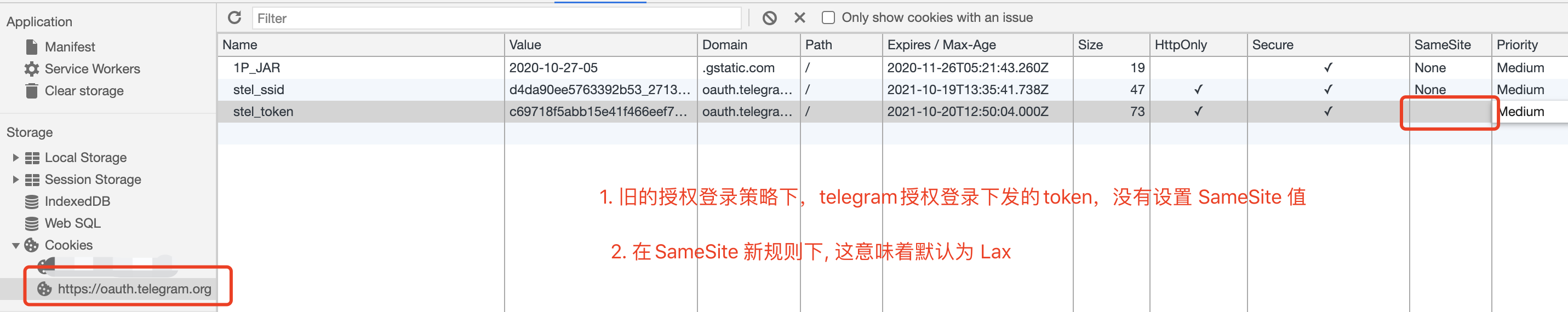

第三方登录受影响

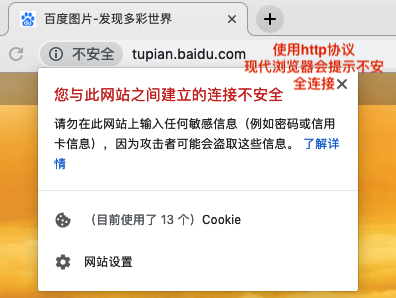

许多使用iframe嵌入第三方域的授权登录都将因为之前没有设置SameSite这个字段,而被浏览器升级导致默认为Lax,进而导致之前的Cookie而失效。 (抱歉,👇这个图我又用了一次)

作为下发授权的网站,需要默认更新你的设置cookie策略,声明式地将SameSite设置为None。

非同站的跨域请求

queen,那么前端通常页面部署在my.queen.io,api的域名通常为api.queen.io和login.queen.io,这种情况不受到SameSite的影响。api,调用兄弟部门的api, 则日常的CORS请求中携带对方域名的cookie就会出现问题,不仅仅是withCredentials = true可以解决问题的。SameSite=None第三方选择显式关闭 SameSite 属性,将其设为 None时,前提是必须同时设置 Secure 属性, 标明 Cookie 只能通过 HTTPS 协议发送,否则无效。

[1] JSON Web Token 入门教程

[2] 当浏览器全面禁用三方 Cookie - 知乎 by conard

[3] Cookie 的 SameSite 属性

[4] SameSite cookies - MDN

无论是BS时代还是CS时代,计算机诞生之初安全问题就一直是重中之重。安全也从来都是们大课题,是你出招我接招的武功比拼。本文仅结合当前见识过的一些招数,管中窥豹地去记录一些日常。

每一次成功的攻击,看似都是多个低概率事件结果。但墨菲定律告诉我们,会发生的事迟早会发生。

面向安全问题,自己问问自己:

linux环境,那前端代码的宿主浏览器和node本身你又了解多少呢?XSS的温床吗?cookie可以根据domain字段判断是否携带。那Same Site、secure和第三方cookie又了解多少呢?XSS、CSRF之外,网络劫持、非法调用又该如何防范呢?安全是一个体系,在恶意攻击面前,每一端每一环都是至关重要。程序从前端到后端,需要把安防这套组合拳打好配合,每个环节都至关重要。

CSRF (Cross-Site-Request-Forgery),中文称之为跨站点伪造攻击。主要流程如下

受害者在正常网站登录,并保存登录态到cookie中。攻击者诱导受害者进入事先准备好的第三方网站。攻击者准备好的第三方网站的恶意脚本中,会向被攻击网站发送跨站请求。被攻击网站中留下的cookie注册凭证,通过受攻击网站的后端用户检验。转移资产、查询敏感信息等)。受害者可能就不小心点击了一个恶意连接,打开的页面一闪而过,攻击可能就完成了。Get请求CSRF攻击,通常会埋藏在恶意网站中的一个图片链接中,或者给出一个超链接引诱用户点击。

img请求可以绕过浏览器同源策略限制<!-- 自动发起请求 -->

<img src="https://safebank.com/assets/change-verify-phone?new_number=1345678901">

<!-- 引诱用户点击 -->

<a href="https://safebank.com/assets/change-verify-phone?new_number=1345678901"></a>更换用户绑定的安全手机号。没错,利用的是你当前浏览器中cookie中的身份token做的身份验证。POST类型的CSRF

<form action="https://safebank.com/assets/change-verify-phone">

<input type="hidden" name="new_phone" value="1345678901">

<input type="hidden" name="other_param" value="xxxxx">

</form>

<script>

document.forms[0].submit() // auto submit

</script>表单自提交请求仍然能够轻松模拟POST请求,并且不阻碍浏览器携带用户token。http协议的同学,也知道GET与POST在请求上其实是相同的,只是两端的读取方式上不一致罢了。CORS类型的CSRFCORS不也是归类到POST或者GET吗?

Response Header中的 Access-Controll-Allow-Origin的时候,为什么不建议设置为*的原因。*意味着来自所有域的脚本,都可以对这个借口进行跨域访问,多增加了一层风险。第三方网站,除非你的网站已经被XSS攻击了。cookie信息,只是借用你的cookie而已针对CSRF特点,我们针对性可以做出防范:

直接阻止外域访问

cookie中的token。添加外域获取不到的信息到请求中

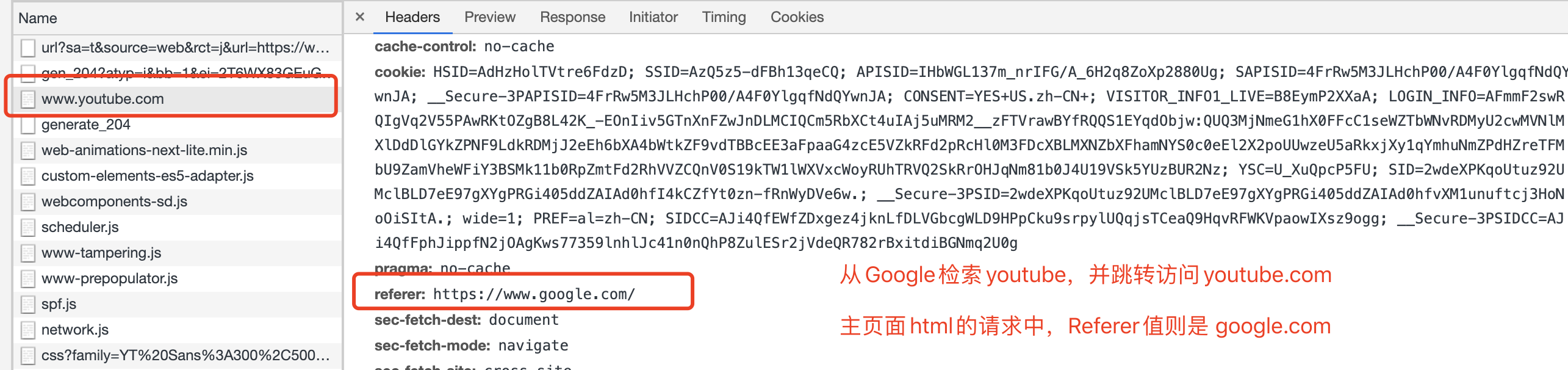

CSRF-Token 方案。都知道http请求是无状态、无连接的,每一次请求的信息都携带在了请求与相应头中,大家是否还记得Origin和Referer这两个Request Header呢?

The Origin request header indicates where a fetch originates from. It doesn't include any path information, but only the server name. It is sent with CORS requests, as well as with POST requests. It is similar to the Referer header, but, unlike this header, it doesn't disclose the whole path.

The Referer request header contains the address of the page making the request. When following a link, this would be the url of the page containing the link. When making AJAX requests to another domain, this would be your page's url. The Referer header allows servers to identify where people are visiting them from and may use that data for analytics, logging, or optimized caching

以上分别是是MDN对Origin 和 Referer 的描述,都可以标明当前请求的来源,而Referer更详细。但我们更需要关心的是这二者发送与不发送的情况。

POST请求下携带CORS请求也不会写带Origin请求头302重定向之后的请求中,不包含Origin请求头IE 6和IE 7下,使用location.href或者window.open进行跳转都不携带refererOrigin 或者 Referer 属于自己的白名单中,则直接拒绝访问。简单粗暴地处理,会有以下问题:

Origin和Referer请求头是不完全可靠,只能够借助这两个请求头进行初步防御。搜索引擎跳转访问页面的时候,referer一定会是搜索引擎的域名。会拒绝掉正常流量。

XSS攻击后,那么攻击方就会很粗暴地成为你自己的Origin了。要说读取Origin/Referer Header信息像是检查你的车票,那么CSRF Token则像是则是检查你的身份证了。区别就在于你能够拿出一些,别人拿不出来的东西,以证明该请求的合法性。

CSRF Token(一般为随机字符串和时间戳的哈希),服务器存储一份,下发给客户端一份。CSRF 攻击者利用,不再使用Cookie存储和提交CSRF Token请求参数中携带这个CSRF Token

beforeSend的intercepter中统一添加Token的合法性,决定是否要处理此请求

时间戳是否超过有效期Token是页面级别的,在大型网站中session存储大量的CSRF Token压力是巨大的。Redis作为多台服务器的公共存储空间页面为维度去处理Token,工作量巨大。<a>标签跳转、<form>提交,则需要手动添加CSRF Token回想我们使用金融类的App时候,就算你已经登录了,在支付的时候也需要再次输入支付密码呢?这里面的支付密码和验证码,其实就相当于支付这个请求的CSRF Token。这个方法适用于少数关键的几个接口。

{

email_verify_code: "1213"

password: "250f78769f22a8c43a2b767fde4b093fbbcdc28bd7ecac4bad883a4b0fcf30e3"

timestamp: 1603684913776

value: "2"

}在业务处理中去验证token的有效性极大地添加了开发工作量。那么有没有更轻便的形式完成简单的CSRF Token工作呢?尝试一下流程:

signKey,作为后续加密使用。// app.config.ts

const CSRFTokenInfo = {

appName: 'bank',

signKey: 'ajhsbdkjasu123123bjsbkd'

}signKey和请求参数,生成请求的signature:

path、当前时间timestamp、本应用的idappName作为、签名参数signKey作为准备参数md5进行加密生成signature// request.interceptor.ts

export function signRequest (config: RequestConfig) {

const key = CSRFTokenInfo.signKey

const timestamp = Date.now()

const fullPath = [(config.baseURL || '').replace(/\/$/, ''), (config.url || '').replace(/^\//, '')].join('/')

const path = new URL(fullPath).pathname

// 明文签名

const text = `app=${CSRFTokenInfo.appName}×tamp=${timestamp}&path=${path}&signature=${key}`

// 加密签名

const signMessage = md5(text)

// 绑定到请求头中

config.headers['x-service-app'] = CSRFTokenInfo.appName

config.headers['x-service-timestamp'] = timestamp

config.headers['x-service-signature'] = signMessage

return config

}input(app、timestamp)与output(signature)通过请求头传递到后端

// other request header...

x-service-app: bank

x-service-signature: 12dsf222ssdf312d334sddzxczxcz

x-service-timestamp: 1403691292039nginx + 本地脚本校验的形式完成前端请求中携带的app、timestamp 与 signature参数,结合nginx中拦截到的请求path,和前端一样重新计算一次signature,并且比对结果timestamp字段则另外再加一个防重放时间的检测signKey两端该如何同步呢?

CSRF Token不同,这次我们反向去考虑问题app.config.ts中配置的signKey加入到发布脚本中ci机器一般拥有ssh到正式环境的权限。ci发布流程完成后。执行特定的script以启动服务器上更新signKey为前端本地的值。

# build 项目 .....

# reload 项目 ....

# 更新signKey

python xxx/xxx/update-sign-key.py -- bank ajhsbdkjasu123123bjsbkdsignKey的更新是由前端驱动的,只有在发版的时候才会更新,实时性并不如第一种方案。nginx层处理,可以大量减少后端同学的开发工作量。所谓成也Cookie,败也Cookie。CSRF则是利用浏览器的这个规则漏洞建立起来的攻击方式。前面说到,安全每一个环节都有责任,那么作为前端主要运行环境的浏览器,是否也可以在Cookie规则上进行优化呢?

时间来到了2020年秋天,SameSite Cookie已经被大多数浏览器所支持了,甚至于有“浏览器全面禁止第三方Cookie”的传闻(连接),这里推荐一个小工具给大家测试自己浏览器的Same-Site Cookie支持情况,传送门==>

将cookie中授权 token的same-site属性设置为Strict则可以直接防止CSRF的发生。

根据上面的总结,CSRF攻击,通常有以下的特点

img作为CSRF请求时,Request Header中的MIME Type为图片,而想要窃取的数据返回的MIME Tpye一般为plain/text、json等文本信息事小而不为。被攻击时,每一个环节都不是无辜的。CSRF请求[1] HTTP headers 之 host, referer, origin

[2] 浏览器的沙箱模式

[3] 前端优化 - by Alex 百度

[4] 前端安全系列(二):如何防止CSRF攻击? - 美团技术团队

[5] CSRF 漏洞的末日?关于 Cookie SameSite 那些你不得不知道的事

CommonJS、AMD 不同, 而ES6 尝试在语言层面上实现了模块化的功能CommonJS 与 AMD 都需要程序运行时才能够知道模块之间的依赖关系。而ES 6 Module要做到的是尽量的静态化,在编译时就确定模块的依赖关系,以及输出和输出的内容。

export命令规定的是对外的接口,起的作用必须是与模块内部建立起一以对应的关系。

export语句输出的接口,与其对应的是动态绑定的关系,模块内部值的变化,会引起外部引用的变化。

例子一:

// modulesA.js

export const number = 3

export function add () {

number ++

}

// app.js

import { number, add } from 'moduleA'

console.log(number) // 3

add()

console.log(number) // 4例子二:

// moduleA.js

class ModuleA {

this.name = 'moduleA'

this.getName = function () {

return this.name

}

}

export const objA = new ModuleA()

// a.js

import { objA } from 'moduleA'

objA.name = 'name has been changed'

// b.js

import { objA } from 'moduleA'

setTimeout(() => {

console.log(objA.name) // 'name has been changed'

})以上两个例子都可以说明,模块内部,引用方拿到的模块引用,都是指向同一个内存空间,任意一方改变了内存空间存储的值,那么任意一方取到的都是最新的值。

ES6 Module的初衷是实现静态分析模块化,所以export必须处于模块顶层中,不能处于块级作用域内。

import会在静态解析时,会因为变量提升解拆分成声明与赋值两个部分。

console.log(abc)

import { abc } from 'module.js' // 并不会报错

与

export相类似,同样遵循ES 6静态模块分析的设计初衷,import语句同样不能处于块级作用域中,导出的值也不能够是需要运算后得出的结果。

import命令输入的变量都是只读的,因为本质上来说,引入的是输入接口。改变引用本身,则会破坏模块之间的引用关系。

原则上不允许修改接口,但可以修改接口里面的值,其他的模块也能够拿到修改后的值,但是我们不推荐这样做,因为这样的修改是不可以追踪的。

如下例子:

// common.js

export const config = {

port: '8899',

host: '123.77.33.56'

}

// a.js

import { config } from 'common.js'

config.port = '1234' // 不会报错

//b.js

import { config } from 'common.js'

console.log(config.port) // 一脸懵逼地拿到了 1234这个值,b的开发者回去看 common.js 又发现不了问题一下的语句,仅仅会执行

my.module模块的内容,但并不会引入任何代码。

import 'my-module'import * as myModule from 'my-module'优先解析

./与../等相对路径,直接写模块名称则需要根据配置文件的规则来约定。

$ node --experimental-modules a.mjs # 这里用node来运行一下比如出现以上循环引用的情况下,a.js为入口moduleB被首先加载

ES 6 Module的最终目的是要取代CommonJS 与 AMD,一统天下。那么在运行时的模块化中,使用import()函数来替代require()方法。import() 与 import 语句不一样,前者产生的是运行时执行的异步加载,后者产生的是静态的连接关系。

import()进行异步加载,方法返回的是一个Promise对象,那么显而易见的require()则是一个运行时同步加载的过程。

// 异步加载

import list from './list';

// 同步加载

const list = require('./list');因为

import()是运行时执行,显而易见的我们可以用于做code spliting。

const router = new VueRouter({

routes: [

{

path: '/foo', component: import('./Foo.vue'),

path: '/bar', component: import('./Bar.vue'),

}

]

})详细请参考👉这里

使用

export default相当于对外暴露了一个名为 default的变量,变量的值直接跟在export default后面。

使用

export from可以实现模块转发,(表面上相当于是import 与 export的结合),但要实际进行静态解析的时候,当前模块是没有引入目标对象的。

// moduleA

export { foo, bar } from 'moduleB'

console.log(foo) // error中间模块转发接口的时候,可以对接口进行改名

export { default as myModule } from 'that-module'

export * as myModule from 'that-module'<script type="module" src="./foo.js" type="module"></script>

<!-- 效果类似于 -->

<script src="./foo.js" defer></script>

defer关键字表示脚本的执行延迟到文档加载完成之后。

module关键字也能够使得JS在DOM加载完后才执行,兼容性不如前者,IE封杀,edge 16+,FF60+,Chrome 61+

当二者同时出现的时候,执行顺序是一般脚本 > module脚本 > defer脚本 > DOMContentLoaded事件

Javascript是一门具有垃圾回收机制的编程语言,程序员大部分情况下不用手动去操心内存管理的问题。

和EvemtLoop类似,虽然我们不能直接地去操控垃圾清理的执行与停止,但充分了解了V8的垃圾回收机制后吗,在编码上能够有意识地去较少GC的影响。相当于武林高手虽然绑上了手脚,但仍然能够识破别人的招式,以守为攻。

本文主要分为两个部分,① 先了解V8与内存的关系,② 再延展开去了解V8对内存的管理(清理)。

V8创始之初是设计为新一代Chrome的内核,作为浏览器所需要的内存当然就不需要太大,这从系统安全和浏览器本身需求两个角度去考虑的。V8自身的垃圾回收机制,若分配的内存过大,单次的垃圾回收时间则会过长,这是在服务端Node.js和前端浏览器都不可以接受的。heapTotal 和 heapUsed 分别代表已申请到的堆内存大小,和当前的使用量。external 代表 V8 管理的,但绑定到 C++ 对象的内存使用情况。rss: 全称是resident set size,是驻留集大小, 是给这个进程分配了多少物理内存(占总分配内存的一部分),包含所有的 C++ 和 JavaScript 对象与代码。'os.freemem()': os.freemem(), // 返回系统空闲内存的大小, 单位是字节

'os.totalmen': os.totalmem(), // 返回系统总共内存的大小堆外内存指的是那些OS分配给Node.js进程使用的内存资源,但却不是通过V8内核进行分配的内存,称之为堆外内存。

这种情况是因为在浏览器Api中,对于大多数场景不需要使用过度的内存,而Node.js在服务端的场景,需要处理网络I/O流,则需要更大的内存,常见的有BufferAPI。

V8的内存分为老生代和新生代,新生代较小,用于保存新产生的小的对象,老生代用于保存大对象和�经历多次回收仍未回收的对象。V8可支配堆内存大小。新生代使用Scavenge算法进行回收。其实现核心是Cheney算法。

From空间中所有能从GC Root对象到达的对象(说明仍该对象仍存活)复制到To区。对象晋升机制,直接移动到老生代中。

To空间的使用率已经超过了25%。Scavenge回收,却没有被淘汰掉的semispace内存会被释放掉。semispace空间对调。老生代中GC使用的是标记清除(Mark Sweep)策略 和 标记整理(Mark Compact)�策略。

Mark Sweep执行过程Mark Compact执行过程V8中会将这两种方法进行结合,在大多数情况下使用的是Mark Sweep,而在发生对象晋升而老生代空间连续不足的情况下,Mark Compact才会被触发。

incremental marking与lazy swaeeping为了减低全堆垃圾回收带来的全停顿,V8从标记到清除也都进行了改进,使得原本需要长时间的GC工作,得以分段实行。

DOM节点内存泄漏DOM 树和 JavaScript 代码都不引用某个 DOM 节点,该节点才会被作为垃圾进行回收。Node.js服务端端开发时,尽可能减少内存进行的使用。定时器 和 事件监听 要记得及时清除。Node.js中尽量使用 stream 和 buffer来操作大文件,而不是使用内存一旦数据不再使用,最好通过将其值设置为null来释放其引用,这个做法叫做解除引用(dereferencing)

一般会针对全局对象的属性进行解除引用操作,局部变量会在离开执行环境的时候自动被解除引用。

解除引用后并不会马上释放内存,只是相当于打上了一个标记,本轮GC回收的时候,会直接将指向null的数据原所占内存释放掉。

已知delete关键字也可以删除对象的一个属性,但不推荐使用

let const var fun声明的量,都不能都够使用delete去删除false,然后相当无操作configurable:false,那么也是不能够被删除的。delete相对于null操作范围基本限定在对象的属性上,能够实现资源回收的优化也仅限于对象的属性上。无论是V8下的浏览器还是Node.js其内存分配制度是极其相似的,Node.js仅仅在其使用场景需要处理大文件I/O的情况下增加了堆外内存的相关API。

因为没有实际去排查过V8在生产环境下的内存问题,接下来的文章就去看看Node.js和浏览器下如何排查内存隐患吧。

[1]《Javascript 高级程序设计 第三版》

[2] 浅谈Chrome中的垃圾回收 -博客园

[3]《Nodejs深入浅出》

[4] javascript 中的 delete

在计算机的世界中,浮点数的表示范围优先。浮点数只是可以近似的标识一个数而已。与许多其他编程语言不同,JavaScript 并未定义不同类型的数字数据类型,而是始终遵循国际 IEEE 754 标准,将数字存储为双精度浮点数。

用2去除十进制整数,可以得到一个商和余数;再用2去除商,又会得到一个商和余数,如此进行,直到商为零时为止,然后把先得到的余数作为二进制数的低位有效位,后得到的余数作为二进制数的高位有效位,依次排列起来。

用2乘十进制小数,可以得到积,将积的整数部分取出,再用2乘余下的小数 部分,又得到一个积,再将积的整数部分取出,如此进行,直到积中的小数部分为零,或者达到所要求的精度为止。然后把取出的整数部分按顺序排列起来。

接下来我们手动尝试一下10.3 + 12.4这个组合,我先帮你在Chrome devtool测试了一下

整数部分: 10 ==> 1010

小数部分: 0.3 ==> 01 0011 0011 0011 0011 ......

科学计数表示: 1.010010011001100110011... x 103

基准偏移量 + 偏移量(可能为负喔)。100 0000 00100100 1001 1001 1001 1001 1001 1001......按照Double Float Precision IEEE 754的格式拼起来就是0 100 0000 0010 0100 1001 1001 10001 1001 1001......

按照上面IEEE 双精度的表示法,两个数字分别如下,然后进行尾数求和

0 100 0000 0010 0100 1001 1001 1001 1001 1001...

0 100 0000 0010 1000 1001 1001 1001 1001 1001...

——————————————————————————————————————————————————

1101 0011 0011 0011 0011 0010

然后进行的是尾数的规格化: 1101 0011 0011 0011 0011 0010 ===> 0110 1001 1001 1001 1001 1001,其实就是把末尾的0给去掉了,前面补0。

因为mantissa(尾数部分)的固定长度为52位,最多可以表示252 + 1(也即是9007199254740992)个数字,用科学技术法来表示也就是9.007199254740992 x 10 16

在控制台我们可以测试到

(0.1).toPrecision(16) // "0.1000000000000000"

(0.1).toPrecision(17) // "0.10000000000000001"

(0.1).toPrecision(18) // "0.100000000000000006"

(0.1).toPrecision(20) // "0.10000000000000000555"

(0.2).toPrecision(16) // "0.2000000000000000"

(0.2).toPrecision(17) // "0.20000000000000001"

(0.2).toPrecision(18) // "0.200000000000000011"

(0.3).toPrecision(16) // "0.3000000000000000"

(0.3).toPrecision(17) // "0.29999999999999999"

(0.3).toPrecision(20) // "0.29999999999999998890"所以,我们平时看到的 0.1 并不是只有 0.1,看到的 0.3也不一定够0.3,只是显示精度作怪而已。

// 以定点表示法或指数表示法表示的一个数值对象的字符串表示,四舍五入到 precision 参数指定的显示数字位数。

numObj.toPrecision(precision)// 使用定点表示法表示给定数字的字符串。

numObj.toFixed(digits)其实,precision是指从小数点开始从左往右开始数,第一个不为0的数字开始计数。而fixed是指小数点后开始算的位数。

显而易见,在IEEE体系中,二进制只能够近似地表示某个浮点数数值。比如0.3,使用标准的转换方式,我们永远也达不到终止条件---小数位为0。在存储空间有限的情况下,无尽的循环到达边界时,就不得不进行类似十进制的四舍五入进位了。

在实际项目中,直接使用float、double进行金额数值运算也就有可能出现未知的情况,在许多语言中会有Decimal数据类型(例如Python)。而在JavaScript中则是推荐使用Decimal.js

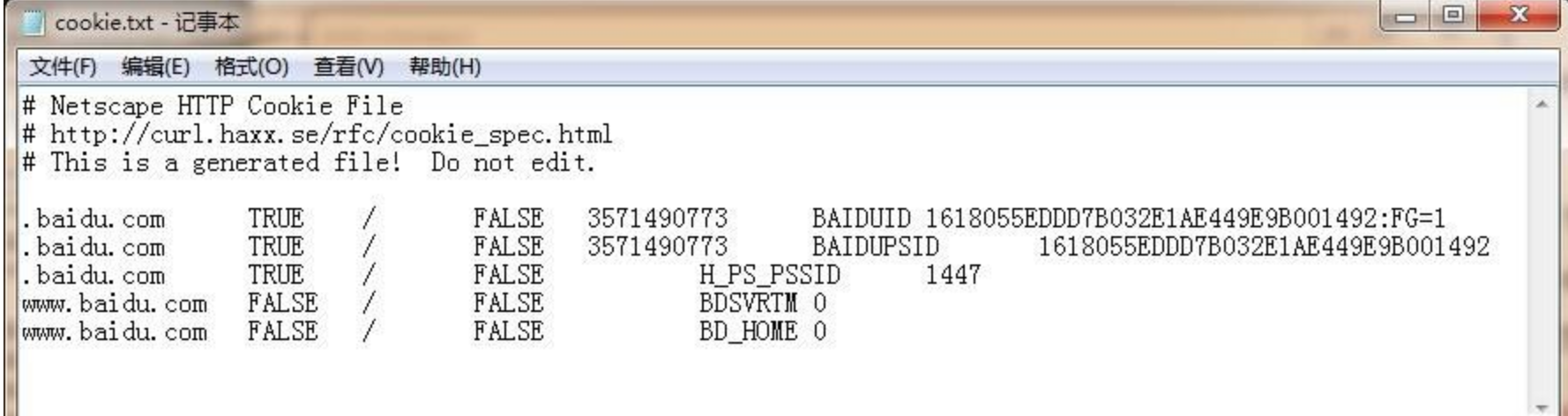

相比较于其他浏览器本地存储,cookie的特点在于符合匹配规则,则自动携带。服务端与客户端双方都可以写入。Cookie 的存在使得基于无状态的HTTP协议下,储存信息成为了可能。

首先定义一下,cookie是一段记录用户信息的字符串,一般保存在客户端的内存或者硬盘中。

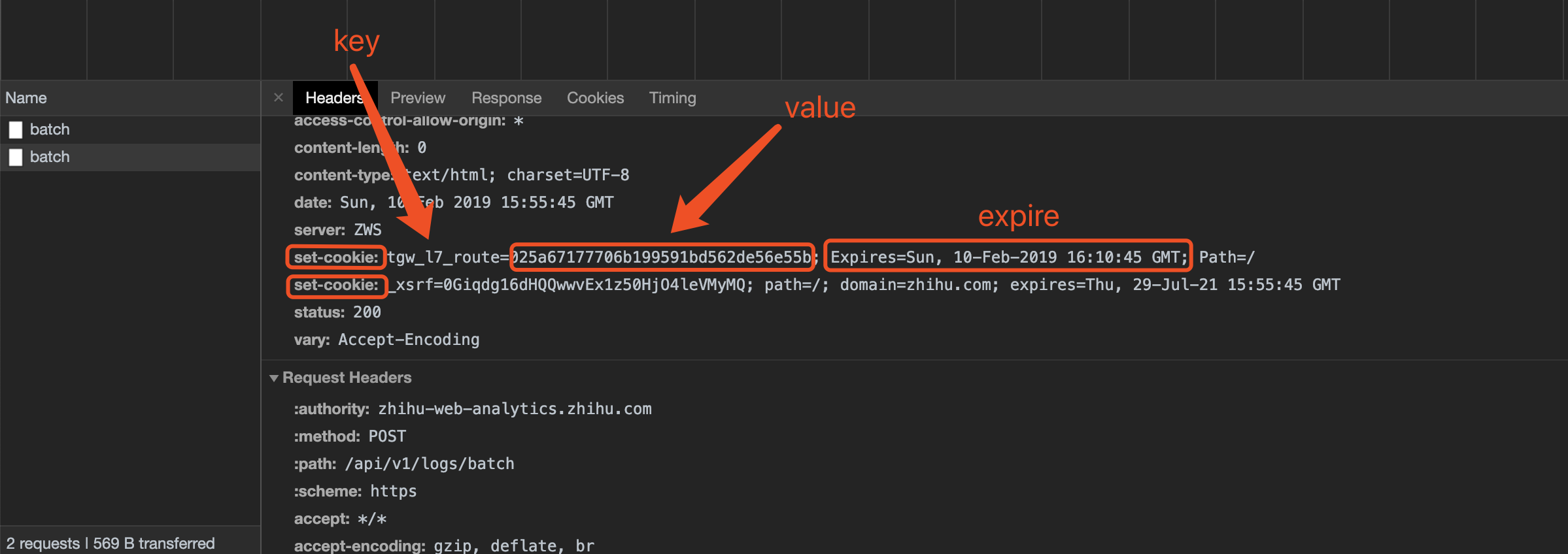

cookie的创建是由服务端的响应头,其中带着set-cookie的字段,来对客户端进行cookie设置。

| 属性名 | 作用 |

|---|---|

| Name | 表示cookie的名称 |

| Value | 字段表示cookie的值 |

| size | 表示cookie的大小 |

| 属性名 | 作用 |

|---|---|

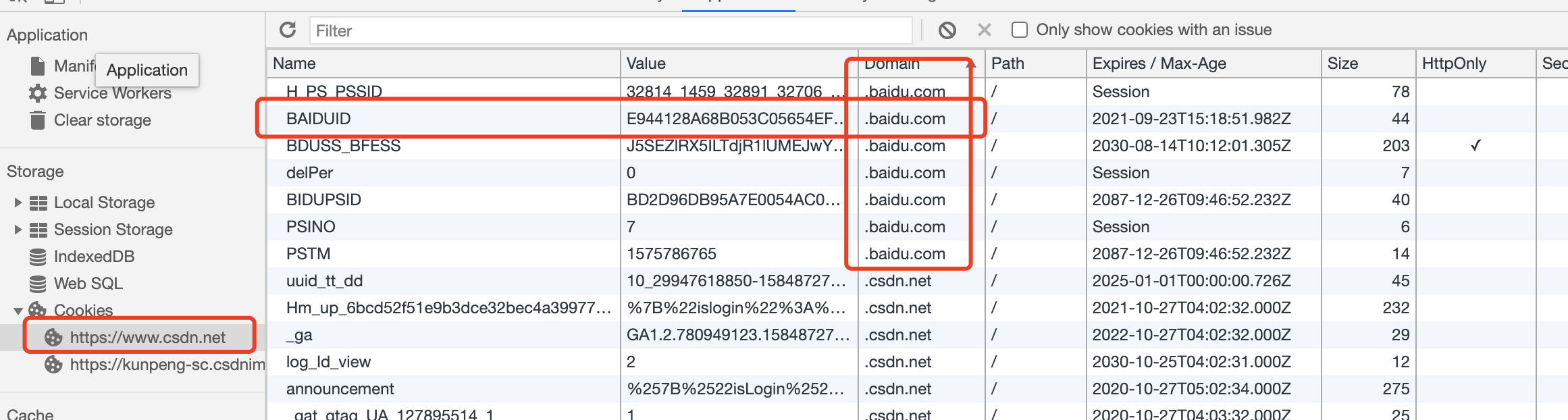

| domain | 表示cookie有效的域,默认值为当前域名 |

| path | 字段表示cookie有效的路径,默认值为/表示全匹配。 |

若不显示设置cookie的domain值,则浏览器会处理为生成一个只对当前域名有效的cookie。比如在map.baidu.com下,我们生成了一个cookie,但没有指定domain值,那么这个cookie,只有在访问map.baidu.com时候有效,而abc.map.baidu.com和user.map.baidu.com都是拿不到的。

domain为www.abc.com,path为/sale/img,则只有匹配www.abc.com/sale/img路径的资源才可以读取cookie。模式匹配,也就是向后匹配,上面的例子也能匹配www.abc.com/sale/img/qqq/ss| 属性名 | 作用 |

|---|---|

| Expire / Max-Age | 表示为cookie的有效时间,默认值session,也就是指浏览器session,也就是用户关闭浏览器就会清除掉这个cookie。 |

| Secure | 表示该cookie在安全的协议下才会生效 |

| HttpOnly | 只用于http请求,本地脚本不能够读写 |

| SameSite | 标明该cookie是否在跨站点请求时发送 |

cookie只会在�https协议或者ssl等安全协议下进行发送。document.cookie = "username=cfangxu; secure"cookie只会在http请求传输的时候携带SameSite 用于限制第三方cookie的使用, 在 a.com 下发起对 b.com 的请求,cookie携带与否,将取决于SameSite这个属性。

Strict 表示绝对禁止所有的跨站cookieNone 则表示不启用该规则Lax, 限制强度介于 Strict 和 None 之间, 相对于Strict仅允许以下三种情况的cookie携带

<a href="..."></a> 连接跳转<link rel="prerender" href="..."/> 预加载<form method="GET" action="..."> GET形式的表单same origin,但 same site中的 site,指的则是有eTLD + 1,其中 eTLD 指的是 effective top-level domain(有效顶级域名)github.com .gov.uk .org.uk也是有效顶级域名。参考👉这份名单你在闲逛某个网站A的时候,使用管理工具查看cookie,发现除了本域下的cookie,还经常存在某些知名搜索网站的cookie。

这并不是什么秘密了,而是搜索网站跟踪手机用户习惯的主要手段。

比如你的网站加入了某某广告联盟,则在你的网站中加入上报脚本,告知广告联盟这个用户来过这里,帮助联盟构建更完整的用户画像。

CORS调用部署在其他站点的第三方API存在影响关于域的设置,👆前面讲解domain部分有介绍。

cookie中的domin设置的跨域是指跨子域名都不可以访问,例如www.baidu.com和map.baidu.com是不可以跨域进行读取内容的。(看上述domain第一条规则)

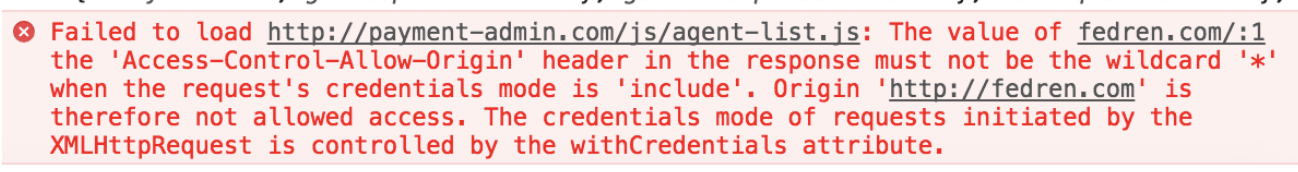

首先服务端要返回Access-Control-Allow-Credentials表明允许跨域请求携带cookie,并且Allow-Control-Allow-Origin字段也不能模糊的表示为*,而要写明cookie发送的域

再者,客户端也要设置请求的携带cookie

// 原生ajax请求设置跨域携带cookie

var xhr = new XMLHttpRequest();

xhr.withCredentials = true;读取cookie可以使用docuemnt.cookie

document.cookie = 'userId=xusfh123; maxAge=5000;path=/;secure'写入cookie也是用的是这个属性,但要注意,但是不支持同时设置多个cookie,需要分开多次调用设置属性值。

删除一个cookie的方法就是把对应字段的cookie值置空。

当服务器想共享cookie值给所有二级域名的时候,我们的cookie就应该设置为共同的上一级域名。比如.baidu.com(常用于单点登录)。建议设置cookie时候,都带上.通配符号,如.a.b.c.baidu.com。

一个服务器能够设置domian的有效的范围是,从自身域名开始,向上追溯到一级域名。比如a.b.c.baidu.com能够设置有效的cookie-domain是.a.b.c.baidu.com、.b.c.baidu.com、.c.baidu.com、.baidu.com。

不能够跨上级域名设置其他域的子域。不能够设置.a.u.c.baidu.com。例如如下:

set-cookie中,domain字段为 .dashboard.swain.com"this. set-cookie domain attribute was invalid with regards to the current host URL".的错误这就是一个跨子域设置cookie的实例,正确的方式应该设置domain为.swain.com

在不domain下的cookie即使同名也不会覆盖,若在同一个domain下,同名的cookie后者会覆盖前者。

secure与http-only都象征着更高的对应cookie条目的更高安全级别,当前cookie已经添加了对应安全策略的时候,更低安全策略的cookie写入相对于是无法无盖已存在的旧cookie值。

因为cookie会跟随请求自动发送的特性,所以浏览器对对一个域的cookie总大小和数目都有着不同的限制。

| 浏览器 | 数目(个/域) | 每域下的cookie总大小限制 | 其他 |

|---|---|---|---|

| Firefox | 50个 | 4k | |

| Chrome | 53个 | 4k | |

| Safari | 无限制 | 4k | |

| IE 7+ | 50个 | <4k | 超长则截断,超过数目则使用LRU淘汰 |

| IE 6 | 20个 | <4k | 超长则截断,超过数目则使用LRU淘汰 |

| Opera | 30个 | 4k |

cookie当做我们的本地数据仓库使用,而仅仅去存储一些用户的id,sessionID之类的身份验证性的简单数据。cookie 需要注意对应的有效范围、有效期、安全生效条件等属性SameSite的支持情况,有可能对于你的应用导致致命的bug。接下来会结合安全、隐私方向,说说最常见的用cookie作为用户身份标识,遇到的问题和解决方案。

[1] 从url中解析出域名、子域名和有效顶级域名 - alsotang

[2] 干掉状态:从 session 到 token

[3] 正确使用cookie中的domain

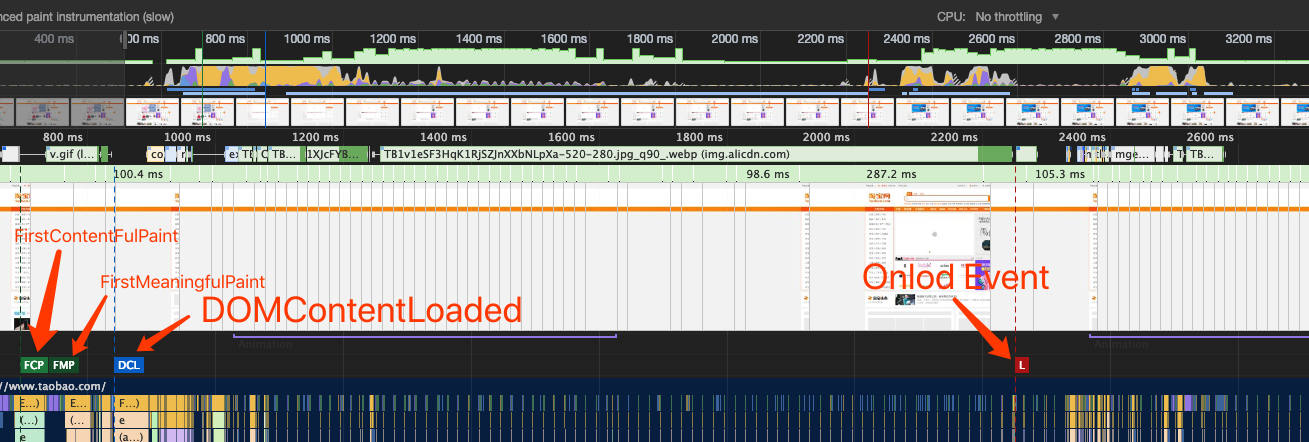

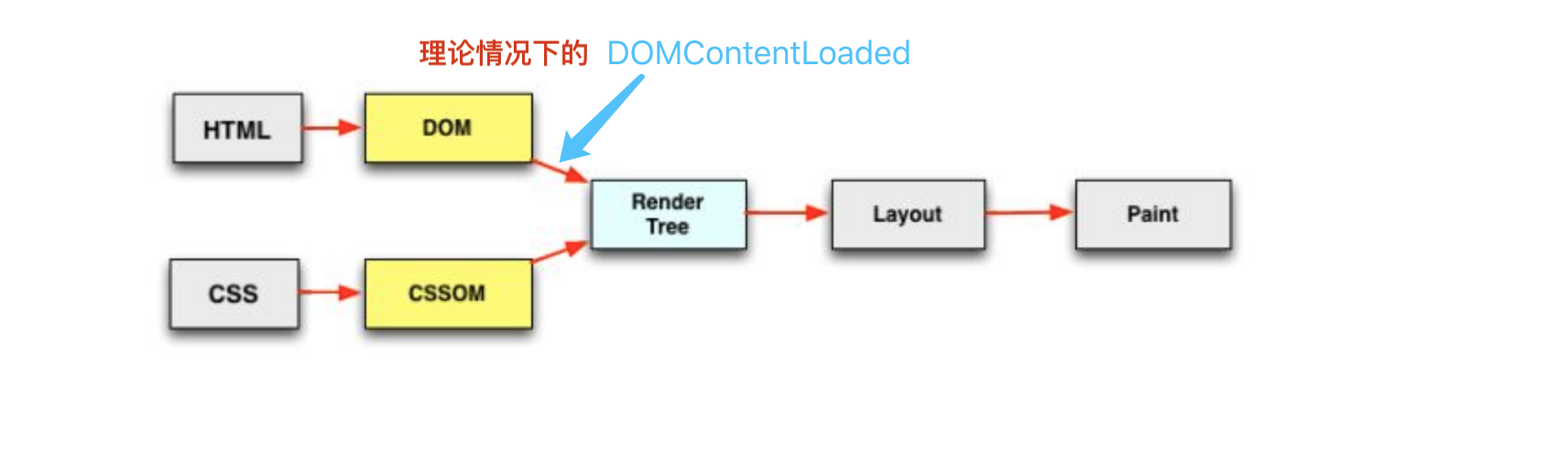

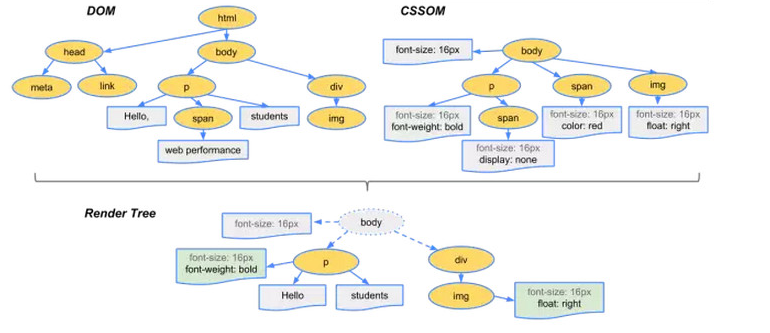

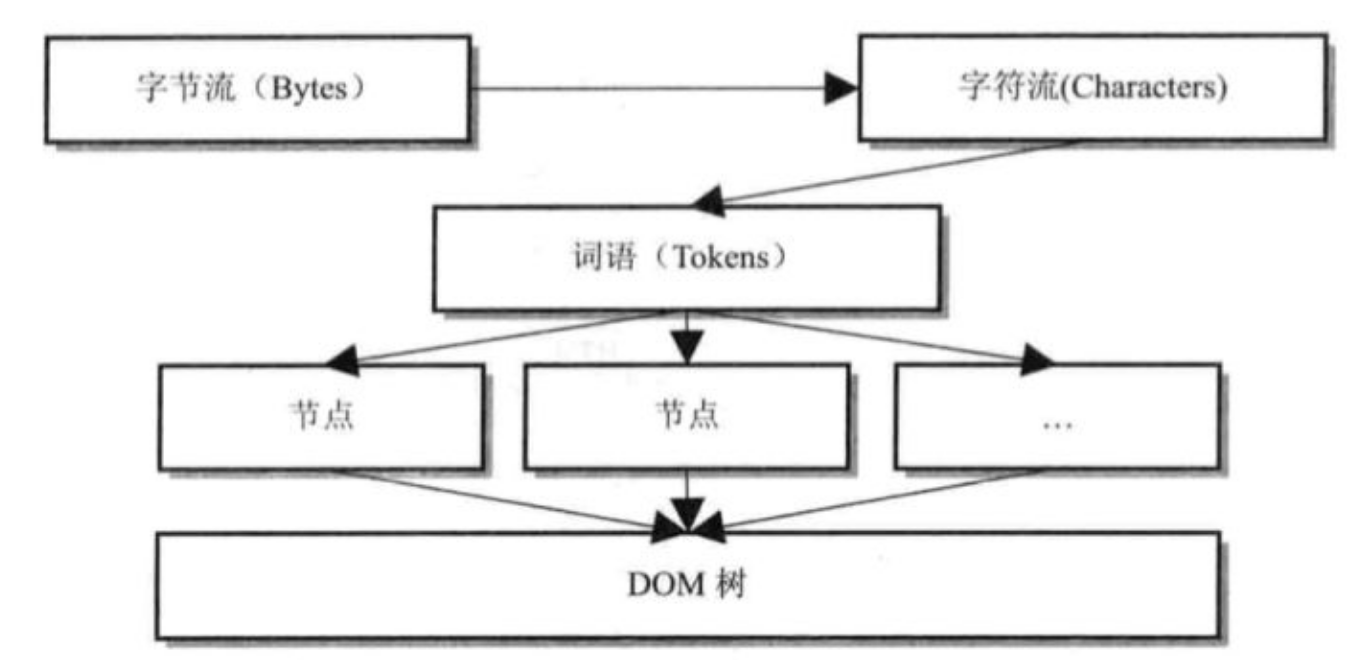

我们知道在浏览器渲染中,页面渲染有几个关键的时刻比如说First Paint、DOMContentLoaded、Onload以及可交互时间。

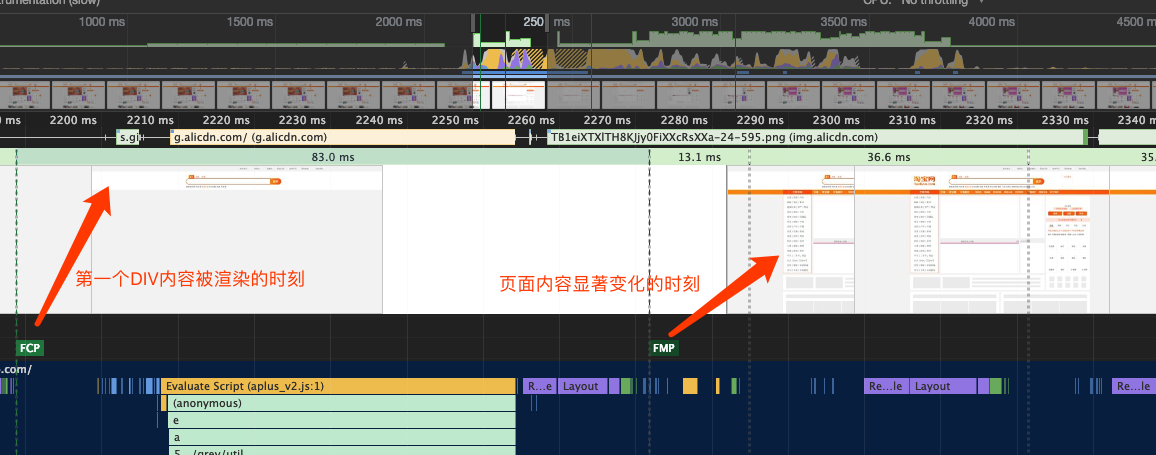

打开我们亲爱的淘宝页面,使用devtools中的Performance面板录制一段从初始加载到完成的过程,可以看出各个资源的下载和执行的过程,也能看到Chrome给我们标出了所需要注意的几个关键时间点。

直接看字面意思,就是DOM的内容加载(解析)完毕了。而据我们之前所知,页面中脚本(无论是外链还是内联)的执行都会阻碍DOM的解析,也就是说脚本的执行,会延迟DOMContentLoaded事件的到来。

如上图所示,DOM的解析阻塞于脚本的加载,而脚本的加载也受限于脚本前面的css加载完成后才会执行,在任何情况下,DOMContentLoaded的触发不需要等待图片或者其他任何资源的加载完成。

这里插一个题外话,async标明的脚本不知道何时会加载完,而后立即执行,所以DOMContentLoaded事件也不会等它。但type=module和defer标明的<script>标签脚本一定会先于DOMContentLoaded事件。

以下代码都是我们熟悉的用于监听DCL事件

// jQuery

$(document).ready(function(){......}); // 或者

$(function(){...});

// 原生

document.addEventListener('DOMContentLoaded',function(){......})首先回答是不可以的。

因为DCL的定义是整个文档都加载完成,当然也包括body外,HTML内的script标签。

但是我们要是把script标签放到了header中,往细说是阻塞了body的解析,那么body中有啥?当然就是我们页面的主要内容结构啦。

理论上浏览器会等待DOM和CSSOM都解析完生成RenderTree才开始布局和绘制,但是现代的浏览器,为了减少白屏等待的时间,都会进行HTML局部的渲染。

上面的截图同样来自于淘宝首页,我们可以看到在DOMContentLoaded之前,就已经触发了FirstPaint,页面空白的时间的不到30ms。但是DOM远远没有解析完,只是部分完成了。这个过程中,我们发现并没有表示script执行的黄色片段。

下面我们来看看www.hoopchina.com 虎扑网的首页

�所以我们将script标签写在header中则会阻塞body的解析,也就是会阻碍First Paint的到来,也就是说用户看到的白屏时间会更长。

所以呢,js代码沉底,只是提前 First Content Paint 的时间,而不是减少 DOMContentLoaded 的时间。

看到图中红色的块块了吗?...在ie 6-8下,请做以下兼容

document.onreadystatechange=function(){

/*dom加载完成的时候*/

if(document.readyState=='complete'){

fn&&fn();//处理事情

}

};�既然上面提到了FirstPaint那么我么就先说说First�Paint相关的知识。

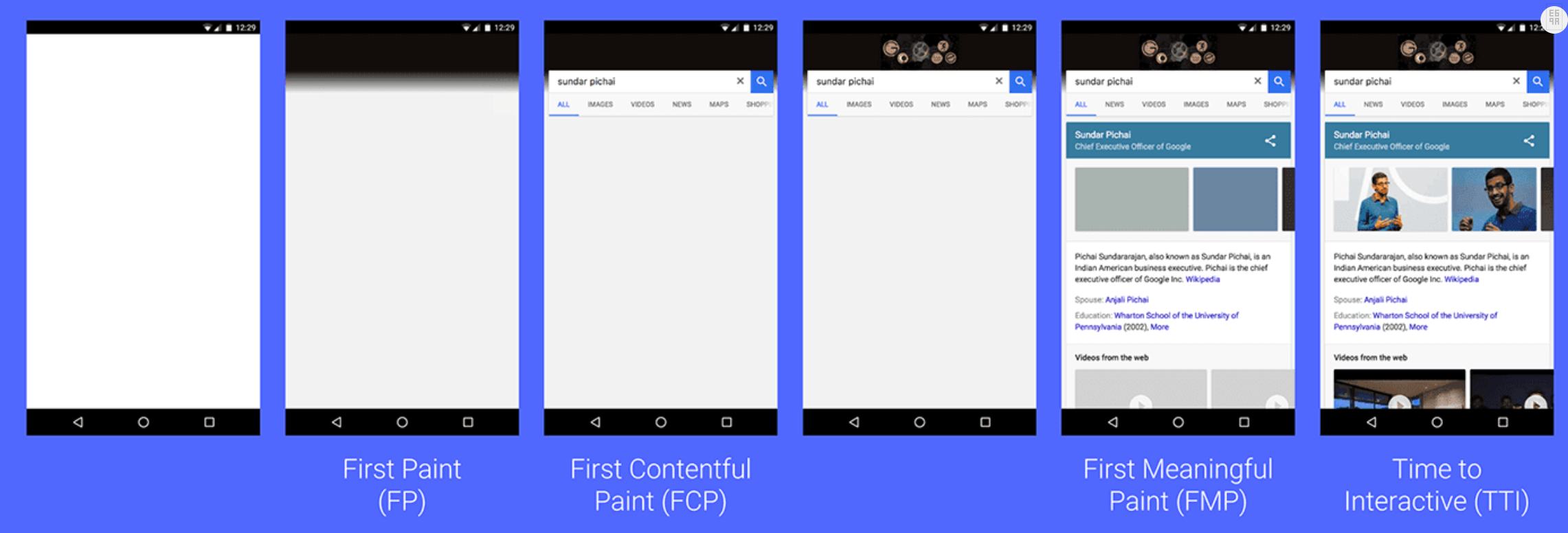

首先呢,Chrome 的devtools给我们细微的划分了FirstPaint为First ���Contentful Paint(首次有内容的渲染)和First Meaningful Paint(首次有效的渲染)。

使用 window.performace.getEntriesByType 这个api可以检测到这两个阶段的开始时间。

FirstPaint 表示的是页面上第一个像素被绘制上去的时刻,有可能是背景颜色。

FirstContentfulPaint 表示的是浏览器第一个DOM节点渲染到品目上的时间。

从上面的测试结果也可以看出来,二者之间的间距非常非常之小,但这两者共同决定了我们常说的白屏时间。

FMP在chrome下的定义是,浏览器计算页面的内容高度或者说是内容多少变化最大的一个时刻,和我们通常意义上将的首屏内容(不包括滚动下滑的内容)意义相近。内容有没有意义,也只是我们网站开发者才能够知道的,所以我们能够根据这一条规则进行优化。

还是来看看淘宝首页的情况吧,FCP的时候出现了顶部的搜索框,FMP的时候基本完成了骨架屏的渲染。

我们知道浏览器中的Javascript是单线程的,浏览器的渲染机制也规定了,UI渲染、�JS执行和用户操作一个时刻只能够执行一种,一定会有一个先后顺序。(宏任务微任务的概念看这里,传送门👉)

既然用户的操作会被JS的执行和UI渲染所阻塞,既然也不能完全避免这样的情况,我们就需要将这样的占用时间尽量缩短,或者说是切割。也就是说将长的JS代码执行任务,切割成小的执行任务。

从人的感受上来说,用户给出的操作最好在100ms内要得到操作反馈,否则就会让用户感觉到卡顿或者说不爽。

其实就是“可交互时间”的英文翻译,我们常简称为TTI。定义上来说,指的是用户看到了页面的大部分内容(近似于FMP)之后,准备进行用户操作,但是此时的主线程又被JS的执行所占用着,想输入,想点击但是都得不到浏览器的响应。

借用一张图来表示,图不是我自己画的....来源在这

在文章首部的图中,我们发现DOMContentLoaded之后还有一个Onload Event,它表明的是页面上所有的资源(图片、音频、视屏)都被加载完的时刻,就会触发onload事件,并且它是固定会晚于DCL时刻的。因为onload是指DOM中的所有资源,而影响DCL只有CSS和JS这两种资源的加载与执行。

重要的是,也能确保使用async标记的script被加载并且执行完,假如我们的一些业务代码是依赖于这些异步加载的第三方库的,则不会出现业务代码操作失败。

但因为图片、视屏这一类的资源一般都是加载时间较长,所以onload事件的使用,需要谨慎,否则会大大拖延业务代码的执行。

对应到代码上,就是使用JS去监听window.onload事件

window.onload=function(){

document.getElementById("bg").style.backgroundColor="#F90"; //DOM操作

// 或者其他任意业务代码

}总结一下,其实前端性能优化,就是服务于用户的感受的,说白了就是用户要感觉到爽,那么我们能不能够从交互的角度来量化一下用户的感受呢?

以下是几个当你打开一个页面后,脑子里会�闪过的几个念头...

| 闪过的念头 | 白话描述 | 内部因素 |

|---|---|---|

| 咦?访问成功了吗? | 用户看到了页面切换,看到了白屏?不知道服务器是否有响应? | FirstPaint、FirstContentfulPaint |

| 内容加载完了吗? | 用户陆续看到了内容,但不知道页面内容加载完了没有? | FirstMeaningfulPaint |

| 我可以动鼠标点击了吗? | 页面看起来时加载完了,但是用户不知道自己可以操作了吗? | Time To Interact |

| 爽不爽? | �整个流程下来,页面是否闪烁,内容上下乱跳,让用户有一个直观的感受,爽与不爽? | 是否有长任务占用主线程,onload之后是否又频繁造成重排 |

回看Timeline,阻塞FP和FCP的就是head标签中的css和Javascript,但是有些css确实首屏需要的(key-css的概念,看这里👉)则仍需要保留在head中避免频繁重排,Javascript脚本则可以放心地沉到body底部或者defer、async。

使用http缓存本地资源,减少请求时间也是很重要的一点。

FMP是关键内容的出现,或者是大部分内容出现的时间。在这一点上客户端的渲染能力,远远比不上服务端的渲染能力,所以首推SSR。

TTI强调的点是交互,那么我们要消除或者减少的是页面UI渲染和JS脚本执行。

DCL之前去加载执行,而不是让用户看到了页面再去等待加载时间,因为用户看到白屏至少不会想要去操作,或者说用户看到了所有内容就会立刻想去操作,若得不到反馈,会极为的不爽。TTL最后的这一条优化,可以根据网站功能类型的不同去做不同优化,不要墨守成规。

在非首屏情况下,大体不会有渲染的问题,但是用户的行为会触发javascript的执行,比如说复杂的JS计算也是会导致用户操作的卡顿,页面进入假死状态。

web-worker进行多线程计算,然后返回结果到主线程。过去两年的时间有幸可以去主导多个 toC 的 web 项目,随着用户量的不断增大,也就让“朗读并背诵全文”的全前端优化手段们得到了实践的机会。

项目的基本信息:

nuxt.jsGoogle AnalyticsSentry接下来说说自己在过去一年多里,优化项目是如何在项目中落地。

随着项目功能模块地增多、用户量也在不断地积累,运营同学那边收到用户的反(to)馈(cao)越来越多...

*xxx is great, but the xxx on web sometime drive me crazy... 😡

一个帮我们推广应用的大V 在推广视频中,面对首页的 8s 加载时间,竟然习以为常地吹起了口哨,平静地向粉丝说 “Dont worry, It just usually take a while.”

天天忙着改 bug 的我们组还没来得及看运营小姐姐的的消息,就被老板在群里 艾特了。

两张图重重地砸在了我的脸上,将近 10s 的平均加载时间,和主要用户来源马来西亚的加载时间甚至达到了 11.41s。

随手打开线上的项目主页,就碰到了和 大V 哥一样的尴尬.....,nuxt 的loading 足足占据了屏幕 15s 才缓缓出现内容。

要我自己是用户早就关掉了......

冤有头债有主,解铃也还需寄铃人嘛。既然是 “平均网页加载时间” 惹了众怒,那就查查 Google Analysis 对这个词儿是如何定义的吧。 传送门👉

Google Analytics 的描述和我们web开发中的 load 事件基本一致。

当整个页面及所有依赖资源如样式表和图片都已完成加载时,将触发load事件。 --- MDN

通过具体分析得知,有以下几个点影响了我们的 load 时间...

iframe页面,但由于各个国家墙的原因,这个脚本静态会加载失败Javascript 文件大小太大,网络加载速度也很慢,直接导致了用户看到大大的loading图标过久。你一定也遇到过首屏是列表页,每个列表项上都有一个或者多个图片需要加载,大量的图片同时加载时间十分不确定,同时渲染到 DOM 上也会造成页面的卡顿。

老问题了,方法也多:

多数情况下,这部分脚本的加载,不会影响到首屏的主观体验。但当首屏加载完成,用户主动去触发该功能时,需要做好所对应功能 “加载未完成” 等提示。

const targetScript = document.getElementById('targetScript')

targetScript && targetScript.onload = () => {

const authIframe = document.getElementById('auth-iframe')

authIframe && authIframe.onload = () => {

loaded = true

}

}在自己合适的地方自定义 page load 事件,这样使得 Google Analytics 上的数据更直观。

ga('send', 'timing', 'JS Dependencies', 'load', timeSincePageLoad);因为实际上我们需要的是 TTI (可交互时间)。这部分内容可以参考这篇笔记 👉

资源加载速度慢有两个方面,一个是资源本身体积过大,二是网络传输速度太慢。

webpack打包优化网上的资料很多,这里就不拓展开讲了。这次只是习惯性地运行一次 analyser,便可以发现那个眨眼的 lodash.js

// 全部引入

import { toNumber, sortby } from 'lodash-es'

// 改为单独引入

import toNumber from 'lodash.toNumber'

import sortby from 'lodash.sortby'上面的一顿操作后,JavaScript 文件的大小的到了控制,但海外用户反映还是慢慢慢慢慢慢慢慢慢慢慢慢.....

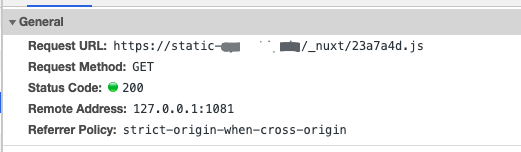

这时候针对性地上了一个部分地区的 CDN 服务。域名配置的是 static-xxx.io。

根据 Nuxt.js 的文档(传送门👉)配置一下,发布前尝试一下连通性...就可以发到线上试试啦。

export default {

build: {

publicPath: 'https://static-xxx.io/_nuxt/'

}

}随着 Web 应用的不断复杂化,早就已经不是填写一个表单就离开的那个时代了。特别是在移动端使用你的 web 服务时,总是想要体会到和原生 App 一样的感受。此时,本地缓存就变得越来越重要了。

无论是作为用户还是开发者,你是不是也受够这无穷无尽 loading。滥用 loading 作为你页面的遮羞布,长此以往只会让你的页面越来越不可用。

ajax 或者 websocket 进行静默地数据更新loading 进行数据更新,更新后也缓存到本地对于 loading 提醒的其他建议,可以看看这篇笔记

针对于数据实时性要求强的业务模块,请求的信道的搭建时间已经远远地超过了数据的实时性本身。这次使用的是 websocket 的解决方案。

在减少了请求我收的同时,也带来了一些问题:

http 请求不兼容具体操作请参考这篇笔记👉

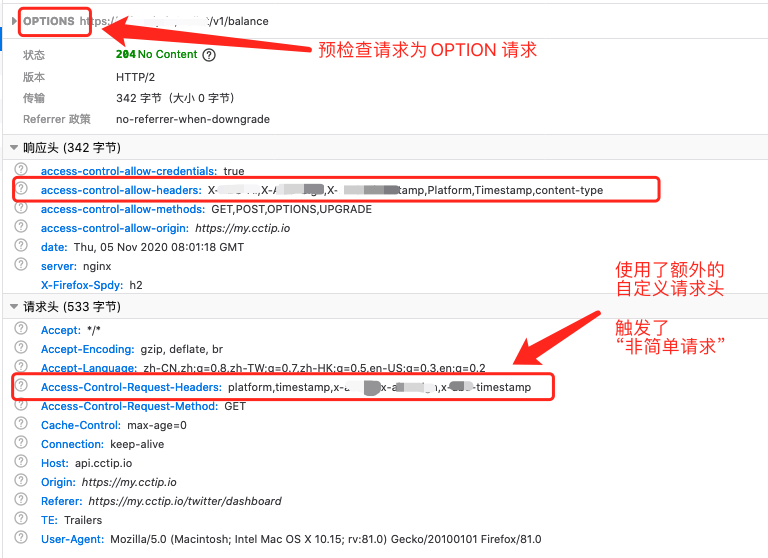

数据请求一般要求下都是发送的非简单请求,这其中就会包括预请求的时间。使用 Access-Control-Max-Age: xxx 减少预请求的次数。

详细的原理请参看这篇笔记👉

prefetch 是浏览器的一种机制,可以利用空闲时间提前先帮你下载好 未来 可能需要的资源。

dns-prefetch 可以帮助我们在用户仅仅访问主页的情况先,优先帮助用户完成 DNS 查询,并缓存结果再浏览器中。

<!-- 十分可能访问页面 -->

<link rel="dns-prefetch" href="https://doc.xxx.io/" >

<link rel="dns-prefetch" href="https://home.xxx.io/" >

<!-- 肯定会用到的接口URL -->

<link rel="dns-prefetch" href="https://api.xxx.io/" >

<link rel="dns-prefetch" href="https://login.xxx.io/" >类似于 http 2.0的 server push的意思,前端也可以要求浏览器提前把需要的 css 、font 等资源提前下载到缓存中。并结合资源的 max-age 和 expire 缓存策略达到跨页面使用。

<link rel="prefetch" href="telegram.auth.com/123ahisdhu2.js" />MDN 连接: [dns-prefetch] [prefetch]

最近工作室的官网准备要上线了,也因为 https 的普遍使用,https 的原理读得多了,现在就来实操一次,为网站建立 https 证书吧。

以腾讯云(免费)申请流程为例子

nginx版本

请根据自己的服务器平台选择证书包

使用scp等方法把证书放到服务器的conf目录,例如

$ scp xxxss.com_bundle.crt xxxss.com.key xxx.xxx.xxx.xx:/usr/local/nginx/conf/cert

with-http_ssl_module 模块在你安装nginx的目录下(这里要注意,不是/usr/local/nginx这个,一般会是nginx.10.x.x带版本号的那个,下面有一个configure可执行文件),用它来安装这个ssl模块

$ ./configure --with-http_ssl_module

然后在同样目录下执行make命令

$ make

然后备份之前的nginx,再将新配置的nginx覆盖掉旧的

$ cp /usr/local/nginx/sbin/nginx /usr/local/nginx/sbin/nginx.bak

$ cp objs/nginx /usr/local/nginx/sbin/nginx

哦对了~👆上面这个覆盖文件会需要你停止当前的nginx,避免你又查了,给你搬运过来了

$ nginx -s quit # 等待当前程序执行完后退出

$ nginx -s stop # 强制停了吧

server {

listen 443;

server_name xxxxxxxx.club; # 此处为您证书绑定的域名。

ssl on; # 设置为on启用SSL功能。

location / {

proxy_pass http://nuxtSSR; # 前面配置的一个前端项目

}

# SSL 证书配置

ssl_certificate cert/1_woniuhuafang.club_bundle.crt; # 您证书的文件名。

ssl_certificate_key cert/2_woniuhuafang.club.key; # 证书的私钥文件名。

ssl_session_timeout 5m;

# 使用此加密套件。

ssl_ciphers ECDHE-RSA-AES128-GCM-SHA256:ECDHE:ECDH:AES:HIGH:!NULL:!aNULL:!MD5:!ADH:!RC4;

ssl_protocols TLSv1 TLSv1.1 TLSv1.2; # 修改protocols。

ssl_prefer_server_ciphers on;

}

搞定之后检测一下语法没问题就重启happy吧

$ nginx -t # check 一下

$ nginx

[warn] the "ssl" directive is deprecated, use the "listen ... ssl" directive instead

移除 ssl on配置,修改listen 443 为 listen 443 ssl

在请求的资源很多的情况下,http1.x是会同时打开6~8个tcp链接,所以我们在前端机操作的时候,就有了压缩合并css/js资源,使用雪碧图这样的�优化方案。

而http2使用单一的长链接去加载所有资源。有效地减少了tcp握手所带来的时延,特别是当请求使用了ssl加密请求时,握手次数会大大增加。

结合上面图说明,http2.0 可以同时对多个资源进行请求,不受 6~8 链接的限制,图中看出,服务器接收到请求的时间是一样的,而根据不同的资源做出的响应时间长度不一样而已。

浏览器所在的操作系统,对半开连接数有限制,用于保护 TCP/IP 协议栈资源不被迅速消耗殆尽。所以浏览器不会同时发送过多的 tcp 链接

浏览器操作启动一个 tcp 链接都需要一个开启一个线程,若同时创建过多线程,性能会下降的很严重。而综合考量 6~8 个 tcp 链接(线程),并且在 http 1.1 下的keep-alive 机制,这些链接(线程)是可以被复用的,减少开销。

对于服务器来说,同时能够接受的请求数目也是有限的。这时候,作为一个 client,不进行作恶就很关键了,作恶你就和恶意程序没有区别了。所以浏览器是选择性的减少同时连接的数目。

每次的TCP链接,都会涉及到一个慢启动过程,也就是连接建立之后,数据线是慢慢地传,然后数据窗口再慢慢地增大,传输速度才达到稳定峰值。

而http2减少tcp的连接数为1次,大大减少了冷启动的滑动窗口的次数。

HTTP 2.0 把每一个资源的传输叫做流 Stream,每一个流都有他的唯一 id 称之为stream ID。

每一个流就像是一批货物,都有自己的编号,每个数据流最后都被切分为数据帧(frame)。同一种货物(最后要拼装在一起的不同frame)要遵循 FIFO 的原则去传输,但是不同种货物之间,可以相互穿插,先后出发。

流id的是递增的已关闭的流的编号在当前连接不能复用,避免在新的流收到延迟的相同编号的老的流的帧。所以流的编号是递增的。

frame传输若把每次建立 TCP 连接,称之为修路的话,那么 http2 则只修了一条路,然后把不同文件请求的 data 切分为多个二进制 Frame,头部信息放在 HEADER FRAME,数据体存放在 data Frame 中,装在不同的的货车上,然后让他们同时在修好的道路上跑,充分利用了道路的宽度,也充分利用了现有的宽带带宽。

HTTP/2规定了多种类型的帧

| 名称 类型 | 帧代码 | 作用 |

|---|---|---|

| DATA | 0x0 | 一个或多个DATA帧作为请求、响应内容载体 |

| HEADERS | 0x1 | 报头主要载体,请求头或响应头,同时呢也用于打开一个流,在流处于打开"open"或者远程半关闭"half closed (remote)"状态都可以发送。 |

| PRIORITY | 0x2 | 表达了发送方对流优先级权重的建议值,在流的任何状态下都可以发送,包括空闲或关闭的流。 |

| RST_STREAM | 0x3 | 表达了发送方对流优先级权重的建议值,任何时间任何流都可以发送,包括空闲或关闭的流。 |

| SETTINGS | 0x4 | 设置帧,接收者向发送者通告己方设定,服务器端在连接成功后必须第一个发送的帧。 |

| PUSH_PROMISE | 0x5 | 服务器端通知对端初始化一个新的推送流准备稍后推送数据 |

| PING | 0x6 | 优先级帧,发送者测量最小往返时间,心跳机制用于检测空闲连接是否有效。 |

| GOAWAY | 0x7 | 一端通知对端较为优雅的方式停止创建流,同时还要完成之前已建立流的任务。 |

| WINDOW_UPDATE | 0x8 | 流量控制帧,作用于单个流以及整个连接,但只能影响两个端点之间传输的DATA数据帧。但需注意,中介不转发此帧。 |

| CONTINUATION | 0x9 | 用于协助HEADERS/PUSH_PROMISE等单帧无法包含完整的报头剩余部分数据。 |

针对不同类型的资源,HTTP2 进行了不同程度的优先传输。比如页面传输中的,script和link会被优先传输,而类似于图片这种较大的文件优先级则降低。

在 http1.x 中,我们可以直接在报文中看到报文头的内容,便于开发人员调试。但随着https 的普及,SSL 加密传输也是 plain text 变成了二进制,明文调试也不存在。

上图是我们尝试发送一个 hello world 字符串,整个数据体�加上报文头,一共超过了300个字符,浪费了很多的大小

header内容HTTP使用HPACK压缩来说压缩头部,减少了报文的大小。具体实现是将报文头中常见的一些字段变成一个索引值index,也就是维护一张静态索引表,例如把method:POST,user-agent,协议版本等,对应成一个index值。

静态索引表是固定的。

浏览器下的系统目录下的 http2.0 静态表格

动态索引表功能类似于静态索引表,动态索引表的索引存放在静态索引表中。请求发现了新内容,则在动态索引表中建立新的索引。

那么我们的动态表格的索引,就从 62 开始计算。有新字段增加,就用最小的索引去记录它,而不是使用大的索引。

table_.push_front(entry);对于经常变化的内容,类似于“资源路径”,HPACK压缩则使用Huffman编码进行压缩。

因为请求的文件过大,超过一个TCP报文时,会被分成几个TCP报文进行传输,压缩能够有效的减少TCP传输的数目。

压缩规范格式为

key长度 + key + value长度 + value比如 Method:OPTION可以被翻译压缩为:

0206 6a6b 6f64 6a69在客户端请求想服务端请求过一个资源"A"后,而服务端"预先"知道,客户端很有可能也会需要另一个资源"B"。

那么服务端就会在客户端请求“B”之前,主动将资源“B”推送给客户端

## nginx 配置文件

location = /html/baidu/index.html { ## 表示在访问这个地址的时候

# 主动向客户端推送以下资源

http2_push /html/baidu/main.js?ver=1;

http2_push /html/baidu/main.css;

http2_push /html/baidu/image/0.png;

http2_push /html/baidu/image/1.png;

http2_push /html/baidu/image/2.png;

http2_push /html/baidu/image/3.png;

http2_push /html/baidu/image/4.png;

http2_push /html/baidu/image/5.png;

http2_push /html/baidu/image/6.png;

}根据上图的配置,客户端请求 /html/baidu/index.html 页面的时候,服务器不会马上返回页面的信息,而是首先将所配置资源以数据帧的形式,与客户端建立多条Stream。

这样可以有效减少资源所需的响应时间,而浏览器收到服务器的主动推送,就可以直接进行下载阶段。

“缓存推送”需要客户端显式地允许服务端提供该功能。即使允许了“主动推送”,客户端仍能够传送 "RST_STREAM" 帧来终止这种主动推送服务。

事实上呢,线上服务的静态资源都是托管于 CDN 的,想要享受 Server Push 的福利只能依赖于 CDN 服务商支持 Server Push 的功能。

frame,充分利用带宽http1.x 时代,强行将多个文件杂糅到成一个文件,分文件请求,使得文件缓存更有效命中。[2] 从Chrome源码看HTTP/2

[3] HTTP2 帧的分类

[5] http2.0优先级

[6] Node HTTP/2 Server Push 从了解到放弃

[7] Exploring Differences Between HTTP Preload vs HTTP/2 Push

使用直接赋值的方式,我们得到的效果一般就是浅拷贝,因为复制的只是对象和数组的引用地址。

let a = {key:123};

let b = a;

b; // {key:123}

a === b; // true💎 常用方法:array.slice(0) 和 array.concat()

只对数组进行了第一层的完全拷贝,第二层以及内部若存在对象或者数组,则也都只是复制了对象的引用。

💎 常用方法:Object.assign

Object.assign拷贝的是属性值,假如源对象对属性是一个指向对象的引用,也只会拷贝那个对象的引用值。

let a = {key:124,aa:{key2:456}};

let b = Object.assign({},a);

b; // {key:123,{key2:456}}

b === a; // false

b.aa = {key3:789};

a.aa; //{key3:789};实现的效果仍然是首层内容的完全拷贝,对于第二层及以后都是只复制引用地址。

只复制第一层的拷贝,适用于只有单层内容(数组或者对象)的拷贝,速度快,不需要迭代。

深拷贝是要对对象以及对象的所有子对象进行拷贝。

使用JSON.stringfy() + JSON.parse进行转换

JSON.parse转换为JSON对象,并且分配一个新的对象。JSON.parse()这个方法,只能够正确地处理 Number、String、Array等能够被json格式正确表达的数据结构。但是,undefined、function、Symbol 会在转换过程中被忽略。在项目中我们要深拷贝一个复杂对象,首选的肯定是lodash的cloneDeep

let obj = {a:1,b:'xxx'};

let copyObj = JSON.parse(JSON.stringify(obj));使用方法很简单,源码的解读网上也有很多,这里就不赘述了,总体来说离不开以下几个关键点

// 判断是否复杂对象

const isComplexObj = data => {

const type = typeof data

return data !== null && (type === 'object' || type === 'function')

}

// 准确判断每一种对象的类型

function getType(target) {

return Object.prototype.toString.call(target);

}

// 判断是否复杂类型,需要继续深入递归

const isIterative = data =>{

let typeString = Object.prototype.toString.call(data);

const iterateTypes = ['[object Array]', '[object Object]', '[object Map]', '[object Set]']

return iterateTypes.includes(typeString)

}

// 获取一个一个复杂类型的原始值

const initComplexObj = data => {

const creator = data.constructor

return new creator()

}

// 拷贝方法主函数

const deepCopy = function(target, currentMap = new WeakMap()) { // 使用WeakMap,使得currentMap与其内部属性是一个弱用关系,占用的内存不需要手动去释放

// 处理原始类型

if (!isComplexObj(target)) {

return target // 原始类型不做多余处理,直接进行返回

}

// 初始化复杂对象的初始值

const cloneTarget = initComplexObj()

// 检测当前复杂对象是否已经被拷贝过了

if (currentMap.get(target)) {

return currentMap.get(target)

}

// 使用WeakMap记录当前对象已经被处理了

currentMap.set(target, cloneTarget) ;

// 注意: 可遍历对象中,所有子元素的类型我们不清楚,所以要不断调用cloneDeep来确定,这里就触发了递归的点

if (isIterative(target)) {

// 复杂对象 - 可遍历对象 - Map的处理

if (getType(target) === '[object Map]') {

target.forEach((value, key) => {

cloneTarget.set(key, deepCopy(value, currentMap))

})

return cloneTarget

}

// 复杂对象 - 可遍历对象 - Set 的处理

if (getType(target) === '[object Set]') {

target.forEach(value => {

cloneTarget.add(deepCopy(value, currentMap))

})

return cloneTarget

}

// 复杂对象 - 可遍历对象 - 数组、JS对象 的处理

for (let attr in source) {

cloneTarget[attr] = deepCopy(target[attr], currentMap);

}

return cloneTarget;

}

else {

// 复杂对象 - 不可遍历对象

// Symbol 这个笔者认为是伪需求,拷贝出来的另一个Symbol又有何意义呢

// Date 自己查查api吧,不难但是常见

// RegExp 通过 source属性拿到正则的规则

/** function

* 重点是要通过 func.prototype 去判断出是否箭头函数

* 若是则使用 eval去生成即可

* 若不是则通过正则解析出函数参数,通过new Function重新构造

*/

// ....... 还有好多其他类型不多说了

return cloneTarget

}

}深度拷贝算法是浏览器内核,某些API需要进行深拷贝时候的内部处理方法,暂未直接对外开放,但我们可以借用这几个API来实现深拷贝。先看看MDN的描述👇传送门

The structured clone algorithm copies complex JavaScript objects. It is used internally to transfer data between Workers via postMessage(), storing objects with IndexedDB, or copying objects for other APIs. It clones by recursing through the input object while maintaining a map of previously visited references, to avoid infinitely traversing cycles.

// target = obj

const {port1, port2} = new MessageChannel();

port2.onmessage = ev => resolve(ev.data);

port1.postMessage(obj);// target = obj

history.replaceState(obj, document.title);

const copy = history.state;当然,这部分知识不建议在生产中使用,权当是拓展自己的视野。

[1] The structured clone algorithm

[2] JavaScript 深拷贝性能分析 - 掘金

[3] lodash源码浅析之如何实现深拷贝

[4] 如何写出一个惊艳面试官的深拷贝?

Javascript的事件环,主要就在理解宏任务和微任务这两种异步任务

| 任务类型 | 事件类型 | 优先级 |

|---|---|---|

| 宏任务 | setTimeOut 、 setInterval 、 setImmediate 、 I/O 、 各种callback、 UI渲染 、messageChannel等 |

主代码块 > setImmediate > postMessage > setTimeOut/setInterval |

| 微任务 | process.nextTick 、Promise 、MutationObserver 、async(实质上也是promise) |

process.nextTick > Promise > MutationOberser |

我们常常把EventLoop中分为 内存、执行栈、WebApi、异步回调队列(包括微任务队列和宏任务队列)

简单用代码表示一下过程

for (macroTask of macroTaskQueue) {

// 1. Handle current MACRO-TASK

handleMacroTask();

// 2. Handle all MICRO-TASK

for (microTask of microTaskQueue) {

handleMicroTask(microTask);

}

}1️⃣ Javascript内核加载代码到执行栈

2️⃣ 执行栈依次执行主线程的同步任务,过程中若遇调用了异步Api则会添加回调事件到回调队列中。且微任务事件添加到微任务队列中,宏任务事件添加到宏任务队列中去。直到当前执行栈中代码执行完毕。

3️⃣ 开始执行当前所有微任务队列中的微任务回调事件。 (:smirk:注意是所有哦,相当于清空队列)

4️⃣ 取出宏任务队列中的第一条(先进先出原则哦)宏任务,放到执行栈中执行。

5️⃣ 执行当前执行栈中的宏任务,若此过程总又再遇到微任务或者宏任务,继续把微任务和宏任务进行各自队伍的入队操作,然后本轮的宏任务执行完后,又把本轮产生的微任务一次性出队都执行了。

6️⃣ 以上操作往复循环...就是我们平时说的eventLoop了

综合一下....特点是

⭕️ 微任务队列操作,总是会一次性清空队列

⭕️ 宏任务队列每次只会取出一条任务到执行栈中执行

let promiseGlobal = new Promise(resolve=>{

console.log(1)

resolve('2')

})

console.log(3)

promiseGlobal.then(data=>{

console.log(data)

let setTimeoutInner = setTimeout(_=>{

console.log(4)

},1000)

let promiseInner =new Promise(resolve=>{

console.log(5)

resolve(6)

}).then(data=>{

console.log(data)

})

})

let setTimeoutGlobal = setTimeout(_=>{

console.log(7);

let promiseInGlobalTimeout = new Promise(resolve=>{

console.log(8);

resolve(9)

}).then(data=>{

console.log(data)

})

},1000) 建议不要直接拷贝到 控制台跑...大家先想想:smirk:

1 3 2 5 6 __ 等待一秒___ 7 8 9 4

let mc = new MessageChannel();

let p1 = mc.port1, p2 = mc.port2;

setTimeout(function(){

let pro2 = new Promise(resolve=>{

resolve()

})

pro2.then(data=>{

console.log('pro2');

})

},0)

console.log('first round');

p1.onmessage = function(data){

let pro3 = new Promise(resolve=>{

resolve()

})

pro3.then(data=>{

console.log('pro3');

})

console.log(data);

}

p2.postMessage("message form port2")

p2.postMessage("message form port2 second")

let pro1 = new Promise((solve)=>{

console.log('pro1 inner');

solve()

})

pro1.then(data=>{

console.log('pro then')

});setTimeout函数到时间了,为啥一直不去执行。A: setTimeOut的回调会被放到任务队列中,需要当前的执行栈执行完了,才会去执行执行任务队列中的内容。出现setTimeout回调不及时,说明在执行栈中出现了阻塞,或者说执行代码过多。

A:常见的vue.$nextTick会把事件直接插入到当前微任务队列的中

[1] 实现异步的Api

[2] vue 的nextTick

[3] vue 的DOM更新机制

CommonJS 引入的是模块值一个拷贝ES 6 module引入的是暴露对象的引用,本质上是暴露了一个指向对应内存空间的指针,模块内部值改变,外部引用值也会改变。在模块中 CommonJS的this指向当前模块

而ES 6 module中this指向的是undefined。

同时,ES 6模块中也不存在

arguments、require、module、exports、__filename、__dirname这些对象

执行阶段也有import()语句来对补充空缺CommonJS加载模块使用的require()是同步加载的。ES6 Module中的import()方法,返回的是一个Promise对象,属于异步加载。文件名以.mjs结尾的文件,代码中可以出现import 或者 export等ES 6模块代码,Nodejs引擎也会将其当做ES 6 Module进行处理。

文件名以.cjs结尾的文件,Node.js引擎会将采用CommonJS加载该模块。

若文件后缀仅仅为.js,则需要搭配package.json配置文件中的type字段来标志自身的模块编写规范。

{

"main": "./dist/index.js", // 后缀没有指明是 cjs 还是 mjs

"type": "module" // 标明是ES6 模块

}Node.js版本 v13.2之后直接支持了ES 6 Module,可以采用package.json中exports字段,对模块入口进行指定。{

"exports": {

"require": "./main.cjs", // CommonJS 入口

"default": "./main.js" // ES 6 入口

}

}其原理是exports字段为.路径声明了一个别名,这里的.也就是指模块入口。

{

"type": "module",

"main": "./dist/index.cjs", // 用于 CommonJS 识别

"exports": {

"require": "./index.cjs",

"default": "./index.mjs"

}

}ES6 module加载CommonJS不能够做到单一输出的加载,只能够整体进行加载,因为CommonJS的模块化是运行时加载的,而ES6 Module则是在编译时进行的加载。

// moduleA.cjs

module.exports = {

bar: 123,

foo: 456s

}

// app.mjs

import { bar } from "moduleA.cjs" // error笔者最近到和朋友的讨论中,聊到了关于 微信扫码相关的设计流程:

大家可以自己先想想这个过程,去京东的授权页下打开 DevTools 看看

已知微信扫码登录设计是遵循 OAuth 2.0 协议 进行设计的,我们可以先从去深入了解 OAuth 2.0 的内容。

授权服务器 使用重定向的方式下发 code 时,有可能出现不使用 https 的安全请求方式的情况App Secret 进行加密,称之为 statecode 时,会将 state 参数进行解密, 并且扔回给第三方应用App Secret 进行加密还原,与自身本地存储的作比较整个过程相当于利用 App Secret,在第三方应用的角度,对授权服务器身份进行了确认

与上述问题类似,授权服务器 同样不能够确认请求授权的身份是否为签约的第三方应用,直接下发 Access Token 则过于草率。

授权服务器 会进行一次性票据的下发APP Secret,对 App Ids 和 下发的 code 生成一个加密内容,发送给授权服务器App Id 找到 App Secret 对应的私钥,并尝试对内容进行解密,若成功则标明发起授权方是合法用户Access Token 到第三方应用提供的页面使用一次性票据 code, 而不是直接下发 Access Token,相当于 授权服务器 与 发起授权的第三方 进行了一次认证,确保申请 Access Token请求到的发起者是经过事先签约的,而不是拦截了请求的攻击者。

Access Token 的结构是以 JWT 的形式而存在的,则资源服务器可以快速验证 Access Token的有效性,而不用通过访问 授权服务器 确认结果。大量减少了授权服务器的访问压力。Resource Server 作为资源访问的认证Access Token 的过期时间比较短

资源服务器 进行即可Refresh Token 由 授权服务器 下发,由 授权服务器 进行验证Refesh Token 是拥有较长过期时间的,不需要被设置无效Access Token 过期时,客户端使用 Refresh Token 向 授权服务器 获取一个新的 Access Token在 OAuth 体系中表示 下发的 Access Token 对应可以访问的资源范围。系统设计中,划分的标准一般为某个权限组、策略组。

用户选择 微信扫码登录 后,显示二维码的页面,我们着重关注两部分

将参数进行解析,使用 Javscript 代码进行表示

const url = 'https://open.weixin.qq.com/connect/qrconnect'

const url_query = {

appid: 'wx827225356b689e24&state',

state: 'C14C6845B4FD3C50F786170C53578D23B3528AEF1154F8304F333200F287D7351AA05BAF998CAE44DF27D76C4995B8B0',

redirect_uri: 'https%3A%2F%2Fqq.jd.com%2Fnew%2Fwx%2Fcallback.action%3Fview%3Dnull%26uuid%3Dbba3111a8de7458c9ff6c152e3bb9ee1',

response_type: 'code',

scope: 'snsapi_login'

}appid 应用唯一标识redirect_uri 授权成功时重定向的URL,请使用 urlEncode 对链接进行处理response_type 表示当前的权限下发方式,固定为 codescope 应用授权作用域state 用于保持请求和回调的状态,授权请求后原样带回给第三方。可用于防止csrf攻击(跨站请求伪造攻击),建议第三方带上该参数,可设置为简单的随机数加session进行校验使用工具进行解码读取内容:

不难得出结论:

uuid用户扫码后,页面上二维码下方提示当前已进入了 等待确认 的状态。

但天知道用户啥时候才会进行 确认/取消 操作呢?好奇的我们打开浏览器的控制台

向服务器轮询当前扫码操作的结果。http 连接返回结果。[1] https://zhuanlan.zhihu.com/p/110127600

[2] https://zhuanlan.zhihu.com/p/22325152

[3] https://zhuanlan.zhihu.com/p/109101311

[4] Access Token & Refresh Token 详解以及使用原则

[5] OAuth2.0 详解 - Dreamgoing

<meta pre-fetch> 二级页面DNS预查询

js,css混淆压缩

使用gulp grunt 或者 webapck等前端工具将多个js文件合并在一起

图片使用雪碧图

CDN服务商可以再离用户最近的云服务器上,部署所需要的静态资源,然后发送给客户。

key-css在首页展示的时候,将首屏关键的css提取出来,并使用内嵌的形式加入页面,剩余部分使用外链的形式。

HTTP 2.0改为使用单一TCP链接,数据的传输改为使用流的形式,充分利用了带宽,减少了RTT的次数。也消除了浏览器对同一个域下资源的同时请求只能存在6~8个的限制。(当然我们也可以在服务端,将不同的资源放在不同的服务器中)

强缓存可以有效地减少RTT次数,而协商缓存也能够有效地减少网络传输的负载。

尽量减小数据包的大小

将页面的多个接口在接入层进行合并,减少网络请求的次数。

首屏数据直接结合DOM�后,直接输出字符串到客户端,而不需要使用异步去请求数据。

�因为浏览器的渲染规则,渲染页面需要CSS生成一个稳定的CSSOM,与DOM一起组成Render Tree。

而script的下载和执行都会阻塞UI的渲染,所以一般将script标签放到DOM结构末尾。

每一次我们使用选择器去获取DOM元素的时候,都需要经历一个查询的过程,时间不长,但是当批量操作出现的时候,�耗时就变得可观了。

let button = document.getElementByClassName('trigger-btn');

button.onclick = fucntion(){};

otherFun(button);

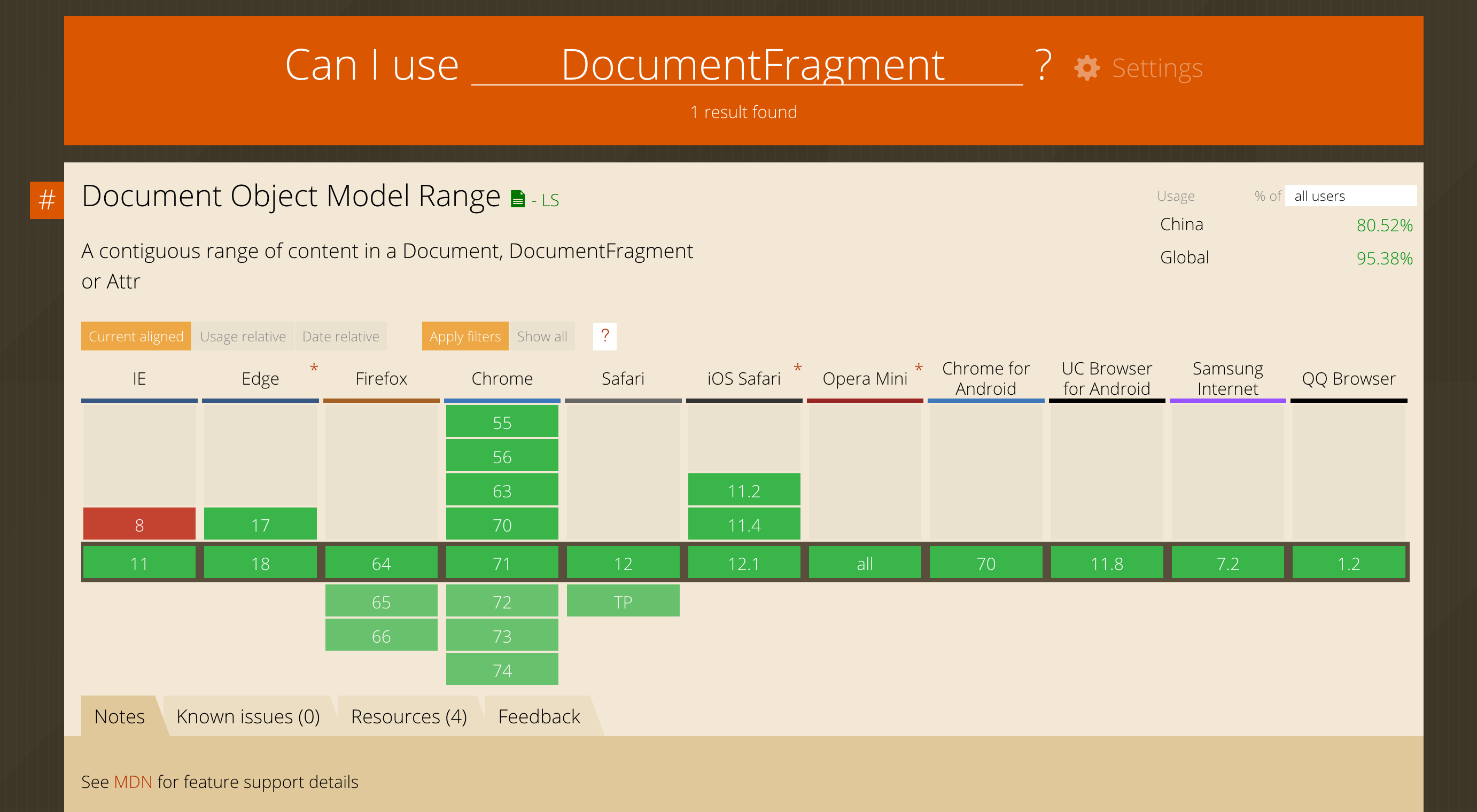

button.id = 'newId'; // 尽量复用前面的引用减少直接操作DOM的次数,也就是将DOM操作进行合并(使用DocumentFragment技术,mdn文档传送门👉

兼容性:IE系列基本不支持 Chrome>55 FF>64

原理就是这么个原理,但是经过大家的测试,貌似兼容性不太好,并且实验效果并没有提升多少效率,暂不推荐使用。

事件节流,频繁频繁的事件,一点要做节流处理,避免js的执行阻塞UI操作。

若后端使用的是node,我们还可以在加载较慢的主页面中,使用SSR直接在node拼装好前端也买�所需要的DOM和数据的结合体,直接交给浏览器渲染,而不用通过前端异步请求数据去渲染数据。�有效减少RTT次数。

VUE-SSR传送门👉

模块中有大量的图片加载时,大量图片同时挂在到节点上,浏览器UI渲染线程就会特别忙...抽不出空来执行其他UI渲染(页面假死),或者是其他Javascript�计算(内容延迟)。

使用图片的懒加载,有许多优秀的现成的工具,其原理是超出视窗(可以自定)范围的图片咱不挂在到DOM上,也就不会触发下载和渲染,等到用户滚动窗口,再根据视窗位置去挂载IMG标签,下载图片资源,渲染图片资源。

浏览器的渲染是单线程,Javascript的大量计算会阻塞UI渲染,使用新建web worker新开启一个进程来进行耗时的计算操作,可以大大减少对UI渲染的阻塞。

当页面�有大量DOM节点的时候,�大量使用范围选择器,会引起CSS选择器查询事件累计加长。

❤️ 性能优化需要数据作为支持,而前端的性能数据的收集,依赖于我们在项目中的埋点。

❤️ 建立数据分析平台,收集大量的监控数据,进行分析。

❤️ 根据分析结构优化代码,然后再继续监测。

[1] 页面优化与安全 - by 掘金

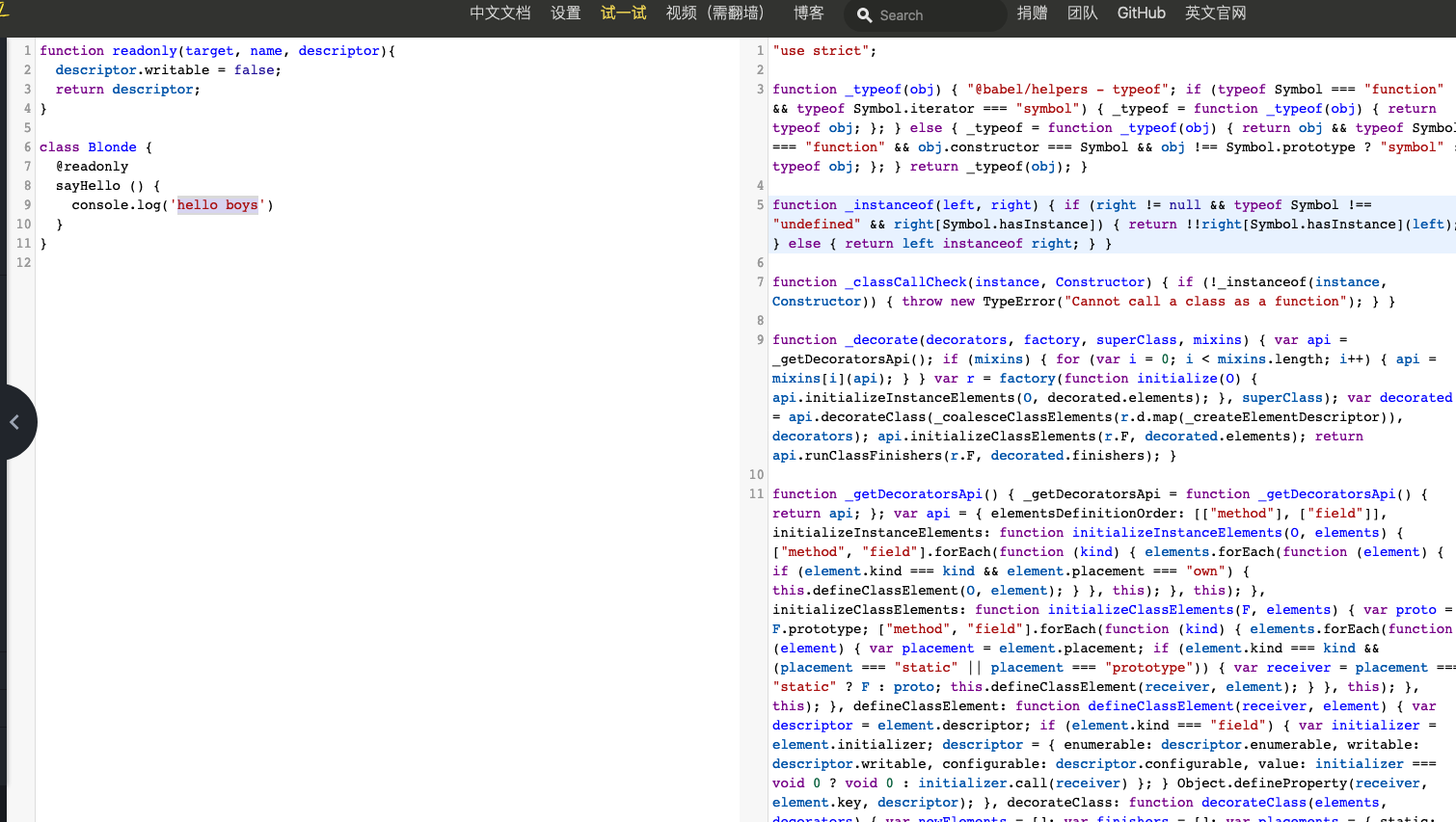

本文的主角是decorator,字面意思是装饰器。前端的同学大概都知道,它当前处于stage 2阶段(草案原文),可以用babel进行转码后进行使用。

使用过Angular 2或者Nest.js(或者Midway.js)的同学,一定对@Component、@Inject、@ViewChild和@get()、@post()、@provide()不陌生。

了解设计模式的同学,大概还记得修饰器模式这东西,也许至今也还分不太清楚它和代理模式的差别。

但这次,我们想要追本溯源,从AOP、IOC和descriptor这些东西说起,认识一下修饰器这个熟悉的陌生人。

在正文开始之前,我们先来一个需求,我们将陆续用不同阶段的思维去实现这个要求。

要求是:已知一个超过10几个人维护的代码,在不修改原函数的情况下,如何实现在每个函数执行后打印出指定内容的一行日志。

In computing, aspect-oriented programming (AOP) is a programming paradigm that aims to increase modularity by allowing the separation of cross-cutting concerns. It does so by adding additional behavior to existing code (an advice) without modifying the code itself, instead separately specifying which code is modified via a "pointcut" specification.

以上是维基百科对AOP的基本解释,主要着重于以下几点

横切关注点与中体业务的进一步分离。现有代码的基础上,通过在切入点增加通知的方式实现。与主体业务没有这么密切的代码对主题代码的入侵。了解过Javascript 高阶函数的同学,可能见到过以下方式对👆题目需求的实现。

// 注意在执行 after的时候,原函数也会被一并执行

Function.prototype.after = function(afterfn){

let _self =this;

return function(){

// 执行原方法

let result = _self.apply(this,arguments);

// 额外添加 after 函数的执行

afterfn.apply(this,arguments);

return result;

}

}实现过程本身不做过多解释,主要思维是将要添加的行为和目标函数(主函数)包装到了一起,实现了不对原函数(主函数)入侵的预期,但写法上仍不够优雅。

在《Spring实战》第四章中提到了

散布于应用中多处的功能(日志、安全、事务管理等)被称为横切关注点。

把横切关注点与业务逻辑分离是AOP要解决的问题。

在Spring中的AOP实现,给调用者的实际已经是经过加工的对象,开发者表面上调用的是Fun方法,但其实Spring为你做的是a + b + c --> Fun -->d + e + f 的调用过程。这里的abcdef都是函数动态的编入点,也就是定义中描述的pointcut。

我们称这种切入方式为运行时织入。

// 基本实现代码

try{

try{

//@Before

method.invoke(..);

}finally{

//@After

}

//@AfterReturning

} catch() {

//@AfterThrowing

}控制反转,是面向对象编程中的一种设计原则,可以用来减低计算机代码之间的耦合度。其中最常见的方式叫做依赖注入,还有一种方式叫“依赖查找”。通过控制反转,对象在被创建的时候,由一个调控系统内所有对象的外界实体,将其所依赖的对象的引用传递给它。

以上是来自于维基百科对”控制反转“的基本解释。那么,我们如何实现一个控制反转呢,需要了解以下几个关键步骤。

所谓IOC容器,它的作用是:在应用初始化的时候自动处理对类的依赖,并且将类进行实例化,在需要的时候,使用者可以随时从容器中去除实力进行使用,而不必关心所使用的的实例何时引入、何时被创建。

const container = new Container()有了容器,我们需要将”可能会被用到“的对象类,绑定到容器上去。

class Rabbit {}

class Wolf {}

class Tiger {}

// 绑定到容器上

container.bind('rabbit', Rabbit)

container.bind('wolf', Wolf)

container.bind('tiger', Tiger)const rabbit = container.get('rabbit')

const wolf = container.get('wolf')

// 对象的创建有可能是一个异步的过程,所以这里采用 getAsync 表示经过异步调用才能够完成的实例获取

const tigger = container.getAsync('tiger')在tc 39 - decorator原文中,笔者没有找到总结性的描述语句。这里分别引用Python和TS中对decorator这一特性的描述。

A Python decorator is a function that takes another function, extending the behavior of the latter function without explicitly modifying it.

Python装饰器是一种 能拓展另一个函数行为而不明确地修改原函数 的函数。

Decorators provide a way to add both annotations and a meta-programming syntax for class declarations and members.

装饰器(Decorator)是一种与类(class)相关的语法,用来注释或修改类和类方法。

Python - decorator中可以看出,其着重在extending与without explicitly modifying it上,基本上沿用了AOP的设计**。

类的装饰 、 类方法的装饰。从内向外执行function longHair(target) {

target.isLongHair = true;

}

// 金发女郎,一般都是长头发

@longHair

class Blonde {

// ...

}

Blonde.isLongHair // true// 修改 descriptor.writable 使得对象不可被修改

function readonly(target, name, descriptor){

descriptor.writable = false;

return descriptor;

}

class Blonde {

@readonly

name() { return `${this.first} ${this.last}` }

}我们把上面这一堆东西扔到babel中试了一下,得到以下内容。

最后最显眼的地方出现了 Class 的 babel 实现,有兴趣的同学可以看这里的全部源码

// 对类本身的修饰

var Blonde = _decorate([longHair], function (_initialize) {

var Blonde = function Blonde () {

_classCallCheck(this, Blonde)

_initialize(this)

}

return {

F: Blonde,

d: [{

kind: 'field',

decorators: [readonly], // 对类方法的修饰

key: 'abc',

value: function value () {

return 12

}

}]

}

})

// 经过多次调用后......

for (var i = decorators.length - 1; i >= 0; i--) {

// 函数本身

var obj = this.fromClassDescriptor(elements)

// decorators 逐个被执行,传入的参数是一个类的模拟对象 { kind: 'class', elements: elements.map(this.fromElementDescriptor, this) }

var elementsAndFinisher = this.toClassDescriptor((0, decorators[i])(obj) || obj)

}从前面的转码实验看出 ,Decorator语法转为ES 5后,其实就是使用Object.defineProperty(target, name, description)进行的。

针对前面的例子,其实就是执行了。

let descriptor = {

value: function(){console.log('hello boys~')},

enumerable: false,

configurable: true,

writeable: true

};

// 此处也对应上述 babel 转码后展示的最后一行代码

descriptor = readonly(Blonde.prototype,'sayHello',descriptor)||descriptor;

Object.defineProperty(Blonde.prototype,'sayHello',descriptor);细心的你已经发现,decorator方法的参数 与 Object.defineProperty一模一样。这是因为Javascript中的decorator的设定就是后者的拦截器。

首先获取到原对象上的descriptor对象属性(非额外添加的那些),然后再执行修饰器自身,实现对原descriptor添加属性。类似于这样

function readonly () {

let descriptor = Object.getOwnPropertyDescriptor(constructor.prototype, 'sayHello')

Object.defineProperty(constructor.prototype, 'sayHello', {

...descriptor, // 保留原来的对象

writable: false, // 进行新的修改

})

}针对一开始的问题,我们也写一个Javascript版本的解决方案吧

const logger = type => {

return (target, name, description) => {

const originFun = description.value; // 取出原方法

description.value = (...args) => {

console.info('ready')

let ret

try {

ret = originFun.apply(target, args) // 执行方法,并将this指向原函数

console.log('excuted success')

} catch (err) {

console.log('excuted error')

}

return ret

}

}

}看完了上面的内容,我们只要简单地回想一下代理模式的定义,就能轻松梳理出二者的异同点。

代理模式: 为其它对象提供一种代理以控制对这个对象的访问。

实际应用: 图片代理下载、缓存计算等

装饰模式:动态地给一个对象添加一些额外的职责。

实际应用:日志模块、模块鉴权等

区别有以下几点:

更详细的例子,推荐参考这篇文章

我们日常开发中,还会有一些功能用Decorator能够优美的实现,比如类型检查、单位转换、字段映射、方法鉴权、代替部分注释`等。

midway.js 封装了许多装饰器,部分是用于实现IOC,如 @provide与@inject

import { provide, inject } from 'midway' // 这里 midway 也是转发了

@provide()

export class FlowerService {

@inject()

flowerMobel;

async getFlowerInfo () {

return this.flowerModel.findByIds([12,28,31])

}

}

// 封装了和 koa-router 所支持的多种请求方法相对应的修饰器

@get、@post、@del、@put、@patch、@options、@head、@all依赖注入只是IOC思维实现的一种表现,而装饰器只是依赖注入的一种实现手段。[1] �我们来聊聊装饰器 -by 讶羽

[2] JS 装饰器实战 -by 芋头

[3] ES6 教程 -by 阮一峰

[4] ES7 Decorator 装饰器 | 淘宝前端团队

[5] 什么是面向切面编程AOP? - 柳树的回答 - 知乎

执行环境 ➡️ 作用域链 ➡️ 变量对象

每个执行环境都有一个[ [scope] ]变量,指向对象的的作用域链,作用域链上的每个栏位都存放着对应的函数空间的变量对象。

函数在创建的时候,会创建一个执行环境(excution context)对内部对象,他定义了一个函数执行时的环境

函数每次执行时,执行环境都是独一无二的,多次调用就有多个执行环境。每个人执行环境都有自己的作用域链,用于解析标志符

每个执行环境都有一个与之关联的变量对象(variable object),环境中定义的所有变量和函数都保存在这个对象中

全局环境是最外围的一个执行环境,随着ECMAScript的真实环境变化而变化,常见的是global和window

某个执行中的代码执行完毕,该环境被销毁,保存在其中的所有变量和函数定义也随之销毁。

[ [scope] ]和执行期上下文虽然保存的都是作用域链,但是不相同。[ [scope] ]属性在函数创建的时候产生,会一直存在每个函数都有自己的执行环境,每当执行流进入一个函数时,当前函数的环境就会被推入一个环境栈中。当函数执行完后,栈将其环境弹出,把控制权返回给外层执行环境。

[[SCOPE]]上。[[scope]],并把当前函数的活动对象,追加到取出的全局对象中,形成新的作用域链,再次存入[[SCOPE]]。在ES6的let之前,javascript是没有块级作用域的

if(false){

var abc = 123;

}

console.log(abc)使用var的abc声明提升到了作用域顶端,这里的所谓if作用域是不存在的,其实就是�外层的顶级作用域。

var name = "Andy";

function changeGlobalName(){

let innerName = "innerName"

name = "Jacky"

function changeInnerName(){

let tempName = "innerInnerName";

innerName = "changeByInnerInner"

}

changeInnerName()

}

changeGlobalName()执行环境 与 作用域链window (name changeGloalName)

:arrow_up: :arrow_up:

changeGlobalName (arguments inner changeInnerName)

:arrow_up: :arrow_up:

changeInnerName (arguments tempName)

⬆️

Javascript的作用域只有:全局作用域和函数作用域。with 和 catch 语句。在严格模式下,with是被禁止使用的。全局环境只能够访问全局环境中定义的 变量 和 函数,而不能直接访问局部环境中的任何数据;一个客户端webview中加载的h5应用与Native通信工具,持续完善中....传送门 👉👉

[1] window.postMessage - MDN

[2] logger-level - github

[3] webpack - ts-loader

[4] JavaScript WebView and iOS

[5] JSON-RPC 2.0

最近在做一个行情模块,后端同学建议直接上websocket练练手,也符合业界基操。这里就记录一些开发中遇到了一些问题,聊一聊解决方案。这里不再去一点点陈列websocket的知识点,主要会围绕项目的痛点来说。

ps: 食用本文时,建议出发点需要向下沉,从传输层开始思考,做类似http(应用层)需要完成的事。

| 端 | 语言 | 框架(lib) | 环境 |

|---|---|---|---|

| 后端 | Go | gin | CentOS |

| 前端 | TS | axios | 浏览器 |

项目当前的前后端选型如上表,因为websocket是一个基于tcp的应用层协议,就像http客户端服务器约定的请求头、响应头、cookie等约定,和一发一收交互形式,websocket在使用的时候相当于将这部分约定的权利,重新交给了我们开发者。

那么如果考虑使用websockt的lib进行项目构建时,则需要考察该方案在两端是否都有实现的方案,

| 框架(lib) | 服务端支持(Go) | 浏览器支持 | 周下载量 | 包大小 | 其他 |

|---|---|---|---|---|---|

| socket.io | ✅ go-socket.io | ✅ | 3,309,990 | 55.9 kB | 支持策略退化到Polling |

| ws | ✅ | ❌ | 25,770,149 | 110 kB |

因为这次的模块是websocket尝鲜,所以没有考虑太多,最后决定前端这边使用浏览器原生支持Websocket对象,根据这次的要求进行简答的封装,先趟趟坑,正式上线后再慢慢考察框架。

开工前,几个前端小伙伴做到了一起,提出了自己对这个SDK的期望。

websocket还是http,请自己在接口层封装好。lib,req和res的interceptor还是要有的吧。axios都习惯了,接口返回的是一个请求的Promise,这次也最后保持一致吧办公室不大,后端的同学也听到了讨论,附和到:

信道复用实现无刷新请求。可别忘啦,后期我们还是要做服务端消息推送的。deadline了...嘚嘞,上马开工...

项目当前的鉴权是依赖用户登录后,服务端下发用户token到cookie中,搭配header中的某个字段进行使用。

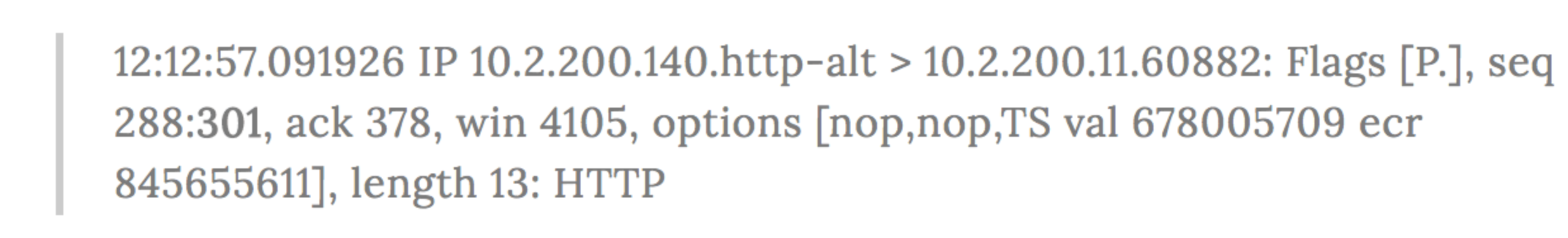

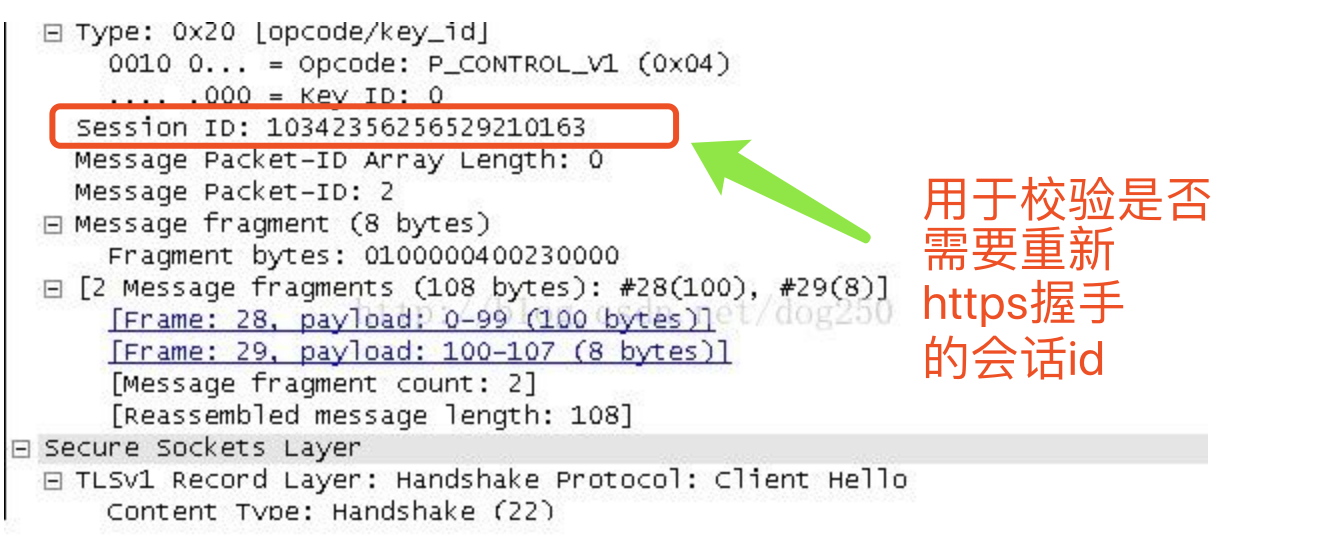

由于websocket在传输数据的时候,并不存在和http协议一样的cookie、request header机制。但信道建所用的请求,仍是http请求,你也一定见过这个请求的报文。

const crypto = require('crypto');

// 生成 websocket AcceptKey