blog's People

blog's Issues

【Spark学习笔记】Hadoop&Spark基本操作与第一次运行

一、HDFS 上传文件

HDFS可以看作一个文件管理系统,和普通PC的本地文件系统很相似。还有图形化的网页界面可供查看。HDFS的原理还需要学习。

以下命令需要在Hadoop开启之后才能使用。

- 创建目录命令

HDFS有一个默认的工作目录/user/$USER,其中$USER是用户的登录用户名。不过目录不会自动建立,需要mkdir建立它

命令格式:hadoop dfs -mkdir

如在home目录下创建pc目录:

hadoop dfs -mkdir /home/pc

注意:Hadoop的mkdir命令会自动创建父目录,类似于带-p的UNIX命令

2. 上传文件命令

put命令从本地文件系统中复制单个或多个源路径到目标文件系统,也支持从标准输入设备中读取输入并写入目标文件系统。分为本地上传和上传到HDFS中。

命令格式:hadoop fs -put filename

如放本地文件系统的一个文件进去

hadoop fs -put example.txt

最后一个参数是句点,相当于放入了默认的工作目录,等价于hadoop fs -put example.txt /home/pc。

- 上传文件到HDFS

上传文件时,文件首先复制到DataNode上,只有所有的DataNode都成功接收完数据,文件上传才是成功的。

命令格式:hadoop dfs put filename newfilename

如:

通过“-put 文件1 文件2 ”命令将Hadoop目录下的test1文件上传到HDFS上并重命名为test2

hadoop dfs -put test1 test2

- 列出HDFS目录下某个文档的文件

通过“-ls 文件夹名” 命令浏览HDFS下文件夹中的文件

命令格式:hadoop dfs -ls 文件夹名

如:

浏览HDFS中in文件夹中的文件

hadoop dfs -ls in

通过该命令可以查看in文件夹中的所有文档文件

查看HDFS下某个文件的内容

通过“-cat 文件名”命令查看HDFS下文件夹中某个文件的内容

命令格式:hadoop$ bin/hadoop dfs -cat 文件名

如:

查看HDFS下in 目录中的内容

hadoop$ bin/hadoop dfs -cat in/*

通过这个命令可以查看in文件夹中所有文件的内容将HDFS中的文件复制到本地系统中

通过“-get 文件按1 文件2”命令将HDFS中某目录下的文件复制到本地系统的某文件中,并对该文件重新命名。

命令格式:hadoop dfs -get 文件名 新文件名

如:

将HDFS中的in文件复制到本地系统并重命名为IN1

hadoop dfs -get in IN1

-get 命令与-put命令一样,既可以操作目录,也可以操作文件删除HDFS下的文档

通过“-rmr 文件”命令删除HDFS下的文件

命令格式:hadoop$ bin/hadoop dfs -rmr 文件

如:

删除HDFS下的out文档

hadoop dfs -rmr out

-rmr 删除文档命令相当于delete的递归版本。格式化HDFS

通过-format命令实现HDFS格式化

命令格式:user@NameNode:hadoop$ bin/hadoop NameNode -format

进入http://localhost:50070/后可以看到:

二、集群运行自带GraphX程序

这里直接使用已经打包在spark/example/jars/目录下的spark-example的jar包。

在命令行下使用

spark-submit --class org.apache.spark.examples.graphx.ComprehensiveExample /usr/local/spark/examples/jars/spark-examples_2.11-2.2.0.jar

运行结果

【待解决】

但是有个问题,在spark Web UI 没有任务显示出来:

三、我的第一个程序

【Scala学习笔记 · 一】基础、控制结构和函数、数组操作

第一章 基础

1、声明值和变量

声明变量:

scala> val a = 8*8

a: Int = 64

scala> var hhh = "hello world"

hhh: String = hello world以val定义的值实际上是一个常量——你无法改变它的内容。而var就可以改变。在scala中,鼓励使用val。

在scala中,变量或函数的类型总卸载变量或函数的后面。

var a,b:String = "as"这是将两个值放在一起声明。

跟java不同,scala的类型(int,char等)都是类,也就是说,可以对数字执行方法。

scala> 666.toString

res1: String = 666更有意思的是:

scala> 2.to(10)

res4: scala.collection.immutable.Range.Inclusive = Range 2 to 10在这里,Int值首先被转换为RichInt(具有int所不具备的便捷方法),再应用to方法。

2、算术和操作符重载

scala> val a = 1+2*3/6-1

a: Int = 1算术符号用法其实与其他语言相同,但需要注意的是这些操作符其实是方法,例如:

a + b是如下方法的简写:

a.+(b)也就是说,这里的+是一个方法名。

和java或C++相比,scala有个显著的不同:没有++和--操作符,需要使用+=1或-=1。

ans+=1还有大数对象:

scala> val x:BigInt = 99999999

x: BigInt = 99999999

scala> x*x*x

res6: scala.math.BigInt = 999999970000000299999999可见操作起来比java方便

3、调用函数和方法

scala> import scala.math._

import scala.math._

scala> sqrt(2)

res8: Double = 1.4142135623730951调用一些函数时,需要引入特定包。

而不带参数的scala方法通常不使用圆括号。例如以下distinct方法,是获取字符串中不重复的字符:

scala> "ddddhello".distinct

res9: String = dhelo如果s是一个字符串,那么在C++中,会写s[i]来获取第i个字符,在Java中是s.charAt(i),而scala是这样:

scala> var s = "hello"

s: String = hello

scala> s(4)

res10: Char = o

scala> "hello"(4)

res11: Char = o可以把这种用法当作是()操作符的重载形式,他的背后是一个apply方法:

def apply(n: Int): Char也就是说,“hello”(4)是如下语句的简写:

"hello".apply(4)练习

- scala允许用数字去乘字符串:

scala> "crazy"*3

res15: String = crazycrazycrazy- res变量是val还是var?

scala> res15+"asd"

res17: String = crazycrazycrazyasd

scala> res17 = "asdasdasdas"

<console>:15: error: reassignment to val

res17 = "asdasdasdas"答:res变量是val,一个不可改变的常量。

- 用BigInt计算2的1024次方。

scala> val x:BigInt = 2

x: scala.math.BigInt = 2

scala> x.pow(1024)

res22: scala.math.BigInt = 179769313486231590772930519078902473361797697894230657273430081157732675805500963132708477322407536021120113879871393357658789768814416622492847430639474124377767893424865485276302219601246094119453082952085005768838150682342462881473913110540827237163350510684586298239947245938479716304835356329624224137216- 在Scala中如何获取字符串的首字符和尾字符?

scala> val a="123456789"

a: String = 123456789

scala> a.head

res24: Char = 1

scala> a.last

res25: Char = 9- take, drop, takeRight, dropRight这些字符串函数是做什么用的?和substring相比,它们的优点和缺点都有哪些?

scala> val a="123456789"

a: String = 123456789

scala> a.take(2)

res26: String = 12

scala> a.drop(2)

res27: String = 3456789

scala> a.takeRight(2)

res28: String = 89

scala> a.dropRight(2)

res29: String = 1234567【Linux】从Linux文件系统看文件读写过程

从Linux文件系统看文件读写过程

提问: 在一个 txt 文件中,修改其中一个字,然后保存,这期间计算机内部到底发生了什么?

1. 答案:文件读写基本流程

1.1 读文件

-

进程调用库函数向内核发起读文件请求;

-

内核通过检查进程的文件描述符定位到虚拟文件系统的已打开文件列表表项;

-

调用该文件可用的系统调用函数read()

-

read()函数通过文件表项链接到目录项模块,根据传入的文件路径,在目录项模块中检索,找到该文件的inode;

-

在inode中,通过文件内容偏移量计算出要读取的页;

-

通过inode找到文件对应的address_space;

-

在address_space中访问该文件的页缓存树,查找对应的页缓存结点:

- 如果页缓存命中,那么直接返回文件内容;

- 如果页缓存缺失,那么产生一个页缺失异常,创建一个页缓存页,同时通过inode找到文件该页的磁盘地址,读取相应的页填充该缓存页;重新进行第6步查找页缓存;

-

文件内容读取成功。

1.2 写文件

前6步和读文件一致,在address_space中查询对应页的页缓存是否存在:

-

如果页缓存命中,直接把文件内容修改更新在页缓存的页中。写文件就结束了。这时候文件修改位于页缓存,并没有写回到磁盘文件中去。

-

如果页缓存缺失,那么产生一个页缺失异常,创建一个页缓存页,同时通过inode找到文件该页的磁盘地址,读取相应的页填充该缓存页。此时缓存页命中,进行第6步。

-

一个页缓存中的页如果被修改,那么会被标记成脏页。脏页需要写回到磁盘中的文件块。有两种方式可以把脏页写回磁盘:

- 手动调用sync()或者fsync()系统调用把脏页写回

- pdflush进程会定时把脏页写回到磁盘

同时注意,脏页不能被置换出内存,如果脏页正在被写回,那么会被设置写回标记,这时候该页就被上锁,其他写请求被阻塞直到锁释放。

这里出现了几个概念:系统调用、虚拟文件系统中的innode、页缓冲Page Cache和Address Space

2.1 系统调用

操作系统的主要功能是为管理硬件资源和为应用程序开发人员提供良好的环境,但是计算机系统的各种硬件资源是有限的,因此为了保证每一个进程都能安全的执行。处理器设有两种模式:“用户模式”与“内核模式”。一些容易发生安全问题的操作都被限制在只有内核模式下才可以执行,例如I/O操作,修改基址寄存器内容等。而连接用户模式和内核模式的接口称之为系统调用。

应用程序代码运行在用户模式下,当应用程序需要实现内核模式下的指令时,先向操作系统发送调用请求。操作系统收到请求后,执行系统调用接口,使处理器进入内核模式。当处理器处理完系统调用操作后,操作系统会让处理器返回用户模式,继续执行用户代码。

进程的虚拟地址空间可分为两部分,内核空间和用户空间。内核空间中存放的是内核代码和数据,而进程的用户空间中存放的是用户程序的代码和数据。不管是内核空间还是用户空间,它们都处于虚拟空间中,都是对物理地址的映射。

应用程序中实现对文件的操作过程就是典型的系统调用过程。

附:linux的用户模式和内核模式

在Linux机器上,CPU要么处于受信任的内核模式,要么处于受限制的用户模式。除了内核本身处于内核模式以外,所有的用户进程都运行在用户模式之中。

处理器总处于以下状态中的一种:

1、内核态,运行于进程上下文,内核代表进程运行于内核空间;

2、内核态,运行于中断上下文,内核代表硬件运行于内核空间;

3、用户态,运行于用户空间。

用户空间的应用程序,通过系统调用,进入内核空间。这个时候用户空间的进程要传递很多变量、参数的值给内核,内核态运行的时候也要保存用户进程的一些寄存器值、变量等。所谓的“进程上下文”,可以看作是用户进程传递给内核的这些参数以及内核要保存的那一整套的变量和寄存器值和当时的环境等。

硬件通过触发信号,导致内核调用中断处理程序,进入内核空间。这个过程中,硬件的一些变量和参数也要传递给内核,内核通过这些参数进行中断处理。所谓的“中断上下文”,其实也可以看作就是硬件传递过来的这些参数和内核需要保存的一些其他环境(主要是当前被打断执行的进程环境)。

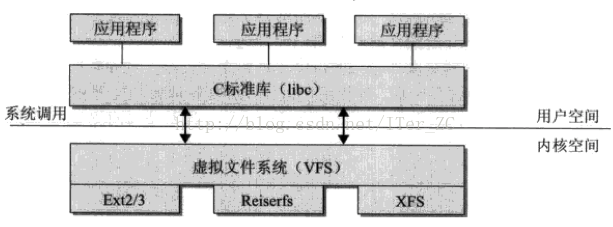

2.2 虚拟文件系统

一个操作系统可以支持多种底层不同的文件系统(比如NTFS, FAT, ext3, ext4),为了给内核和用户进程提供统一的文件系统视图,Linux在用户进程和底层文件系统之间加入了一个抽象层,即虚拟文件系统(Virtual File System, VFS),进程所有的文件操作都通过VFS,由VFS来适配各种底层不同的文件系统,完成实际的文件操作。

通俗的说,VFS就是定义了一个通用文件系统的接口层和适配层,一方面为用户进程提供了一组统一的访问文件,目录和其他对象的统一方法,另一方面又要和不同的底层文件系统进行适配。如图所示:

Linux的EXT2文件系统

对于一个磁盘分区来说,在被指定为相应的文件系统后,整个分区被分为 1024,2048 和 4096 字节大小的块。根据块使用的不同,可分为:

-

超级块(Superblock): 这是整个文件系统的第一块空间。包括整个文件系统的基本信息,如块大小,inode/block的总量、使用量、剩余量,指向空间 inode 和数据块的指针等相关信息。

-

inode块(文件索引节点) : 文件系统索引,记录文件的属性。它是文件系统的最基本单元,是文件系统连接任何子目录、任何文件的桥梁。每个子目录和文件只有唯一的一个 inode 块。它包含了文件系统中文件的基本属性(文件的长度、创建及修改时间、权限、所属关系)、存放数据的位置等相关信息. 在 Linux 下可以通过 "ls -li" 命令查看文件的 inode 信息。硬连接和源文件具有相同的 inode 。

-

数据块(Block) :实际记录文件的内容,若文件太大时,会占用多个 block。为了提高目录访问效率,Linux 还提供了表达路径与 inode 对应关系的 dentry 结构。它描述了路径信息并连接到节点 inode,它包括各种目录信息,还指向了 inode 和超级块。

就像一本书有封面、目录和正文一样。在文件系统中,超级块就相当于封面,从封面可以得知这本书的基本信息; inode 块相当于目录,从目录可以得知各章节内容的位置;而数据块则相当于书的正文,记录着具体内容。

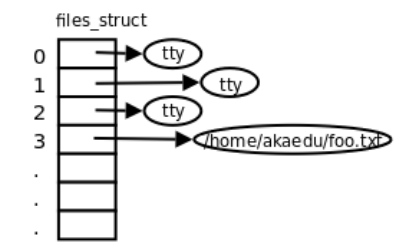

进程和虚拟文件系统交互

-

内核使用task_struct来表示单个进程的描述符,其中包含维护一个进程的所有信息。task_struct结构体中维护了一个 files的指针(和“已打开文件列表”上的表项是不同的指针)来指向结构体files_struct,files_struct中包含文件描述符表和打开的文件对象信息。

-

file_struct中的文件描述符表实际是一个file类型的指针列表(和“已打开文件列表”上的表项是相同的指针),可以支持动态扩展,每一个指针指向虚拟文件系统中文件列表模块的某一个已打开的文件。

-

file结构一方面可从f_dentry链接到目录项模块以及inode模块,获取所有和文件相关的信息,另一方面链接file_operations子模块,其中包含所有可以使用的系统调用函数,从而最终完成对文件的操作。这样,从进程到进程的文件描述符表,再关联到已打开文件列表上对应的文件结构,从而调用其可执行的系统调用函数,实现对文件的各种操作。

进程、文件列表与Inode

-

多个进程可以同时指向一个打开文件对象(文件列表表项),例如父进程和子进程间共享文件对象;

-

一个进程可以多次打开一个文件,生成不同的文件描述符,每个文件描述符指向不同的文件列表表项。但是由于是同一个文件,inode唯一,所以这些文件列表表项都指向同一个inode。通过这样的方法实现文件共享(共享同一个磁盘文件);

2.3 I/O 缓冲区

概念

如高速缓存(cache)产生的原理类似,在I/O过程中,读取磁盘的速度相对内存读取速度要慢的多。因此为了能够加快处理数据的速度,需要将读取过的数据缓存在内存里。而这些缓存在内存里的数据就是高速缓冲区(buffer cache),下面简称为“buffer”。

具体来说,buffer(缓冲区)是一个用于存储速度不同步的设备或优先级不同的设备之间传输数据的区域。一方面,通过缓冲区,可以使进程之间的相互等待变少,从而使从速度慢的设备读入数据时,速度快的设备的操作进程不发生间断。另一方面,可以保护硬盘或减少网络传输的次数。

Buffer和Cache

buffer和cache是两个不同的概念:cache是高速缓存,用于CPU和内存之间的缓冲;buffer是I/O缓存,用于内存和硬盘的缓冲;简单的说,cache是加速“读”,而buffer是缓冲“写”,前者解决读的问题,保存从磁盘上读出的数据,后者是解决写的问题,保存即将要写入到磁盘上的数据。

Buffer Cache和 Page Cache

buffer cache和page cache都是为了处理设备和内存交互时高速访问的问题。buffer cache可称为块缓冲器,page cache可称为页缓冲器。在linux不支持虚拟内存机制之前,还没有页的概念,因此缓冲区以块为单位对设备进行。在linux采用虚拟内存的机制来管理内存后,页是虚拟内存管理的最小单位,开始采用页缓冲的机制来缓冲内存。Linux2.6之后内核将这两个缓存整合,页和块可以相互映射,同时,页缓存page cache面向的是虚拟内存,块I/O缓存Buffer cache是面向块设备。需要强调的是,页缓存和块缓存对进程来说就是一个存储系统,进程不需要关注底层的设备的读写。

buffer cache和page cache两者最大的区别是缓存的粒度。buffer cache面向的是文件系统的块。而内核的内存管理组件采用了比文件系统的块更高级别的抽象:页page,其处理的性能更高。因此和内存管理交互的缓存组件,都使用页缓存。

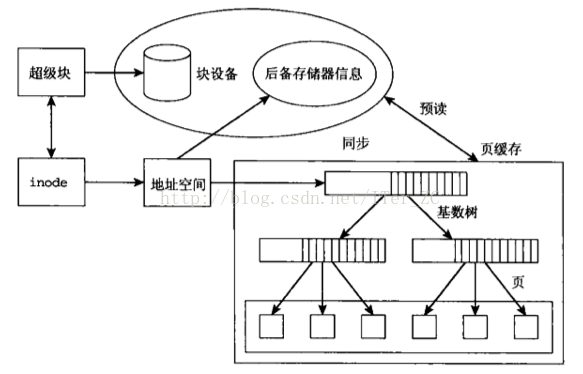

2.4 页缓存Page Cache

页缓存是面向文件,面向内存的。通俗来说,它位于内存和文件之间缓冲区,文件IO操作实际上只和page cache交互,不直接和内存交互。page cache可以用在所有以文件为单元的场景下,比如网络文件系统等等。page cache通过一系列的数据结构,比如inode, address_space, struct page,实现将一个文件映射到页的级别:

-

struct page结构标志一个物理内存页,通过page + offset就可以将此页帧定位到一个文件中的具体位置。同时struct page还有以下重要参数:

- 标志位flags来记录该页是否是脏页,是否正在被写回等等;

- mapping指向了地址空间address_space,表示这个页是一个页缓存中页,和一个文件的地址空间对应;

- index记录这个页在文件中的页偏移量;

-

文件系统的inode实际维护了这个文件所有的块block的块号,通过对文件偏移量offset取模可以很快定位到这个偏移量所在的文件系统的块号,磁盘的扇区号。同样,通过对文件偏移量offset进行取模可以计算出偏移量所在的页的偏移量。

-

page cache缓存组件抽象了地址空间address_space这个概念来作为文件系统和页缓存的中间桥梁。地址空间address_space通过指针可以方便的获取文件inode和struct page的信息,所以可以很方便地定位到一个文件的offset在各个组件中的位置,即通过:文件字节偏移量 --> 页偏移量 --> 文件系统块号 block --> 磁盘扇区号

-

页缓存实际上就是采用了一个基数树结构将一个文件的内容组织起来存放在物理内存struct page中。一个文件inode对应一个地址空间address_space。而一个address_space对应一个页缓存基数树。

2.5 Address Space

下面我们总结已经讨论过的address_space所有功能。address_space是Linux内核中的一个关键抽象,它被作为文件系统和页缓存的中间适配器,用来指示一个文件在页缓存中已经缓存了的物理页。因此,它是页缓存和外部设备中文件系统的桥梁。如果将文件系统可以理解成数据源,那么address_space可以说关联了内存系统和文件系统。

由图中可以看到,地址空间address_space链接到页缓存基数树和inode,因此address_space通过指针可以方便的获取文件inode和page的信息。那么页缓存是如何通过address_space实现缓冲区功能的?我们再来看完整的文件读写流程。

3 回顾

应用程序需要修改文件A中的部分字段,首先应用程序将待写数据存放在其user buffer结构中,user buffer 通过MMU 映射,数据实际存放在物理内存中。现在应用程序需要将待写数据写入硬盘。

-

程序进程调用内核函数write(),将待写文件标识(句柄)、待写数据相对文件首部的字节偏移量(offset xx)、待写数据长度(2KB)和待写数据的位置一并传给内核 ;

注:在程序打开文件时,内核在PageCache中创建一个虚拟的文件 A’,这个文件A’从文件系统inode结构(下文讲)中映射出来,由若干个page组成,初始情况下文件A’存在与逻辑地址空间内,不占用物理内存。文件A’的逻辑长度参考文件实际长度占用page的整数倍,这里假设page 大小为4KB。

-

内核根据文件字节偏移量和上文提到的虚拟文件A’计算出待写数据占用的page1;(这里面待写数据只有2KB,小于page大小,因此待写数据落入page1中)

-

计算出page号后,内核尝试找到page1对应的物理地址,以进行下一步操作。此时发现page1对应的数据并没有调入内存中,产生缺页,此时需要内核将page1对应的数据完整的从磁盘调入内存;(注意:此处和内存换页没有关系,这里可以看到使用操作系统Pagecache的写IO可能会产生IO读惩罚)

注:文件系统的主要功能就是组织文件在磁盘上的分布,文件是连续的结构,但其在磁盘上却是离散分布的。文件系统将磁盘格式化成若干个块,每个块由若干个连续物理扇区组成,这个真实存在的块叫做物理块。为了提高利用率,同一个文件映射出的物理块可能在磁盘的任何位置,不一定是连续的。因此文件系统需要一个链表来记录文件对应的物理块位置,这个结构在linux中就是inode

-

文件系统将page号映射到对应的块,然后根据inode可查到文件块对应的真实物理地址LBA,内核将请求封装后转给设备驱动层(此步内核需要将Page所包含的所有字节都调入内存——”Page对齐“)。

-

设备驱动将请求翻译成若干各个SCSI指令,驱动SAS控制器通过SAS总线向磁盘发送指令:

SCSI Read() LBA0x****** Len=N N=读取字节大小/扇区大小注:上述过程主要发生在CPU与内存之间,CPU从内存中读出指令并执行,最后CPU将指令通过PCIe总线发送给了SAS控制器,SAS控制器将指令发送到SAS总线上

-

磁盘收到SCSI指令后,找到LBA对应的实际盘面和柱面,读出对应的扇区,发回SAS控制器;

-

从磁盘读出的数据(这里是4KB大小)从原路返回,最后写入到page1对应的物理内存中;

-

内核用代写2KB数据替换掉Page1对应的2KB待替换数据;

-

此时内核向程序进程反馈:写入成功;

-

内核在合适时机将内存中的脏页刷入磁盘。

注:9、10两步表示 Write Back模式,内核在没有将数据写入磁盘时就返回写入成功,以提高效率,相当于内核“欺骗”了应用程序。实际上不光内核会这样做,底层的很多环节也会有这样的情况,比如磁盘也会“欺骗”SAS控制器。如果此时发生系统掉电,所有易失性存储中的数据全部丢失,并未写入磁盘,而应用程序认为写IO已经完成了,下次开机时就会产生数据不一致。程序可以设置Write Through 模式,此时内核会等底层层层上报写入成功后,才会反馈写入成功。

参考链接

【Linux】关于空洞文件

【问题】:文件在初始地方放1字节,在K位置放1字节(一块的大小就是4K),整文件大小多少?占用硬盘物理空间多大?

【答】文件大小2字节,占用硬盘物理空间4K。

在日常的常识中,我们使用的文件存放在硬盘分区上的时候,有多大的内容就会占用多大的空间,但Linux为了便于管理文件,文件系统都是按块大小来分配给文件的,假如这个文件系统一个块是4096的话,那么这个文件就会占用一个块的,无论实际的内容是1B还是4000B.如果我们有一个4MB的文件,那么它会在分区中占用:4MB/4096B=1000个块.

但在Linux文件读写时,如果文件指针偏移很大一段,然后写入1byte,这样这个文件实际占用1byte空间,但是stat查看文件大小,或者读写时,都会发现文件很大,所有没有写内容的都填充0,且不占用空间,这样的文件叫

sparse file,即空洞文件。文件储存在硬盘上,硬盘的最小存储单位叫做"扇区"(

Sector)。每个扇区储存512字节(相当于0.5KB)。操作系统读取硬盘的时候,不会一个个扇区地读取,这样效率太低,而是一次性连续读取多个扇区,即一次性读取一个"块"(block)。这种由多个扇区组成的"块",是文件存取的最小单位。"块"的大小,最常见的是4KB,即连续八个sector组成一个block。举个生活中的例子吧,很多人一起吃饭,这个分配单元就相当于碗的大小,这个文件就好比碗里的饭,每个人的饭量不一样,有人吃的多,就需要两个碗来盛饭,但是有的人吃的少,但也是要占一个碗。了解这个概念以后,理解起来文件大小和占用空间的关系就简单多了。

其实可以实际测试一下,为了效果更佳明显,我没有按照题目一样只放一个字节。

对于

testfile1,我从一个tar文件那里复制1000个块,每块大小4096字节。通过ls –l命令我们可以看到文件大小4M,通过du –h命令可以看到占用硬盘物理空间同样是4M。而对于

testfile2,我只复制了最后的一个块,前面的999个都跳过了,也就是创建了一个空洞文件。可以看到文件大小虽然是4M,但占用硬盘物理空间只有4K。实际中的空洞文件会在哪里用到呢?常见的场景有两个:

- 在下载电影的时候,发现刚开始下载,文件的大小就已经到几百M了.

- 在创建虚拟机的磁盘镜像的时候,你创建了一个100G的磁盘镜像,但是其实装起来系统之后,开始也不过只占用了3,4G的磁盘空间,如果一开始把100G都分配出去的话,无疑是很大的浪费.

【Scala学习笔记 · 二】映射和元组、类、对象

第四章 映射和元组

1. 映射

Scala中映射是对偶的集合,也就是两个值构成的组,这两个值不一定是一个类型的。

//建立映射的两种方式

val sc = Map("A"->99, "B"-> 80)

val sc2 = Map(("Alice",10), ("Bob",8))

//获取映射的值

val Asc = sc.get("A")

//Asc: Option[Int] = Some(99)

val Bobsc = sc2.getOrElse("Bob",0)

//如果映射包含键“Bob”,返回相应值,否则返回0

//Bobsc: Int = 8

//映射的更新

val newsc = sc+("C"->88, "D"->77)

//映射迭代之键值交换

for((k, v) <- sc) yield (v,k)

//res0: scala.collection.immutable.Map[Int,String] = Map(99 -> A, 80 -> B)2. 元组

映射是对偶的集合,对偶是元组(tuple)的最简单形式——元组是不同类型的值的聚集。

//创建一个元组

val t = (1,2.2,"sadf")

//t: (Int, Double, String) = (1,2.2,sadf)

//如下方法访问组元,这里将第二个组元传给变量second

val second = t._2

//second: Double = 2.2

//也可以一起访问并赋值

val (fir, sec, thi) = t

//fir: Int = 1

//sec: Double = 2.2

//thi: String = sadf

//当然也可以不全部获取

val (fir1, sec1, _) = t

//fir1: Int = 1

//sec1: Double = 2.2拉链操作:

val symbol = Array("<", "-", ">")

val count = Array(2, 10, 2)

val pairs = symbol.zip(count)

//pairs: Array[(String, Int)] = Array((<,2), (-,10), (>,2))练习

- 设置一个映射,其中包含你想要的一些装备,以及它们的价格。然后构建另一个映射,采用同一组键,但在价格上打9折。

val p :Map[String, Int] = Map("t1"->10, "t2"->12, "t3"->20)

val ans = (for((k, v) <- p) yield {(k,v*0.9)})

//p: Map[String,Int] = Map(t1 -> 10, t2 -> 12, t3 -> 20)

//ans: scala.collection.immutable.Map[String,Double] = Map(t1 -> 9.0, t2 -> 10.8, t3 -> 18.0)- 编写一段程序,从文件中读取单词。用一个可变映射来清点每一个单词出现的频率。

import java.io.File

import java.util.Scanner

val in = new Scanner(new File("/text.txt"))

val map = new scala.collection.mutable.HashMap[String, Int]()

while(in.hasNext()){

val str = in.next()

map(str) = map.getOrElse(str,0) + 1

}

println(map.mkString(","))

//(alpha) -> 1,PageRank -> 1,Collaborative -> 1 .......................- 重复前一个练习,这次用不可变的映射。

import java.io.File

import java.util.Scanner

val in = new Scanner(new File("C:/Users/67329/Desktop/text.txt"))

val map = Map[String, Int]()

var m = map //不可变(val)映射

while(in.hasNext()){

val str = in.next()

m += (str -> (m.getOrElse(str,0) + 1))

//添加一对映射

}

println(m.mkString(","))

//abstraction -> 1,At -> 1,GraphX -> 4,for -> 1................- 重复前一个练习,这次用已排序的映射,以便单词可以按顺序打印出来。

import java.io.File

import java.util.Scanner

val in = new Scanner(new File("/text.txt"))

val map = scala.collection.immutable.SortedMap[String, Int]()

var m = map //不可变(val)映射

while(in.hasNext()){

val str = in.next()

m += (str -> (m.getOrElse(str,0) + 1))

//添加一对映射

}

println(m.mkString(","))

//(alpha) -> 1,(e.g., -> 3,API -> 1,API. -> 1............................- 编写一个函数minmax(values: Array[Int]),返回数组中最小值和最大值的对偶。

val t =Array(1,2,3,4,5)

val min = t.min

val max = t.max

printf("%d, %d\n",min,max)

//1, 5- 编写一个函数lteqgt(values: Array[Int], v: Int),返回数组中小于v,等于v和大于v的数量,要求三个值一起返回。

def iteqgt(values: Array[Int], v: Int) = {

var l,e,r = 0;

for (i <- values){

if (i<v)

l += 1

else if(i == v)

e += 1

else

r += 1

}

(l,e,r)

}

val a = Array(1,2,3,4,5,6)

val ans = iteqgt(a,3)

println(ans)

//(2,1,3)- 当你将两个字符串拉链在一起,比如”Hello”.zip(“World”),会是什么结果?想出一个讲得通的用例。

val t1 = "hello".zip("world")

val t2 = "ab".zip("cde")

val t3 = "abc".zip("d")

println(t1)

println(t2)

println(t3)

//Vector((h,w), (e,o), (l,r), (l,l), (o,d))

//Vector((a,c), (b,d))

//Vector((a,d))【Java】HashMap工作原理

HashMap工作原理

先抛出几个问题:

1.什么是HashMap?你为什么用到它?

2.你知道HashMap的工作原理吗?

3.你知道get和put的原理吗?equals()和hashCode()的都有什么作用?

4.你知道hash的实现吗?为什么要这样实现?

5.如果HashMap的大小超过了负载因子(load factor)定义的容量,怎么办?

1.HashMap是什么

简而言之,就是一种基于哈希的键值对数据结构。

在java官方文档中是这样描述HashMap的:

Hash table based implementation of the Map interface. This implementation provides all of the optional map operations, and permits null values and the null key. (The HashMap class is roughly equivalent to Hashtable, except that it is unsynchronized and permits nulls.) This class makes no guarantees as to the order of the map; in particular, it does not guarantee that the order will remain constant over time.

基于Map接口实现、允许null键/值、非同步(synchronized)、不保证有序(比如插入的顺序)、也不保证序不随时间变化。

【疑问】

null和非同步是怎么体现的?有什么作用?

2.HashMap 工作原理

2.1 结构与参数

系统在初始化HashMap时,会创建一个 长度为 capacity 的 Entry 数组,这个数组里可以存储元素的位置被称为“桶(bucket)”,每个 bucket 都有其指定索引,系统可以根据其索引快速访问该 bucket 里存储的元素。

在HashMap中有两个很重要的参数,容量(Capacity)和负载因子(Load factor):

Capacity就是buckets的数目,Load factor就是buckets填满程度的最大比例。如果对迭代性能要求很高的话不要把

capacity设置过大,也不要把load factor设置过小。当bucket填充的数目(即hashmap中元素的个数)大于capacity*load factor时就需要调整buckets的数目为当前的2倍。

无论何时,HashMap 的每个“桶”只存储一个元素(也就是一个 Entry),由于 Entry 对象可以包含一个引用变量(就是 Entry 构造器的的最后一个参数)用于指向下一个 Entry,

因此可能出现的情况是:HashMap 的 bucket 中只有一个 Entry,但这个 Entry 指向另一个 Entry ——这就形成了一个 Entry 链。(也就是冲突了)

当 HashMap 的每个 bucket 里存储的 Entry 只是单个 Entry ——也就是没有通过指针产生 Entry 链时(没有哈希冲突),此时的 HashMap 具有最好的性能:当程序通过 key 取出对应 value 时,系统只要先计算出该 key 的 hashCode() 返回值,在根据该 hashCode 返回值找出该 key 在 table 数组中的索引,然后取出该索引处的 Entry,最后返回该 key 对应的 value 即可。

在发生“Hash 冲突”的情况下,单个 bucket 里存储的不是一个 Entry,而是一个 Entry 链,系统只能必须按顺序遍历每个 Entry,直到找到想搜索的 Entry 为止——如果恰好要搜索的 Entry 位于该 Entry 链的最末端(该 Entry 是最早放入该 bucket 中),那系统必须循环到最后才能找到该元素。

当创建 HashMap 时,有一个默认的负载因子(load factor),其默认值为 0.75,这是时间和空间成本上一种折衷:增大负载因子可以减少 Hash 表(就是那个 Entry 数组)所占用的内存空间,但会增加查询数据的时间开销,而查询是最频繁的的操作(HashMap 的 get() 与 put() 方法都要用到查询);减小负载因子会提高数据查询的性能,但会增加 Hash 表所占用的内存空间。 通常情况下,程序员无需改变负载因子的值。

2.2 put()函数的实现

put函数大致的思路为:

- 对key的hashCode()做hash,然后再计算index;

- 如果没碰撞直接放到bucket里;

- 如果碰撞了,以链表的形式存在buckets后;

- 如果碰撞导致链表过长(大于等于TREEIFY_THRESHOLD),就把链表转换成红黑树参考此链接:Java 8:HashMap的性能提升;

- 如果节点已经存在就替换old value(保证key的唯一性)

- 如果bucket满了(超过load factor*current capacity),就要resize。

public V put(K key, V value) {

// 对key的hashCode()做hash

return putVal(hash(key), key, value, false, true);

}

final V putVal(int hash, K key, V value, boolean onlyIfAbsent,

boolean evict) {

Node<K,V>[] tab; Node<K,V> p; int n, i;

// tab为空则创建

if ((tab = table) == null || (n = tab.length) == 0)

n = (tab = resize()).length;

// 计算index,并对null做处理

if ((p = tab[i = (n - 1) & hash]) == null)

tab[i] = newNode(hash, key, value, null);

else {

Node<K,V> e; K k;

// 节点存在

if (p.hash == hash &&

((k = p.key) == key || (key != null && key.equals(k))))

e = p;

// 该链为树

else if (p instanceof TreeNode)

e = ((TreeNode<K,V>)p).putTreeVal(this, tab, hash, key, value);

// 该链为链表

else {

for (int binCount = 0; ; ++binCount) {

if ((e = p.next) == null) {

p.next = newNode(hash, key, value, null);

if (binCount >= TREEIFY_THRESHOLD - 1) // -1 for 1st

treeifyBin(tab, hash);

break;

}

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

break;

p = e;

}

}

// 写入

if (e != null) { // existing mapping for key

V oldValue = e.value;

if (!onlyIfAbsent || oldValue == null)

e.value = value;

afterNodeAccess(e);

return oldValue;

}

}

++modCount;

// 超过load factor*current capacity,resize

if (++size > threshold)

resize();

afterNodeInsertion(evict);

return null;

}2.3 get()函数的实现

大致思路如下:

- bucket里的第一个节点,直接命中;

- 如果有冲突,则通过key.equals(k)去查找对应的entry

- 若为树,则在树中通过key.equals(k)查找,O(logn);

- 若为链表,则在链表中通过key.equals(k)查找,O(n)。

public V get(Object key) {

Node<K,V> e;

return (e = getNode(hash(key), key)) == null ? null : e.value;

}

final Node<K,V> getNode(int hash, Object key) {

Node<K,V>[] tab; Node<K,V> first, e; int n; K k;

if ((tab = table) != null && (n = tab.length) > 0 &&

(first = tab[(n - 1) & hash]) != null) {

// 直接命中

if (first.hash == hash && // always check first node

((k = first.key) == key || (key != null && key.equals(k))))

return first;

// 未命中

if ((e = first.next) != null) {

// 在树中get

if (first instanceof TreeNode)

return ((TreeNode<K,V>)first).getTreeNode(hash, key);

// 在链表中get

do {

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

return e;

} while ((e = e.next) != null);

}

}

return null;

}2.4 hash函数的实现

static final int hash(Object key) {

int h;

return (key == null) ? 0 : (h = key.hashCode()) ^ (h >>> 16);

}高16bit不变,低16bit和高16bit做了一个异或。

这样的一个hash函数实现,主要是权衡了速度与碰撞率。

设计者还解释到因为现在大多数的hashCode的分布已经很不错了,就算是发生了碰撞也用

O(logn)的tree去做了。仅仅异或一下,既减少了系统的开销,也不会造成的因为高位没有参与下标的计算(table长度比较小时),从而引起的碰撞。

如果发生了碰撞:

在Java 8之前的实现中是用链表解决冲突的,在产生碰撞的情况下,进行get时,两步的时间复杂度是O(1)+O(n)。因此,当碰撞很厉害的时候n很大,O(n)的速度显然是影响速度的。

因此在Java 8中,利用红黑树替换链表,这样复杂度就变成了O(1)+O(logn)了,这样在n很大的时候,能够比较理想的解决这个问题,在Java 8:HashMap的性能提升一文中有性能测试的结果。

注意:hash和计算下标是不一样的,hash是计算下标过程的一部分

2.5 RESIZE 的实现

当put时,如果发现目前的bucket占用程度已经超过了Load Factor所希望的比例,为了减少碰撞率,就会执行resize。resize的过程,简单的说就是把bucket扩充为2倍,之后重新计算index,把节点再放到新的bucket中。

怎么理解呢?例如我们从16扩展为32时,具体的变化如下所示:

因此元素在重新计算hash之后,因为n变为2倍,那么n-1的mask范围在高位多1bit(红色),因此新的index就会发生这样的变化:

因此,我们在扩充HashMap的时候,不需要重新计算hash,只需要看看原来的hash值新增的那个bit是1还是0就好了,是0的话索引没变,是1的话索引变成“原索引+oldCap”。可以看看下图为16扩充为32的resize示意图:

这个设计确实非常的巧妙,既省去了重新计算hash值的时间,而且同时,由于新增的1bit是0还是1可以认为是随机的,因此resize的过程,均匀的把之前的冲突的节点分散到新的bucket了。

Hashmap为什么容量是2的幂次

最理想的效果是,Entry数组中每个位置都只有一个元素,这样,查询的时候效率最高,不需要遍历单链表,也不需要通过equals去比较K,而且空间利用率最大。那如何计算才会分布最均匀呢?我们首先想到的就是%运算,哈希值%容量=bucketIndex。

static int indexFor(int h, int length) {

return h & (length-1);

} 这个等式实际上可以推理出来,2^n转换成二进制就是1+n个0,减1之后就是0+n个1,如16 -> 10000,15 -> 01111,那根据&位运算的规则,都为1(真)时,才为1,那0≤运算后的结果≤15,假设h <= 15,那么运算后的结果就是h本身,h >15,运算后的结果就是最后三位二进制做&运算后的值,最终,就是%运算后的余数,我想,这就是容量必须为2的幂的原因。

3. 总结

1. 什么是HashMap?你为什么用到它?

是基于Map接口的实现,存储键值对时,它可以接收null的键值,是非同步的,HashMap存储着Entry(hash, key, value, next)对象。

2. 你知道HashMap的工作原理吗?

通过hash的方式,以键值对<K,V>的方式存储(put)、获取(get)对象。存储对象时,我们将K/V传给put方法时,它调用hashCode计算hash从而得到bucket位置,进一步存储,HashMap会根据当前bucket的占用情况自动调整容量(超过Load Facotr则resize为原来的2倍)。获取对象时,我们将K传给get,它调用hashCode计算hash从而得到bucket位置,并进一步调用equals()方法确定键值对。如果发生碰撞的时候,Hashmap通过链表将产生碰撞冲突的元素组织起来,在Java 8中,如果一个bucket中碰撞冲突的元素超过某个限制(默认是8),则使用红黑树来替换链表,从而提高速度。

3. 你知道get和put的原理吗?equals()和hashCode()的都有什么作用?

通过对key的hashCode()进行hashing,并计算下标( n-1 & hash),从而获得buckets的位置。如果产生碰撞,则利用key.equals()方法去链表或树中去查找对应的节点。

4. 你知道hash的实现吗?为什么要这样实现?

在Java 1.8的实现中,是通过hashCode()的高16位异或低16位实现的:(h = k.hashCode()) ^ (h >>> 16),主要是从速度、功效、质量来考虑的,这么做可以在bucket的n比较小的时候,也能保证考虑到高低bit都参与到hash的计算中,同时不会有太大的开销。

5. 如果HashMap的大小超过了负载因子(load factor)定义的容量,怎么办?

如果超过了负载因子(默认0.75),则会重新resize一个原来长度两倍的HashMap,并且重新调用hash方法。

6. 什么是哈希冲突?如何解决的?

以Entry[]数组实现的哈希桶数组,用Key的哈希值取模桶数组的大小可得到数组下标。

插入元素时,如果两条Key落在同一个桶(比如哈希值1和17取模16后都属于第一个哈希桶),我们称之为哈希冲突。

JDK的做法是链表法,Entry用一个next属性实现多个Entry以单向链表存放。查找哈希值为17的key时,先定位到哈希桶,然后链表遍历桶里所有元素,逐个比较其Hash值然后key值。

在JDK8里,新增默认为8的阈值,当一个桶里的Entry超过閥值,就不以单向链表而以红黑树来存放以加快Key的查找速度。

当然,最好还是桶里只有一个元素,不用去比较。所以默认当Entry数量达到桶数量的75%时,哈希冲突已比较严重,就会成倍扩容桶数组,并重新分配所有原来的Entry。扩容成本不低,所以也最好有个预估值。

7. HashMap在高并发下引起的死循环

- HashMap进行存储时,如果size超过当前最大容量*负载因子时候会发生resize。

- 而这段代码中又调用了transfer()方法,而这个方法实现的机制就是将每个链表转化到新链表,并且链表中的位置发生反转,而这在多线程情况下是很容易造成链表回路,从而发生get()死循环

- 链表头插法的会颠倒原来一个散列桶里面链表的顺序。在并发的时候原来的顺序被另外一个线程a颠倒了,而被挂起线程b恢复后拿扩容前的节点和顺序继续完成第一次循环后,又遵循a线程扩容后的链表顺序重新排列链表中的顺序,最终形成了环。

- 假如有两个线程P1、P2,以及链表 a=》b=》null

- P1先执行,执行完"Entry<K,V> next = e.next;"代码后发生阻塞,或者其他情况不再执行下去,此时e=a,next=b

- 而P2已经执行完整段代码,于是当前的新链表newTable[i]为b=》a=》null

- P1又继续执行"Entry<K,V> next = e.next;"之后的代码,则执行完"e=next;"后,newTable[i]为a《=》b,则造成回路,while(e!=null)一直死循环

参考资料

HashMap的工作原理

HashMap 里的“bucket”、“负载因子” 介绍

Java 8:HashMap的性能提升

HashMap和Hashtable的区别

【Camera】Camera2Basic 源码阅读

Camera2Basic 源码阅读

本文将通过对 android-Camera2Basic 的源码分析,学习安卓相机的基本开发。

【TODO】getSupportFragmentManager() 这系列的语句是做什么用的?

【TODO】安卓基础:inflater

【TODO】Java 信号量 Semaphore

【TODO】camera:TextureView是什么?

【TODO】OpenGL相关:OpenGL ES texture是什么?

一、CameraActivity

public class CameraActivity extends AppCompatActivity {

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity_camera);

if (null == savedInstanceState) {

getSupportFragmentManager().beginTransaction()

.replace(R.id.container, Camera2BasicFragment.newInstance())

.commit();

}

}

}首先肯定要看这个相机应用是怎么诞生的。

onCreate很简短,主要是实例化一个 Camera2BasicFragment,也是整个项目的重头戏。

【TODO】getSupportFragmentManager() 这系列的语句是做什么用的?

二、Camera2BasicFragment

public static Camera2BasicFragment newInstance() {

return new Camera2BasicFragment();

}通过这个方法,之前的活动 CameraActivity 实例化了Fragment:

【此处应有张截图】代码界面贴一张图片

由上图可以看到,整个 com.example.android.camera2basic.Camera2BasicFragment.java 总共有 25 个方法、一个图片保存类、一个比较类以及两个日志类。

根据本app的拍照流程,这25个方法可以分为以下几类:

创建界面 - 打开相机 - 显示预览 - 拍摄 - 保存图片 - 关闭服务

2.1 创建界面

(1) 导入视图的xml

@Override

public View onCreateView(LayoutInflater inflater, ViewGroup container,

Bundle savedInstanceState) {

return inflater.inflate(R.layout.fragment_camera2_basic, container, false);

}【TODO】 安卓基础:inflater

(2)配置按钮

@Override

public void onViewCreated(final View view, Bundle savedInstanceState) {

// 下方蓝底和拍摄按钮

view.findViewById(R.id.picture).setOnClickListener(this);

// 右侧感叹号 信息按钮

view.findViewById(R.id.info).setOnClickListener(this);

mTextureView = (AutoFitTextureView) view.findViewById(R.id.texture);

}设置拍摄按钮以及info按钮的点击事件

(3)相关配置初始化

@Override

public void onActivityCreated(Bundle savedInstanceState) {

super.onActivityCreated(savedInstanceState);

// 为拍摄得到的图片定义输出路径文件

mFile = new File(getActivity().getExternalFilesDir(null), "pic.jpg");

}mFile是图片的输出目标文件

2.2 打开相机

2.2.1 通过API2调用

app层次的代码肯定是无法直接调用硬件层面的摄像头配置的,所以需要使用API2提供的接口来对相机进行打开和关闭,以及异常情况的处理:

/**

* {@link CameraDevice.StateCallback} is called when {@link CameraDevice} changes its state.

*/

private final CameraDevice.StateCallback mStateCallback = new CameraDevice.StateCallback() {

// 打开摄像头

@Override

public void onOpened(@NonNull CameraDevice cameraDevice) {

// This method is called when the camera is opened. We start camera preview here.

mCameraOpenCloseLock.release();

mCameraDevice = cameraDevice;

// 创建预览绘画

createCameraPreviewSession();

}

@Override

public void onDisconnected(@NonNull CameraDevice cameraDevice) {

// 关闭相机连接时 解锁(此处省略代码)

}

@Override

public void onError(@NonNull CameraDevice cameraDevice, int error) {

//(此处省略代码)

};对于摄像头这个独占资源的使用,采用了

private Semaphore mCameraOpenCloseLock = new Semaphore(1);

信号量进行控制。 【TODO】Java 信号量 Semaphore

并创建了之后为用户提供画面的预览会话。

这部分API的使用,会在之后的app调用中通过 CameraManager 来使用。

2.2.2 获得相机权限

回到app层面,要使用相机,肯定需要获得Android的相机权限:

private void requestCameraPermission() {

if (shouldShowRequestPermissionRationale(Manifest.permission.CAMERA)) {

new ConfirmationDialog().show(getChildFragmentManager(), FRAGMENT_DIALOG);

} else {

requestPermissions(new String[]{Manifest.permission.CAMERA}, REQUEST_CAMERA_PERMISSION);

}

}2.2.3 相机输出设置

获得所有摄像头的特性,并根据长度宽度这两个参数,设置预览与输出的分辨率大小。

private void setUpCameraOutputs(int width, int height) {

Activity activity = getActivity();

CameraManager manager = (CameraManager) activity.getSystemService(Context.CAMERA_SERVICE);

try {

// 0. 可能有多个摄像头,比如前置后置,遍历每个摄像头进行设置

for (String cameraId : manager.getCameraIdList()) {

// 1. 获得描述摄像头的各种特性

// 通过CameraManager的getCameraCharacteristics(String cameraId)方法来获取

CameraCharacteristics characteristics

= manager.getCameraCharacteristics(cameraId);

// 2. 跳过前置摄像头

Integer facing = characteristics.get(CameraCharacteristics.LENS_FACING);

if (facing != null && facing == CameraCharacteristics.LENS_FACING_FRONT) {

continue;

}

// 3. 获得该摄像头支持的分辨率信息

StreamConfigurationMap map = characteristics.get(

CameraCharacteristics.SCALER_STREAM_CONFIGURATION_MAP);

if (map == null) {

continue;

}

// 4. 使用可行的最大的尺寸来输出照片

Size largest = Collections.Arrays.asList(map.getOutputSizes(ImageFormat.JPEG)),new CompareSizesByArea());

。。。

// Find out if we need to swap dimension to get the preview size relative to sensor coordinate.

int displayRotation = activity.getWindowManager().getDefaultDisplay().getRotation();

//noinspection ConstantConditions

// 5. 获取摄像头方向,按照顺时针来衡量角度

mSensorOrientation = characteristics.get(CameraCharacteristics.SENSOR_ORIENTATION);

boolean swappedDimensions = false;

switch (displayRotation) {

。。。

}

// 6. 通过点的坐标获得预览显示区域的像素大小

Point displaySize = new Point();

activity.getWindowManager().getDefaultDisplay().getSize(displaySize);

。。。

// 7. 将TextureView的宽高与预览的大小匹配,并且会与手机横置与否匹配

int orientation = getResources().getConfiguration().orientation;

。。。

// 8. 检查闪光灯是否支持

Boolean available = characteristics.get(CameraCharacteristics.FLASH_INFO_AVAILABLE);

。。。

return;

}

} catch (CameraAccessException e) {

e.printStackTrace();

} catch (NullPointerException e) {

// Currently an NPE is thrown when the Camera2API is used but not supported on the

// device this code runs.

ErrorDialog.newInstance(getString(R.string.camera_error))

.show(getChildFragmentManager(), FRAGMENT_DIALOG);

}

}2.2.4 通过CameraManager管理相机

CameraManager manager = (CameraManager) activity.getSystemService(Context.CAMERA_SERVICE);

CameraManager是一个系统服务,将相机硬件相关的功能封装成接口供调用。

2.2.* 整体流程代码

整体流程封装如下,在最后的打开相机时,会使用Lock.tryAcquire() 检测锁是否被占用。

/**

* Opens the camera specified by {@link Camera2BasicFragment#mCameraId}.

*/

private void openCamera(int width, int height) {

// 1. 获取权限

if (ContextCompat.checkSelfPermission(getActivity(), Manifest.permission.CAMERA)

!= PackageManager.PERMISSION_GRANTED) {

requestCameraPermission();

return;

}

// 设置相机输出格式:长宽,并配置好预览的长宽、闪光灯配置等

setUpCameraOutputs(width, height);

//

configureTransform(width, height);

Activity activity = getActivity();

// 2. 获取CameraManager:"摄像头管理器,用于打开和关闭系统摄像头"

CameraManager manager = (CameraManager) activity.getSystemService(Context.CAMERA_SERVICE);

try {

// 请求摄像头时检测锁是否被占用

if (!mCameraOpenCloseLock.tryAcquire(2500, TimeUnit.MILLISECONDS)) {

throw new RuntimeException("Time out waiting to lock camera opening.");

}

// 调用时内部还会有同步锁进行控制

manager.openCamera(mCameraId, mStateCallback, mBackgroundHandler);

} catch (CameraAccessException e) {

e.printStackTrace();

} catch (InterruptedException e) {

throw new RuntimeException("Interrupted while trying to lock camera opening.", e);

}

}【TODO】TextureView是什么? 旋转?

2.3 显示预览

// 打开摄像头

@Override

public void onOpened(@NonNull CameraDevice cameraDevice) {

// This method is called when the camera is opened. We start camera preview here.

mCameraOpenCloseLock.release();

mCameraDevice = cameraDevice;

// 创建预览会话

createCameraPreviewSession();

}打开摄像头之后,就要在应用界面显示预览画面。

预览画面时动态且实时的,所以需要摄像头持续不断的获取数据:

所以创建了一个拍摄会话,通过一个重复请求源源不断的获取图片,并以数组形式传递给surface用以显示预览

surface是什么?

是一个接受数据的原始缓冲

经常被SurfaceTexture、MediaRecorder等图片缓冲消费者(consumer of image buffers)创建

或者被生产者如opengl.EGL14、MediaPlayer等调用通过SurfaceTexture创建

【TODO】OpenGL相关:OpenGL ES texture是什么?({@link SurfaceTexture}: Captures frames from an image stream as an OpenGL ES texture.)

/**

* Creates a new {@link CameraCaptureSession} for camera preview.

*/

private void createCameraPreviewSession() {

try {

SurfaceTexture texture = mTextureView.getSurfaceTexture();

assert texture != null;

// 我们将默认缓冲区的大小配置为我们想要的相机预览的大小。

texture.setDefaultBufferSize(mPreviewSize.getWidth(), mPreviewSize.getHeight());

// 这是需要开始预览的输出surface

Surface surface = new Surface(texture);

// 通过surface配置CaptureRequest.Builder

mPreviewRequestBuilder

= mCameraDevice.createCaptureRequest(CameraDevice.TEMPLATE_PREVIEW);

mPreviewRequestBuilder.addTarget(surface);

// Here, we create a CameraCaptureSession for camera preview.

// 创建CaptureSession会话。

// 第一个参数 outputs 是一个 List 数组,相机会把捕捉到的图片数据传递给该参数中的 Surface 。

// 第二个参数 StateCallback 是创建会话的状态回调。

// 第三个参数描述了 StateCallback 被调用时所在的线程,这里为 null

mCameraDevice.createCaptureSession(Arrays.asList(surface, mImageReader.getSurface()),

new CameraCaptureSession.StateCallback() {

@Override

public void onConfigured(@NonNull CameraCaptureSession cameraCaptureSession) {

// The camera is already closed

if (null == mCameraDevice) {

return;

}

// When the session is ready, we start displaying the preview.

mCaptureSession = cameraCaptureSession;

try {

// Auto focus should be continuous for camera preview.

mPreviewRequestBuilder.set(CaptureRequest.CONTROL_AF_MODE,

CaptureRequest.CONTROL_AF_MODE_CONTINUOUS_PICTURE);

// Flash is automatically enabled when necessary.

setAutoFlash(mPreviewRequestBuilder);

// Finally, we start displaying the camera preview.

mPreviewRequest = mPreviewRequestBuilder.build();

// 为预览会话持续不断的重复获取捕捉到的图片

// 并且mPreviewRequest由之前的代码定义:设置为连续自动对焦模式,并在必要时自动开启闪光

mCaptureSession.setRepeatingRequest(mPreviewRequest,

mCaptureCallback, mBackgroundHandler);

} catch (CameraAccessException e) {

e.printStackTrace();

}

}

@Override

public void onConfigureFailed(

@NonNull CameraCaptureSession cameraCaptureSession) {

showToast("Failed");

}

}, null

);

} catch (CameraAccessException e) {

e.printStackTrace();

}

}2.4 拍摄

2.4.1 点击拍摄按钮拍照:

public void onClick(View view) {

switch (view.getId()) {

case R.id.picture: {

// 点击拍摄键拍照

takePicture();

break;

}

case R.id.info: {

。。。

}

break;

}

}

}

private void takePicture() {

lockFocus();

}2.4.2 对焦曝光要正确

拍照,肯定要对焦,并且对焦要稳定不能拉风箱,对于对焦的状态,可通过mState = STATE_WAITING_LOCK;进行控制。

private void lockFocus() {

try {

// This is how to tell the camera to lock focus.

// 告诉摄像头 配置自动对焦

mPreviewRequestBuilder.set(CaptureRequest.CONTROL_AF_TRIGGER,

CameraMetadata.CONTROL_AF_TRIGGER_START);

// Tell #mCaptureCallback to wait for the lock.

mState = STATE_WAITING_LOCK;

mCaptureSession.capture(mPreviewRequestBuilder.build(), mCaptureCallback,

mBackgroundHandler);

} catch (CameraAccessException e) {

e.printStackTrace();

}

}通过RequestBuilder配置好自动对焦后,等待对焦稳定,通过session拍摄,此时会调用一个回调进行拍摄,也就是mCaptureCallback。

而拍摄的处理过程就是靠这个回调定义的。

这个回调mCaptureCallback,会分为四种不同的情况:

预览时需要调用摄像头的数据但并不做拍摄操作;

mState = STATE_WAITING_LOCK时表示要准备拍照了,此时会根据【对焦状态】进行拍摄或尝试进行预拍摄(precapture);

根据【曝光状态】如“需要闪光灯补光”,将mstate由等待预拍摄(STATE_WAITING_PRECAPTURE)转换为等待非预拍摄(STATE_WAITING_NON_PRECAPTURE)

曝光稳定后拍摄

/**

* A {@link CameraCaptureSession.CaptureCallback} that handles events related to JPEG capture.

*/

private CameraCaptureSession.CaptureCallback mCaptureCallback

= new CameraCaptureSession.CaptureCallback() {

private void process(CaptureResult result) {

// 按下拍照键后根据设置的不同,有不同的拍摄方式

switch (mState) {

case STATE_PREVIEW: {

// 预览

// We have nothing to do when the camera preview is working normally.

break;

}

case STATE_WAITING_LOCK: {

// 对焦稳定后拍摄或尝试拍摄

Integer afState = result.get(CaptureResult.CONTROL_AF_STATE);

if (afState == null) {

captureStillPicture();

} else if (CaptureResult.CONTROL_AF_STATE_FOCUSED_LOCKED == afState ||

CaptureResult.CONTROL_AF_STATE_NOT_FOCUSED_LOCKED == afState) {

// CONTROL_AE_STATE can be null on some devices

Integer aeState = result.get(CaptureResult.CONTROL_AE_STATE);

if (aeState == null ||

aeState == CaptureResult.CONTROL_AE_STATE_CONVERGED) {

// 对焦状态无特殊情况或与当前场景契合 正常拍照

mState = STATE_PICTURE_TAKEN;

captureStillPicture();

} else {

runPrecaptureSequence();

}

}

break;

}

case STATE_WAITING_PRECAPTURE: {

// CONTROL_AE_STATE can be null on some devices

// 曝光,等待曝光稳定,比如需要闪光灯

Integer aeState = result.get(CaptureResult.CONTROL_AE_STATE);

if (aeState == null ||

aeState == CaptureResult.CONTROL_AE_STATE_PRECAPTURE ||

aeState == CaptureRequest.CONTROL_AE_STATE_FLASH_REQUIRED) {

mState = STATE_WAITING_NON_PRECAPTURE;

}

break;

}

case STATE_WAITING_NON_PRECAPTURE: {

// CONTROL_AE_STATE can be null on some devices

// 曝光稳定后拍摄

Integer aeState = result.get(CaptureResult.CONTROL_AE_STATE);

if (aeState == null || aeState != CaptureResult.CONTROL_AE_STATE_PRECAPTURE) {

mState = STATE_PICTURE_TAKEN;

captureStillPicture();

}

break;

}

}

}2.4.3 拍照

真正获得静态图像的是captureStillPicture()这个方法。

/**

* Capture a still picture. This method should be called when we get a response in

* {@link #mCaptureCallback} from both {@link #lockFocus()}.

* 拍照获得静态图像并保存

*/

private void captureStillPicture() {

try {

final Activity activity = getActivity();

if (null == activity || null == mCameraDevice) {

return;

}

// 和预览界面相似的一系列设置,包括自动曝光自动对焦等

// This is the CaptureRequest.Builder that we use to take a picture.

final CaptureRequest.Builder captureBuilder =

mCameraDevice.createCaptureRequest(CameraDevice.TEMPLATE_STILL_CAPTURE);

captureBuilder.addTarget(mImageReader.getSurface());

// Use the same AE and AF modes as the preview.

captureBuilder.set(CaptureRequest.CONTROL_AF_MODE,

CaptureRequest.CONTROL_AF_MODE_CONTINUOUS_PICTURE);

setAutoFlash(captureBuilder);

// Orientation

int rotation = activity.getWindowManager().getDefaultDisplay().getRotation();

captureBuilder.set(CaptureRequest.JPEG_ORIENTATION, getOrientation(rotation));

// 通过保存了拍摄设置的session,调用拍摄回调,将图片保存到文件中,并toast路径

CameraCaptureSession.CaptureCallback CaptureCallback

= new CameraCaptureSession.CaptureCallback() {

@Override

public void onCaptureCompleted(@NonNull CameraCaptureSession session,

@NonNull CaptureRequest request,

@NonNull TotalCaptureResult result) {

showToast("Saved: " + mFile);

Log.d(TAG, mFile.toString());

// 拍摄结束时结束等待对焦状态,回到预览状态

unlockFocus();

}

};

// 中断传输给预览界面的循环

mCaptureSession.stopRepeating();

// 放弃当前所有任务,如果是循环任务如预览,会放弃之前缓存的数据

mCaptureSession.abortCaptures();

// 根据之前设置的参数,拍照获取当前帧

mCaptureSession.capture(captureBuilder.build(), CaptureCallback, null);

} catch (CameraAccessException e) {

e.printStackTrace();

}

}拍摄时,会中断为预览画面执行的循环任务,并放弃之前缓存的数据,然后拍照获取当前帧。

2.5 保存图片

图片的保存是通过一个实现了runnable的内部类,异步保存

private static class ImageSaver implements Runnable {

/**

* The JPEG image

*/

private final Image mImage;

/**

* The file we save the image into.

*/

private final File mFile;

ImageSaver(Image image, File file) {

mImage = image;

mFile = file;

}

// 使用另一个线程保存照片

@Override

public void run() {

ByteBuffer buffer = mImage.getPlanes()[0].getBuffer();

byte[] bytes = new byte[buffer.remaining()];

buffer.get(bytes);

FileOutputStream output = null;

try {

output = new FileOutputStream(mFile);

output.write(bytes);

} catch (IOException e) {

e.printStackTrace();

} finally {

mImage.close();

if (null != output) {

try {

// 在finally里面调用close,如果在try中close,可能会因为出现异常,导致无法执行到close语句

output.close();

} catch (IOException e) {

e.printStackTrace();

}

}

}

}

}2.6 关闭服务

使用juc中的信号量Semaphore控制并发,依次关闭相机相关服务

private void closeCamera() {

// 使用juc中的信号量Semaphore控制并发,依次关闭相机相关服务

try {

mCameraOpenCloseLock.acquire();

if (null != mCaptureSession) {

mCaptureSession.close();

mCaptureSession = null;

}

if (null != mCameraDevice) {

mCameraDevice.close();

mCameraDevice = null;

}

if (null != mImageReader) {

mImageReader.close();

mImageReader = null;

}

} catch (InterruptedException e) {

throw new RuntimeException("Interrupted while trying to lock camera closing.", e);

} finally {

mCameraOpenCloseLock.release();

}

}2.7 特殊情况的处理

在阅读代码的过程中,经常会出现一些变量,与“Background”有关,比如mBackgroundThread。最开始看到很疑惑这个东西是干什么的。

/**

* An additional thread for running tasks that shouldn't block the UI.

* 一个额外的线程用以运行维持UI的任务

*/

private HandlerThread mBackgroundThread;搜寻了一番发现在 onResume() 中有段注释:

@Override

public void onResume() {

super.onResume();

// TODO:什么是HandlerThread,关于BackgroundThread是做什么的:见line224

startBackgroundThread();

// When the screen is turned off and turned back on, the SurfaceTexture is already

// available, and "onSurfaceTextureAvailable" will not be called. In that case, we can open

// a camera and start preview from here (otherwise, we wait until the surface is ready in

// the SurfaceTextureListener).

if (mTextureView.isAvailable()) {

openCamera(mTextureView.getWidth(), mTextureView.getHeight());

} else {

mTextureView.setSurfaceTextureListener(mSurfaceTextureListener);

}

}也就是说,但屏幕关闭之后又开启,相机应用可以通过这个“后台线程”快速可用。

同时可以注意到该线程是一个HandleThread类,似乎是个Android独有的线程实现方式。

private void startBackgroundThread() {

mBackgroundThread = new HandlerThread("CameraBackground");

mBackgroundThread.start();

// 在Android开发中,不熟悉多线程开发的人一想到要使用线程,可能就用new Thread(){…}.start()这样的方式。

//实质上在只有单个耗时任务时用这种方式是可以的,但若是有多个耗时任务要串行执行呢?

//那不得要多次创建多次销毁线程,这样导致的代价是很耗系统资源,容易存在性能问题。那么,怎么解决呢?

//我们可以只创建一个工作线程,然后在里面循环处理耗时任务,

mBackgroundHandler = new Handler(mBackgroundThread.getLooper());

}那么如何关闭这个线程?

在onPause()中调用:

@Override

public void onPause() {

closeCamera();

stopBackgroundThread();

super.onPause();

}HandlerThread既然是一个循环线程,那么怎么退出呢?有两种方式,分别是不安全的退出方法quit()和安全的退出方法quitSafely();

具体有关HandlerThread的内容可以看另一篇博文。

private void stopBackgroundThread() {

// HandlerThread既然是一个循环线程,那么怎么退出呢?有两种方式,分别是不安全的退出方法quit()和安全的退出方法quitSafely():

mBackgroundThread.quitSafely();

try {

mBackgroundThread.join();

mBackgroundThread = null;

mBackgroundHandler = null;

} catch (InterruptedException e) {

e.printStackTrace();

}

}三、总结

整体代码就是按照拍照应该有的流程进行,包括创建界面 - 打开相机 - 显示预览 - 拍摄 - 保存图片 - 关闭服务,以及特殊情况的处理。

通过功能来梳理源码,结构很清晰,同时了解了拍摄前后的一些细节,比如对焦曝光检测。

同时编码过程中也有很多trick,比如信号量在相机开关时的使用,以及handlerThread实现的后台线程,应该会对以后的编码有所启发。

DONE

【Scala学习笔记 · 三】包和引入、继承、文件和正则表达式

第七章 包和引入

1. 包

下面的代码定义了一个cn.scala.xtwy包

在程序的任何地方都可以通过cn.scala.xtwy.Teacher来使用Teacher这个类

package cn{

package scala{

package xtwy{

class Teacher {

}

}

}

}2. 包的作用域

包可以和其他作用域嵌套,可以访问上层作用域的名称。

package cn{

package scala{

//在包cn.scala下创建了一个Utils单例

object Utils{

def toString(x:String){

println(x)

}

//外层包无法直接访问内层包,下面这一行代码编译通不过

//def getTeacher():Teacher=new Teacher("john")

//如果一定要使用的话,可以引入包

import cn.scala.xtwy._

def getTeacher():Teacher=new Teacher("john")

}

//定义了cn.scala.xtwy

package xtwy{

class Teacher(var name:String) {

//演示包的访问规则

//内层包可以访问外层包中定义的类或对象,无需引入

def printName()={Utils.toString(name)}

}

}

}

}

object Test{

//scala允许在任何地方进行包的引入,_的意思是引入该包下的所有类和对象

import cn.scala._

import cn.scala.xtwy._

def main(args: Array[String]): Unit = {

Utils.toString(new Teacher("john").name)

new Teacher("john").printName()

}

}但在Scala中包名是相对的(Java中是绝对的),也就是说:比如创建com.horstmann.collection包,那么编译器在寻找collection.mutable时就不能找到,因为本意是向使用顶级的scala包的collection包,而不是随便什么存在与可访问作用域中的子包。

而这个解决方法之一就是使用包名,以_root_开始:

val subordinates = new _root_.scala.collection.mutable.ArrayBuffer[Employee]3. 包对象

package cn{

package scala{

object Utils{

def toString(x:String){

println(x)

}

import cn.scala.xtwy._

def getTeacher():Teacher=new Teacher("john")

}

package xtwy{

class Teacher(var name:String) {

def printName()={Utils.toString(name)}

}

}

}

}

//利用package关键字定义单例对象

package object Math {

val PI=3.141529

val THETA=2.0

val SIGMA=1.9

}

class Coputation{

def computeArea(r:Double)=Math.PI*r*r

}

//PI: Double = 3.141529

//THETA: Double = 2.0

//SIGMA: Double = 1.94. 包可见性

package cn{

package scala{

object Utils{

def toString(x:String){

println(x)

}

import cn.scala.xtwy._

def getTeacher():Teacher=new Teacher("john")

}

package xtwy{

class Teacher(var name:String) {

def printName()={Utils.toString(name)}

}

}

}

}

class Teacher(var name: String) {

private def printName(tName:String="") :Unit= { println(tName) }

//可以访问

def print(n:String)=this.printName(n)

}

object Teacher{

//伴生对象可以访问

def printName=new Teacher("john").printName()

}

object appDemo {

def main(args: Array[String]): Unit = {

//不能访问

//new Teacher("john").printName()

}

}5. import高级特性

重命名与隐藏方法

import java.util.{ HashMap => JavaHashMap }

//将java.util.HashMap重命名为JavaHashMap

import java.util.{HashMap=> _,_}

//通过HashMap=> _,这样类便被隐藏起来了隐式引入

每个Scala程序都隐式的引入了以下代码:

import java.lang._

import scala._

import Predef._

练习

- 编写一段让你的Scala朋友们感到困惑的代码,使用一个不在顶部的com包。

package com.horstmann.impatient {

object Funcy {

def foo {

println("top level com");

}

}

}

package scala.com.horstmann.impatient {

object Funcy {

def foo {

println("not top level com");

}

}

}

import scala._ // 如果去掉用输出 "top level com" , 否则输出 "not top level com"

object Test {

def main(args : Array[String]) {

com.horstmann.impatient.Funcy.foo

}

}- 编写一个包random,加入函数nextInt():Int、nextDouble: Double和setSeed(seed:Int):Unit。生成随机数的算法使用线性同余生成器:

后值=(前值 x * a + b) mod 2^n

其中,a=1664525,b=1013904223,n=32,前值的初始值为seed。

package random {

package object random {

val a : Long = 1664525;

val b : Long = 1013904223;

val n : Int = 32;

var prev : Int = 1;

def nextInt() : Int = {

val rand = (prev * a + b) % n

setSeed(rand.toInt)

rand.toInt

}

def setSeed(seed : Int) : Unit = {

this.prev = seed

}

def nextDouble() : Double = {

nextInt.toDouble / n

}

}

}

object Test {

def main(args : Array[String]) {

import random._ //导入包

random.setSeed(1);

for (_ <- 1.to(10, 1)) {

println(random.nextInt);

}

for (_ <- 1.to(10, 1)) {

println(random.nextDouble);

}

}

}【Java】由几个多线程并发的失效案例出发

[toc]

一、多线程并发

1. synchronized的对象定义为final

【例子】对于一个变量mA,将其作为synchronized的对象,但是没有定义为final,而且在函数1中有改变其值,那么对于函数2和3来讲就有可能sync不同的对象,从而起不到同步作用。

【分析】使用该变量作为锁对象本来就是不正规的,应该为此private final new Object(),使用final的同步对象作为synchronized的对象,然后再各个函数内操作改变变量mA

【原理】

概括:【TODO】

参考链接

- final关键词在多线程环境中的使用

- 从Java内存模型理解synchronized、volatile和final关键字

- volatile、synchronized、final原理浅析

- 额外深入: 深入理解 Java 内存模型(六)——final

- 延申: 为什么要指令重排序?

2. 同步锁对象不明确

【例子】使用this对象锁时,this指向的可能是其内部类对象。下面的例子为同一个类,this为三个不同的对象

【分析】这个问题体现的是同步锁的不是一个对象;使用同步锁对象时需要将其声明为final,并确保同步锁的是同一对象

【原理】使用自定义任意对象进行同步锁 不同线程必须为同一对象,否则仍旧是异步运行的。而存在内部类时,使用this会导致指向内部类,使得多个线程之间,一个持有大类,一个持有内部类,并不是同一个锁(同一个对象)

参考链接:

3. 同步锁范围过大导致死锁

【例子】同步锁范围过大有可能导致两个线程试图以不同的顺序来获得相同的锁,进而死锁

public void funA() {

synchronized(mA) {

//...

funcB();

}

}

void funcB() {

synchronized(mB) {

}

}【分析】在log中(暂无图),会出现

thread-1先拿到mA的锁,在等待mB,thread-2可能在别处先拿到mB的锁,在等待mA即2个thread死锁

【解决】缩小同步锁范围,不要出现两个锁嵌套

public void funA() {

synchronized(mA) {

//...

}

funcB();

}

void funcB() {

synchronized(mB) {

}

}4. 多线程环境下单例模式的规范写法

编写的单例模式不够规范,下面介绍两种规范写法供大家参考

【写法一】

- 参考代码

public class Singleton {

private static volatile Singleton singleton;

private Singleton() {}

public static Singleton getInstance() {

if (singleton == null) {

synchronized (Singleton.class) {

if (singleton == null) {

singleton = new Singleton(); // 参考代码第8行

}

}

}

return singleton;

}

}- 注意事项(WHY):

- private构造函数:以确保无法通过该类的构造函数来实例化该类的对象,只能通过该类提供的静态方法getInstance()来得到该类的唯一实例。

- private、static 、volatile关键字:其中volatile的作用是防止重排序

参考代码第8行有可能发生如下重排序。

重排序前

memory = allocate(); // 1. 分配对象的内存空间

ctorInstance(memory); // 2. 初始化对象

instance = memory; // 3. 设置instance指向刚分配的内存地址可能发生重排序后:

memory = allocate(); // 1. 分配对象的内存空间

instance = memory; // 3. 设置instance指向刚分配的内存地址

// 注意,此时对象还没有被初始化!

ctorInstance(memory); // 2. 初始化对象比如线程A在参考代码第8行执行了步骤1和步骤3,但步骤2还没有执行完

这时线程B执行到了第5行,判断sInstance不为空,就直接返回了一个未初始化完的sInstance

-

double check提高执行效率:

- 第1次判空:单例模式只需要创建一次实例,如果后面再次调用getInstance()时,则直接返回之前创建的实例,因此大部分时间不需要执行同步块里的代码,提高了性能

- 第2次判空:防止创建多个实例

-

synchronized块:保证线程安全

-

懒加载:延迟加载,只在getInstance()第一次被调用时才实例化

- 参考链接:

【写法二】

- 参考代码:

public class Singleton() {

private Singleton() {}

public static Singleton getInstance() {

return SingletonInstance.INSTANCE;

}

private static class SingletonInstance {

private final static Singleton INSTANCE = new Singleton();

}

}- 注意事项(WHY):

- private构造函数:作用同上

- 线程安全:静态内部类变量INSTANCE只会在第一次调用getInstance(),加载类SingletonInstance时初始化,保证了线程安全

- 懒加载:作用同上

5. 多线程更新list后,获取数据为空

关键: ArrayList 并不是线程安全

【案例】

代码场景:两个线程,两处代码,一处代码是Arraylist.add(),由线程1执行,另一处代码是ArrayList.get(),由线程2执行。发生空指针。

【分析】

How ? 线程如何调用才会导致出现箭头处的空指针呢??

估计是Add操作并不是原子操作,看下JDK的实现:

// java.util.ArrayList#add(E)

public boolean add(E e) {

ensureCapacityInternal(size + 1); // Increments modCount!!

elementData[size++] = e;

return true;

}出现了一个问题, 即操作的时候是先将size增加了1,还是先将值赋值进正确的位置?

看下Java字节码是如何执行的

- 首先准备demo代码

public class incre {

public void test() {

int[] list = new int[32];

int i = 8;

list[i++] = 10; // 主要看自增操作与赋值操作的先后顺序,直觉来说应该是自增

}

}- 编译并查看

javac Increment.java

javap -verbose Increment- 得到字节码的执行序列:

Classfile /D:/My Documents/Desktop/javademo/incre.class

Last modified 2020年4月22日; size 258 bytes

MD5 checksum aeecc843a0de5a71613407b83abf58cf

Compiled from "incre.java"

public class incre

minor version: 0

major version: 55

flags: (0x0021) ACC_PUBLIC, ACC_SUPER

this_class: #2 // incre

super_class: #3 // java/lang/Object

interfaces: 0, fields: 0, methods: 2, attributes: 1

Constant pool:

#1 = Methodref #3.#11 // java/lang/Object."<init>":()V

#2 = Class #12 // incre

#3 = Class #13 // java/lang/Object

#4 = Utf8 <init>

#5 = Utf8 ()V

#6 = Utf8 Code

#7 = Utf8 LineNumberTable

#8 = Utf8 test

#9 = Utf8 SourceFile

#10 = Utf8 incre.java

#11 = NameAndType #4:#5 // "<init>":()V

#12 = Utf8 incre

#13 = Utf8 java/lang/Object

{

public incre();

descriptor: ()V

flags: (0x0001) ACC_PUBLIC

Code:

stack=1, locals=1, args_size=1

0: aload_0

1: invokespecial #1 // Method java/lang/Object."<init>":()V

4: return

LineNumberTable:

line 1: 0

public void test();

descriptor: ()V

flags: (0x0001) ACC_PUBLIC

Code:

stack=3, locals=3, args_size=1

0: bipush 32

2: newarray int

4: astore_1

5: bipush 8 // 赋值 i = 8

7: istore_2

8: aload_1

9: iload_2

10: iinc 2, 1 // 自增 i++

13: bipush 10 // 赋值 = 10

15: iastore

16: return

LineNumberTable:

line 3: 0

line 4: 5

line 5: 8

line 6: 16

}

SourceFile: "incre.java"测试结论是先增加Size,再放元素进数组。

因此回到本案例,线程1 add 元素,执行到将size++ 后,CPU切成线程2执行,去取list.size(), 此时取到的是线程1 将Size增大1 的Size。但是元素并没有就位。线程2继续get元素,所以get到空了。

【修复】

- 将线程抛至同一个线程操作,使得其能同步处理

- 将ArrayList修改成线程安全的CopyOnWriteArrayList,保证数据的安全性

【结论】

- 多线程场景下,尽量使用线程安全的对象进行数据操作,如

vector,CopyOnWriteArrayList - 多线程场景下,需要考虑一下加锁,线程同步等措施,保证无稳定性的前提下,确保业务数据正确。

【参考链接】

- 读多写少的场景,使用基于synchronized修饰的vector效率就不高了,所以需要基于读写分离**实现的juc容器:并发容器之CopyOnWriteArrayList

【操作系统实验笔记】进程控制与GDB多线程调试

本文基于最基础的Linux下创建子进程的程序,了解GDB在多线程下的调试。

参考链接: 100个gdb小技巧

操作系统:Ubuntu 16.04/bash on ubuntu on windows

实验内容

编写一段程序,使用系统调用 fork( )创建两个子进程,在系统中有一个父进程和两个子进程 活动。让每个进程在屏幕上显示一个字符;父进程显示字符“a”,子进程分别显示字符“b” 和“c”。 试观察记录屏幕上的显示结果,并分析原因。

实现代码

#include

#include

int main(){

int p1,p2;

while((p1=fork())==-1);

if(p1==0)

putchar('b');

else {

while((p2=fork())==-1);

if(p2==0){

putchar('c');

printf("\n");

}

else putchar('a');

}

return 0;

}

其中,a、b、c 的显示顺序是随机的,取决与进程的调度顺序。fork()创建进程之后,各 个进程的时间片的获得不一定是顺序的,所以输出的顺序会变化。

GDB多进程调试

调试子进程

在调试多进程程序时,gdb 默认会追踪父进程。如果要调试子进程,要使用如下命 令:

set follow-fork-mode child

(gdb) set follow-fork-mode child

(gdb) start

Temporary breakpoint 1 at 0x40056e: file 1.c, line 5.

Starting program: /root/tst

Temporary breakpoint 1, main () at 1.c:5

5 while((p1=fork())==-1);

(gdb) n

[New process 24]

ac

[Switching to process 24]

main () at 1.c:6

6 if(p1==0)

(gdb)

7 putchar('b');

(gdb)

16 return 0;

(gdb)

17 }

(gdb)

__libc_start_main (main=0x400566 , argc=1, argv=0x7ffffffde398, init=,

fini=, rtld_fini=, stack_end=0x7ffffffde388)

at ../csu/libc-start.c:325

325 ../csu/libc-start.c: No such file or directory.

(gdb)

b[Inferior 2 (process 24) exited normally]

(gdb)

The program is not being run.

可以看到执行到第5行,父进程打印“a” 并创建了子进程 24,子进程打印“c”。正常退出后打印“b”。

(但这里是不是只监视了一个子进程24 ?)

同时调试父进程和子进程

如果要同时调试父进程和子进程,可以使用

set detach-on-fork off(默 认detach-on-fork是on)命令,这样 gdb 就能同时调试父子进程,并且在调试一 个进程时,另外一个进程处于挂起状态。在使用set detach-on-fork off命令 后,用i inferiors(i 是 info 命令缩写)查看进程状态,可以看到父子进程都 在被 gdb 调试的状态,前面显示“*”是正在调试的进程。当父进程退出后,用inferior infno切换到子进程去调试。

(gdb) set detach-on-fork off

(gdb) start

Reading symbols from /usr/lib/debug/lib/x86_64-linux-gnu/libc-2.23.so...done.

Reading symbols from /usr/lib/debug/lib/x86_64-linux-gnu/ld-2.23.so...done.

Reading symbols from /usr/lib/debug/lib/x86_64-linux-gnu/libc-2.23.so...done.

Reading symbols from /usr/lib/debug/lib/x86_64-linux-gnu/ld-2.23.so...done.

Temporary breakpoint 2 at 0x40056e: main. (3 locations)

Starting program: /root/tst

Thread 1.1 "tst" hit Temporary breakpoint 2, main () at 1.c:5

5 while((p1=fork())==-1);

(gdb) n

[New process 26]

6 if(p1==0)

(gdb) i inferior

Num Description Executable

* 1 process 25 /root/tst

2 process 23 /root/tst

3 process 24 /root/tst

4 process 26 /root/tst

(gdb) n

9 while((p2=fork())==-1);

(gdb)

[New process 27]

10 if(p2==0){

(gdb)

14 else putchar('a');

(gdb)

16 return 0;

(gdb)

17 }

(gdb)

__libc_start_main (main=0x400566 , argc=1, argv=0x7ffffffde398, init=,

fini=, rtld_fini=, stack_end=0x7ffffffde388)

at ../csu/libc-start.c:325

325 ../csu/libc-start.c: No such file or directory.

(gdb)

a[Inferior 1 (process 25) exited normally]

(gdb)

The program is not being run.

(gdb) inferior 2

[Switching to inferior 2 [process 23] (/root/tst)]

[Switching to thread 2.1 (process 23)]

#0 0x00007fffff0fc41a in __libc_fork () at ../sysdeps/nptl/fork.c:145

145 ../sysdeps/nptl/fork.c: No such file or directory.

(gdb)

[Switching to inferior 2 [process 23] (/root/tst)]

[Switching to thread 2.1 (process 23)]

#0 0x00007fffff0fc41a in __libc_fork () at ../sysdeps/nptl/fork.c:145

145 in ../sysdeps/nptl/fork.c

.

.

.

168 in ../sysdeps/nptl/fork.c

(gdb) bt

#0 __libc_fork () at ../sysdeps/nptl/fork.c:168

#1 0x0000000000400573 in main () at 1.c:5

(gdb) n

169 in ../sysdeps/nptl/fork.c

.

.

.

(gdb)

264 in ../sysdeps/nptl/fork.c

(gdb)

main () at 1.c:6

6 if(p1==0)

(gdb) i inferior

Num Description Executable

1 /root/tst

* 2 process 23 /root/tst

3 process 24 /root/tst

4 process 26 /root/tst

5 process 27 /root/tst

(gdb) inferior 3

[Switching to inferior 3 [process 24] (/root/tst)]

[Switching to thread 3.1 (process 24)]

#0 0x00007fffff0fc41a in __libc_fork () at ../sysdeps/nptl/fork.c:145

145 ../sysdeps/nptl/fork.c: No such file or directory.

(gdb) i inferior

Num Description Executable

1 /root/tst

2 process 23 /root/tst

* 3 process 24 /root/tst

4 process 26 /root/tst

5 process 27 /root/tst

(gdb) n

152 in ../sysdeps/nptl/fork.c

.

.

.

(gdb)

264 in ../sysdeps/nptl/fork.c

(gdb)

main () at 1.c:10

10 if(p2==0){

(gdb)

11 putchar('c');

(gdb)

12 printf("\n");

(gdb)

c

16 return 0;

(gdb)

17 }

(gdb)

__libc_start_main (main=0x400566 , argc=1, argv=0x7ffffffde398, init=,

fini=, rtld_fini=, stack_end=0x7ffffffde388)

at ../csu/libc-start.c:325

325 ../csu/libc-start.c: No such file or directory.

(gdb)

[Inferior 3 (process 24) exited normally]

(gdb)

7 putchar('b');

(gdb)

16 return 0;

(gdb)

17 }

(gdb)

__libc_start_main (main=0x400566 , argc=1, argv=0x7ffffffde398, init=,

fini=, rtld_fini=, stack_end=0x7ffffffde388)

at ../csu/libc-start.c:325

325 ../csu/libc-start.c: No such file or directory.

(gdb)

b[Inferior 2 (process 23) exited normally]

(gdb)

The program is not being run.

在使用“set detach-on-fork off”命令后,用“i inferiors”(i是info命令缩写)查看进程状态,可以看到父子进程都在被gdb调试的状态,前面显示“*”是正在调试的进程。当父进程退出后,用“inferior infno”切换到子进程去调试。

此外,如果想让父子进程都同时运行,可以使用“set schedule-multiple on”(默认schedule-multiple是off)命令,仍以上述代码为例:

(gdb) set detach-on-fork off

(gdb) set schedule-multiple on

(gdb) start

Temporary breakpoint 1 at 0x40056e: file 1.c, line 5.

Starting program: /root/tst

Temporary breakpoint 1, main () at 1.c:5

5 while((p1=fork())==-1);

(gdb) n

[New process 32]

b6 if(p1==0)

(gdb)

[Inferior 2 (process 32) exited normally]

(gdb)

9 while((p2=fork())==-1);

(gdb)

[New process 33]

c

10 if(p2==0){

(gdb)

[Inferior 3 (process 33) exited normally]

(gdb)

14 else putchar('a');

(gdb)

16 return 0;

(gdb)

17 }

(gdb)

__libc_start_main (main=0x400566 , argc=1, argv=0x7ffffffde398, init=, fini=,

rtld_fini=, stack_end=0x7ffffffde388) at ../csu/libc-start.c:325

325 ../csu/libc-start.c: No such file or directory.

(gdb)

a[Inferior 1 (process 28) exited normally]

(gdb)

The program is not being run.

父进程Inferior 1(process 28)创建Inferior 2(process 32)打印 b ,并正常退出;再创建Inferior 3(process 33)打印c,并正常退出,之后父进程打印a,退出。

总结

第一次上手GDB调试,有助于对进程控制的理解

【Java】《深入理解Java虚拟机》笔记 · 一 Java内存区域

一. Java内存区域

原书第二章

1. 运行时区域

原书2.2节

书上讲的很难理解,这里有一张图:Link1

- java堆(Heap):Heap区域被所有线程共享,用于存储对象实例。

- 方法区:被各个线程共享,用于存储已经被虚拟机加载的类型西、常量、静态变量等数据。

如果想查阅书上原文(P38-43),这篇博客 整理的很好。

2. 方法区和运行时常量池溢出

原书2.4.3节

书中进行了一个String.intern()返回引用的测试。

分别在JDK1.6和JDK1.7分别运行会产生不同的结果。产生差异的原因:JDK1.6中,intern()方法会把首次遇到的字符串实例复制到永久代上,返回的就是永久代上的实例引用,而StringBuilder创建的字符串实例在java堆上,所以两者不会是一个引用。

而在JDK1.7上intern()只是在常量池中记录首次出现的实例引用,也就是和StringBuilder创建的实例是同一个。

PermGen(永久代)

这里的 “PermGen space”其实指的就是方法区。不过方法区和“PermGen space”又有着本质的区别。前者是 JVM 的规范,而后者则是 JVM 规范的一种实现,并且只有 HotSpot 才有 “PermGen space”,而对于其他类型的虚拟机,如 JRockit(Oracle)、J9(IBM) 并没有“PermGen space”。由于方法区主要存储类的相关信息,所以对于动态生成类的情况比较容易出现永久代的内存溢出。最典型的场景就是,在 jsp 页面比较多的情况,容易出现永久代内存溢出。

Metaspace(元空间)

在 JDK 1.8 中, HotSpot 已经没有 “PermGen space”这个区间了,取而代之是一个叫做 Metaspace(元空间) 的东西。

元空间的本质和永久代类似,都是对JVM规范中方法区的实现。不过元空间与永久代之间最大的区别在于:元空间并不在虚拟机中,而是使用本地内存。因此,默认情况下,元空间的大小仅受本地内存限制。

参考链接

《深入理解Java虚拟机》读书笔记

《深入理解Java虚拟机》读书笔记1:Java技术体系、Java内存区域和内存溢出异常

《Java虚拟机原理图解》3、JVM运行时数据区

JVM内存结构---《深入理解Java虚拟机》学习总结

Java8内存模型—永久代(PermGen)和元空间(Metaspace)

【测试】与其感慨路难行,不如马上出发

【整理】知识图谱整理

一、算法

1. 贪心

- 一个n位的数,去掉其中的k位,问怎样去使得留下来的(n-k)位数按原来的前后顺序组成的数最小

思路:去除降序数列中的第一个 思路

2. 动态规划

-

你有很多硬币,面额为1,2,4,8,....,2^k,每种面额的硬币有两个,要求凑出n元来,输出不同的凑硬币方案的数目。

动态规划 -

最长回文子序列 dp 相反之后做LCS

for(int i=1;i<=X.length;i++){

for (int j=1;j<=Y.length;j++){

if(X[i-1]==Y[j-1]){

c[i][j] = c[i-1][j-1]+1;

}

else{

c[i][j] = max(c[i][j-1],c[i-1][j]);

}

}

}- 找零钱问题:

// 假设只有 1 分、 2 分、五分、 1 角、二角、 五角、 1 元的硬币。

// 在超市结账时,如果需要找零钱,收银员希望将最少的硬币数找给顾客。

// 那么,给定需要找的零钱数目,如何求得最少的硬币数呢?

public class zhaolingqian {

public int caldp(int n,int[] money){

// dp[i] 金额为i时找的零钱数目

int[] dp = new int[n + 5];

for (int i = 1; i<dp.length; i++){

dp[i] = Integer.MAX_VALUE; //!!!!!!!!!!!!

}

dp[0] = 0;

for (int i = 0; i < money.length; i++){

for (int j = money[i]; j <= n; j++){

dp[j] = Math.min(dp[j - money[i]] + 1 , dp[j]);

}

}

return dp[n];

}

public static void main(String[] args) {

int[] money = {1,2,5,10,20,50,100};

zhaolingqian zq = new zhaolingqian();

System.out.println(zq.caldp(625, money)); //8

}

}3. 排序算法

查找是在大量的信息中寻找一个特定的信息元素,在计算机应用中,查找是常用的基本运算,例如编译程序中符号表的查找。本文简单概括性的介绍了常见的七种查找算法,说是七种,其实二分查找、插值查找以及斐波那契查找都可以归为一类——插值查找。插值查找和斐波那契查找是在二分查找的基础上的优化查找算法。树表查找和哈希查找会在后续的博文中进行详细介绍。 >

查找定义:根据给定的某个值,在查找表中确定一个其关键字等于给定值的数据元素(或记录)。

查找算法分类:

- 静态查找和动态查找;

注:静态或者动态都是针对查找表而言的。动态表指查找表中有删除和插入操作的表。

- 无序查找和有序查找。

无序查找:被查找数列有序无序均可;

有序查找:被查找数列必须为有序数列。平均查找长度(Average Search Length,ASL):需和指定key进行比较的关键字的个数的期望值,称为查找算法在查找成功时的平均查找长度。

对于含有n个数据元素的查找表,查找成功的平均查找长度为:ASL = Pi*Ci的和。

Pi:查找表中第i个数据元素的概率。

Ci:找到第i个数据元素时已经比较过的次数。

不仅详细介绍了诸如树表查找、分块查找等查找方式,还引申了B树红黑树等数据结构的优缺点与使用场景

- O(N)查找有哪些数据结构?

- 答:顺序查找

- O(logN)查找有哪些数据结构?

- 答:二分查找、斐波那契查找、二叉查找树(最坏有O(n)的复杂度)、红黑树。

- O(1)查找有哪些数据结构?

- 答:hash(无冲突的情况)

- 其他:插值查找时间复杂度均为O(log2(log2n))。

堆排序

- 堆排序(使用大堆,升序)从基本实现原理来说也是一种选择排序。

- 所谓大根堆,就是根节点大于子节点的完全二叉树。

- 首先将所有元素都构建在一个初始堆中,并重建为大堆。这时当前堆中的最大元素就在堆的顶部,也就是数组a[0],这时将该最大元素与数组中的最后一个元素交换,使其移到最末尾,表明该元素已经到应该在得位置了,之后的堆重建也不需要管他,所以last--,对缩小后的目标堆重建。就这样,将顶端最大的元素与最后一个元素不断的交换,交换后又不断的调用堆以重新维持最大堆的性质,最后,一个一个的,从大到小的,把堆中的所有元素都清理掉,也就形成了一个有序的序列。这就是堆排序的全部过程。

#include <bits/stdc++.h>

using namespace std;

int a[100];

void rebuild(int a[], int size, int rt)

{

int left_child = 2*rt+1;

if(left_child < size)

{

int right_child = left_child+1;

if(right_child < size)

{

if(a[left_child] > a[right_child]) // < shengxu

left_child = right_child;

}

if(a[rt] > a[left_child]) // 用 < 代表大根堆 升序

{

swap(a[rt], a[left_child]);

rebuild(a, size, left_child);

}

//注意rebuild的if框

}

}

void heapSort(int a[], int size)

{

//第一步 构造初始堆

for(int i=size-1 ;i>=0 ;i--)

{

rebuild(a,size, i);

}

int last = size - 1;

for(int i=1; i<=size; i++, last--)

{

swap(a[0],a[last]);

rebuild(a,last, 0);//把最大的元素沉入堆底之后就可以不用管了,last--

}

}

int main()

{

int n;

cin>>n;

for(int i=0 ;i<n; i++)

{

cin>>a[i];

}

heapSort(a,n);

for(int i=0; i<n; i++)

cout<<a[i]<<" ";

cout<<endl;

return 0;

}- 快排

#include <bits/stdc++.h>

using namespace std;

int a[100],n;

void hqsort(int* a, int left, int right) {

if(left+1 >= right) return ;

int i = left, j = right-1, key = a[left];

while(i < j) {

while(i < j && key <= a[j]) j--;

a[i] = a[j];

while(i < j && a[i] <= key) i++;

a[j] = a[i];

}

a[i] = key;

hqsort(a, left, i);

hqsort(a, i+1, right);

}

int main()

{

cin>>n;

for(int i=0; i<n; i++)

{

cin>>a[i];

}

hqsort(a,0,n);

for(int i=0; i<n; i++)

{

cout<<a[i]<<" ";

}

return 0;

}-

不同条件下,排序方法的选择

- 若n较小(如n≤50),可采用直接插入或直接选择排序。

当记录规模较小时,直接插入排序较好;否则因为直接选择移动的记录数少于直接插人,应选直接选择排序为宜。 - 若文件初始状态基本有序(指正序),则应选用直接插人、冒泡或随机的快速排序为宜;

- 若n较大,则应采用时间复杂度为O(nlgn)的排序方法:快速排序、堆排序或归并排序。

- 快速排序是目前基于比较的内部排序中被认为是最好的方法,当待排序的关键字是随机分布时,快速排序的平均时间最短;

- 堆排序所需的辅助空间少于快速排序,并且不会出现快速排序可能出现的最坏情况。这两种排序都是不稳定的。

- 若要求排序稳定,则可选用归并排序。但本章介绍的从单个记录起进行两两归并的 排序算法并不值得提倡,通常可以将它和直接插入排序结合在一起使用。先利用直接插入排序求得较长的有序子文件,然后再两两归并之。因为直接插入排序是稳定 的,所以改进后的归并排序仍是稳定的。

优先队列通常用堆排序来实现

- 若n较小(如n≤50),可采用直接插入或直接选择排序。

4. 图论

图的遍历和图的连通性**

即BFS、DFS和Kruskal、Prim 算法

拓扑排序

由AOV网构造拓扑序列的拓扑排序算法主要是循环执行以下两步,直到不存在入度为0的顶点为止。

(1) 选择一个入度为0的顶点并输出之;

(2) 从网中删除此顶点及所有出边。

循环结束后,若输出的顶点数小于网中的顶点数,则输出“有回路”信息,否则输出的顶点序列就是一种拓扑序列。

5. 数据结构

5.1 栈

import java.util.Stack;

public class TwoStackQueue {

Stack<Integer> s1 = new Stack<>();

Stack<Integer> s2 = new Stack<>();

public static void main(String[] args) {

TwoStackQueue twoStackQueue = new TwoStackQueue();

twoStackQueue.push(1);

twoStackQueue.push(2);

System.out.println(twoStackQueue.pop());

}

private int pop() {

while(!s1.empty()){

s2.push(s1.pop());

}

int res = s2.pop();

//重新pop回去

while(!s2.empty()){

s1.push(s2.pop());

}

return res;

}

private void push(int i) {

s1.push(i);

}

}5.2 链表

- 链表反转

链接

//遍历反转法:递归反转法是从后往前逆序反转指针域的指向,而遍历反转法是从前往后反转各个结点的指针域的指向。

// 基本思路是:将当前节点cur的下一个节点 cur.getNext()缓存到temp后,然后更改当前节点指针指向上一结点pre。也就是说在反转当前结点指针指向前,先把当前结点的指针域用tmp临时保存,以便下一次使用,其过程可表示如下:

// pre:上一结点

// cur: 当前结点

// tmp: 临时结点,用于保存当前结点的指针域(即下一结点)

public class LinkedListReverse {

private void Display(Node node){

while (null != node){

System.out.println(node.getData() + " ");

node = node.getNext();

}

System.out.println("====");

}

private Node Reverse(Node head){

if (head == null)

return head;

Node pre = head;

Node cur = head.getNext();

Node tmp;

while(null != cur){

tmp = cur.getNext();

cur.setNext(pre);

pre = cur;

cur = tmp;

}

head.setNext(null);

return pre;

}

public static void main(String[] args) {

Node head = new Node(0);Node n1 = new Node(1);

Node n2 = new Node(2);Node n3 = new Node(3);

head.setNext(n1);n1.setNext(n2);

n2.setNext(n3);n3.setNext(null);

LinkedListReverse linkedListReverse = new LinkedListReverse();

linkedListReverse.Display(head);

Node rvs = linkedListReverse.Reverse(head);

linkedListReverse.Display(rvs);

}

}

class Node{

private int data;

private Node next;

}-

判断一个单链表是否有环

最常用方法:定义两个指针,同时从链表的头节点出发,一个指针一次走一步,另一个指针一次走两步。如果走得快的指针追上了走得慢的指针,那么链表就是环形链表;如果走得快的指针走到了链表的末尾(next指向 NULL)都没有追上第一个指针,那么链表就不是环形链表。 -

使用异或交换两个整数或者字符串

public static String reverse(String s){ char[] a = s.toCharArray(); int first = 0, last = a.length-1; while(first < last){ a[first] = (char)(a[first] ^ a[last]); a[last] = (char)(a[last] ^ a[first]); a[first] = (char)(a[last] ^ a[first]); first ++; last --; } return new String(a); }

5.3 树

- 红黑树

-

节点是红色或黑色。

-

根是黑色。

-

所有叶子都是黑色(叶子是NIL节点)。

-

每个红色节点必须有两个黑色的子节点。(从每个叶子到根的所有路径上不能有两个连续的红色节点。)

-

从任一节点到其每个叶子的所有简单路径都包含相同数目的黑色节点。

-

- 2-3 查找树需要用到 2- 节点和 3- 节点,红黑树使用红链接来实现 3- 节点。指向一个节点的链接颜色如果为红色,那么这个节点和上层节点表示的是一个 3- 节点,而黑色则是普通链接。

-

2-3查找树能保证在插入元素之后能保持树的平衡状态,最坏情况下即所有的子节点都是2-node,树的高度为lgN,从而保证了最坏情况下的时间复杂度。但是2-3树实现起来比较复杂,本文介绍一种简单实现2-3树的数据结构,即红黑树(Red-Black Tree)

-

红黑树的主要是想对2-3查找树进行编码,尤其是对2-3查找树中的3-nodes节点添加额外的信息。红黑树中将节点之间的链接分为两种不同类型,红色链接,他用来链接两个2-nodes节点来表示一个3-nodes节点。黑色链接用来链接普通的2-3节点。特别的,使用红色链接的两个2-nodes来表示一个3-nodes节点,并且向左倾斜,即一个2-node是另一个2-node的左子节点。这种做法的好处是查找的时候不用做任何修改,和普通的二叉查找树相同。

-

链接中还有动画演示。

-

5.4. 哈希表

-

哈希表就是一种以 键-值(key-indexed) 存储数据的结构,我们只要输入待查找的值即key,即可查找到其对应的值。

-

使用哈希查找有两个步骤:

- 使用哈希函数将被查找的键转换为数组的索引。在理想的情况下,不同的键会被转换为不同的索引值,但是在有些情况下我们需要处理多个键被哈希到同一个索引值的情况。所以哈希查找的第二个步骤就是处理冲突

- 处理哈希碰撞冲突。有很多处理哈希碰撞冲突的方法,本文后面会介绍拉链法和线性探测法。

-

实现哈希函数:以正整数与字符串为例

- 获取正整数哈希值最常用的方法是使用除留余数法。即对于大小为素数M的数组,对于任意正整数k,计算k除以M的余数。M一般取素数。

- 我们可以将组成字符串的每一个字符取值然后进行哈希

for (int i = 0; i < value.length; i++) {h = 31 * h + val[i];}

-

避免哈希冲突

- 拉链法:其实就是将冲突后的数据依次存入链表中。

- 线性探测法;开放寻址法中最简单的是线性探测法:当碰撞发生时即一个键的散列值被另外一个键占用时,直接检查散列表中的下一个位置即将索引值加1

6. 经典问题

Top k 问题

-

堆排序方法

按照堆排序的方法排序之后输出前K个即可。

时间复杂度

n*logK

适用场景

实现的过程中,我们先用前K个数建立了一个堆,然后遍历数组来维护这个堆。这种做法带来了三个好处:(1)不会改变数据的输入顺序(按顺序读的);(2)不会占用太多的内存空间(事实上,一次只读入一个数,内存只要求能容纳前K个数即可);(3)由于(2),决定了它特别适合处理海量数据。这三点,也决定了它最优的适用场景。

-

快排方法

用快排的partition**,对数组进行不断分治,使得基准点pos刚好在K-1的位置上,此时前面的K个数字(0,K-1)就是要找的前K个数。

时间复杂度

n适用场景

对照着堆排的解法来看,partition函数会不断地交换元素的位置,所以它肯定会改变数据输入的顺序;既然要交换元素的位置,那么所有元素必须要读到内存空间中,所以它会占用比较大的空间,至少能容纳整个数组;数据越多,占用的空间必然越大,海量数据处理起来相对吃力。但是,它的时间复杂度很低,意味着数据量不大时,效率极高。

string 反转

除了普通的交换,还可以用异或的方法减少空间复杂度。

public static String reverse(String s){

char[] a = s.toCharArray();

int first = 0, last = a.length-1;

while(first < last){

a[first] = (char)(a[first] ^ a[last]);

a[last] = (char)(a[last] ^ a[first]);

a[first] = (char)(a[last] ^ a[first]);

first ++;

last --;

}

return new String(a);

}7. 大数据相关

二、操作系统

1. 进程与线程

进程是资源分配的基本单位。

进程控制块 (Process Control Block, PCB) 描述进程的基本信息和运行状态,所谓的创建进程和撤销进程

1.1 进程与线程的区别

- 线程是独立调度的基本单位。

- 一个进程中可以有多个线程,它们共享进程资源。

进程和线程的主要差别在于它们是不同的操作系统资源管理方式。进程有独立的地址空间,一个进程崩溃后,在保护模式下不会对其它进程产生影响,而线程只是一个进程中的不同执行路径。线程有自己的堆栈和局部变量,但线程之间没有单独的地址空间,一个线程死掉就等于整个进程死掉,所以多进程的程序要比多线程的程序健壮,但在进程切换时,耗费资源较大,效率要差一些。但对于一些要求同时进行并且又要共享某些变量的并发操作,只能用线程,不能用进程。

例:QQ 和浏览器是两个进程,浏览器进程里面有很多线程,例如 HTTP 请求线程、事件响应线程、渲染线程等等,线程的并发执行使得在浏览器中点击一个新链接从而发起 HTTP 请求时,浏览器还可以响应用户的其它事件。

进程和线程的区别?

- 线程里面有什么是独立的

栈:是个线程独有的,保存其运行状态和局部自动变量的。栈在线程开始的时候初始化,每个线程的栈互相独立,因此,栈是 thread safe的。操作系统在切换线程的时候会自动的切换栈,就是切换 SS/ESP寄存器。

线程独享资源:程序计数器,寄存器,栈,状态字.

1.2 并发与并行的区别

并发和并行的区别就是一个处理器同时处理多个任务和多个处理器或者是多核的处理器同时处理多个不同的任务。

前者是逻辑上的同时发生(simultaneous),而后者是物理上的同时发生.

2. 进程

2.1 现代操作系统的进程内存分布

一个linux进程分为几个部分(从一个进程的地址空间的低地址向高地址增长):

- text段,就是存放代码,可读可执行不可写,也称为正文段,代码段。

- data段,存放已初始化的全局变量和已初始化的static变量(不管是局部static变量还是全局static变量)

- bss段,存放全局未初始化变量和未初始化的static变量(也是不区分局部还是全局static变量)

以上这3部分是确定的,也就是不同的程序,以上3部分的大小都各不相同,因程序而异,若未初始化的全局变量定义的多了,那么bss区就大点,反之则小点。 - heap,也就是堆,堆在进程空间中是自低地址向高地址增长,你在程序中通过动态申请得到的内存空间(c中一般为malloc/free,c++中一般为new/delete),就是在堆中动态分配的。

- stack,栈,程序中每个函数中的局部变量,都是存放在栈中,栈是自高地址向低地址增长的。起初,堆和栈之间有很大一段空间,然后随着,程序的运行,堆不断向高地址增长,栈不断向高地址增长,这样,堆跟栈之间的空间总有一个最大界限,超过这个最大界限,就会出现堆跟栈重叠,就会出错,所以一般来说,Linux下的进程都有其最大空间的。

- 再往上,也就是一个进程地址空间的顶部,存放了命令行参数和环境变量。

2.2 Linux进程的状态转换图

-

运行状态(TASK_RUNNING)

当进程正在被CPU执行,或已经准备就绪随时可由调度程序执行,则称该进程为处于运行状态(running)。进程可以在内核态运行,也可以在用户态运行。当系统资源已经可用时,进程就被唤醒而进入准备运行状态,该状态称为就绪态。这些状态(图中中间一列)在内核中表示方法相同,都被成为处于TASK_RUNNING状态。

-

可中断睡眠状态(TASK_INTERRUPTIBLE)

当进程处于可中断等待状态时,系统不会调度该进程执行。当系统产生一个中断或者释放了进程正在等待的资源,或者进程收到一个信号,都可以唤醒进程转换到就绪状态(运行状态)。

-

不可中断睡眠状态(TASK_UNINTERRUPTIBLE)

与可中断睡眠状态类似。但处于该状态的进程只有被使用wake_up()函数明确唤醒时才能转换到可运行的就绪状态。

-

暂停状态(TASK_STOPPED)

当进程收到信号SIGSTOP、SIGTSTP、SIGTTIN或SIGTTOU时就会进入暂停状态。可向其发送SIGCONT信号让进程转换到可运行状态。在Linux 0.11中,还未实现对该状态的转换处理。处于该状态的进程将被作为进程终止来处理。

-

僵死状态(TASK_ZOMBIE)

当进程已停止运行,但其父进程还没有询问其状态时,则称该进程处于僵死状态。

当一个进程的运行时间片用完,系统就会使用调度程序强制切换到其它的进程去执行。另外,如果进程在内核态执行时需要等待系统的某个资源,此时该进程就会调用sleep_on()或sleep_on_interruptible()自愿地放弃CPU的使用权,而让调度程序去执行其它进程。进程则进入睡眠状态(TASK_UNINTERRUPTIBLE或TASK_INTERRUPTIBLE)。

只有当进程从“内核运行态”转移到“睡眠状态”时,内核才会进行进程切换操作。在内核态下运行的进程不能被其它进程抢占,而且一个进程不能改变另一个进程的状态。为了避免进程切换时造成内核数据错误,内核在执行临界区代码时会禁止一切中断。

2.3 孤儿进程,僵尸进程

-

孤儿进程

一个父进程退出,而它的一个或多个子进程还在运行,那么这些子进程将成为孤儿进程。孤儿进程将被 init 进程(进程号为 1)所收养,并由 init 进程对它们完成状态收集工作。

由于孤儿进程会被 init 进程收养,所以孤儿进程不会对系统造成危害。

-

僵死进程

一个子进程的进程描述符在子进程退出时不会释放,只有当父进程通过 wait 或 waitpid 获取了子进程信息后才会释放。如果子进程退出,而父进程并没有调用 wait 或 waitpid,那么子进程的进程描述符仍然保存在系统中,这种进程称之为僵死进程。

通过 ps 命令显示出来的状态为 Z。

系统所能使用的进程号是有限的,如果大量的产生僵死进程,将因为没有可用的进程号而导致系统不能产生新的进程。

要消灭系统中大量的僵死进程,只需要将其父进程杀死,此时所有的僵死进程就会变成孤儿进程,从而被 init 所收养,这样 init 就会释放所有的僵死进程所占有的资源,从而结束僵死进程。

2.4 进程间通信方式

- 同一主机上的进程通信方式

- UNIX进程间通信方式: 包括管道(PIPE), 有名管道(FIFO), 和信号(Signal)

- System V进程通信方式:包括信号量(Semaphore), 消息队列(Message Queue), 和共享内存(Shared Memory)

- 网络主机间的进程通信方式

- RPC: Remote Procedure Call 远程过程调用

- Socket: 当前最流行的网络通信方式, 基于TCP/IP协议的通信方式.

- 各自的特点如下:

- 管道(PIPE):管道是一种半双工的通信方式,数据只能单向流动,而且只能在 具有亲缘关系(父子进程)的进程间使用 。另外管道传送的是无格式的字节流,并且管道缓冲区的大小是有限的(管道缓冲区存在于内存中,在管道创建时,为缓冲区分配一个页面大小)。

- 有名管道 (FIFO): 有名管道也是半双工的通信方式,但是它允许无亲缘关系进程间的通信。

- 信号(Signal): 信号是一种比较复杂的通信方式,用于通知接收进程某个事件已经发生。

- 信号量(Semaphore):信号量是一个计数器,可以用来控制多个进程对共享资源的访问。它常作为一种锁机制,防止某进程正在访问共享资源时,其他进程也访问该资源。因此,主要作为进程间以及同一进程内不同线程之间的同步手段。

- 消息队列(Message Queue):消息队列是由消息的链表,存放在内核中并由消息队列标识符标识。消息队列克服了信号传递信息少、管道只能承载无格式字节流以及缓冲区大小受限等缺点。

- 共享内存(Shared Memory ):共享内存就是映射一段能被其他进程所访问的内存,这段共享内存由一个进程创建,但多个进程都可以访问。共享内存是最快的 IPC 方式,它是针对其他进程间通信方式运行效率低而专门设计的。它往往与其他通信机制,如信号量,配合使用,来实现进程间的同步和通信。

- 套接字(Socket): 套解口也是一种进程间通信机制,与其他通信机制不同的是,它可用于不同主机间的进程通信。

2.4.1 管道(TODO)

2.4.2 信号量、互斥体和自旋锁(TODO)

2.5 进程间如何同步(Synchronization)

-

进程的互斥、同步、通信都是基于这两种基本关系而存在的,为了解决进程间竞争关系(间接制约关系)而引入进程互斥;为了解决进程间松散的协作关系( 直接制约关系)而引入进程同步;为了解决进程间紧密的协作关系而引入进程通信。

-

某些进程为完成同一任务需要分工协作,由于合作的每一个进程都是独立地以不可预知的速度推进,这就需要相互协作的进程在某些协调点上协 调各自的工作。当合作进程中的一个到达协调点后,在尚未得到其伙伴进程发来的消息或信号之前应阻塞自己,直到其他合作进程发来协调信号或消息后方被唤醒并继续执行。这种协作进程之间相互等待对方消息或信号的协调关系称为进程同步。

-

进程的同步(Synchronization)是解决进程间协作关系( 直接制约关系) 的手段。进程同步指两个以上进程基于某个条件来协调它们的活动。一个进程的执行依赖于另一

个协作进程的消息或信号,当一个进程没有得到来自于另一个进程的消息或信号时则需等待,直到消息或信号到达才被唤醒。 -

不难看出,进程互斥关系是一种特殊的进程同步关系,即逐次使用互斥共享资源,也是对进程使用资源次序上的一种协调。

-

进程同步的方法

-

Linux下

- Linux 下常见的进程同步方法有:SysVIPC 的 sem(信号量)、file locking / record locking(通过 fcntl 设定的文件锁、记录锁)、futex(基于共享内存的快速用户态互斥锁)。针对线程(pthread)的还有 pthread_mutex 和 pthread_cond(条件变量)。

- Linux 下常见的进程通信的方法有 :pipe(管道),FIFO(命名管道),socket(套接字),SysVIPC 的 shm(共享内存)、msg queue(消息队列),mmap(文件映射)。以前还有 STREAM,不过现在比较少见了(好像)。

-

Windows下