upan / cheat-sheet Goto Github PK

View Code? Open in Web Editor NEW常用工具和开源项目链接收藏

常用工具和开源项目链接收藏

这些新特性涉及的范围包括:字符集、语法、索引、JSON、从 MySQL 5.7 升级到 MySQL 8.0 需要注意的不兼容项、参数、Hint等。

默认字符集由 latin1 调整为 utf8mb4。

在 MySQL 8.0 中,utf8mb4 默认的校对集是 utf8mb4_0900_ai_ci,在 MySQL 5.7 中则是 utf8mb4_general_ci。

utf8mb4_0900_ai_ci 中的 0900 指的是 Unicode 9.0 规范,ai 是 accent insensitivity 的缩写,指的是不区分音调,ci 是 case insensitivity 的缩写,指的是不区分大小写。

CTE,简单来说,就是一个命名的临时结果集。

只需定义一次,即可多次使用。

使用 CTE 不仅让 SQL 语句变得简洁,同时也提升了 SQL 语句的可读性。

# 普通的公用表表达式

WITH

cte1 AS (SELECT a, b FROM table1),

cte2 AS (SELECT c, d FROM table2)

SELECT b, d FROM cte1 JOIN cte2

WHERE cte1.a = cte2.c;

# 递归公用表表达式

WITH RECURSIVE cte (n) AS

(

SELECT 1

UNION ALL

SELECT n + 1 FROM cte WHERE n < 5

)

SELECT * FROM cte;

窗口函数,也称为分析函数,可针对一组行进行计算,并为每行返回一个结果。

这一点与聚合函数不同。聚合函数只能为每个分组返回一个结果。

窗口函数中的 OVER 子句定义了所要计算行的行窗口。

看下面这个示例,都是为了实现行号,只不过在 MySQL 8.0 之前,需借助于自定义变量,而在 MySQL 8.0 中,可以直接使用 ROW_NUMBER()。

# MySQL 5.7

SET @row_number = 0;

SELECT dept_no, dept_name,

(@row_number:=@row_number + 1) AS row_num

FROM departments ORDER BY dept_no;

# MySQL 8.0

SELECT dept_no, dept_name,

ROW_NUMBER() OVER (ORDER BY dept_no) AS row_num

FROM departments;

下面是官方文档中的一个示例。

CREATE TABLE t1 (

# 文本默认值

i INT DEFAULT 0,

c VARCHAR(10) DEFAULT '',

# 表达式默认值

f FLOAT DEFAULT (RAND() * RAND()),

b BINARY(16) DEFAULT (UUID_TO_BIN(UUID())),

d DATE DEFAULT (CURRENT_DATE + INTERVAL 1 YEAR),

p POINT DEFAULT (Point(0,0)),

j JSON DEFAULT (JSON_ARRAY())

);

注意,表达式默认值必须放到括号内。

从 MySQL 8.0.13 开始,BLOB, TEXT, GEOMETRY 和 JSON 字段允许设置表达式默认值。例如,

CREATE TABLE t2 (b BLOB DEFAULT ('abc'));

看下面这个示例。

CREATE TABLE t1

(

c1 INT CHECK (c1 > 10),

c2 INT CONSTRAINT c2_positive CHECK (c2 > 0),

c3 INT CHECK (c3 < 100),

CONSTRAINT c1_nonzero CHECK (c1 <> 0),

CHECK (c1 > c3)

);

mysql> SHOW CREATE TABLE t1\G

*************************** 1. row ***************************

Table: t1

Create Table: CREATE TABLE `t1` (

`c1` int DEFAULT NULL,

`c2` int DEFAULT NULL,

`c3` int DEFAULT NULL,

CONSTRAINT `c1_nonzero` CHECK ((`c1` <> 0)),

CONSTRAINT `c2_positive` CHECK ((`c2` > 0)),

CONSTRAINT `t1_chk_1` CHECK ((`c1` > 10)),

CONSTRAINT `t1_chk_2` CHECK ((`c3` < 100)),

CONSTRAINT `t1_chk_3` CHECK ((`c1` > `c3`))

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4 COLLATE=utf8mb4_0900_ai_ci

1 row in set (0.00 sec)

隐藏列是 MySQL 8.0.23 引入的新特性。对于隐藏列,只有显式指定才能访问。无论是在查询,还是 DML 语句中。

如果是通过 SELECT * 查询,则不会返回隐藏列的内容。

mysql> CREATE TABLE t1 (c1 INT, c2 INT INVISIBLE);

Query OK, 0 rows affected (0.03 sec)

mysql> INSERT INTO t1 (c1, c2) VALUES(1, 2);

Query OK, 1 row affected (0.01 sec)

mysql> INSERT INTO t1 VALUES(3);

Query OK, 1 row affected (0.00 sec)

mysql> SELECT * FROM t1;

+------+

| c1 |

+------+

| 1 |

| 3 |

+------+

2 rows in set (0.00 sec)

mysql> SELECT c1, c2 FROM t1;

+------+------+

| c1 | c2 |

+------+------+

| 1 | 2 |

| 3 | NULL |

+------+------+

2 rows in set (0.00 sec)

对于冗余索引,在执行删除操作之前,可以先将它设置为不可见,然后观察一段时间,确定对业务没有影响再执行删除操作。

# 创建不可见索引

ALTER TABLE t1 ADD INDEX k_idx (k) INVISIBLE;

# 将索引设置为不可见

ALTER TABLE t1 ALTER INDEX i_idx INVISIBLE;

# 将索引设置为可见

ALTER TABLE t1 ALTER INDEX i_idx VISIBLE;

优化器默认不会使用不可见索引。如果要使用,可设置 optimizer_switch。

SET SESSION optimizer_switch='use_invisible_indexes=on';

SELECT /*+ SET_VAR(optimizer_switch = 'use_invisible_indexes=on') */ * FROM t1 WHERE k = 1;

对于涉及到多列,但排序顺序又不一致的排序操作,可以通过降序索引来优化。

如 ORDER BY c1 ASC, c2 DESC 这个排序操作就可以通过下面这个索引来优化。

ALTER TABLE t add INDEX idx_1 (c1 ASC, c2 DESC);

函数索引允许对表达式创建索引,在此之前,只能对列或列的前缀创建索引。

CREATE TABLE tbl (

col1 LONGTEXT,

INDEX idx1 ((SUBSTRING(col1, 1, 10)))

);

# 对查询列使用相同的函数,可以使用索引

mysql> EXPLAIN SELECT * FROM tbl WHERE SUBSTRING(col1, 1, 10) = '1234567890';

+----+-------------+-------+------------+------+---------------+------+---------+-------+------+----------+-------+

| id | select_type | table | partitions | type | possible_keys | key | key_len | ref | rows | filtered | Extra |

+----+-------------+-------+------------+------+---------------+------+---------+-------+------+----------+-------+

| 1 | SIMPLE | tbl | NULL | ref | idx1 | idx1 | 33 | const | 1 | 100.00 | NULL |

+----+-------------+-------+------------+------+---------------+------+---------+-------+------+----------+-------+

1 row in set, 1 warning (0.00 sec)

VALUES 是 MySQL 8.0.19 开始支持的语法,它会以表的形式返回一行或多行数据。

行数据通过 ROW() 函数来构造。函数中的元素既可以是标量值,也可以是表达式。

列名是 column_x,其中,x 是序号,从 0 开始递增。

mysql> VALUES ROW(1,now()), ROW(2,now());

+----------+---------------------+

| column_0 | column_1 |

+----------+---------------------+

| 1 | 2022-12-13 11:01:40 |

| 2 | 2022-12-13 11:01:40 |

+----------+---------------------+

2 rows in set (0.00 sec)

MySQL 8.0.31 开始支持 INTERSECT 和 EXCEPT,分别用来取两个集合的交集和差集。

mysql> VALUES ROW(1,2), ROW(3,4) INTERSECT VALUES ROW(1,2);

+----------+----------+

| column_0 | column_1 |

+----------+----------+

| 1 | 2 |

+----------+----------+

1 row in set (0.00 sec)

mysql> VALUES ROW(1,2), ROW(3,4) EXCEPT VALUES ROW(1,2);

+----------+----------+

| column_0 | column_1 |

+----------+----------+

| 3 | 4 |

+----------+----------+

1 row in set (0.00 sec)

唯一键冲突的报错信息会输出表名,在 MySQL 5.7 中,只会输出唯一键名。

# MySQL 8.0

ERROR 1062 (23000): Duplicate entry '1' for key 't1.PRIMARY'

# MySQL 5.7

ERROR 1062 (23000): Duplicate entry '1' for key 'PRIMARY'

查询改写插件在 MySQL 8.0.12 之前只支持 SELECT 语句,从 MySQL 8.0.12 开始支持 INSERT,REPLACE,UPDATE 和 DELETE 语句。

JSON 字段支持部分更新,极大提升了 JSON 字段的处理性能。

看下面这个测试结果。

JSON 的具体用法可参考:一文说透 MySQL JSON 数据类型

SELECT ... FOR SHARE 和 SELECT ... FOR UPDATE 语句中引入 NOWAIT 和 SKIP LOCKED 选项,用来解决电商场景热点行问题。

session1> CREATE TABLE t(id INT PRIMARY KEY);

Query OK, 0 rows affected (0.06 sec)

session1> INSERT INTO t VALUES(1),(2),(3);

Query OK, 3 rows affected (0.01 sec)

Records: 3 Duplicates: 0 Warnings: 0

session1> BEGIN;

Query OK, 0 rows affected (0.00 sec)

session1> SELECT * FROM t WHERE id=2 FOR UPDATE;

+----+

| id |

+----+

| 2 |

+----+

1 row in set (0.00 sec)

# 如果需要加锁的行被其它事务锁定,指定 NOWAIT 会立即报错,不会等到锁超时

session2> SELECT * FROM t WHERE id = 2 FOR UPDATE NOWAIT;

ERROR 3572 (HY000): Statement aborted because lock(s) could not be acquired immediately and NOWAIT is set.

# 指定 SKIP LOCKED 则会跳过锁定行

session2> SELECT * FROM t FOR UPDATE SKIP LOCKED;

+----+

| id |

+----+

| 1 |

| 3 |

+----+

2 rows in set (0.00 sec)

不再支持 GROUP BY ASC/DESC 语法。例如,

GROUP BY dept_no ASC;

如果要对分组列进行排序,需显式指定排序列,例如,

GROUP BY dept_no ORDER BY dept_no;

通用的分区接口(Handler)已从代码层移除。

在 MySQL 8.0 中,如果要使用分区表,只能使用 InnoDB 存储引擎。

在 MySQL 8.0 中,正则表达式底层库由 Henry Spencer 调整为了 International Components for Unicode (ICU)。Spencer 库的部分语法不再支持。

两者用法上的具体差异可参考:不可不知的 MySQL 升级利器及 5.7 升级到 8.0 的注意事项

引入了 sql_require_primary_key 参数可强制要求表上必须存在主键。默认为 OFF。

mysql> CREATE TABLE slowtech.t1(id INT);

ERROR 3750 (HY000): Unable to create or change a table without a primary key, when the system variable 'sql_require_primary_key' is set. Add a primary key to the table or unset this variable to avoid this message. Note that tables without a primary key can cause performance problems in row-based replication, so please consult your DBA before changing this setting.

在 MySQL 8.0.30 中,引入了 sql_generate_invisible_primary_key 参数可为没有显式设置主键的表创建一个隐式主键。默认为 OFF。

看下面这个示例。

mysql> CREATE TABLE t1(c1 INT);

Query OK, 0 rows affected (0.04 sec)

mysql> SHOW CREATE TABLE t1\G

*************************** 1. row ***************************

Table: t1

Create Table: CREATE TABLE `t1` (

`my_row_id` bigint unsigned NOT NULL AUTO_INCREMENT /*!80023 INVISIBLE */,

`c1` int DEFAULT NULL,

PRIMARY KEY (`my_row_id`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4 COLLATE=utf8mb4_0900_ai_ci

1 row in set (0.01 sec)

引入了多个 Hint。

在 MySQL 5.7 中,Hint 只有 13 个。在 MySQL 8.0 中,则新增到了 37 个。

新增的 Hint 中,其中一个是 SET_VAR,可在语句级别调整参数的会话值。例如,

SELECT /*+ SET_VAR(max_execution_time = 1000) */ * FROM employees.employees;

mysql> CREATE TABLE t_parent (id INT PRIMARY KEY);

Query OK, 0 rows affected (0.04 sec)

mysql> CREATE TABLE t_child (id INT PRIMARY KEY, parent_id INT, FOREIGN KEY (parent_id) REFERENCES t_parent(ID));

Query OK, 0 rows affected (0.04 sec)

mysql> INSERT INTO t_child VALUES(1,1);

ERROR 1452 (23000): Cannot add or update a child row: a foreign key constraint fails (`slowtech`.`t_child`, CONSTRAINT `t_child_ibfk_1` FOREIGN KEY (`parent_id`) REFERENCES `t_parent` (`id`))

mysql> INSERT /*+ SET_VAR(foreign_key_checks = OFF) */ INTO t_child VALUES(1,1);

Query OK, 1 row affected (0.01 sec)

收录于合集 #MySQL

你的项目或许已经使用 Redis 很长时间了,但在使用过程中,你可能还会或多或少地遇到以下问题:

尤其是当你的项目越来越依赖 Redis 时,这些问题就变得尤为重要。

此时,你迫切需要一份**「最佳实践指南」**。

这篇文章,我将从以下七个维度,带你「全面」分析 Redis 的最佳实践优化:

在文章的最后,我还会给你一个完整的最佳实践清单,不管你是业务开发人员,还是 DBA 运维人员,这个清单将会帮助你更加「优雅」地用好 Redis。

这篇文章干货很多,希望你可以耐心读完。

首先,我们来看一下 Redis 内存方面的优化。

众所周知,Redis 的性能之所以如此之高,原因就在于它的数据都存储在「内存」中,所以访问 Redis 中的数据速度极快。

但从资源利用率层面来说,机器的内存资源相比于磁盘,还是比较昂贵的。

当你的业务应用在 Redis 中存储数据很少时,你可能并不太关心内存资源的使用情况。但随着业务的发展,你的业务存储在 Redis 中的数据就会越来越多。

如果没有提前制定好内存优化策略,那么等业务开始增长时,Redis 占用的内存也会开始膨胀。

所以,提前制定合理的内存优化策略,对于资源利用率的提升是很有必要的。

那在使用 Redis 时,怎样做才能更节省内存呢?这里我给你总结了 6 点建议,我们依次来看:

1) 控制 key 的长度

最简单直接的内存优化,就是控制 key 的长度。

在开发业务时,你需要提前预估整个 Redis 中写入 key 的数量,如果 key 数量达到了百万级别,那么,过长的 key 名也会占用过多的内存空间。

所以,你需要保证 key 在简单、清晰的前提下,尽可能把 key 定义得短一些。

例如,原有的 key 为 user:book:123,则可以优化为 u:bk:123。

这样一来,你的 Redis 就可以节省大量的内存,这个方案对内存的优化非常直接和高效。

2) 避免存储 bigkey

除了控制 key 的长度之外,你同样需要关注 value 的大小,如果大量存储 bigkey,也会导致 Redis 内存增长过快。

除此之外,客户端在读写 bigkey 时,还有产生性能问题(下文会具体详述)。

所以,你要避免在 Redis 中存储 bigkey,我给你的建议是:

3) 选择合适的数据类型

Redis 提供了丰富的数据类型,这些数据类型在实现上,也对内存使用做了优化。具体来说就是,一种数据类型对应多种数据结构来实现:

例如,String、Set 在存储 int 数据时,会采用整数编码存储。Hash、ZSet 在元素数量比较少时(可配置),会采用压缩列表(ziplist)存储,在存储比较多的数据时,才会转换为哈希表和跳表。

作者这么设计的原因,就是为了进一步节约内存资源。

那么你在存储数据时,就可以利用这些特性来优化 Redis 的内存。这里我给你的建议如下:

4) 把 Redis 当作缓存使用

Redis 数据存储在内存中,这也意味着其资源是有限的。你在使用 Redis 时,要把它当做缓存来使用,而不是数据库。

所以,你的应用写入到 Redis 中的数据,尽可能地都设置「过期时间」。

业务应用在 Redis 中查不到数据时,再从后端数据库中加载到 Redis 中。

采用这种方案,可以让 Redis 中只保留经常访问的「热数据」,内存利用率也会比较高。

5) 实例设置 maxmemory + 淘汰策略

虽然你的 Redis key 都设置了过期时间,但如果你的业务应用写入量很大,并且过期时间设置得比较久,那么短期间内 Redis 的内存依旧会快速增长。

如果不控制 Redis 的内存上限,也会导致使用过多的内存资源。

对于这种场景,你需要提前预估业务数据量,然后给这个实例设置 maxmemory 控制实例的内存上限,这样可以避免 Redis 的内存持续膨胀。

配置了 maxmemory,此时你还要设置数据淘汰策略,而淘汰策略如何选择,你需要结合你的业务特点来决定:

6) 数据压缩后写入 Redis

以上方案基本涵盖了 Redis 内存优化的各个方面。

如果你还想进一步优化 Redis 内存,你还可以在业务应用中先将数据压缩,再写入到 Redis 中(例如采用 snappy、gzip 等压缩算法)。

当然,压缩存储的数据,客户端在读取时还需要解压缩,在这期间会消耗更多 CPU 资源,你需要根据实际情况进行权衡。

以上就是「节省内存资源」方面的实践优化,是不是都比较简单?

下面我们来看「性能」方面的优化。

当你的系统决定引入 Redis 时,想必看中它最关键的一点就是:性能。

我们知道,一个单机版 Redis 就可以达到 10W QPS,这么高的性能,也意味着如果在使用过程中发生延迟情况,就会与我们的预期不符。

所以,在使用 Redis 时,如何持续发挥它的高性能,避免操作延迟的情况发生,也是我们的关注焦点。

在这方面,我给你总结了 13 条建议:

1) 避免存储 bigkey

存储 bigkey 除了前面讲到的使用过多内存之外,对 Redis 性能也会有很大影响。

由于 Redis 处理请求是单线程的,当你的应用在写入一个 bigkey 时,更多时间将消耗在「内存分配」上,这时操作延迟就会增加。同样地,删除一个 bigkey 在「释放内存」时,也会发生耗时。

而且,当你在读取这个 bigkey 时,也会在「网络数据传输」上花费更多时间,此时后面待执行的请求就会发生排队,Redis 性能下降。

所以,你的业务应用尽量不要存储 bigkey,避免操作延迟发生。

如果你确实有存储 bigkey 的需求,你可以把 bigkey 拆分为多个小 key 存储。

2) 开启 lazy-free 机制

如果你无法避免存储 bigkey,那么我建议你开启 Redis 的 lazy-free 机制。(4.0+版本支持)

当开启这个机制后,Redis 在删除一个 bigkey 时,释放内存的耗时操作,将会放到后台线程中去执行,这样可以在最大程度上,避免对主线程的影响。

3) 不使用复杂度过高的命令

Redis 是单线程模型处理请求,除了操作 bigkey 会导致后面请求发生排队之外,在执行复杂度过高的命令时,也会发生这种情况。

因为执行复杂度过高的命令,会消耗更多的 CPU 资源,主线程中的其它请求只能等待,这时也会发生排队延迟。

所以,你需要避免执行例如 SORT、SINTER、SINTERSTORE、ZUNIONSTORE、ZINTERSTORE 等聚合类命令。

对于这种聚合类操作,我建议你把它放到客户端来执行,不要让 Redis 承担太多的计算工作。

4) 执行 O(N) 命令时,关注 N 的大小

规避使用复杂度过高的命令,就可以高枕无忧了么?

答案是否定的。

当你在执行 O(N) 命令时,同样需要注意 N 的大小。

如果一次性查询过多的数据,也会在网络传输过程中耗时过长,操作延迟变大。

所以,对于容器类型(List/Hash/Set/ZSet),在元素数量未知的情况下,一定不要无脑执行 LRANGE key 0 -1 / HGETALL / SMEMBERS / ZRANGE key 0 -1。

在查询数据时,你要遵循以下原则:

5) 关注 DEL 时间复杂度

你没看错,在删除一个 key 时,如果姿势不对,也有可能影响到 Redis 性能。

删除一个 key,我们通常使用的是 DEL 命令,回想一下,你觉得 DEL 的时间复杂度是多少?

O(1) ?其实不一定。

当你删除的是一个 String 类型 key 时,时间复杂度确实是 O(1)。

但当你要删除的 key 是 List/Hash/Set/ZSet 类型,它的复杂度其实为 O(N),N 代表元素个数。

也就是说,删除一个 key,其元素数量越多,执行 DEL 也就越慢!

原因在于,删除大量元素时,需要依次回收每个元素的内存,元素越多,花费的时间也就越久!

而且,这个过程默认是在主线程中执行的,这势必会阻塞主线程,产生性能问题。

那删除这种元素比较多的 key,如何处理呢?

我给你的建议是,分批删除:

没想到吧?一个小小的删除操作,稍微不小心,也有可能引发性能问题,你在操作时需要格外注意。

6) 批量命令代替单个命令

当你需要一次性操作多个 key 时,你应该使用批量命令来处理。

批量操作相比于多次单个操作的优势在于,可以显著减少客户端、服务端的来回网络 IO 次数。

所以我给你的建议是:

7) 避免集中过期 key

Redis 清理过期 key 是采用定时 + 懒惰的方式来做的,而且这个过程都是在主线程中执行。

如果你的业务存在大量 key 集中过期的情况,那么 Redis 在清理过期 key 时,也会有阻塞主线程的风险。

想要避免这种情况发生,你可以在设置过期时间时,增加一个随机时间,把这些 key 的过期时间打散,从而降低集中过期对主线程的影响。

8) 使用长连接操作 Redis,合理配置连接池

你的业务应该使用长连接操作 Redis,避免短连接。

当使用短连接操作 Redis 时,每次都需要经过 TCP 三次握手、四次挥手,这个过程也会增加操作耗时。

同时,你的客户端应该使用连接池的方式访问 Redis,并设置合理的参数,长时间不操作 Redis 时,需及时释放连接资源。

9) 只使用 db0

尽管 Redis 提供了 16 个 db,但我只建议你使用 db0。

为什么呢?我总结了以下 3 点原因:

10) 使用读写分离 + 分片集群

如果你的业务读请求量很大,那么可以采用部署多个从库的方式,实现读写分离,让 Redis 的从库分担读压力,进而提升性能。

如果你的业务写请求量很大,单个 Redis 实例已无法支撑这么大的写流量,那么此时你需要使用分片集群,分担写压力。

11) 不开启 AOF 或 AOF 配置为每秒刷盘

如果对于丢失数据不敏感的业务,我建议你不开启 AOF,避免 AOF 写磁盘拖慢 Redis 的性能。

如果确实需要开启 AOF,那么我建议你配置为 appendfsync everysec,把数据持久化的刷盘操作,放到后台线程中去执行,尽量降低 Redis 写磁盘对性能的影响。

12) 使用物理机部署 Redis

Redis 在做数据持久化时,采用创建子进程的方式进行。

而创建子进程会调用操作系统的 fork 系统调用,这个系统调用的执行耗时,与系统环境有关。

虚拟机环境执行 fork 的耗时,要比物理机慢得多,所以你的 Redis 应该尽可能部署在物理机上。

13) 关闭操作系统内存大页机制

Linux 操作系统提供了内存大页机制,其特点在于,每次应用程序向操作系统申请内存时,申请单位由之前的 4KB 变为了 2MB。

这会导致什么问题呢?

当 Redis 在做数据持久化时,会先 fork 一个子进程,此时主进程和子进程共享相同的内存地址空间。

当主进程需要修改现有数据时,会采用写时复制(Copy On Write)的方式进行操作,在这个过程中,需要重新申请内存。

如果申请内存单位变为了 2MB,那么势必会增加内存申请的耗时,如果此时主进程有大量写操作,需要修改原有的数据,那么在此期间,操作延迟就会变大。

所以,为了避免出现这种问题,你需要在操作系统上关闭内存大页机制。

好了,以上这些就是 Redis 「高性能」方面的实践优化。如果你非常关心 Redis 的性能问题,可以结合这些方面针对性优化。

我们再来看 Redis 「可靠性」如何保证。

这里我想提醒你的是,保证 Redis 可靠性其实并不难,但难的是如何做到「持续稳定」。

下面我会从「资源隔离」、「多副本」、「故障恢复」这三大维度,带你分析保障 Redis 可靠性的最佳实践。

1) 按业务线部署实例

提升可靠性的第一步,就是「资源隔离」。

你最好按不同的业务线来部署 Redis 实例,这样当其中一个实例发生故障时,不会影响到其它业务。

这种资源隔离的方案,实施成本是最低的,但成效却是非常大的。

2) 部署主从集群

如果你只使用单机版 Redis,那么就会存在机器宕机服务不可用的风险。

所以,你需要部署「多副本」实例,即主从集群,这样当主库宕机后,依旧有从库可以使用,避免了数据丢失的风险,也降低了服务不可用的时间。

在部署主从集群时,你还需要注意,主从库需要分布在不同机器上,避免交叉部署。

这么做的原因在于,通常情况下,Redis 的主库会承担所有的读写流量,所以我们一定要优先保证主库的稳定性,即使从库机器异常,也不要对主库造成影响。

而且,有时我们需要对 Redis 做日常维护,例如数据定时备份等操作,这时你就可以只在从库上进行,这只会消耗从库机器的资源,也避免了对主库的影响。

3) 合理配置主从复制参数

在部署主从集群时,如果参数配置不合理,也有可能导致主从复制发生问题:

在这方面我给你的建议有以下 2 点:

4) 部署哨兵集群,实现故障自动切换

只部署了主从节点,但故障发生时是无法自动切换的,所以,你还需要部署哨兵集群,实现故障的「自动切换」。

而且,多个哨兵节点需要分布在不同机器上,实例为奇数个,防止哨兵选举失败,影响切换时间。

以上这些就是保障 Redis「高可靠」实践优化,你应该也发现了,这些都是部署和运维层的优化。

除此之外,你可能还会对 Redis 做一些「日常运维」工作,这时你要注意哪些问题呢?

如果你是 DBA 运维人员,在平时运维 Redis 时,也需要注意以下 6 个方面。****

1) 禁止使用 KEYS/FLUSHALL/FLUSHDB 命令

执行这些命令,会长时间阻塞 Redis 主线程,危害极大,所以你必须禁止使用它。

如果确实想使用这些命令,我给你的建议是:

2) 扫描线上实例时,设置休眠时间

不管你是使用 SCAN 扫描线上实例,还是对实例做 bigkey 统计分析,我建议你在扫描时一定记得设置休眠时间。

防止在扫描过程中,实例 OPS 过高对 Redis 产生性能抖动。

3) 慎用 MONITOR 命令

有时在排查 Redis 问题时,你会使用 MONITOR 查看 Redis 正在执行的命令。

但如果你的 Redis OPS 比较高,那么在执行 MONITOR 会导致 Redis 输出缓冲区的内存持续增长,这会严重消耗 Redis 的内存资源,甚至会导致实例内存超过 maxmemory,引发数据淘汰,这种情况你需要格外注意。

所以你在执行 MONITOR 命令时,一定要谨慎,尽量少用。

4) 从库必须设置为 slave-read-only

你的从库必须设置为 slave-read-only 状态,避免从库写入数据,导致主从数据不一致。

除此之外,从库如果是非 read-only 状态,如果你使用的是 4.0 以下的 Redis,它存在这样的 Bug:

从库写入了有过期时间的数据,不会做定时清理和释放内存。

这会造成从库的内存泄露!这个问题直到 4.0 版本才修复,你在配置从库时需要格外注意。

5) 合理配置 timeout 和 tcp-keepalive 参数

如果因为网络原因,导致你的大量客户端连接与 Redis 意外中断,恰好你的 Redis 配置的 maxclients 参数比较小,此时有可能导致客户端无法与服务端建立新的连接(服务端认为超过了 maxclients)。

造成这个问题原因在于,客户端与服务端每建立一个连接,Redis 都会给这个客户端分配了一个 client fd。

当客户端与服务端网络发生问题时,服务端并不会立即释放这个 client fd。

什么时候释放呢?

Redis 内部有一个定时任务,会定时检测所有 client 的空闲时间是否超过配置的 timeout 值。

如果 Redis 没有开启 tcp-keepalive 的话,服务端直到配置的 timeout 时间后,才会清理释放这个 client fd。

在没有清理之前,如果还有大量新连接进来,就有可能导致 Redis 服务端内部持有的 client fd 超过了 maxclients,这时新连接就会被拒绝。

针对这种情况,我给你的优化建议是:

6) 调整 maxmemory 时,注意主从库的调整顺序

Redis 5.0 以下版本存在这样一个问题:从库内存如果超过了 maxmemory,也会触发数据淘汰。

在某些场景下,从库是可能优先主库达到 maxmemory 的(例如在从库执行 MONITOR 命令,输出缓冲区占用大量内存),那么此时从库开始淘汰数据,主从库就会产生不一致。

要想避免此问题,在调整 maxmemory 时,一定要注意主从库的修改顺序:

直到 Redis 5.0,Redis 才增加了一个配置 replica-ignore-maxmemory,默认从库超过 maxmemory 不会淘汰数据,才解决了此问题。

好了,以上这些就是「日常运维」Redis 需要注意的,你可以对各个配置项查漏补缺,看有哪些是需要优化的。

接下来,我们来看一下,保障 Redis「安全」都需要注意哪些问题。

无论如何,在互联网时代,安全问题一定是我们需要随时警戒的。

你可能听说过 Redis 被注入可执行脚本,然后拿到机器 root 权限的安全问题,都是因为在部署 Redis 时,没有把安全风险注意起来。

针对这方面,我给你的建议是:

只要你把这些做到位,基本上就可以保证 Redis 的安全风险在可控范围内。

至此,我们分析了 Redis 在内存、性能、可靠性、日常运维方面的最佳实践优化。

除了以上这些,你还需要做到提前「预防」。

HTTP主要经历了 1.0、1.1、2.0、3.0 四个版本

HTTP 1.0需要使用keep-alive 参数来告知服务器端要建立一个长连接,而HTTP1.1 默认 支持长连接。

HTTP是基于TCP/IP协议的,创建一个TCP连接是需要经过三次握手的,有一定的开销,如果每次通讯都要重新建立连接的话,对性能有影响。因此最好能维持一个长连接,可以用个长连接来发多个请求。

HTTP还支持传送内容的一部分。这样当客户端已经有一部分的资源后,只需要跟服务器请求另外的部分资源即可。这是支持文件断点续传的基础。

HTTP1.0是没有host域的,HTTP1.1才支持这个参数。

HTTP2.0使用了多路复用的技术,做到同一个连接并发处理多个请求,而且并发请求的数量比HTTP1.1大了好几个数量级。

当然HTTP1.1也可以多建立几个TCP连接,来支持处理更多并发的请求,但是创建TCP连接本身也是有开销的。

TCP连接有一个预热和保护的过程,先检查数据是否传送成功,一旦成功过,则慢慢加大传输速度。因此对应瞬时并发的连接,服务器的响应就会变慢。所以最好能使用一个建立好的连接,并且这个连接可以支持瞬时并发的请求。

所有就是请求的都是通过一个 TCP连接并发完成。 HTTP 1.x 中,如果想并发多个请求,必须使用多个 TCP 链接,且浏览器为了控制资源,还会对单个域名有 6-8个的TCP链接请求限制

HTTP1.1不支持header数据的压缩,HTTP2使用HPACK算法对header的数据进行压缩,这样数据体积小了,在网络上传输就会更快。

意思是说,当我们对支持HTTP2.0的web server请求数据的时候,服务器会顺便把一些客户端需要的资源一起推送到客户端,免得客户端再次创建连接发送请求到服务器端获取。这种方式非常合适加载静态资源。

服务器端推送的这些资源其实存在客户端的某处地方,客户端直接从本地加载这些资源就可以了,不用走网络,速度自然是快很多的。

HTTP/2 采用二进制格式传输数据,而非HTTP 1.x 的文本格式

https://mp.weixin.qq.com/s/n9CmpkiGThQbXW6KcGcQVA?utm_source=tuicool&utm_medium=referral

API网关可以看做系统与外界联通的入口,我们可以在网关进行处理一些非业务逻辑的逻辑,比如权限验证,监控,缓存,请求路由等等。

由于在内部开发中我们都是以RPC协议(thrift or dubbo)去做开发,暴露给内部服务,当外部服务需要使用这个接口的时候往往需要将RPC协议转换成HTTP协议。

在我们的系统中由于同一个接口新老两套系统都在使用,我们需要根据请求上下文将请求路由到对应的接口。

对于鉴权操作不涉及到业务逻辑,那么可以在网关层进行处理,不用下层到业务逻辑。

由于网关是外部服务的入口,所以我们可以在这里监控我们想要的数据,比如入参出参,链路时间。

对于流量控制,熔断降级非业务逻辑可以统一放到网关层。

有很多业务都会自己去实现一层网关层,用来接入自己的服务,但是对于整个公司来说这还不够。

统一的API网关不仅有API网关的所有的特点,还有下面几个好处:

在公司中如果有某个技术组件需要升级,那么是需要和每个业务线沟通,通常几个月都搞不定。举个例子如果对于入口的安全鉴权有重大安全隐患需要升级,如果速度还是这么慢肯定是不行,那么有了统一的网关升级是很快的。

对于某个服务的接入也比较困难,比如公司已经研发出了比较稳定的服务组件,正在公司大力推广,这个周期肯定也特别漫长,由于有了统一网关,那么只需要统一网关统一接入。

不同业务不同部门如果按照我们上面的做法应该会都自己搞一个网关层,用来做这个事,可以想象如果一个公司有100个这种业务,每个业务配备4台机器,那么就需要400台机器。并且每个业务的开发RD都需要去开发这个网关层,去随时去维护,增加人力。如果有了统一网关层,那么也许只需要50台机器就可以做这100个业务的网关层的事,并且业务RD不需要随时关注开发,上线的步骤。

对于我们自己实现的网关层,由于只有我们自己使用,对于吞吐量的要求并不高所以,我们一般同步请求调用即可。

对于我们统一的网关层,如何用少量的机器接入更多的服务,这就需要我们的异步,用来提高更多的吞吐量。对于异步化一般有下面两种策略:

这种策略使用的比较普遍,京东,有赞,Zuul,都选取的是这个策略,这种策略比较适合HTTP。在Servlet3中可以开启异步。

Netty为高并发而生,目前唯品会的网关使用这个策略,在唯品会的技术文章中在相同的情况下Netty是每秒30w+的吞吐量,Tomcat是13w+,可以看出是有一定的差距的,但是Netty需要自己处理HTTP协议,这一块比较麻烦。

对于网关是HTTP请求场景比较多的情况可以采用Servlet,毕竟有更加成熟的处理HTTP协议。如果更加重视吞吐量那么可以采用Netty。

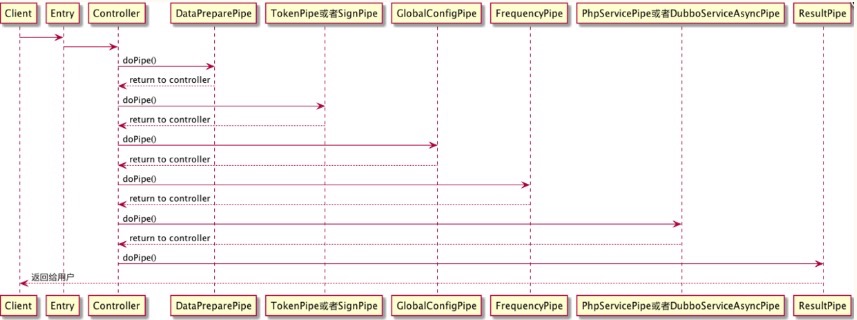

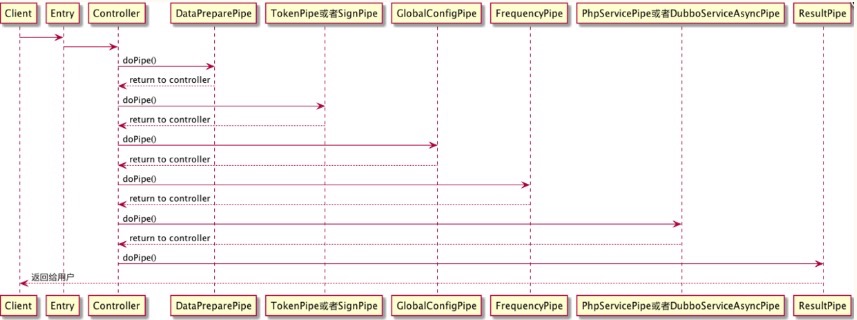

对于来的请求我们已经使用异步了,为了达到全链路异步所以我们需要对去的请求也进行异步处理,对于去的请求我们可以利用我们rpc的异步支持进行异步请求所以基本可以达到下图:

由在web容器中开启servlet异步,然后进入到网关的业务线程池中进行业务处理,然后进行rpc的异步调用并注册需要回调的业务,最后在回调线程池中进行回调处理。

在设计模式中有一个模式叫责任链模式,他的作用是避免请求发送者与接收者耦合在一起,让多个对象都有可能接收请求,将这些对象连接成一条链,并且沿着这条链传递请求,直到有对象处理它为止。通过这种模式将请求的发送者和请求的处理者解耦了。在我们的各个框架中对此模式都有实现,比如servlet里面的filter,springmvc里面的Interceptor。

在Netflix Zuul中也应用了这种模式,如下图所示:

这种模式在网关的设计中我们可以借鉴到自己的网关设计:

这种设计在有赞的网关也有应用。

上面在全链路异步的情况下不同业务之间的影响很小,但是如果在提供的自定义FiIlter中进行了某些同步调用,一旦超时频繁那么就会对其他业务产生影响。所以我们需要采用隔离之术,降低业务之间的互相影响。

信号量隔离只是限制了总的并发数,服务还是主线程进行同步调用。这个隔离如果远程调用超时依然会影响主线程,从而会影响其他业务。因此,如果只是想限制某个服务的总并发调用量或者调用的服务不涉及远程调用的话,可以使用轻量级的信号量来实现。有赞的网关由于没有自定义filter所以选取的是信号量隔离。

最简单的就是不同业务之间通过不同的线程池进行隔离,就算业务接口出现了问题由于线程池已经进行了隔离那么也不会影响其他业务。在京东的网关实现之中就是采用的线程池隔离,比较重要的业务比如商品或者订单 都是单独的通过线程池去处理。但是由于是统一网关平台,如果业务线众多,大家都觉得自己的业务比较重要需要单独的线程池隔离,如果使用的是Java语言开发的话那么,在Java中线程是比较重的资源比较受限,如果需要隔离的线程池过多不是很适用。如果使用一些其他语言比如Golang进行开发网关的话,线程是比较轻的资源,所以比较适合使用线程池隔离。

如果有某些业务就需要使用隔离但是统一网关又没有线程池隔离那么应该怎么办呢?那么可以使用集群隔离,如果你的某些业务真的很重要那么可以为这一系列业务单独申请一个集群或者多个集群,通过机器之间进行隔离。

流量控制可以采用很多开源的实现,比如阿里最近开源的Sentinel和比较成熟的Hystrix。

一般限流分为集群限流和单机限流:

这一块也可以参照开源的实现Sentinel和Hystrix,这里不是重点就不多提了。

泛化调用指的是一些通信协议的转换,比如将HTTP转换成Thrift。在一些开源的网关中比如Zuul是没有实现的,因为各个公司的内部服务通信协议都不同。比如在唯品会中支持HTTP1,HTTP2,以及二进制的协议,然后转化成内部的协议,淘宝的支持HTTPS,HTTP1,HTTP2这些协议都可以转换成,HTTP,HSF,Dubbo等协议。

如何去实现泛化调用呢?由于协议很难自动转换,那么其实每个协议对应的接口需要提供一种映射。简单来说就是把两个协议都能转换成共同语言,从而互相转换。

一般来说共同语言有三种方式指定:

比如可以将一个 www.baidu.com/id = 1 GET 可以映射为json:

代码块

{

“method”: "getBaidu"

"param" : {

"id" : 1

}

}

对于泛化调用如果要自己设计的话JSON基本可以满足,如果对于个性化的需要特别多的话倒是可以自己定义一套语言。

上面介绍的都是如何实现一个网关的技术关键。这里需要介绍网关的一个业务关键。有了网关之后,需要一个管理平台如何去对我们上面所描述的技术关键进行配置,包括但不限于下面这些配置:

最后一个合理的标准网关应该按照如下去实现:

当应用系统有大量用户进行访问时,导致系统的TPS极速上升,查询数据直接打到了数据库,达到了系统的性能瓶颈,接口的响应会变慢,用户体验变得非常差。

那么从技术架构的角度思考可以使用缓存技术对系统进行优化:

在计算机中,缓存是一个高速数据存储层,其中存储了数据子集且通常是短暂性存储,这样日后再次请求此数据时要比访问数据的主存储位置快,通过缓存可以高效地重用之前检索或计算的数据;

缓存分为以下三种:硬件缓存、客户端缓存、服务端缓存。

它是指一块芯片集成到硬盘、CPU上,作用是充当硬盘、CPU与外界接口之间的暂存器,外部接口通常是指硬盘或CPU和内存之间。

为了提高用户体验和减轻服务端压力,会将用户之前访问的一些数据缓存在客户端本地,

一般来说指的是浏览器缓存或APP缓存。

服务端缓存目的和客户端缓存是一样的,只是站在服务端的角度考虑,

如果客户端每次请求服务端都要直接连接到数据库,当客户请求数多的时候数据库压力会非常大,

这个时候可以把一些经常被请求的数据存放在内存中,

当有请求来访问的时候直接返回,不用经过数据库,这样就能减轻数据库的压力,

硬件缓存属于硬件层面上的优化而客户端和服务端缓存则属于技术优化手段,

缓存的本质是以空间换时间的手段来提升接.口的响应速度,

作为一个后端开发关注更多的是服务器端缓存。

高并发查询、高并发写入、热点数据、大对象初始化。

因为[内存]速度远远高于磁盘,所以大大的提升了应用程序的访问速度

一个缓存实例就可以提供数十万的QPS,可以取代大量数据库实例从而降低总成本

降低数据库负载,防止其在负载情况下性能下降甚至是雪崩

当有很少数据被频繁的访问,例如微博上某个明星突然官宣,很多用户都会去看一下

这会在数据库中产生热点,为了让访问速度更快,需要用特殊手段去维护这些热点数据

当使用了缓存以后就不需要考虑热点数据的问题

相比较于数据库除了更低的延迟外,内存系统还提供了更高的吞吐量,

比如说redis单个实例可以处理十几万的读请求.

缓存通常需要设置有效期,过期后应当失效

常见的过期策略有:定时、定期、惰性失效

缓存占用有空间上限,超过上限需淘汰部分缓存数据

常见的淘汰策略有:FIFO、LRU、LFU

缓存需要支持并发的读取和写入

请求数据库中不存在的数据导致每次查询都无法命中缓存,从而违背了降低数据库压力的本意

缓存失效的同时大量相同请求穿过缓存访问数据库

大量缓存同时失效,导致大量请求穿过缓存访问到数据库

基于JDK自带的Map容器类:HashMap、ConcurrentHashMap

Google提供的java增强工具包Guava的一个模块,社区活跃。Spring5之前默认的内存缓存框架

重量级的内存缓存,支持二级缓存,Hibernate中默认的缓存框架

基于Guava API开发的高性能内存缓存,Spring5默认的内存缓存框架

判断一个缓存的好坏最核心的指标就是命中率,影响缓存命中率有很多因素,包括业务场景、淘汰策略、清理策略、缓存容量等等。如果作为本地缓存, 它的性能的情况,资源的占用也都是一个很重要的指标。

上面说到淘汰策略是影响缓存命中率的因素之一,一般比较简单的缓存就会直接用到 LFU(Least Frequently Used,即最不经常使用) 或者LRU(Least Recently Used,即最近最少使用) ,而 Caffeine 就是使用了 W-TinyLFU 算法。

W-TinyLFU 看名字就能大概猜出来,它是 LFU 的变种,也是一种缓存淘汰算法。那为什么要使用 W-TinyLFU 呢?

TinyLFU 就是其中一个优化算法,它是专门为了解决 LFU 上述提到的两个问题而被设计出来的。

解决第一个问题是采用了 Count–Min Sketch 算法。

解决第二个问题是让记录尽量保持相对的“新鲜”(Freshness Mechanism),并且当有新的记录插入时,可以让它跟老的记录进行“PK”,输者就会被淘汰,这样一些老的、不再需要的记录就会被剔除。

如何对一个 key 进行统计,但又可以节省空间呢?(不是简单的使用HashMap,这太消耗内存了),注意哦,不需要精确的统计,只需要一个近似值就可以了,怎么样,这样场景是不是很熟悉,如果你是老司机,或许已经联想到布隆过滤器(Bloom Filter)的应用了。

没错,将要介绍的 Count–Min Sketch 的原理跟 Bloom Filter 一样,只不过 Bloom Filter 只有 0 和 1 的值,那么你可以把 Count–Min Sketch 看作是“数值”版的 Bloom Filter。

在 TinyLFU 中,近似频率的统计如下图所示:

对一个 key 进行多次 hash 函数后,index 到多个数组位置后进行累加,查询时取多个值中的最小值即可。

Caffeine 对这个算法的实现在FrequencySketch类。但 Caffeine 对此有进一步的优化,例如 Count–Min Sketch 使用了二维数组,Caffeine 只是用了一个一维的数组;再者,如果是数值类型的话,这个数需要用 int 或 long 来存储,但是 Caffeine 认为缓存的访问频率不需要用到那么大,只需要 15 就足够,一般认为达到 15 次的频率算是很高的了,而且 Caffeine 还有另外一个机制来使得这个频率进行衰退减半(下面就会讲到)。如果最大是 15 的话,那么只需要 4 个 bit 就可以满足了,一个 long 有 64bit,可以存储 16 个这样的统计数,Caffeine 就是这样的设计,使得存储效率提高了 16 倍。

为了让缓存保持“新鲜”,剔除掉过往频率很高但之后不经常的缓存,Caffeine 有一个 Freshness Mechanism。做法很简答,就是当整体的统计计数(当前所有记录的频率统计之和,这个数值内部维护)达到某一个值时,那么所有记录的频率统计除以 2。

#美团即时物流的分布式系统架构设计

https://tech.meituan.com/2018/11/22/instant-logistics-distributed-system-architecture.html

美团外卖已经发展了五年,即时物流探索也经历了3年多的时间,业务从零孵化到初具规模,在整个过程中积累了一些分布式高并发系统的建设经验。最主要的收获包括两点:

本文主要介绍在美团即时物流分布式系统架构逐层演变的进展中,遇到的技术障碍和挑战:

美团即时物流配送平台主要围绕三件事展开:一是面向用户提供履约的SLA,包括计算送达时间ETA、配送费定价等;二是在多目标(成本、效率、体验)优化的背景下,匹配最合适的骑手;三是提供骑手完整履约过程中的辅助决策,包括智能语音、路径推荐、到店提醒等。

在一系列服务背后,是美团强大的技术体系的支持,并由此沉淀出的配送业务架构体系,基于架构构建的平台、算法、系统和服务。庞大的物流系统背后离不开分布式系统架构的支撑,而且这个架构更要保证高可用和高并发。

分布式架构,是相对于集中式架构而言的一种架构体系。分布式架构适用CAP理论(Consistency 一致性,Availability 可用性,Partition Tolerance 分区容忍性)。在分布式架构中,一个服务部署在多个对等节点中,节点之间通过网络进行通信,多个节点共同组成服务集群来提供高可用、一致性的服务。

早期,美团按照业务领域划分成多个垂直服务架构;随着业务的发展,从可用性的角度考虑做了分层服务架构。后来,业务发展越发复杂,从运维、质量等多个角度考量后,逐步演进到微服务架构。这里主要遵循了两个原则:不宜过早的进入到微服务架构的设计中,好的架构是演进出来的不是提前设计出来的。

上图是比较典型的美团技术体系下的分布式系统结构:依托了美团公共组件和服务,完成了分区扩容、容灾和监控的能力。前端流量会通过HLB来分发和负载均衡;在分区内,服务与服务会通过OCTO进行通信,提供服务注册、自动发现、负载均衡、容错、灰度发布等等服务。当然也可以通过消息队列进行通信,例如Kafka、RabbitMQ。在存储层使用Zebra来访问分布式数据库进行读写操作。利用CAT(美团开源的分布式监控系统)进行分布式业务及系统日志的采集、上报和监控。分布式缓存使用Squirrel+Cellar的组合。分布式任务调度则是通过Crane。

在实践过程还要解决几个问题,比较典型的是集群的扩展性,有状态的集群可扩展性相对较差,无法快速扩容机器,无法缓解流量压力。同时,也会出现节点热点的问题,包括资源不均匀、CPU使用不均匀等等。

首先,配送后台技术团队通过架构升级,将有状态节点变成无状态节点,通过并行计算的能力,让小的业务节点去分担计算压力,以此实现快速扩容。

第二是要解决一致性的问题,对于既要写DB也要写缓存的场景,业务写缓存无法保障数据一致性,美团内部主要通过Databus来解决,Databus是一个高可用、低延时、高并发、保证数据一致性的数据库变更实时传输系统。通过Databus上游可以监控业务Binlog变更,通过管道将变更信息传递给ES和其他DB,或者是其他KV系统,利用Databus的高可用特性来保证数据最终是可以同步到其他系统中。

第三是我们一直在花精力解决的事情,就是保障集群高可用,主要从三个方面来入手,事前较多的是做全链路压测评,估峰值容量;周期性的集群健康性检查;随机故障演练(服务、机器、组件)。事中做异常报警(性能、业务指标、可用性);快速的故障定位(单机故障、集群故障、IDC故障、组件异常、服务异常);故障前后的系统变更收集。事后重点做系统回滚;扩容、限流、熔断、降级;核武器兜底。

单IDC故障之后,入口服务做到故障识别,自动流量切换;单IDC的快速扩容,数据提前同步,服务提前部署,Ready之后打开入口流量;要求所有做数据同步、流量分发的服务,都具备自动故障检测、故障服务自动摘除;按照IDC为单位扩缩容的能力。

美团IDC以分区为单位,存在资源满排,分区无法扩容。美团的方案是多个IDC组成虚拟中心,以中心为分区的单位;服务无差别的部署在中心内;中心容量不够,直接增加新的IDC来扩容容量。

相比多中心来说,单元化是进行分区容灾和扩容的更优方案。关于流量路由,美团主要是根据业务特点,采用区域或城市进行路由。数据同步上,异地会出现延迟状况。SET容灾上要保证同本地或异地SET出现问题时,可以快速把SET切换到其他SET上来承担流量。

机器学习平台,是一站式线下到线上的模型训练和算法应用平台。之所以构建这个平台,目的是要解决算法应用场景多,重复造轮子的矛盾问题,以及线上、线下数据质量不一致。如果流程不明确不连贯,会出现迭代效率低,特征、模型的应用上线部署出现数据质量等障碍问题。

JARVIS是一个以稳定性保障为目标的智能化业务运维AIOps平台。主要用于处理系统故障时报警源很多,会有大量的重复报警,有效信息很容易被淹没等各种问题。此外,过往小规模分布式集群的运维故障主要靠人和经验来分析和定位,效率低下,处理速度慢,每次故障处理得到的预期不稳定,在有效性和及时性方面无法保证。所以需要AIOps平台来解决这些问题。

经过复盘和Review之后,我们发现未来的挑战很大,微服务不再“微”了,业务复杂度提升之后,服务就会变得膨胀。其次,网状结构的服务集群,任何轻微的延迟,都可能导致的网络放大效应。另外复杂的服务拓扑,如何做到故障的快速定位和处理,这也是AIOps需要重点解决的难题。最后,就是单元化之后,从集群为单位的运维到以单元为单位的运维,业给美团业务部署能力带来很大的挑战。

去哪儿网在刚开始做酒店交易业务的时候,为了实现各个业务线的快速搭建和运营,采取了比较简单粗放的设计,在短期内确实取得了不错的效果,但是同时也带来了诸如结构混乱、系统割裂、流程复杂繁琐等一系列问题,随着业务规模和范围的不断发展,技术在响应越来越复杂的需求时就碰到了很多困难,效率和质量都严重受到影响。因此做了一次大规模的重构,重新设计产品模型,梳理业务流程,划分好层次和边界,拆分各个子系统,通过服务化的架构方式来组织系统,使得开发能分工明确高效高质的响应业务需求,也能够在此基础上不断的改进和完善系统。

莫德友,2013年8月加入QUNAR酒店事业部,负责酒店交易系统的业务规划和系统架构。2006年毕业于北京邮电大学,之前在艺龙工作多年,一直从事酒店交易系统相关开发工作,见证了艺龙酒店系统的一路演进,对如何设计更好的技术架构和数据模型以更简洁有效的实现纷繁复杂的产品需求和业务流程有着极大兴趣。

在大型系统中,任务调度是一项基础性的需求。对于一些需要重复、定时执行或者耗时比较长的任务经常会被剥离出来单独处理,而随着任务规模与复杂性的上升,任务调度系统也就随需而生。设计良好的任务调度系统具备可靠性及伸缩性,它可以管理并监控任务的执行流程,以保证任务的正确执行。去哪儿网的工程师余昭辉曾参与开发了去哪儿网的任务调度中心基础组件,InfoQ就任务调度中心对他进行了采访。

一般在交易系统中会存在各种各样的后台任务,有的可能是定时运行,有的就是一直在幕后默默执行。比如每间隔一段时间我们需要两个系统之间进行对账,每天某个固定时刻我们开始发起所有符合条件的退款操作等等。原先我们的各种后台都是由自行开发,有的使用开源的Quartz,有的就直接使用java自带的线程池等。使用这些方式在早期可以很快的满足我们的需求,但是随着系统越来越庞大,大量的后台任务越来越难以管理和维护。第一个是缺少一个集中的管理方式,可以以很好的可视化的方式监视所有任务的执行状态,跟踪任务的执行历史。第二是大部分任务都存在单点问题(因为很多任务同时只能有一个实例运行,简单的实现方式难以做到分布式)。还有其他一些各方面的小问题,促使自己开发一个分布式的任务调度系统来解决这些问题。首先我们开发的这个系统应该能够记录下任务的所有执行记录,当出现问题的时候我们可以很容易的追踪任务的历史执行轨迹。我们还要集中的管理所有任务,即使一个新人也可以立即知晓我们的系统中有多少任务在运行。最后,我们我们要能让执行任务的应用多台部署,但又要保证只有单个实例在运行。

在技术方面,我们的任务调度中心使用Zookeeper来实现任务调度中心集群的failover。执行任务应用机器的上下线也是通过Zookeeper来实现的。任务执行过程中所生成的日志通过Alibaba开源的Dubbo汇集到中心,然后存储在HBase里备查。任务中心和执行任务的应用之间会传递心跳信息,通过心跳信息不断地交换当前正在执行的任务的执行状态。

我们的调度中心没有基于Quartz,在调度方面是完全自己开发的。当时开发的时候确实有想过是不是直接使用Quartz,但是最后看Quartz的代码发现代码量真不少。Quartz提供了很多非常丰富的特性,很多特性我觉得并不是我们所需要的,所以我不愿意承担这个复杂性。最后开发完也证明了这一点,任务调度的地方并没有多少代码量,因为自己写也更熟悉,也可以更好的利用公司现有的一些框架类库。我们的任务调度中心支持Cron Expression,执行任务的应用也支持集群部署。提供了多种错误恢复和报警策略,可以由业务自行选择。

在使用上我们的任务中心还是挺方便的。因为我们公司大部分Java项目都是基于Spring的,所以我们提供了自定义的Annotation,只需要在你想调度的方法上标记该Annotation,任务就可以自动注册到任务中心里,然后就可以在任务中心的管理后台进行各种参数配置和监控。

任务中心与执行任务的应用之间是通过发消息通信的,这里使用了我们团队自己开发的一个可靠消息中间件。第三方应用作为消息的消费者。任务中心负责调度,当要开始调度一个任务的时候,就往这个应用发送一条消息,第三方应用收到消息后就开始执行任务。

调度中心支持任务的开始和修改任务的执行时间的,但是不支持将一个正在运行的任务暂停下来,主要是我们觉得安全地暂停正在执行的任务还是挺困难的,不是任务中心提供了这个功能,这个任务就可以暂停,还需要执行任务的应用配合,如果一旦误用可能还会带来很多其他问题,所以我们没有提供这个功能。

我们默认使用的是随机的负载均衡策略。为了实现高可用,任务调度中心自身也是一个集群,前面也提到执行任务的应用也是集群,而且要保证一个任务同一时刻只有一个实例在运行。当时实现这块儿想到两个方案,一个就是去中心化。任务中心集群的每个节点都可以进度调度,通过协调保证每个任务只有单实例运行。但是这种实现方式虽然看起来很好,但实现还是非常复杂,定位问题也很困难。最后我们选择了中心化的策略。我们利用Zookeeper的选举机制,在任务中心集群里选出一个Leader节点进行任务调度,而其他节点负责心跳跟踪,日志汇总等。当任务调度的节点出现故障,我们可以快速的failover到其他节点上。这样一来整个实现方案就简单得多了,到现在运行有半年多时间,总共有上千的任务在上调度一直工作良好。

但这也是这个任务中心最大的缺陷,可能未来某天单个节点难以承载这么大的任务量(其实任务调度也就是要在内存里维护任务的一些元素据信息,而这些信息都不大,我计算了一下,要超过单个节点的容量任务至少要到10万级),如果到这个时候我们计划Leader节点不再进行任务调度,只进行任务分发。就像发扑克牌一样,这个周期内这个任务发给这个节点了就一直由这个节点进行调度。但是整个架构我还是更青睐中心化的方案。

美团 Mock Server 方案

https://www.cnblogs.com/xywq/p/7338988.html

去哪儿YAPI方案

https://testerhome.com/topics/12796?locale=en

去哪儿 Api 自动化测试实践

https://cnodejs.org/topic/5a3a121f8230827a182938da

http://www.sohu.com/a/350497448_817016

最近这几年中台概念火起来了,各大公司纷纷建设自己的中台。

本文介绍阿里数字化转型的实践历程,阿里巴巴中台技术在某石油企业的实施效果分析,如何更好地用好阿里巴巴中台技术实现企业数字化转型。

阿里巴巴中台技术架构首次揭秘,建议收藏

过去十年,我国货物贸易进出口量连创新高,已经成为全球货物贸易第一大国。据 2022 年 11 月海关总署发布的我国前 10 个月外贸“成绩单”:进出口总值 34.62 万亿元,同比增长 9.5%;如果把视线放在全球,这个市场更加巨大,2022 年全球贸易额预计将达到创纪录的 32 万亿美元。

传统外贸模式中,一般国内企业厂家会与海外经销商直接对接,通过邮件、电话、展会、海外办事处等形式达成业务合作,采取大批量采购模式,以银行国际证或 TT 电汇形式支付货款,最终通过海运集装箱完成货物交割。就像众多传统行业一样,跨境贸易产业近年来也经历了数字化的转型创新;与传统外贸相比,互联网参与进模式创新的地方前期主要集中于信息展示和业务撮合领域,近几年来也开始慢慢向交易、支付、物流履约、金融等方向渗透;阿里巴巴国际站(Alibaba.com)就是扎根于这样庞大的一个市场里,希望用技术的力量来重构数字化外贸,从 Sourcing 到 Traceding。

用户增长最早起源于“增长黑客(Growth Hacker)”一词,它由 Qualaroo 的创始人兼首席执行官 Sean Ellis 提出,广泛流行于硅谷互联网创业圈。马克·扎克伯格曾说过“增长黑客团队是 Facebook 在过去 8 年里比较重要的一个发明”;自 Facebook 2008 年设立增长团队以来,不少公司如 LinkedIn、Airbnb、Twitter 等都成立了自己的用户增长团队。随着互联网公司用户的大幅度增长和在商业上取得的巨大成功,国内互联网也纷纷争相效仿,“用户增长”逐渐开始成为国内外互联网创业公司最热门的新兴部门。那到底什么是增长黑客呢?

Andrew Chen 在《Growth Hacker is the new VP Marketing》一文中谈到,增长黑客们试图用更聪明的方式解答产品得以增长的奥秘,并使之成为助力产品增长的长效机制。他们通常采用的手段包括 A/B 测试、搜索引擎优化、电子邮件召回和营销等;换句话说,增长团队是一群以市场指导产品、以数据驱动营销、通过技术化手段贯彻增长目标的人,他们的核心使命就是尽一切可能挖掘一个产品的增长潜力;他们通常既了解技术,又深谙用户心理,擅长发挥创意、绕过限制,通过低成本的手段解决公司产品增长问题;同时不断对产品进行调整并对调整内容进行测试,包括产品的特征、信息传达方式以及用户获取、激活、留存与变现的方式。

在用户增长领域,最经典的方法论莫过于 AARRR 与 RARRA 模型,它们分别将用户增长的过程划分为 5 个不同的阶段,即拉新、激活、留存、变现及推荐。AARRR 模型由 McClure 在 2007 年提出,当时互联网还处在爆发期,获客成本较低廉,因此 AARRR 把重点放在了拉新阶段;而随着流量红利逐渐见顶,获客成本与日俱增,因此 Thomas Petit 和 Gabor Papp 提出了 RARRA 模型,强调拉新不再是增长的王道,真正关键在于用户留存。

不过这种从 C 端演变发展而来的用户增长模型,并不完全适用于 B 端用户,主要原因是 B 类买家与 C 类买家有着显著的差异。B 类业务的一个显著特点就是客单价高且采购周期长,并且在不同采购过程中的不同阶段(认知阶段→考虑阶段→偏好阶段→订单阶段→履约阶段),需求也存在较大差异。因此,B 类用户增长的本质就是要根据 B 类买家的特点,在 C 类用增方法的基础上,要找到更合适的有效策略,来打消不同阶段采购者的不同顾虑。B 类买家与 C 类买家的详细差异如下:

根据上述 B 类用增的特点,我们认为跨境 B 类用户增长领域主要面临以下三方面的挑战:

**挑战一:用户结构复杂,但行为数据稀疏:**跨境贸易服务于全球 200 多个国家,不同的语种、文化、法律法规、行业所带来的差异决定了买家需求的多样性;而且用户行为的稀疏性,以及身份、偏好、采购需求等关键信息的缺少更加加剧的增长的挑战性。

**挑战二:目标人群规模小,流量引入的精准性要求高:**全球互联网用户大部分为 C 类用户,其中有 B 类采购需求的用户数占很小比例。流量规模越小,一方面意味着对人群精准定位的要求就越高,另外一方面也意味着获取流量的成本也越高。因此,如何在预算有限的情况下,精准的获取这些 B 类流量成为增长的核心命题。

**挑战三:B 类买家留存率低,C 类增长策略不可复制:**跨境贸易平台用户留存率与 C 类相比存在较大差距,主要原因是匹配效率越高,买家下沉越快,缺乏把买家留存平台的核心权益体系与有效留存抓手,一些 C 类的留存策略不可复制,如红包权益、用户裂变、互动 &社交等玩法在 B 类买家中并不适用。

阿里巴巴国际站用户增长团队经过多年的增长探索,总结出一套牵引业务持续增长的思维框架;在增长策略上,围绕北极星指标持续迭代体系化的方法论和增长引擎,以全链路、多维度的视角挖掘增长策略并通过 A/B Test 快速验证;在组织文化上,研发产品运营一起建立目标、资源和信息的高度一致和协同,持续提升团队成员的产品思维、数据思维、算法能力,以极致技术的匠心精神助力业务高速增长。

面对上述跨境 B 类用户增长的三大核心挑战,团队经过多年的深度实践,打造出具有跨境 B 类特色的四大核心能力,即:1)北极星指标(定义增长目标,起到指挥棒的作用);2)数据驱动增长(通过数据分析洞察,找到增长的核心策略);3)策略执行中心(高效执行增长策略,拿到实际效果);4)AB 实验(快速实验,验证策略及执行效果)。四大核心能力高效咬合,循环执行,形成用户增长飞轮。

增长团队战略制定的第一步是需要设定一个清晰明确的目标,即北极星指标。北极星指标也叫唯一关键指标(OMTM,One metric that matters),简单来说就是产品现阶段最关键的指标,它就像“北极星”一样指引着公司前进的发展方向。北极星指标不是一成不变的,随着业务的变化,公司在不同阶段会有不同目标。具体来说,一个好的北极星指标可以在以下几方面发挥作用:

1)指引方向:北极星指标可以起到指挥棒的作用,给公司所有员工一个明确、统一的数据指标指引。

2)提高行动力:北极星指标可以帮助明确任务的优先级,集中火力,抓住重点,努力朝着同一个目标使劲。

3)指导实验:通过北极星指标可以知道公司业务的当前现状,有针对性地上线优化各种增长实验,观察有无成效,循环反复。

在制定北极星指标的过程中,一般 C 类的电商平台,会使用 MAU、GMV 等作为北极星指标,它反映了用户的活跃度或网站的交易规模。但 B 类业务由于上述讲到的采购周期长、决策链路复杂等特点,C 类相关的指标并不适用。**阿里巴巴国际站用增团队经过多年不断的摸索尝试,在北极星选取这块,也经历了多轮的迭代,主要分为 3 个不同的阶段即“流量→商机→新商机”。**不同的北极星指标代表着不同的业务阶段,也体现了用增团队在业务背后的深度思考,代表着阿里巴巴国际站从粗放到精细化运营的策略转型。具体如下:

**1)流量:**在 2017 之前,我们选择流量规模 UV 作为北极星指标,因为当时商家对流量诉求非常强烈,没有流量或流量较少的商家要求先有流量规模后再考虑流量质量。因此,在合理的预算框架内,用增产研团队想方设法从全球各种媒体中,快速尝试多样性低成本的流量获取方式,满足商家的流量诉求。当时我们在 SEO、联盟等渠道获得了突破性的进展,流量快速增长,但调整增长的背后,也隐藏着一些问题,比如流量不够精准,一些低质量的流量容易造成对商家的干扰,导致服务成本变高。

**2)商机:**经过与商家的大量沟通走访以及内部产研的不断讨论,我们选取了商机作为北极星指标。每一个商机背后代表着一个用户的深度行为(如沟通、询盘、下单等),相比 UV 代表着流量规模,选用商机作为北极星指标,代表着我们更加关注买家在全链路的体验及转化,因此低质量流量大规模减少,买家转化率变高了,对商家造成的困扰得到了很好的缓解,满意度 NPS 有效提升。

**3)优质商机:**随着业务的发展,商家对买家质量提出了更高的诉求,如对询盘质量的诉求,对买家地域的诉求,对买家层级的诉求等等。因此,近年来,我们逐渐开始使用“优质商机”代替“商机”作为北极星指标,同时我们也会关注商机中核心国家、高层级买家的占比。

随着我们对买家以及买家背后的需求、生意模式等认知的不断提升,国际站的北极星指标还会继续演进,虽然每次北极星指标的变化都会带来不小的成本,但从过往的经验来看,正向的长期收益都高于短期的阵痛。不管选取哪个指标作为北极星指标,唯一不变的就是我们坚持客户第一,坚持对高质量买家的追求,这就意味着我们需要持续不断的迭代增长策略,保持创新,为客户创造价值。

现代管理学之父彼得·德鲁克曾说过:如果你不能衡量它,那么你就不能有效增长它。用户增长对数据的依赖性很高,因为定北极星指标、构建增长模型、分析用户数据、寻找增长机会等,这一系列增长策略的探索与发现都离不开数据。因此,阿里巴巴国际站用增团队一直提倡数据驱动的文化,并在这方面打造了三大利器,即:B 类买家资产沉淀、用户行为分析系统、增长策略中心等。

1) 业务背景

国际站服务于来自全球 200+国家的客户,不同的文化、风俗、法律法规、行业所带来的差异决定了买家需求的多样性。通过整合内外部数据,构建海外 B 类数据资产是重要的环节,它有助于明确海外 B 类客户的采购诉求,为其定制差异化的用户引导路径、货品供给、权益服务等精细化运营机制,最终目的是扩大海外 B 买市场渗透率,保障高质量买家增长。相较国内买家的数据资产构建,海外 B 类的资产建设难度明显偏高,主要存在下述两个方面的挑战:

**数据沉淀难:**对于海外 B 类客户,数据沉淀难度高,站内买家行为数据稀疏,用户自填身份/偏好/采购需求等关键信息填写率低,而且也没有类似国内良好的二/三方生态,可以联动相互补充数据等。另外,邓白氏等海外数据公司由于涉及到用户隐私与数据跨境传输等问题,各数据源的稳定性、准确性、及时性等也存在较大问题。

**资产化难度高:**为尽量弥补数据稀疏的问题,我们往往会采用多种数据源,但数据源之间格式参差不齐,存在语种、货币等的区别,而且企业信息无统一主键,其数据清洗归一化的复杂性呈指数级别增长,海外买家同人模型的构建难度远超国内 B/C 类数据资产。

2) 解决方案

面对以上挑战,我们设计了如下整体解决方案,主要包括以下三大模块:

**多数据源引入:**渐进式采集布点完善站内买家信息沉淀,基于流批一体实现行为日志和业务数据的实时 &离线数据集成;建立二方 &三方数据的标准化沉淀流程、基于最小单元原则的标准化数据标准。

**数据资产化:**通过数据建模沉淀 B 类买家的数据资产,结合数据标准定义和数据资产保障实现数据资产的管理与治理。

**服务标准化:**通过资产管理、人群圈选、效果评估和标签服务,建立 B 买数据资产的标准化服务能力。

1) 业务背景

用户的行为是用户对网站体验的真实客观反映,基于用户行为的分析发现产品中的体验是一种重要的技术手段,我们常常希望基于用户行为分析回答以下一些问题,并通过这些问题的优化解决来提升用户体验,进而促进用户的留存与增长。

产品的主路径是什么,用户是否有按照预期的路径步骤操作?

进入产品的不同来源分布如何,哪些来源的质量更优?

产品中是否存在异常路径,如环路、非预期路径等?

产品中哪些环节流失量、流失率较高?

在不同标签等条件下,用户动线的差异是什么?

2) 解决方案

然而,随着产品的不断迭代更新,功能设计愈发复杂多变,很难从全链路上看清用户操作的各个环节及相应的转化流失情况。人工梳理面临着成本高、不准确、周期长、扩展性差等问题,严重影响了产品体验迭代更新节奏。因此,我们打造了一套自动化的用户行为分析系统,主要包含以下几个模块:

**用户行为建模:**在网站打点数据的基础上,通过事件的发生先后顺序构建一套用户行为数据模型。将用户维度信息、用户行为信息、用户反馈信息等底层数据通过以离线的方式进行聚合,然后再导入 OLAP 实时数仓,为后续行为可视化及分析做好数据基础。

**用户行为可视化:**为了降低了行为分析的门槛,我们设计了一种路径配置的领域特定语言(DSL),用户只需要完成简单的配置即可自定义一个用户的行为动线。基于配置化的动线可视化,不仅可以支持产品运营同学的快速调整与试错,而且降低了平台的后续开发维护成本,通配置文件与平台的解耦,底层的数据模型、计算方式及可视化呈现不管动线如何变化均无需二次开发。

**用户行为分析:**通过将常见的行为分析方法,如来源去向分析、转化漏斗分析、热门路径分析、人群对比分析、流失行为分析等做成自动化工具,帮助产品运营同学基于用户行为快速发现增长的策略,并通过 AB 实验的验证,在驱动业务增长的同时,迭代改进自动化分析方法。

用户需求是一切产品的起点,只有理解需求才能为客户创造价值,从而带来业务的长期增长与繁荣。因此,国际站从 B 类买家的需求理解的角度出发,打造了增长策略中心,希望基于对买家需求的深入理解,并协同用增、供给、供应链、商业化等各个团队的联合作战,驱动业务的全局增长。核心模块如下图所示:

**1)数据中心:**将站内外相关数据从需求视角出发汇总成数据中心,包括站内数据(如供需数据、行业化数据、国家化数据、供应链数据等)和站外数据(如国外电商热卖数据、Google 搜索趋势数据、海关进出口数据等),这是需求理解的基础。

**2)策略输出:**基于对下以几个需求理解问题的自动分析识别,挖掘增量机会点,并通过按国家、行业、身份等维度的多维下钻,找到每个细分市场潜在的机会点,输出增长策略。

**3)策略协同:**增长策略输出给各业务团队(用增、供给、供应链、商业等),并结合业务的经验,进一步判断策略的可行性,进行协同作战。

**4)策略验证:**对可行的策略,通过 AB 实验进行验证,并结合 AB 实验的结果迭代优化策略生成逻辑。

用户增长是一个系统性工程,3.2 介绍了如何基于数据驱动找到增长策略,本节将重点介绍如何通过系统化将这些策略进行高效执行。

1) 业务背景

拉新即用户的引入,是用户增长中非常重要的一个环节,它的核心是转化率,即如何低成本的获取精准用户。长期以来,国际站用增团队的重要命题就是通过与国外各渠道媒体的对接,吸引潜在 B 类买家,引导并优化买家在整体链路上的体验,提升活跃买家规模,降低获取成本。日常对接的媒体矩阵如下图所示:

为了更好的优化外投广告的成本,支撑业务目标的达成,在这些渠道的运营工作中也面临着如下核心挑战:

**外投规模大、运营成本高:**外投业务经过多年的发展目前在投渠道数众多,基本覆盖海外核心媒体渠道。预算设置、文案设置、人群定向等设置人工操作成本非常高,同时也无法做到精细化运营。

**外投场景多且复杂,需要满足多业务目标:**外投业务除了要支持用增业务外还需要广告、供应链等横向业务,根据其他团队的业务目标将外投业务能力进行输出,以帮助横向业务发展。不同的业务有不同的目标,怎么通过一套解决方案去满足多业务、多目标的诉求也是我们的核心挑战之一。

**引流流量结构及转化表现迥异:**由于不同端型、不同区域的流量特性存在天然差异,投放策略在针对不同行业、不同区域会面临着很大的不确定性。这些差异性导致了一些运营策略并不是全局有效,增加了业务目标完成的复杂情况,怎么去应对这种复杂,探索成功的投放策略也是核心难点。

2) 解决方案

从业务诉求出发,利用算法和工程的能力,打造集广告投放、预算调控、目标优化为一体的智能投放系统,帮助运营更低成本、更精细化的解决日常工作中的投放任务控制。同时能够让业务运营集中精力去解决更为复杂和不确定性的业务问题。整体能力如下图所示。

核心包含以下几部分的能力:

**核心媒体覆盖能力:**完成海外主流媒体全覆盖,包括 Google、Facebook、TikTok、Criteo、Twitter、Linkedin、联盟等,并且通过 API 网关层做好了对上层的屏蔽,可以快速实现对新渠道的集成。

**API 开放服务化能力:**基于业务场景抽取出物料同步、效果报告下载、物料优化等三个核心服务化接口,在此基础上,其他业务场景可以根据自身业务出发进行定制化的模块组装,快速搭建一套自定义的外投体系。

**全链路自动化优化:**对投放需要的各种要素建成管理及级联优化的能力,包括关键词、选词、创意、转化信号等,实现所有关键要素自动优化,无人值守。

**业务效果仿真能力:**基于历史多维度转化效果,实现对整体外投效果进行预估和规划,在整体预算有限的情况下,可对全局进行统筹优化并对决策提供支持。

1)业务背景

除了拉新外,用户增长的后半程是用户促活和留存,简单来讲,是通过触达手段帮助用户高效 onboarding、尽快体验到平台的价值以达到“aha 时刻”、以利益点透传召回用户,提升用户的留存效率和转化效率。经过多年的发展,国际站用户增长团队基于生命周期运营(新用户→成熟用户→留存用户→流失用户)构建了一套多渠道联动的高效促活系统,提升运营效率和价值,整体思路如下图所示:

其面临的主要问题和挑战如下:

B 类买家采购周期长且采购链路复杂,如何在全链路建立一体化的运营机制,以长周期和买家动线的精准触达的方式持续影响用户心智?

B 类买家规模小、行业及身份差异的离散度高,如何针对细分买家精准实施有效策略促活、促转化?

2)解决方案

为了解决上述问题,我们重点从下述两方面构筑全链路一体化促活运营系统:

**构建全链路运营的协同机制:**从站外召回延伸到站内运营,打通多渠道联合,建成全链路运营的技术闭环。

**寻求用户精细化运营的最优策略:**从用户动线出发深刻理解用户,挖掘临门一脚的优质策略,构建全局策略赛马和管控机制,寻求运营价值最大化。

核心包含以下几部分的能力:

**全链路一体化策略编排体系:**沉淀图形化支撑买家画像、触点、时机、物料 4 要素的全局策略编排体系,支持多触达通道的联合编排,形成端外(PUSH/EDM/WhatsApp)召回、端内(PopX/资源位)运营的技术闭环,使运营策略从单点运营迈向网格化,从离线迈向实时化,给予运营团队更大的发挥空间。

**分群促活的个性化疲劳度 &赛马机制:**以用户画像人群分群矩阵为基础,结合业务域和策略性质的维度细分,以及策略长周期累积的正、负反馈,构建一套基于效果动态和买家意图调节的细分人群差异化的疲劳度调控和赛马分发机制,动态化调节最优策略的分发。

**多样化的物料创意定义能力:**沉淀了创意模型的开放式设计能力,支持文本框、选择器和数组等多形态、条件变量的定义,满足多样化的物料诉求;在物料层抽象成钩子库,支持多通道物料一体化,降低创意模型的开发成本,有超过 90%的需求通过配置化可快速支撑。

在用户增长领域,AB 实验已成为一个基础性思维,能做 AB 实验的地方一定要做,不能做 AB 实验的地方也要想办法做。AB 实验的主要作用是对增长实验进行科学有效的度量,即通过将实验组和对照组进行比较,可以清晰地看到某个改变带来的影响是多少。在国际站,数据科学团队打造了一个从“实验定义->实验调试->实验运行->实验决策”的完善的 AB 实验平台,现在所有的用户增长实验均通过该平台进行精准有效的评估。

当今世界,互联网的流量红利逐渐见顶,宏观环境也充满了很大的不确定性,用户增长的难度不可否认肯定会越来越大。但在面对难题时,我们要坚持在不确定性中寻找确定性,坚持做难而正确的事情,以下是我们认为在用户增长领域值得长期探索和坚持的几个事情:

**持续增加对买家的理解:**只有更好地理解买家的特点、痛点、采购诉求、生意模式等,我们才能更好的做产品创新与模式创新。因此,我们会通过加强买家线上面对面采访、买家信息采集 &验真、买家多维度数据分析、买卖家沟通文本分析、买家评论分析 &挖掘、买家调研报告等多种方式加强对买家的理解。

**坚持增长方法论的迭代:**基于对买家的认知和核心问题的识别,我们不断定义什么是增长,不断寻找买家增量在哪里?不断地迭代我们的用增方法论。

**坚持演进增长文化:**坚持拥抱不确定性,勇于探索,持续学习,培养求真务实的增长文化,培养微创新土壤。

**坚持数据驱动方式:**坚持大胆假设→科学度量→A/B 实验→数据专题分析 &挖掘→ 持续迭代的数据驱动方式,打造高效的用户增长飞轮。

去哪儿支付系统自2011年搭建以来,在五年的时间里逐渐从一个高耦合的单一系统发展为众多子系统组成的高并发、高可用、支持多种交易支付业务的分布式系统。业务从最初的非代收到现在多种非代收、代收场景的支持,B2B业务的从无到有,支付方式从单一网银支付到现在银行卡、拿去花、代金券、红包、立减、积分、趣游宝等多种的组合,订单从单笔支付到多个订单同时支付和多次付款。下面对整体的演变过程进行简单的介绍。

新的业务系统初建时,业务逻辑相对简单,业务量也比较小,为了能够快速实现功能,发布上线,大多数团队都会把所有的逻辑都耦合在一个系统。这对于初期业务的快速迭代是有一定好处的。毫不例外,支付交易系统也采用了这样的方式。如下图所示。

一个支付系统不例外包括几个重要组成部分:收银台、交易、支付、网关、账务。

收银台:用于展示支付详情、提供各种多样支付方式的选择

交易:收单规则和交易规则处理

支付:处理各种组合的支付方式,如银行卡、用户余额、信用付、拿去花、红包、代金券、立减、积分等

账务:用来记录所有交易、资金往来的明细,财务会计记账

网关:用于对接银行通道、第三方支付通道(微信、支付宝)

在业务量不大的情况下,这样的系统结构没有问题。随着更多业务的接入,各种复杂的功能逻辑加入,系统处理起来有点吃力,主要表现以下几个方面:

系统容灾能力:所有的功能都集中在一起,一但某个功能出问题,直接影响全局

系统扩容:在一个分布式系统中,决定系统性能的取决于最差的部分,整体扩容效果差

开发成本高:团队成员的增加,功能的复杂,多个项目并行时,开发效率极低

更多更复杂业务:结构不合理,不能满足业务发展需要

系统职责混乱:如收银台只是简单维护银行列表

在这样的一些背景下,2.0系统应运而生。

2.0时代是支付交易系统快速发展的一个重要时段。在此过程中,不仅要从系统架构上进行服务化的拆分,而且需要支持更复杂的业务。

首先对相对比较独立的网关进行拆分,网关在整个支付系统中属于底层基础服务,是比较重要的基础设施。对外能够提供怎么样的支付交易服务,很多都取决于网关能力的建设。

网关有一些显著特征,它是一个可高度抽象的业务。对外可以抽象到支付、退款、查询这些标准的服务。因此优先将这部分拆分,一是为了能够更好的打好基础,二是其能够独立的发展,三是这部分也相对好实施。

网关的拆分路由系统起到至关重要的作用,对于多通道支付的支持和智能化选择发挥着巨大作用。

做交易支付业务,重要的一件事要记清楚账。记账可以很简单的记录来往流水,也可以更加专业的记财务会计账。在拆分前系统只是记录了交易流水,拆分后实现了更加专业和复杂的复式记账。

新账务系统的一个简单流程图:

会员系统与交易系统本身只是一个依赖关系,在交易支付系统看来只是一个业务系统。比如会员充值业务可以看做是一笔支付交易。为了摆正各自角色,对于会员部分从原有系统中独立出来。这样一来各自定位更加清晰明了,也方便了各自独立发展。现在的会员系统不仅仅只有一个余额,而且引入实名服务、各种资产管理、交易管理等。

更多的系统拆分独立后,原有公用的某些功能会多次复制重复。为方便集中管理维护,通过对各系统公用逻辑更能的统一,提供集中的基础服务,如安全服务、加验签服务、通知服务、基础信息查询等,如下图中talos系统。

上述几个服务的拆分更多是为从业务方面或者技术驱动来考虑。而典型的交易支付过程是有一个时序过程的。比如下单->交易->收银台->支付->网关->银行。这样一个先后时序也是一个比较好的系统拆分方案。根据这样的一个时序,我们针对性的对每个阶段做了拆分(排除网关和银行部分),如下过程:

关注于收单方式和交易类型。

收单方面系统已经支持单笔订单支付、批量订单支付。交易类型目前支持直接交易、担保交易、直接分账交易、担保分账交易、预授权交易等。在批量订单支付时各种交易类型可以进行混合。且分账交易同时支持多个账户。交易类型除了上面正向交易外,系统还支持很多后续流程交易、如预授权确认、预授权撤销、退款、担保撤销、二次分账交易等。

多种多样的交易源于各事业部业务的复杂性,比起标准化的支付系统,我们提提供了更多灵活方便的业务来支持。

关注于支付方案的组合和执行。

支付方式:银行卡、支付宝、微信、拿去花、趣游宝、余额、积分、红包、代金券、会员红包、立减等多种方式支付。

支付组合:可以单一使用,也可以进行组合使用。组合场景区分资金类型,如银行卡、支付宝、微信每次只能选择一个,其它类资金可多个同时使用。

在有上面基础的支持下,对于同一批次交易订单可也进行多次的组合支付扣款,如酒店信用住付款、拿去花还款等业务场景。下图是支付核心(minos)在系统中的位置:

收银台直接面向用户,因此支付体验至关重要。据统计在支付环节放弃的订单占比还比较大。因此一个方便、简洁易用的收银台对于订单转换是有很大帮助的。目前系统支持的收银台主要有app(native)、app前置收银台、touch、PC预授权收银台、PC多单收银台、PC英文版收银台、PC标准收银台等。收银台在系统中的位置如下图所示。

无线端收银台:

PC端收银台:

交易系统更多的服务是通过后台接口来完成的,这部分占到整体系统很大的业务比重。如支付后期的资金流转、逆向操作退款等。但也有一些是用来查询一些交易订单相关性的信息。在此背景下,对于api接入层采用读写分离方式处理。如下图ares系统,将底层的各dubbo服务包装提供各种查询类服务。Odin系统是可读写,更多的关注跟核心业务相关的写,如解冻、退款、撤销等。

截止目前,整体系统的一个大体结构如下图所示:

服务化拆分后,在系统结构上更加清晰了,但对于整体系统的开发管理和日常运营带来更大的挑战。比如下几个方面:

系统拆分后主要提供dubbo服务和对外http(https)服务

接口定义:粒度控制、边界控制。一个接口不能存在模棱两可的情况,只做其一

参数标准:复杂接口使用对象做参数(避免map)、统一父类、支持扩展属性透传、提供create/builder构造合法参数、使用枚举限制参数范围。有效避免调用端参数错传

返回值:统一QResponse封装、错误码管理(非数字形式含义明确、按业务区分避免重复等)

业务模板:定义标准业务处理流程、标准化异常处理

接口文档化:定义好接口后,通过注解动态生成接口文档

a)接口参数:command、校验器、参数类型配置化。

command中定义接口信息,包括请求返回参数、每个参数的参数类型、参数的校验器、参数类型的校验器。校验器可以组合使用,也可以自定义实现扩展。如下示例:

Command定义:

<commands>

<command name="forex_queryExchangeRate">

<cnName>汇率查询接口</cnName>

<version>20150808</version>

<desc>查询本币和目标币种汇率</desc>

<request>

<param name="localCurrType" required="true">

<validator id="CURID"/>

</param>

<param name="targetCurrType" required="true">

<validator id="CURID"/>

</param>

</request>

<!-- 返回参数部分 -->

<response>

<param name="localCurrType">

<cnName>本币</cnName>

<required>true</required>

</param>

<param name="targetCurrType">

<cnName>目标币种</cnName>

<required>true</required>

</param>

<param name="sellingPrice">

<cnName>卖出价</cnName>

<required>true</required>

</param>

<param name="buyingPrice">

<cnName>购买价</cnName>

<required>true</required>

</param>

<param name="rateTime">

<cnName>汇率时间</cnName>

<required>true</required>

</param>

</response>

</command>

</commands>

校验器:

<validators>

<validator id="CURID" type="Regex">

<pattern>^[A-Z]{3}$</pattern>

</validator>

</validators>

参数类型:

<paramTypes>

<paramType name="merchantCode">

<cnName>商户号</cnName>

<desc>用来区分不同商户</desc>

<type>java.lang.String</type>

<example>testbgd</example>

<validator type="Regex">

<pattern>^[A-Za-z0-9]{1,20}$</pattern>

</validator>

</paramType>

</paramTypes>

b)并发控制

在某些操作场景下,对于并发写会有一些问题,此时可以通过依赖cache加锁来控制。比如通过在接口增加注解来启用。可以指定接口参数来作为锁的lockKey ,指定锁失效时间和重试次数,并指定异常时(lockGotExIgnore )的处理方案。

@RequestLock(lockKeyPrefix = "combdaikoupay:",

lockKey = "${parentMerchantCode}_${parentTradeNo}",

lockKeyParamMustExists = true,

lockKeyExpireSecs = 5,

lockUsedRetryTimes = 0,

lockUsedRetryLockIntervalMills = 500,

lockGotExIgnore = false)

c)流量控制

流控目前分两种:qps、并行数。

qps分为节点、集群、接口节点、接口集群。通过对每秒中的请求计数进行控制,大于预设阀值(可动态调整)则拒绝访问同时减少计数,否则通过不减少计数。

行数主要是为了解决请求横跨多秒的情况。此时qps满足条件但整体的访问量在递增,对系统的吞吐量造成影响。大于预设阀值(可动态调整)则拒绝访问。每次请求结束减少计数

d)安全校验

接口权限:对接口的访问权限进行统一管理和验证,粒度控制到访问者、被访问系统、接口、版本号

接口签名:避免接口参数在传递过程中发生串改

e)统一监控

包括接口计数、响应时长和错误码统计三个维度

f)接口文档化

依赖前面command、校验器、参数类型配置进行解析生成

接口监控模板化:http、Dubbo多系统统一模板,集中展示管理。

组件可监控化:Redis/Memcache、Mybatis 、Lock 、QMQ 、 EventBus 、DataSource 、JobScheduler

监控面板自动化生成:Python自动化生成脚本,新创建系统只需要提供系统名称和面板配置节点即可生成标准监控面板

系统硬件资源、tomcat、业务关键指标可视化监控

对于各个场景的关键流程进行格式化日志输出,集中收集处理。如orderLog、userLog、cardLog、binlog、busilog、tracelog、pagelog...

####2.3.1 分表

随着业务量增加,单表数据量过大,操作压力大。因此分表势在必行。常用的分表策略如按照时间来分表,如月表,季表,按照某个key来hash分表,也可以将两种结合起来使用。分表的好处是可方便将历史数据进行迁移,减少在线数据量,分散单表压力。

多库单实例,多业务单库。部分业务存在问题会影响全局,从而会拖垮整个集群。因此在业务系统拆分后,db的拆分也是重要的一个环节。举一个例支付库拆分的例子。支付交易的表都在同一个库中,由于磁盘容量问题和业务已经拆分,因此决定进行拆库。稳妥起见,我们采用保守方案,先对目前实例做一个从库,然后给需要拆分出来的库创建一个新的用户U,切换时先收回U的写权限,然后等待主从同步完成,,确定相关表没有写入后将U切到新的实例上。然后删除各自库中无关的表。

很多业务读多写少,使用MMM结构,基本上只有一台在工作,不仅资源闲置且不利于整体集群的稳定性。引入读写分离、读负责均衡策略。有效使用硬件资源,且降低每台服务器压力。

a)读写负载均衡

b)多动态源

c)多库动态源读负载均衡

servlet3异步:释放出http线程提高系统整体吞吐量,可隔离开不同业务的工作线程

qmq:使用最广泛也更灵活的异步

dubbo:对于服务提供者响应比较慢的情况

servlet异步和qmq结合的场景如下图所示。流程为http服务接到组合扣款请求,然后向后端交易系统下单并发起扣款,此时http服务进入轮询等待,根据轮询间隔定时发起对放在cache中的扣款结果查询。交易系统则根据扣款规则以qmq的方式驱动扣款,直至走完所有流程为止(成功,失败,部分支付)。每次扣款结束将结果放入cache中供http服务查询。

轮询式场景如上图中使用,关键在于确定轮询间隔

嵌入在应用中,指标数据可灵活配置发送方式到多个地方。也支持api接口直接拉取数据

python监控脚本框架,从db、java模块api、redis等获取数据,计算指标并发送

整体架构可插件化、有通用标准功能、也可定制化开发

指标可直接推送至watcher(dashboard)系统添加监控页

报警方式有mail、sms、qtalk

python监控脚本框架主要包含四个重要组件:

metric_manager:指标管理器

graphite_sender:指标推送

Dbpool:数据库链接池管理

Scheduler:调度器,定时执行指标数据获取

2.5.3 数据流系统

采用xflume、kafka、storm、hdfs、hbase、redis、hive对业务日志、binlog等实时收集并处理。提供业务日志、订单生命周期日志、各种格式化日志的查询和一些监控指标的计算存储和报警。整体大致流程如下图所示:

业务和系统结构复杂后报警尤为重要。甄别哪些指标是必须报警的和报警阀值的确定是个很复杂的问题。一般有两种情况:一种是明确认为不能出现的,另一种是需要一定计算来决定是否要报警。当然有些基础层的服务出现问题,可能会导致连锁反应,那么如何甄别最直接的问题来报警,避免乱报影响判断是比较难的事情。目前针对这种情况系统会全报出来,然后人工基本判断下,比如接口响应慢报警,此时又出现了DB慢查询报警,那基本可以确认是DB的问题。

A、明确失败报警

日志NPE、业务FAIL、系统ERROR、Access (4xx\5xx)、接口异常、dubbo超时、fullgc、DB慢查询等

B、计算类报警

调用量特别小,波动明细,没有连续性,不具有对比性

期望值:如下图所示,当前值与期望值偏差加大

截止目前交易支付系统从收银台、交易、支付、网关、账务、基础服务、监控等各个模块的拆分并独立完善发展,针对高复杂业务和高并发访问的支撑相比以前强大很多。但还有很多不足的地方有待提高和完善。

继续期待交易支付3.0……

吕博,去哪儿网金融事业部研发工程师,毕业于吉林大学,2012年加入去哪儿网。致力于支付平台研发和支付环节的基础服务建设。

https://blog.csdn.net/oooo_mumuxi/article/details/96477324

本次分享我们从百亿流量交易系统 API 网关(API Gateway)的现状和面临问题出发,阐述微服务架构与 API 网关的关系,理顺流量网关与业务网关的脉络,带来最全面的 API 网关知识与经验。内容涉及:

计算机科学领域的任何问题都可以通过增加一个间接的中间层来解决。 —— David Wheeler

分布式服务架构、微服务架构与 API 网关

什么是 API 网关(API Gateway)

其实网关跟面向服务架构(Service Oriented Architecture,SOA)和微服务架构(MicroServices Architecture,MSA)有很深的渊源。

十多年以前,银行等金融机构完成全国业务系统大集中以后,分散的系统都变得集中,同时也带来各种问题:业务发展过快如何应对,对接系统过多如何集成和管理。为了解决这些问题,业界实现了作用于渠道与业务系统之间的中间层网关,即综合前置系统,由其适配各类渠道和业务,处理各种协议接入、路由与报文转换、同步异步调用等。

人们基于 SOA 的理念,在综合前置的基础上,进一步增加了服务的元数据管理、注册、中介、编排、治理等功能,逐渐形成了企业服务总线(ESB,Enterprise Service Bus)。

面向服务架构(SOA)是一种建设企业 IT 生态系统的架构指导**。SOA 的关注点是服务,服务最基本的业务功能单元,由平台中立性的接口契约来定义。通过将业务系统服务化,可以将不同模块解耦,各种异构系统间可以轻松实现服务调用、消息交换和资源共享。

不同于以往的孤立业务系统,SOA 强调整个企业 IT 生态环境是一个大的整体。整个 IT 生态中的所有业务服务构成了企业的核心 IT 资源。各系统的业务拆解为不同粒度和层次的模块和服务,服务可以组装到更大的粒度,不同来源的服务可以编排到同一个处理流程,实现非常复杂的集成场景和更加丰富的业务功能。

SOA 从更高的层次对整个企业 IT 生态进行统一的设计与管理,应用软件被划分为具有不同功能的服务单元,并通过标准的软件接口把这些服务联系起来,以 SOA 架构实现的企业应用可以更灵活快速地响应企业业务变化,实现新旧软件资产的整合和复用,降低软件整体拥有成本。

当然基于 ESB 这种集中式管理的 SOA 方案也存在着种种问题,特别是面向互联网技术领域的爆发式发展的情况下。

分布式服务架构、微服务架构与 API 网关

而近年来,随着互联网技术的飞速发展,为了解决以 ESB 这种集中式管理的 SOA 方案的种种问题,以 Apache Dubbo(2011 年开源后)与新近出现的 Spring Cloud 为代表的分布式技术的出现,给了 SOA 实现的另外一个选择:去中心化的分布式服务架构(DSA)。分布式服务架构技术不再依赖于具体的服务中心容器技术(比如 ESB),而是将服务寻址和调用完全分开,这样就不需要通过容器作为服务代理,在运行期实现最搞笑的直连调用。

进而又在此基础上随着 REST、Docker 容器化、领域建模、自动化测试运维等领域的发展,逐渐形成了微服务架构(MSA)。在微服务架构里,服务的粒度被进一步细分,各个业务服务可以被独立的设计、开发、测试、部署和管理。这时,各个独立部署单元可以用不同的开发测试团队维护,可以使用不同的编程语言和技术平台进行设计,这就要求必须使用一种语言和平台无关的服务协议作为各个单元间的通讯方式。

我们可以看到微服务架构中,由于系统和服务的细分,导致系统结构变得非常复杂,REST API 由于其简单、高效、跨平台、易开发、易测试、易集成,成为了不二选择。此时一个类似综合前置的系统就产生了,这就是 API 网关(API Gateway)。API 网关作为分散在各个业务系统微服务的 API 聚合点和统一接入点,外部请求通过访问这个接入点,即可访问内部所有的 REST API 服务。

跟 SOA/ESB 类似,企业内部向外暴露的所有业务服务能力,都可以通过 API 网关上管理的 API 服务来得以体现,所以 API 网关上也就聚合了企业所有直接对外提供的 IT 业务能力。

API 网关的技术趋势

我们从百度指数趋势看到,SpringCloud 和 SOA 非常火,MSA、gRPC、Gateway 也都有着非常高的关注度,而且这些技术的搜索趋势都正相关。

另一方面,我们可以通过 Github 的搜索来看,Gateway 类型的项目也非常多。

https://github.com/search?o=desc&p=1&q=gateway&s=stars&type=Repositories

可以看到,前 10 页的 100 个项目,使用 Go 语言实现的 Gateway 差不多占一半,语言分类上来看:

Go > NodeJS/JavaScript > Java > Lua > C/C++ > PHP > Python/Ruby/Perl

API 网关的定义、职能与关注点

API 网关的定义

网关的角色是作为一个 API 架构,用来保护、增强和控制对于 API 服务的访问。

The role of a Gateway in an API architecture is to protect, enrich and control access to API services.

API 网关是一个处于应用程序或服务(提供 REST API 接口服务)之前的系统,用来管理授权、访问控制和流量限制等,这样 REST API 接口服务就被 API 网关保护起来,对所有的调用者透明。因此,隐藏在 API 网关后面的业务系统就可以专注于创建和管理服务,而不用去处理这些策略性的基础设施。

这样,网关系统就可以代理业务系统的业务服务 API。此时网关接受外部其他系统的服务调用请求,也需要访问后端的实际业务服务。在接受请求的同时,可以实现安全相关的系统保护措施。在访问后端业务服务的时候,可以根据相关的请求信息做出判断,路由到特定的业务服务上,或者调用多个服务后聚合成新的数据返回给调用方。网关系统也可以把请求的数据做一些过程和预处理,同理也可以把返回给调用者的数据做一些过滤和预处理,即根据需要对请求头/响应头、请求报文/响应报文做一些修改处理。如果不做这些额外的处理,最简单直接的代理服务 API 功能,我们一般叫做透传。

同时,由于 REST API 的语言无关性,我们可以看出基于 API 网关,我们的后端服务可以是任何异构系统,不论是 Java、Dotnet、Python,还是 PHP、ROR、NodeJS 等,只要是支持 REST API,就可以被 API 网关管理起来。

API 网关的职能

一般来说,API 网关有四大职能:

API 网关的关注点

通过以上的分析可以看出,API 网关不是一个典型的业务系统, 而是一个为了让业务系统更专注与业务服务本身,给API服务提供更多附加能力的一个中间层。

这样在设计和实现 API 网关时,两个目标需要考虑:

海量并发的 Gateway 最重要的三个关注点:

API 网关的分类与技术分析

API 网关的分类

如果我们对于上述的目标和关注点进行更深入的思考,就会发现一个很重要的问题:所有需要考虑的问题和功能可以分为两类。

一类是全局性的,跟具体的后端业务系统和服务完全无关的部分,比如安全策略、全局性流控策略、流量分发策略等。

一类是针对具体的后端业务系统,或者是服务和业务有一定关联性的部分,并且一般被直接部署在业务服务的前面。

这样,随着互联网的复杂业务系统的发展,这两类功能集合逐渐形成了现在常见的两种网关系统:流量网关和业务网关。

流量网关与 WAF

我们定义全局性的、跟具体的后端业务系统和服务完全无关的策略网关,即为流量网关。这样流量网关关注于全局流量的稳定与安全,具体比如防止各类 SQL 注入,黑白名单控制,接入请求到业务系统的 Loadbalance 等,通常有如下的一些通用性功能:

等等。

通过这个功能清单,我们可以发现,流量网关的功能跟 Web 应用防火墙(WAF)非常类似。WAF一般是基于 Nginx/OpenResty 的 ngx_lua 模块开发的 Web 应用防火墙。

WAF 一般代码很简单,关注于使用简单,高性能和轻量级。简单的说就是在 Nginx 本身的代理能力以外,添加了安全相关功能。一句话来描述其原理,就是解析 HTTP 请求(协议解析模块),规则检测(规则模块),做不同的防御动作(动作模块),并将防御过程(日志模块)记录下来。

一般的 WAF 具有如下功能:

几个 WAF 开源实现

以上 WAF 的内容主要参考如下两个项目:

流量网关的开源实例,还可以参考著名的开源项目 Kong(基于 OpenResty)。

业务网关

我们定义针对具体的后端业务系统,或者是服务和业务有一定关联性的策略网关,即为业务网关。比如针对某个系统、某个服务或者某个用户分类的流控策略,针对某一类服务的缓存策略,针对某个具体系统的权限验证方式,针对某些用户条件判断的请求过滤,针对具体几个相关API的数据聚合封装等等。

业务网关一般部署在流量网关之后,业务系统之前,比流量网关更靠近系统。我们大部分情况下说的 API 网关,狭义上指的是业务网关。并且如果系统的规模不大,我们也会将两者合二为一,使用一个网关来处理所有的工作。具体的业务网关设计实现,将在下面的篇章详细介绍。

常见的开源网关介绍

目前常见的开源网关大致上按照语言分类有如下几类:

按照使用数量、成熟度等来划分,主流的有 4 个:

Nginx+Lua

Open Resty

OpenResty® 是一个基于 Nginx 与 Lua 的高性能 Web 平台,其内部集成了大量精良的 Lua 库、第三方模块以及大多数的依赖项。用于方便地搭建能够处理超高并发、扩展性极高的动态 Web 应用、Web 服务和动态网关。

OpenResty® 通过汇聚各种设计精良的 Nginx 模块(主要由 OpenResty 团队自主开发),从而将 Nginx 有效地变成一个强大的通用 Web 应用平台。这样,Web 开发人员和系统工程师可以使用 Lua 脚本语言调动 Nginx 支持的各种 C 以及 Lua 模块,快速构造出足以胜任 10K 乃至 1000K 以上单机并发连接的高性能 Web 应用系统。

OpenResty® 的目标是让你的 Web 服务直接跑在 Nginx 服务内部,充分利用 Nginx 的非阻塞 I/O 模型,不仅仅对 HTTP 客户端请求,甚至于对远程后端诸如 MySQL、PostgreSQL、Memcached 以及 Redis 等都进行一致的高性能响应。

以上介绍来自于 OpenResty 网站中文版。简单的说,OpenResty 基于 Nginx,集成了 Lua 语言和 Lua 的各种工具库,可用的第三方模块,这样我们就在 Nginx 既有的高效 HTTP 处理的基础上,同时获得了 Lua 提供的动态扩展能力。因此,我们可以做出各种符合我们需要的网关策略的 Lua 脚本,以其为基础实现我们的网关系统。

Kong

项目地址:

Kong 基于 OpenResty,是一个云原生、快速、可扩展、分布式的微服务抽象层(Microservice Abstraction Layer),也叫 API 网关(API Gateway),在 Service Mesh 里也叫 API 中间件(API Middleware)。

Kong 开源于 2015 年,核心价值在于高性能和扩展性。从全球 5000 强的组织统计数据来看,Kong 是现在依然在维护的,在生产环境使用最广泛的 API 网关。

Kong 宣称自己是世界上最流行的开源微服务 API 网关(The World’s Most Popular Open Source Microservice API Gateway)。

核心优势:

ABTestingGateway

项目地址:

https://github.com/CNSRE/ABTestingGateway

ABTestingGateway 是一个可以动态设置分流策略的网关,关注与灰度发布相关领域,基于 Nginx 和 ngx-lua 开发,使用 Redis 作为分流策略数据库,可以实现动态调度功能。

ABTestingGateway 是新浪微博内部的动态路由系统 dygateway 的一部分,目前已经开源。在以往的基于 Nginx 实现的灰度系统中,分流逻辑往往通过 rewrite 阶段的 if 和 rewrite 指令等实现,优点是性能较高,缺点是功能受限、容易出错,以及转发规则固定,只能静态分流。ABTestingGateway 则采用 ngx-lua,通过启用 lua-shared-dict 和 lua-resty-lock 作为系统缓存和缓存锁,系统获得了较为接近原生 Nginx 转发的性能。

功能特性:

据了解,美团内部的 Oceanus 也是基于 Nginx 和 ngx_lua 扩展实现,主要提供服务注册与发现、动态负载均衡、可视化管理、定制化路由、安全反扒、session ID 复用、熔断降级、一键截流和性能统计等功能。

Java

Zuul/Zuul2

项目地址:https://github.com/Netflix/zuul

Zuul 是 Netflix 开源的 API 网关系统,它的主要设计目标是动态路由、监控、弹性和安全。

Zuul 的内部原理可以简单看做是很多不同功能 filter 的集合(PS:作为对比,ESB 也可以简单被看做是管道(channel)和过滤器(filter)的集合),这些 filter 可以使用 Groovy 或其他基于 JVM 的脚本编写(当然 Java 也可以编写),放置在指定的位置,然后可以被 Zuul Server 轮询发现变动后动态加载并实时生效。

Zuul 目前有两个大的版本,1.x 和 2.x,这两个版本差别很大。

Zuul 1.x 基于同步 IO,也是 Spring Cloud 全家桶的一部分,可以方便的配合 Spring Boot/Spring Cloud 配置和使用。

在 Zuul 1.x 里,filter 的种类和处理流程可以参见下图,最主要的就是 pre、routing、post 这三种过滤器,分别作用于调用业务服务 API 之前的请求处理、直接响应、调用业务服务 API 之后的响应处理。

Zuul 2.x 最大的改进就是基于 Netty Server 实现了异步 IO 来接入请求,同时基于 Netty Client 实现了到后端业务服务 API 的请求。这样就可以实现更高的性能、更低的延迟。此外也调整了 filter 类型,将原来的三个核心 filter 显式命名为:Inbound Filter、Endpoint Filter 和 Outbound Filter。

Zuul 2.x 核心功能:

Spring Cloud Gateway

项目地址:

https://github.com/spring-cloud/spring-cloud-gateway/

Spring Cloud Gateway 基于 Java 8、Spring 5.0、Spring Boot 2.0、Project Reactor,发展的比 Zuul 2 要早,目前也是 Spring Cloud 全家桶的一部分。

Spring Cloud Gateway 可以看做是一个 Zuul 1.x 的升级版和代替品,比 Zuul 2 更早的使用 Netty 实现异步 IO,从而实现了一个简单、比 Zuul 1.x 更高效的、与 Spring Cloud 紧密配合的 API 网关。

Spring Cloud Gateway 里明确的区分了 Router 和 Filter,并且一个很大的特点是内置了非常多的开箱即用功能,并且都可以通过 SpringBoot 配置或者手工编码链式调用来使用。

比如内置了 10 种 Router,使得我们可以直接配置一下就可以随心所欲的根据 Header、或者 Path、或者 Host、或者 Query 来做路由。

比如区分了一般的 Filter 和全局 Filter,内置了 20 种 Filter 和 9 种全局 Filter,也都可以直接用。当然自定义 Filter 也非常方便。

核心特性:

gravitee gateway

项目地址:

Kaazing WebSocket Gateway

项目地址:

Kaazing WebSocket Gateway 是一个专门针对和处理 Websocket 的网关,其宣称提供世界一流的企业级 WebSocket 服务能力。

具体如下特性:

Dromara soul

Go

fagongzi

项目地址:

fagongzi gateway 是一个 Go 实现的功能全面的 API Gateway,自带了一个 Rails 实现的 Web UI 管理界面。

功能特性:

Janus

项目地址:

Janus 是一个轻量级的 API Gateway 和管理平台,它能帮你实现控制谁,什么时候,如何访问这些 REST API,同时它也记录了所有的访问交互细节和错误。

使用 Go 实现 API 网关的一个好处在于,一般只需要一个单独的二进制文件即可运行,没有复杂的依赖关系(No dependency hell)。

功能特性:

Dotnet

Ocelot

项目地址:

核心特性:

NodeJS

Express Gateway

项目地址:

Express Gateway 是一个基于 NodeJS 开发,Express 和 Express 中间件实现的 REST API 网关。

核心特性:

microgateway

项目地址:

StrongLoop 是 IBM 的一个子公司,Microgateway 网关基于 Node.js/Express 和 Nginx 构建,作为 IBM API Connect,同时也是 IBM 云生态的一部分。

Microgateway 是一个聚焦于开发者,可扩展的网关框架,它可以增强我们对微服务和 API 的访问能力。

核心特性:

此外,Microgateway 还有几个特性:

核心架构如下图所示:

四大开源网关的对比分析(OpenResty/Kong/Zuul2/SpringCloudGateway 等)

OpenResty/Kong/Zuul2/SpringCloudGateway 重要特性对比

| 网关 | 限流 | 鉴权 | 监控 | 易用性 | 可维护性 | 成熟度 |

|---|---|---|---|---|---|---|

| Spring Cloud Gateway | 可以通过IP,用户,集群限流,提供了相应的接口进行扩展 | 普通鉴权、auth2.0 | Gateway Metrics Filter | 简单易用 | spring系列可扩展强,易配置 可维护性好 | spring社区成熟,但gateway资源较少 |

| Zuul2 | 可以通过配置文件配置集群限流和单服务器限流亦可通过filter实现限流扩展 | filter中实现 | filter中实现 | 参考资料较少 | 可维护性较差 | 开源不久,资料少 |

| OpenResty | 需要lua开发 | 需要lua开发 | 需要开发 | 简单易用,但是需要进行的lua开发很多 | 可维护性较差,将来需要维护大量lua脚本 | 很成熟资料很多 |

| Kong | 根据秒,分,时,天,月,年,根据用户进行限流。可在原码的基础上进行开发 | 普通鉴权,Key Auth鉴权,HMAC,auth2.0 | 可上报datadog,记录请求数量,请求数据量,应答数据量,接收于发送的时间间隔,状态码数量,kong内运行时间 | 简单易用,api转发通过管理员接口配置,开发需要lua脚本 | "可维护性较差,将来需要维护大量lua库 | 相对成熟,用户问题汇总,社区,插件开源 |

以限流功能为例:

对 Zuul/Zuul2/Spring Cloud Gateway 的一些功能点分析可以参考 Spring Cloud Gateway 作者 Spencer Gibb 的文章:

https://spencergibb.netlify.com/preso/detroit-cf-api-gateway-2017-03/

OpenResty/Kong/Zuul2/SpringCloudGateway 性能测试对比

分别使用 3 台 4Core16G 内存的机器,作为 API 服务提供者、Gateway、压力机,使用 wrk 作为性能测试工具,对 OpenResty/Kong/Zuul2/SpringCloudGateway 进行简单小报文的情况进行性能测试。

(Spring Cloud Gateway、Zuul2、OpenResty、Kong 的性能对比)

上图中 y 轴坐标是 QPS,x 轴是一个 Gateway 的数据,每根线是一个场景下的不同网关数据,测试结论如下:

开源网关的技术总结

开源网关的测试分析

脱离场景谈性能,都是耍流氓。性能就像温度,不同的场合下标准是不一样的。同样是 18 摄氏度,老人觉得冷,小孩觉得很合适,企鹅觉得热,冰箱里的蔬菜可能要坏了。

同样基准条件下,不同的参数和软件,相对而言的横向比较,才有价值。比如同样的机器(比如 16G 内存/4Core),同样的 server(用 Spring Boot,配置路径 api/hello 返回一个 helloworld),同样的压测方式和工具(比如用 WRK,10 线程,20 并发连接),我们测试直接访问 server 得到的极限 QPS(QPS-Direct,29K);和配置了一个 Spring Cloud Gateway 做网关访问的极限 QPS(QPS-SCG,11K)、同样方式配置一个 Zuul2 做网关压测得到的极限 QPS(QPS-Zuul2,13K),Kong 得到的极限 QPS(QPS-Kong,21K),OpenResty 得到的极限 QPS(QPS-OR,19K),这个对比就有意义了。

Kong 的性能非常不错,非常适合做流量网关,并且对于 service、route、upstream、consumer、plugins 的抽象,也是自研网关值得借鉴的。

对于复杂系统,不建议业务网关用 Kong,或者更明确的说是不建议在 Java 技术栈的系统深度定制 Kong 或 OpenResty,主要是工程性方面的考虑。举个例子:假如我们有很多个不同业务线,鉴权方式五花八门,都是与业务多少有点相关的。这时如果把鉴权在网关实现,就需要维护大量的 Lua 脚本,引入一个新的复杂技术栈是一个成本不低的事情。

Spring Cloud Gateway/Zuul2 对于 Java 技术栈来说比较方便,可以依赖业务系统的一些 common jar。Lua 不方便,不光是语言的问题,更是复用基础设施的问题。另外,对于网关系统来说,性能不是差一个数量级,问题不大,多加 2 台机器就可以搞定。

目前测试的总结来看,如果服务都是 2ms 级别,直连的性能假如是 100,Kong 可以到 60,OpenResty 是 50,Zuul2 和 Spring Cloud Gateway 是 35,如果服务本身的 latency 大一点,这些个差距会逐步缩小。

目前来看 Zuul2 的坑还是比较多的:

所以简单使用或者轻度定制业务网关系统,目前比较建议使用 Spring Cloud Gateway 作为基础骨架。

各类网关的 demo 与测试

以上测试用到的模拟服务和网关 demo 代码,大部分可以在这里找到:

这里也简单模拟了一个 NodeJS 做的 Gateway,加了 keep-alive 和 pool,demo 的性能测试结果大概是直连的 1/9,也就是 Spring Cloud Gateway 或 Zuul2 的 1/4 左右。

百亿流量交易系统 API 网关的现状和面临问题

百亿流量系统面对的业务现状

我们目前面临的现状是日常十几万的并发在线长连接数(不算短连接),每天长连接总数 3000 万+,每天 API 的调用次数超过 100 亿,每天交易订单数 1.5 亿。

在这个情况下,API 网关设计的一个重要目标就是:如何借助 API 网关为各类客户提供精准、专业、个性化的服务,保障客户实时的获得业务系统的数据和业务能力。

网关系统与其他系统的关系

我们的业务里,API 网关系统与其他系统的关系大致如下图所示:

网关系统典型的应用场景

我们的 API 网关系统为 Web 端、移动 APP 端客户提供服务,同时也为大量 API 客户提供 API 调用服务,同时支持 REST API 和 WebSocket 协议。

作为实时交易系统的前置系统,必须精准及时为客户提供最新的行情和交易信息。一旦出现数据的延迟或者错误,都会给客户造成无法挽回的损失。

另外针对不同的客户和渠道,网关系统需要提供不同的安全、验证、流控、缓存策略,同时可以随时聚合不同视角的数据进行预处理,保障系统的稳定可靠和数据的实时精确。

交易系统 API 的特点

作为一个全球性的交易系统,API 的特点总结如下:

交易系统 API 网关面临的问题

问题 1:流量的不断增加

如何合理控制流量,如何应对突发流量,怎么样最大程度的保障系统稳定,都是重要的问题。特别网关作为一个直接面对客户的系统,任何问题都会放大百倍。很多千奇百怪的重来没人遇到的问题都随时可能出现。

问题 2:网关系统越来越复杂

现有的业务网关经过多年发展,里面有大量的业务嵌入,并且存在很多个不同的业务网关,相互之间没有任何关系,也没有沉淀出基础设施。

同时技术债务太多,系统里硬编码实现了全局性网关策略以及很多业务规则,导致维护成本较大。

问题 3:API 网关管理比较困难

海量并发下 API 的监控指标设计和数据的收集也是一个不小的问题。7x24 小时运行的技术支持也导致维护成本较高。

问题 4:推送还是拉取的选择

使用短连接还是长连接,REST API 还是 WebSocket?

业务渠道较多(多个不同产品线的 Web、App、API 等形成十几个不同的渠道),导致用户的使用行为难以控制。

业务网关的设计与最佳实践

API 网关 1.0

我们的 API 网关 1.0 版本是多年前开发的,是直接使用 OpenResty 定制的,全局的安全测试、流量的路由转发策略、针对不同级别的限流等都是直接用 Lua 脚本实现。

这样就导致在经历了业务飞速发展以后,系统里存在了非常多的相同功能或不同功能的 Lua 脚本,每次上线或维护都需要找到影响的其中几个或几十个 Lua 脚本,进行策略调整,非常不方便,策略控制的粒度也不够细。

API 网关 2.0

在区分了流量网关和业务网关以后,2017 年开始实现了流量网关和业务网关的分离,流量网关继续使用 OpenResty 定制,只保留少量全局性,不经常改动的配置功能和对应的 Lua 脚本。

业务网关使用 Vert.x实现的 Java 系统,部署在流量网关和后端业务服务系统之间,利用 Vert.x 的反应式编程能力和异步非阻塞 IO 能力、分布式部署的扩展能力,这样就初步解决了问题 1 和问题 2。

Vert.x 是一个基于事件驱动和异步非阻塞 IO、运行于 JVM 上的框架,如下图所示。在 Vert.x 里,Verticle 是最基础的开发和部署单元,不同的 Vert.x 可以通过 Event Bus 传递数据,进而方便的实现高并发性能的网络程序。关于 Vert.x 原理的分析可以参考阿里宿何的 blog:https://www.sczyh30.com/tags/Vert-x/

Vert.x 同时也很好的支持 Websocket 协议,所以可以方便的实现支持 REST API 和 Websocket、完全异步的网关系统。

一个高性能的 API 网关系统,缓存是必不可少的部分。无论是分发冷热数据,降低对业务系统的压力,还是作为中间数据源,为服务聚合提供高效可复用的业务数据,都发挥了巨大作用。而一个优秀、高效的缓存系统,也必须是需要针对所承载的业务数据特点,进行特定设计和实现的。

API 网关的日常监控

我们使用多种工具对 API 进行监控和管理,全链路访问跟踪、连接数统计分析、全世界重要国家和城市的波测访问统计。网关技术团队每时每刻都关注着数据的变化趋势。各个业务系统研发团队,每天安排专人关注自己系统的 API 性能,推进性能问题解决和持续优化。这就初步解决了问题 3。

推荐外部客户使用 Websocket

由于外部客户需要自己通过 API 网关调用 API 服务来集成业务服务能力到自己的系统,各个客户的技术能力和系统处理能力有较大差异,使用行为也各有不同。对于不断发展变动的交易业务数据,客户调用 API 频率太低则会影响数据实时性,调用频率太高则可能会浪费双方的系统资源。同时利用 Websocket 的消息推送特点,我们可以在网关系统控制客户接受消息的频率、单个用户的连接数量等,随时根据业务系统的情况动态进行策略调整。综合考虑,Websocket 是一个比 REST API 更加实时可靠,更加易于管理的方式。通过逐步协助和鼓励客户使用 Websocket 协议上,基本解决了问题 4。

API 网关的性能优化

API 网关系统作为 API 的统一接入点,为了给用户提供最优质的用户体验,必须长期做性能优化工作。

不仅 API 网关自己做优化,同时可以根据监控情况,时刻发现各业务系统的 API 服务能力,以此为出发点,推动各个业务系统不断优化 API 性能。

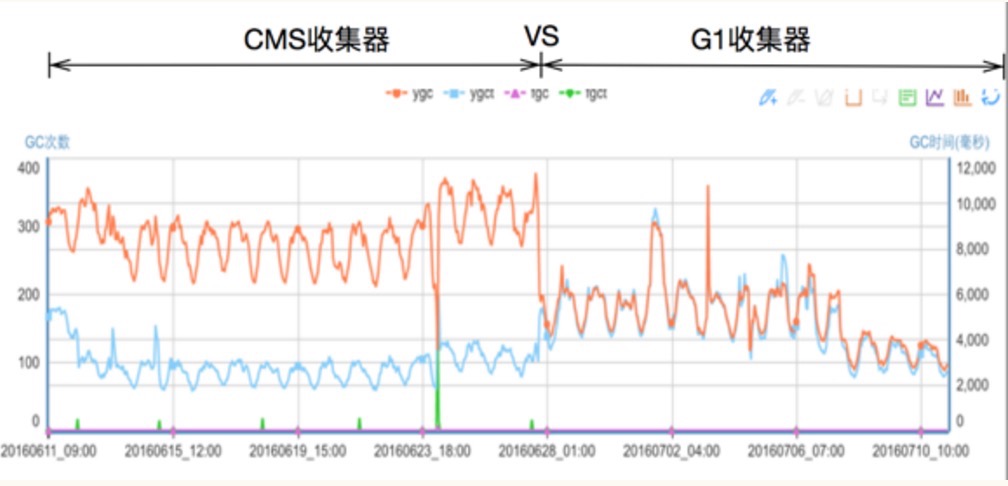

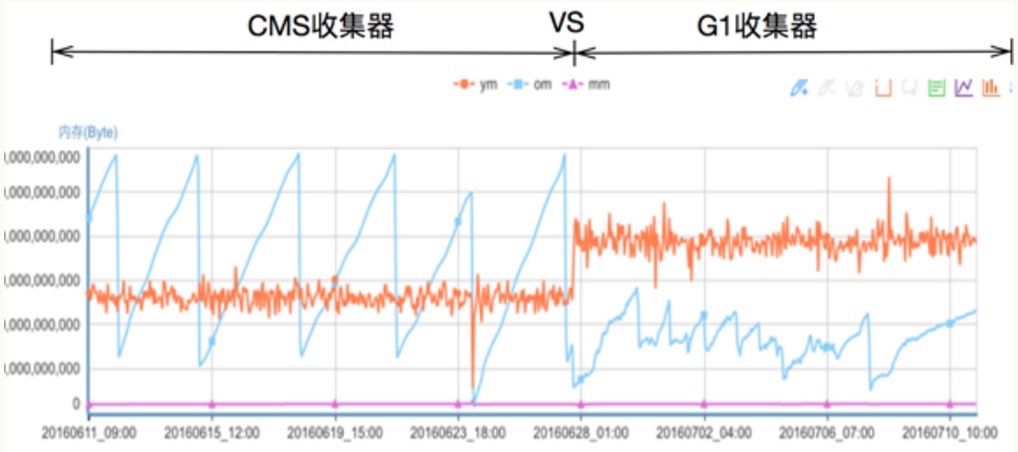

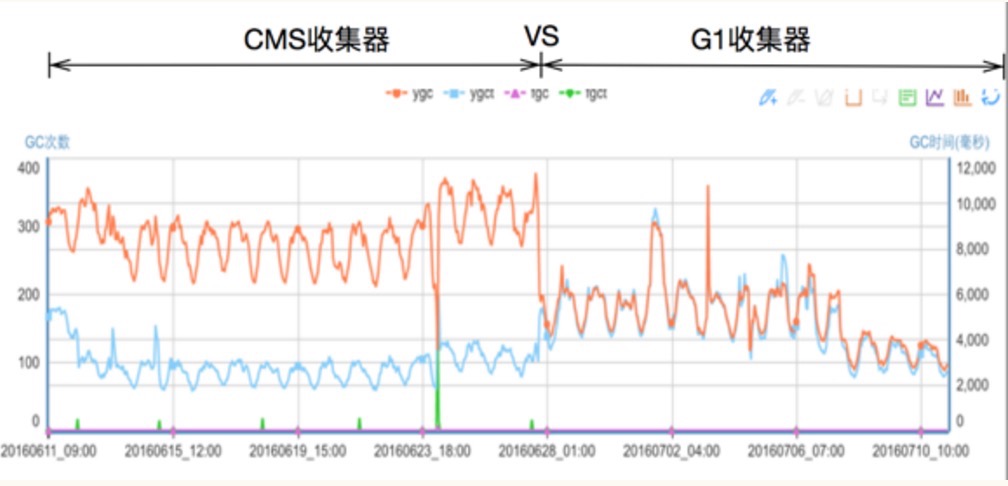

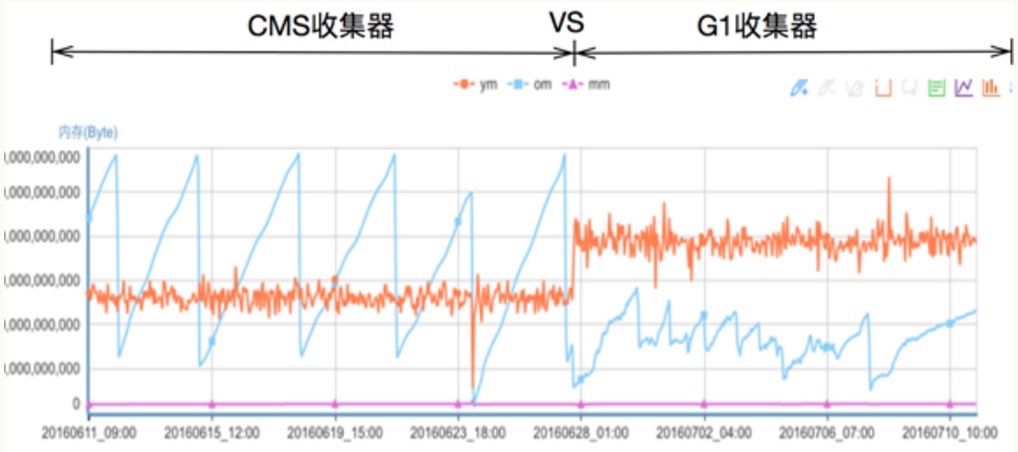

在此举一个具体的例子,某个网关系统发现连接经常剧烈抖动(如下图所示),严重影响系统的稳定性、浪费系统资源,经过排除发现:

针对如上分析,我们采取了几个处理方式:

优化前:

优化后:

对 API 网关的发展展望

经历接近一年的开发、三个候选版本,Redis 7.0终于正式发布,这是Redis历史上改变最多的一个大版本,它不仅包含了50多个新命令,还有大量核心新特性与改进,这些不仅能够解决用户使用中的诸多问题,还进一步拓展了Redis的使用场景。

Function是Redis脚本方案的全新实现,在Redis 7.0之前用户只能使用EVAL命令族来执行Lua脚本,但是Redis对Lua脚本的持久化和主从复制一直是undefined状态,在各个大版本甚至release版本中也都有不同的表现。因此社区也直接要求用户在使用Lua脚本时必须在本地保存一份(这也是最为安全的方式),以防止实例重启、主从切换时可能造成的Lua脚本丢失,维护Redis中的Lua脚本一直是广大用户的痛点。

Function的出现很好的对Lua脚本进行了补充,它允许用户向Redis加载自定义的函数库,一方面相对于EVALSHA的调用方式用户自定义的函数名可以有更为清晰的语义,另一方面Function加载的函数库明确会进行主从复制和持久化存储,彻底解决了过去Lua脚本在持久化上含糊不清的问题。

那么自7.0开始,Function命令族和EVAL命令族有了各自明确的定义:FUNCTION LOAD会把函数库自动进行主从复制和持久化存储;而SCRIPT LOAD则不会进行持久化和主从复制,脚本仅保存在当前执行节点。并且社区也在计划后续版本中让Function支持更多语言,例如JavaScript、Python等,敬请期待。

总的来说,Function在7.0中被设计为数据的一部分,因此能够被保存在RDB、AOF文件中,也能通过主从复制将Function由主库复制到所有从库,可以有效解决之前Lua脚本丢失的问题,我们也非常建议大家逐步将Redis中的Lua脚本替换为Function。

AOF是Redis数据持久化的核心解决方案,其本质是不断追加数据修改操作的redo log,那么既然是不断追加就需要做回收也即compaction,在Redis中称为AOF rewrite。

然而AOF rewrite期间的增量数据如何处理一直是个问题,在过去rewrite期间的增量数据需要在内存中保留,rewrite结束后再把这部分增量数据写入新的AOF文件中以保证数据完整性。可以看出来AOF rewrite会额外消耗内存和磁盘IO,这也是Redis AOF rewrite的痛点,虽然之前也进行过多次改进但是资源消耗的本质问题一直没有解决。

阿里云的Redis企业版在最初也遇到了这个问题,在内部经过多次迭代开发,实现了Multi-part AOF机制来解决,同时也贡献给了社区并随此次7.0发布。具体方法是采用base(全量数据)+inc(增量数据)独立文件存储的方式,彻底解决内存和IO资源的浪费,同时也支持对历史AOF文件的保存管理,结合AOF文件中的时间信息还可以实现PITR按时间点恢复(阿里云企业版Tair已支持),这进一步增强了Redis的数据可靠性,满足用户数据回档等需求。

对具体实现感兴趣的同学可以查看本文末尾参考资料。

Redis自2.0开始便支持发布订阅机制,使用pubsub命令族用户可以很方便地建立消息通知订阅系统,但是在cluster集群模式下Redis的pubsub存在一些问题,最为显著的就是在大规模集群中带来的广播风暴。

Redis的pubsub是按channel频道进行发布订阅,然而在集群模式下channel不被当做数据处理,也即不会参与到hash值计算无法按slot分发,所以在集群模式下Redis对用户发布的消息采用的是在集群中广播的方式。

那么问题显而易见,假如一个集群有100个节点,用户在节点1对某个channel进行publish发布消息,该节点就需要把消息广播给集群中其他99个节点,如果其他节点中只有少数节点订阅了该频道,那么绝大部分消息都是无效的,这对网络、CPU等资源造成了极大的浪费。

Sharded-pubsub便是用来解决这个问题,意如其名,sharded-pubsub会把channel按分片来进行分发,一个分片节点只负责处理属于自己的channel而不会进行广播,以很简单的方法避免了资源的浪费。

Redis 使用标准版本标记进行版本控制:major.minor.patchlevel。

偶数的版本号表示稳定的版本, 例如 1.2,2.0,2.2,2.4,2.6,2.8。

奇数的版本号用来表示非标准版本,例如2.9.x是非稳定版本,它的稳定版本是3.0。

Redis2.6在2012年正式发布,经历了17个版本,到2.6.17版本,相比于Redis2.4,主要特性如下:

1) 服务端支持Lua脚本。

2) 去掉虚拟内存相关功能。

3) 放开对客户端连接数的硬编码限制。

4) 键的过期时间支持毫秒。

5) 从节点提供只读功能。

6) 两个新的位图命令:bitcount和bitop。

7) 增强了redis-benchmark的功能:支持定制化的压测,CSV输出等功能。

8) 基于浮点数自增命令:incrbyfloat和hincrbyfloat。

9) redis-cli可以使用–eval参数实现Lua脚本执行。

10) shutdown命令增强。

11) info可以按照section输出,并且添加了一些统计项。

12) 重构了大量的核心代码,所有集群相关的代码都去掉了,cluster功能将会是3.0版本最大的亮点。

13) sort命令优化。

Redis2.8在2013年11月22日正式发布 经历了24个版本,到2.8.24版本,相比于Redis2.6,主要特性如下:

1) 添加部分主从复制的功能,在一定程度上降低了由于网络问题, 造成频繁全量复制生成RDB对系统造成的压力。

2) 尝试性地支持IPv6。

3) 可以通过config set命令设置maxclients。

4) 可以用bind命令绑定多个IP地址。

5) Redis设置了明显的进程名,方便使用ps命令查看系统进程。

6) config rewrite命令可以将config set持久化到Redis配置文件中。

7) 发布订阅添加了pubsub命令。

8) Redis Sentinel第二版,相比于Redis2.6的Redis Sentinel,此版本已经变成生产可用。

Redis3.0在2015年4月1日正式发布,截止到本书完成已经到3.0.7版本,相比于Redis2.8主要特性如下:

Redis3.0最大的改动就是添加Redis的分布式实现Redis Cluster,填补了Redis官方没有分布式实现的空白。Redis Cluster经历了4年才正式发布也是有原因的,具体可以参考Redis Cluster的开发日志

1) Redis Cluster: Redis的官方分布式实现。

2) 全新的embedded string对象编码结果,优化小对象内存访问,在特定的工作负载下速度大幅提升。

3) lru算法大幅提升。

4) migrate连接缓存, 大幅提升键迁移的速度。

5) migrate命令两个新的参数copy和replace。

6) 新的client pause命令,在指定时间内停止处理客户端请求。

7) bitcount命令性能提升。

8) config set设置maxmemory时候可以设置不同的单位(之前只能是字节),例如config set

maxmemory1gb。

9) Redis日志小做调整:日志中会反应当前实例的角色(master或者slave)。

10) incr命令性能提升。

Redis3.2在2016年5月6日正式发布,相比于Redis3.0主要特征如下:

1) 添加GEO相关功能。

2) SDS在速度和节省空间上都做了优化。

3) 支持用upstart或者systemd管理Redis进程。

4) 新的List编码类型:quicklist。

5) 从节点读取过期数据保证一致性。

6) 添加了hstrlen命令。

7) 增强了debug命令 支持了更多的参数。

8) Lua脚本功能增强。

9) 添加了Lua Debugger。

10) config set支持更多的配置参数。

11) 优化了Redis崩溃后的相关报告。

12) 新的RDB格式,但是仍然兼容旧的RDB。

13) 加速RDB的加载速度。

14) spop命令支持个数参数。

15) cluster nodes命令得到加速。

16) Jemalloc更新到4.0.3版本。

可能出乎很多人的意料,Redis3.2之后的版本是4.0,而不是3.4、3.6、3.8。一般这种重大版本号的升级也意味着软件或者工具本身发生了重大变革,直到本书截稿前,Redis发布了4.0-RC2,下面列出Redis4.0的新特性:

1) 提供了模块系统,方便第三方开发者拓展Redis的功能,更多模块详见:http://redismodules.com/。

2) PSYNC2.0:优化了之前版本中,主从节点切换必然引起全量复制的问题。

3) 提供了新的缓存剔除算法:LFU(Last Frequently Used),并对已有算法进行了优化。

4) 提供了非阻塞del和flushall/flushdb功能,有效解决删除bigkey可能造成的Redis阻塞。

5) 提供了RDB-AOF混合持久化格式,充分利用了AOF和RDB各自优势。

6) 提供memory命令,实现对内存更为全面的监控统计。

7) 提供了交互数据库功能,实现Redis内部数据库之间的数据置换。

8) Redis Cluster兼容NAT和Docker。

Redis 5.0在2018年10月正式发布,相比于Redis4.0主要特征如下:

1) 新的流数据类型(Stream data type) https://redis.io/topics/streams-intro

2) 新的 Redis 模块 API:定时器、集群和字典 API(Timers, Cluster and Dictionary APIs)

3) RDB 增加 LFU 和 LRU 信息

4) 集群管理器从 Ruby (redis-trib.rb) 移植到了redis-cli 中的 C 语言代码

5) 新的有序集合(sorted set)命令:ZPOPMIN/MAX 和阻塞变体(blocking variants)

6) 升级 Active defragmentation 至 v2 版本

7) 增强 HyperLogLog 的实现

8) 更好的内存统计报告

9) 许多包含子命令的命令现在都有一个 HELP 子命令

10) 客户端频繁连接和断开连接时,性能表现更好

11) 许多错误修复和其他方面的改进

12) 升级 Jemalloc 至 5.1 版本

13) 引入 CLIENT UNBLOCK 和 CLIENT ID

14) 新增 LOLWUT 命令 http://antirez.com/news/123

15) 在不存在需要保持向后兼容性的地方,弃用 “slave” 术语

16) 网络层中的差异优化

17) Lua 相关的改进

18) 引入动态的 HZ(Dynamic HZ) 以平衡空闲 CPU 使用率和响应性

19) 对 Redis 核心代码进行了重构并在许多方面进行了改进

Redis 6.0在2020年5月正式发布,相比于Redis5.0主要特征如下:

1)ACL权限管控(包括ACL LOG)

2)客户端缓冲(Client side caching)

3)多线程 IO(Threaded I/O)

4)Redis集群代理

5)支持linux/bsd系统的CPU和线程(包括子线程如aof\rdb\IO线程)亲和力绑定

6)过期Key回收优化,新增主动配置参数

7)Resp3协议,兼容Resp2并更加简单、高效

8)优化了INFO命令,使之执行更快,优化了所有的阻塞命令,复杂度从O(n)到O(1),RDB加载速度优化,集群Slots命令优化,Psync2优化,修复了5.0的链式复制不一致问题。defrag优化,从试验版到正式版

9)新的module API

10)disque消息队列模块(module)

11)新增配置使Del命令如unlink执行

12)XINFO STREAM FULL流命令

13)CLIENT KILL USER username命令

14)全面支持SSL协议、并新增TSL协议

15)Redis-benchmark支持集群模式

16)重写 Systemd 支持

17)新增配置参数来删除用于在非持久性实例中进行复制的RDB文件

18)无磁盘复制副本(Diskless replication on replicas),从测试版优化,目前无磁盘复制在load

rdb仍是测试版。

Redis 7.0 RC1 于 2022 年 1 月 31 日发布,主要特性如下

1)Redis 函数:使用服务器端脚本扩展 Redis 的新方法

2) ACL:细粒度的基于密钥的权限,允许用户支持多个带有选择器的命令规则集

3) 集群:分片(特定于节点)发布/订阅支持

https://redis.io/topics/pubsub#sharded-pubsub

4) 在大多数情况下对子命令的一流处理

5) 命令元数据和文档 [https://redis.io/commands/command-docs,

https://redis.io/topics/command-tips](https://redis.io/commands/command-docs, https://redis.io/topics/command-tips)

6)命令键规格。一种更好的方式让客户找到关键论点及其读/写目的

https://redis.io/topics/key-specs

7)多部分 AOF 机制避免 AOF 重写开销

8)集群:支持主机名,而不仅仅是 IP 地址

9)改进了对网络缓冲区消耗的内存的管理,以及一个选项当总内存超过限制时删除客户端

10)Cluster:一种断开集群总线连接的机制,以防止不受控制的缓冲区增长

11)AOF:时间戳注释和对时间点恢复的支持

12)Lua:支持 EVAL

脚本中的函数标志https://redis.io/topics/eval-intro#eval-flags

13)Lua: 支持 Verbatim 和 Big-Number 类型的 RESP3 回复

14)Lua: 通过 redis.REDIS_VERSION, redis.REDIS_VERSION_NUM 获取 Redis 版本

“最重要的是选择,最困难的是坚持。”

我是在 2014 年入职饿了么,从前端和 PHP 一直做到后端架构和团队,从 2014 年到 2017 年陆续负责过公司客服、销售、代理商、支付、清结算、订单这些业务的产研与团队;2018 年从业务研发团队抽身,6 个人组起一个小组投身机器学习,试图结合实际的业务场景通过技术改造业务;2019 年回归到平台(中台)研发,负责交易、金融、营销三个中台的研发和团队工作。基于我在饿了么4年和阿里巴巴 2 年研发经历,从技术、业务、管理和架构层面分享一些我的思考。

技术层面

对开发同学而言,技术是立身之本,虽然往往面试造火箭入职拧螺丝,但不可否认的是,技术就是你从业的的基石。不管是基本的动手能力还是问题分析能力,包括你的思维逻辑乃至对事物认知的能力,技术思维都会时刻影响你。最明显的影响就是当你面对无数个问题的钉子时,技术是不是你最顺手的那把锤子。

技术上我比较关注的几个层面:

1、稳定性

稳定性是一个先有意识再有能力的事儿。记得在 2015 年年初,张雪峰加入饿了么担任 CTO 之后,从他嘴里最常听到的一句话就是“研发要对生产环境有敬畏”。

2014年下半年,各方人马开始杀入外卖市场,饿了么启动百城计划进行业务扩张,短时间内从10+城市覆盖到100+城市,日订单量也很快从10万上涨到100万。业务井喷的同时,技术还没有做好足够的准备。我印象中,2014年下半年几乎每天中午交易量都有新高,但同时也伴随着系统宕机、限流扩容、紧急调优、客服爆线、技术加班熬夜的问题。

我曾在新乡的客服中心看到有的客服同学突然崩溃,耳机直接摔下来离开工位,因为每天会接收到大量用户的来电责问,就在那一刻其实你才会清晰且直观的感受到:你在编辑器的每一行代码,你在服务器的每一次发布,会对现实世界很多活生生的人有直接的影响,你会突然意识到你的工作比你之前以为的要重要且有意义。

所谓研发要对生产环境有敬畏,就是你知道你的作品会对别人产生不好的影响,你会为不好的结果感到惭愧与内疚,这就产生了敬畏。应急处理有一个基本原则:“以业务影响最小为主,优先恢复为核心目的,不要纠结手段和根因。”

别把你的懊悔、决心、对稳定性的思考、各种奇妙的idea以及执行力体现在事故复盘会上,系统的安全生产和火灾一样,事前才有意义。

2 、链路设计

大部分产研缺少全链路的视角,往往看到的是自己负责的点,但是对于一条线乃至整个面是看不到的,也没有机会去思考这些,而对于一些大项目和长链路系统而言,这是致命的。

我的建议是,对你所负责的系统,它关键的上下游、核心业务的链路一定要熟悉,包括数据、接口(调用、功能、逻辑)、各种异常的处理和特殊的设计。能帮你达成这一目的的最简单的办法就是画图、画图、画图!重要的结论说三遍,一定要自己能把系统的大图画出来,然后做到可以根据大图随意放大和缩小。放大到将链路画到业务场景里,突出业务逻辑和上下游交互,缩小到某一次调用的处理逻辑大致是怎样,数据是怎么变化。

经常画图,不用纠结形式和标准,重要的是形成自己理解系统的一个框架,一个自己的思维方式,需要的时候可以随时拿出来用。

日常不管是聊需求还是做系统设计,习惯性的把图画出来,就达成了一半。剩下的一半就要看图去想、去找问题。

3、技术债务

永远不要骗自己说,现在为了这个需求先挖一个坑,过一段时间再来填(重构 or 重做)。

技术债务和金融债务一样,它必然存在,并且会像无赖一样一直赖着,隔三差五会爆发一下。随着时间的推移和业务的发展,你会发现架构越来越混乱,不同系统的领域边界越来越模糊,系统和需求与组织关系的映射越来越复杂,服务内编码风控越来越不一致,重复的轮子一个接一个隐蔽的出现。

“太忙了没时间梳理哪些问题”、“改那些问题需要上下游一起改,费时费力,推不动”、“现在还没出问题,而且正在整理了,别催”。这是我们经常会听到的声音。其实,技术同学多少都有点代码洁癖,有很多问题不处理不是主观的原因,而是客观上因为精力、时间、ROI等因素,往往要等问题真的爆发后,大家才能狠下心去处理那些问题 。

我以前处理技术债务的思路,是要有一个检查清单,我会定期的复盘所有的系统,并且结合自己团队和其他团队的事故去全量扫雷。系统本身是一个平衡的产物,是时间、功能、风险、未来可能性等几个方向平衡的结果。所以技术债务对于研发同学的考验,不在于你怎么在日常工作中保证系统技术债为0,而是你要评估清楚在有限的资源和时间下,哪些问题是刻不容缓的,哪些问题是可以往后放的。

很难想象一个没有技术追求的团队能开发出一个健壮的、可维护性好、可扩展性好的系统。相反,这种业务代码的堆砌,从短期看也许是“较快”实现了业务需求,但是从长远来看,这种烂系统的增加会极大地阻碍业务的发展,形成一个个的黑洞应用,而工程师被裹挟在业务需求和烂系统之间,疲于应对,心力交瘁。这种将就将导致系统腐化堕落,技术债越垒越高,丑陋的代码疯狂滋长,像肿瘤一样消耗你所有的能量,最后还要你的命。

4、警惕大项目

并不是所有人都有能力操盘大项目,也不是所有人都能够平衡好交付压力、上线质量、产品逻辑以及时间窗口,这是一个非常有挑战的工作,需要纯粹的技术能力之外的很多软性能力来辅助,比如组织的沟通协作能力、向上要权要责的能力、平衡产品业务期望的的能力、突发情况应急转变的能力等。越大的项目对于Owner的要求也越高,真能把大项目做好不怎么留大坑的少之又少。

大项目从启动到立项所用的时间很多时候是远超项目实际的开发周期的,项目的顺利推进需要“妥协”,但项目的成功需要坚持。很多项目之所以失败,是在做的过程中方方面面不断妥协,最后做出来的东西已经远离了最开始想要的样子。

业务层面

除了技术之外,研发同学对业务层面也需要提升认知与重视。

对于研发而言,业务就像是外语,你不理解业务就好比人在异国,与周围的环境格格不入,并且容易吃亏!相比产品、业务、运营等其他工种,技术更喜欢和技术打交道,业务在大多数同学眼中是混沌且缺少秩序的,没有技术那样清晰的实现路径和稳定共识的知识结构。并且技术相对容易证伪,而业务往往就是不停的尝试,研发都讨厌“不确定性”。但是在一个庞大的组织里想把技术做好,就必然要与业务打交道,毕竟业务才是一家公司存在的核心价值。

1、基于业务规划做技术规划

很多同学习惯于把计划等同于规划。阿里是一家尊重技术的商业公司,所有的团队都在谈业务、规划里是业务规划、周报里是业务项目、汇报里是业务成果、晋升的时候也要突出你的“战功”。相比技术本身,大家更关注技术改变了什么,在业务部分聊技术团队如何做规划的原因就在于此,这是公司运营的的起点(目的),延伸出来才有具体的技术规划和组织设计作为解决方案。

深刻理解业务并设计战略,拆解战役与项目,通过组织和各种机制确保项目的执行与落地,最终拿到业务结果,这是一个大公司的标准战略执行方式。研发同学做技术规划以及团队规划的时候,一定要考虑到你所在环境,公司今年要主打什么,所在大部门的目标是什么,对口的产品和业务现状如何,纯粹的技术迭代在业务上的好处在哪儿。另外,团队目前有哪些不可抗力,或者影响规划推进的阻力。

很多同学做规划的时候会习惯性按照这个思路进行:①总结现状(痛点) ② 对应的解决方案和策略 ③ 展望未来。有时候②和③的顺序会反过来。很多时候大家发现最终的部门规划和自己做的规划没什么关联,不知道怎么往哪个方向用力,或者干脆继续按照自己的计划先走着。

对大部分同学,我建议规划要实在。做技术规划前,找你周边的研发团队聊一下,找你对口的产品、运营聊一下,知道他们的目标是什么,知道公司几个重点是什么,然后结合你们目前的痛点,在现在和未来之前找平衡、找现在和未来都有收益的那部分。

规划中需要包含一些硬性的内容,比如这个目标要解决什么问题,怎么确定它解决了,解决得好不好,好的结果谁认可等。规划一定要有重点,没有重点那不叫规划,那是日程计划。很多同学对做规划不投入,也有自己的“想法”,比如公司业务或者战略变化太快、组织调整太频繁,下半年在哪个团队工作甚至做什么都不一定,所以规划做得并不认真。不否认变化频繁的存在,以及这种组织架构变化对规划的影响,但是如果你一直这样思考,你永远无法从变化中获得价值,因为你一直在置身事外。

2、研发要比产品还懂业务

雷军说过:“永远不要试图用战术上的勤奋,去掩盖你战略上的懒惰。”对于研发同学,你要比业务同学更懂业务,才能找到技术与业务平衡的空间。对大部分同学而言,常常是只熟悉自己负责的系统,但是对于想要更大空间和更多成长的同学,我可以给出明确的结论:只熟悉自己负责的系统是不够的。

首先,不同的人对熟悉的定义不一样。对于你负责、你贡献代码、你进行设计并且完成需求交付的系统,单是熟悉远不够。你不仅要知道它的前世今生,思考它的一路成长,纠结它的未来发展,同时还要清楚它的风险与隐患,它的生与死。

基于你最清楚的核心系统,由它开始做业务场景上的外延,以此了解你的上下游,并且能做到结合业务场景去挖掘。从业务的角度、从产品的链路、从技术的调优和隐患多个视角去切,让自己的设计维度与视角不断拉升,这样你有把握或者有掌控力的范围会越来越大,未来才会有更多的机会。

管理层面

团队是一个宏观与微观并存的事物,宏观上我们说组织、讲战略、定规划、要排兵布阵,微观上我们关注沟通、成长、情绪。大部分同学之所以在微观上受挫,就是因为没能把握到宏观的节奏。公司是一个盈利组织,技术中心是一个成本部门,技术中心之所以会有某一个组织,那么一定是:“公司期望这个组织解决某一类问题,并且解决到一定程度。”

所以在这里你要理解一个关键词,“结果和KPI”并不取决于你怎么定义它,而是给你下放目标的组织与管理者对你的期望是怎样的,你们的GAP往往未必是结果的差别,而是期望的落差。

1、拥抱变化

其实大多数时候不需要你去拥抱,变化会突如其来的抱住你,勒紧你的脖子让你有那么一瞬间觉得呼吸困难。互联网公司之所以变化快,很大程度取决于它的业务属性,相比传统公司,互联网公司能更快、更清晰地感受到与市场的契合程度,并且及时调整策略。

结合这几年的经历,到最近两年加入阿里巴巴,我的核心感悟有两个:

2、加人不能解决问题

即使嘴上再怎么说“不能”,但是动作会很诚实,依然会尽可能多地要HC,希望把更多“核心”的系统建设在你的职责范围内。其实,从管理的角度,你可以看一下你有没有“有效加人”,一些技术Leader不关注新人的 Landing ,相当于只盯数量不盯质量,最后结果肯定是一塌糊涂的。

从绝对理论的角度,加人肯定是有帮助的,你的资源变多了,周转的空间和操作的余地都丰富了。但是从经验看,大部分情况下,加人没有产生最终的价值变化(项目的结果、业务的成败)。因为系统的开发、项目的推进并不是单纯的资源堆砌,1000 人日的系统哪是 1000 个人做一天就做出来的。真实的世界里,我们往往不是败在资源的使用量上,而是资源的使用方向和使用效率上。

3、有意识地向上管理

这个问题源于过去经历的两个点:一是我经历了无数次的组织关系调整,我发现不管是我自己还是我团队的同学,大家相比于自己做什么以及带不带人、带多少人外,更关注的是自己的汇报线。自己汇报给谁,谁是我Leader,我和他处不处得来,他能不能让我有提高、有成长。二是很多同学会对与Leader的相处关系有困惑。

基于这两个点,我把向上管理作为一个单独的话题加了进来,先说结论:要!要!要!必须要!一定要!

连马老师都说员工离职的三大要素之一就是和Leader处不来,你怎么还能心安理得的忽略它。如果大家对于向上管理还停留在服从甚至谄媚的态度来处理你们的关系,我只能说太稚嫩了。我没有系统地学过向上管理,也没有体系化地看过这方面的书,所以我只说一下自己的理解。

个体在一个组织里想得到报酬和收益,基本的方法就是促进组织的成长与提高,并且同步提高自己,这样就可以从中分得自己的那份收益。这就要求你产出的结果是要对组织有正向溢出的,但是这个方向与标准并不是所有人都清楚或者能准确地把握到。

经常有绩效差的同学很沮丧甚至抱怨说自己经常加班,甚至是部门走的最晚的,周末也要处理工作等。先不讨论背景,如果命中上面这一条的,我先给你个忠告:除了按件计费的工厂,其它任何地方体力上的付出与最终结果都没有明显的直接关系。就像你上学的时候一定有那么几个别人家的孩子,要么就是特别努力学习特别好,要么就是看上去每天和你一起玩,但是成绩总是碾压你。从学校到社会,这个现象并没有消失,别迷信加班和体力上的付出,大多数人只要能不去思考,在体力上愿意做出的付出,远超你我的想象。

与Leader相处和沟通,本质上是为了达成一致的目标和互相认可的结果。这是一个非常关键的初衷,我有时候开玩笑和团队的同学聊,说你们要好好看看我的Leader到底想干嘛,这样你们做出来,我好去汇报。方向、节奏、结果的对焦对于工作的展开和拿成绩是至关重要的,同时你要从他身上获取更多的信息以便于自己的判断决策和学习,不断从他们身上吸取养分。

在一些环境中,体力上的付出是必须的,但是仅有体力上的付出最终只能感动你自己,你的团队并不想每天陪你加班到11点或者发布到凌晨2点,更没有兴趣凌晨1点半还拉个电话会讨论方案。所以一定要做好“期望管理”,Leader对你的期望、对项目的期望、你对他给予你空间和支持的期望,大家一定要对焦清楚,并且目标一致。

架构层面

还有一点我觉得也很重要,就是在架构层面,包括业务架构、技术选型和细节实现上,要有清醒的认知。

1、最关键的是定义问题

爱因斯坦说过:“提出问题比解决问题更重要!”定义问题是个脑力活,解决问题是个体力活。大家往往习惯于看到一个问题就冲上去锤它,从概率上来讲,很大可能会陷入一个解决问题的黑洞,就是你不停地在解决问题,但是最终你的情况没有变好。

当你面临一个困难或者一个情况时,首先比较重要的是定义问题,这到底是要解决什么、解决了有什么好处、怎么确定解决了。其次是定义结构,这个问题的关键点组成,你对应的解法是怎样的,这其中得失要怎么权衡轻重,并且最终解决的效果如何贯穿和透传,由点及面。

一个团队可以不停歇的埋头干,但是未必会干出成绩。大部分习惯罗列面对的问题,但是对这些问题并没有做一个全局的分析和梳理,其实最难的就在“找问题”上。

2、问题的本质没那么高深

有时我们做一个项目,可能有一个产品需求,大家看完觉得不好做或者做不了,因为系统现在不支持,改造成本太高,并且还伴有很多不确定的技术风险。相信很少有人在这种情况下会无脑的要求加人、加工期来解决这个问题。大多数情况下我们会看有没有捷径或者其他方案,让产品效果达成,哪怕技术实现脏一些、绕一些。

其实这时候横向纵向多挖一下或者多问几个问题,有可能就会有不一样的答案。这个需求在解决用户什么问题,目前这个解决方案是不是业务(产品、技术)上唯一的,这个解决方案会带来哪些成本和新的问题,目前正在推进的其他项目和这个问题会不会有关联,有没有其他团队也在解决类似的问题或者曾经解决过。

3、达成目标

在工作中小到聊定一个API契约、中到上线一个需求、大到完成一次晋升,所有的事情都是有成功的方法的。找出短板、设定计划、抗住挫折、反复训练、根据反馈调优,就可以解决任何问题。《债务危机》的作者——桥水基金 CEO 达里奥总结了一个五步成功法,很有意思:

著名的大数学家波利亚有一本名著《怎样解题》,其中给了一个四步解题法,可能站在研发的角度看会更有感觉:

4、持续学习才是根本

时代在持续发展和变化,现在正是波澜壮阔的年代,在这样的环境下,不管当前如何积累,都有可能随着发展的变化在短时间跌落谷底。公司能发展,一定是在某一个时期内非常契合环境的要求,但随着时间的变化,如果它的变化不能跟上来,那么也只会被时代抛弃。正所谓让你成功的,最终也将让你失败,比如柯达、诺基亚不能幸免,个体也难逃这样的规律。

这样的情况下,持续的学习和改变自身的能力才是研发同学最大、也是最强的优势。技术本身的日新月异要求你持续学习,同样的习惯放射到各个领域上,才会慢慢的取长补短,优化自身,所以如果说研发同学最需要什么,我认为持续的学习能力是最关键的。

正如饿了么创始人汪渊在之前接受采访时有一句话,让我很难忘:最重要的是选择,最困难的是坚持。

作者丨石佳宁

来源丨公众号:阿里巴巴中间件(ID:Aliware_2018)

dbaplus社群欢迎广大技术人员投稿,投稿邮箱:[email protected]

最近在梳理 MySQL 8.0 的新特性,以下是从中选取的 18 个管理相关的新特性。

这 18 个新特性涉及的范围比较广,包括安装、备份、升级、DDL、慢日志、迁移、日常维护等。

掌握这些新特性有助于我们更好地使用 MySQL 8.0。

持久化后的变量会存储在数据目录下的 mysqld-auto.cnf 文件中。

以下是持久化变量相关的命令。

# 持久化变量,同时修改变量的内存值。

SET PERSIST max_connections = 2000;

# 只持久化变量,不修改变量的内存值,适用于只读参数的调整。

SET PERSIST_ONLY back_log = 2000;

# 从 mysqld-auto.cnf 中删除所有持久化变量。

RESET PERSIST;

# 从 mysqld-auto.cnf 中删除指定的变量。如果变量不存在,会报错。

RESET PERSIST system_var_name;

# 从 mysqld-auto.cnf 中删除指定的变量。如果变量不存在,会提示 warning,不报错。

RESET PERSIST IF EXISTS system_var_name;

持久化后的变量即可在 mysqld-auto.cnf 中查看,也可通过 performance_schema.persisted_variables 查看。

管理 IP 通过 admin_address 参数设置,管理端口通过 admin_port 参数设置。

管理连接的数量没有限制,但仅允许具有 SERVICE_CONNECTION_ADMIN 权限的用户连接。

默认情况下,管理接口没有自己的独立线程,可将 create_admin_listener_thread 设置为 ON 开启。

建议设置管理 IP 和端口,这样即使连接数满了,也不用担心登陆不上实例去调整 max_connections 的大小。

从 MySQL 8.0.16 开始,MySQL 针对通用二进制包(Linux - Generic)提供了一个最小化版本。

最小化版本移除了 debug 相关的二进制文件。

MySQL 8.0.31 普通版本(mysql-8.0.31-linux-glibc2.12-x86_64.tar.xz)包的大小是 576.8 MB,而最小化版本(mysql-8.0.31-linux-glibc2.17-x86_64-minimal.tar.xz)只有 57.4 MB。后者大小只是前者的 9.95 %。

从 MySQL 8.0.31 开始,通用二进制包还提供了 Linux - Generic (glibc 2.17) (ARM, 64-bit) 版本的下载。

资源组,可用来控制组内线程的优先级及其能使用的资源,目前,能被管理的资源只有 CPU。

# 创建资源组

CREATE RESOURCE GROUP Batch

TYPE = USER # 资源组的类型,可设置USER(用户资源组),SYSTEM(系统资源组)。

VCPU = 0-1 # 设置 CPU 亲和性,让线程运行在指定的 CPU 上。不设置,则默认会使用所有的 CPU。

THREAD_PRIORITY = 10; # 设置线程优先级,有效值是-20(最高优先级)到19(最低优先级)。不设置,则默认为0。对于系统资源组,可设置的优先级范围是-20到0,对于用户资源组,可设置的优先级范围是0到19。

以下是资源组的几种常用方式。

SET RESOURCE GROUP Batch FOR 702,703; # 将指定线程分配给资源组。702 是线程ID,对应 performance_schema.threads 中的 THREAD_ID。

SET RESOURCE GROUP Batch; # 将当前会话的线程分配给资源组

SELECT /*+ RESOURCE_GROUP(Batch) */ COUNT(*) FROM sbtest.sbtest1;

设置为只读模式的库将禁止任何更新操作。适用于数据库迁移场景。

# 将 mydb 设置为只读模式

ALTER DATABASE mydb READ ONLY = 1;

# 关闭只读模式

ALTER DATABASE mydb READ ONLY = 0;

SHOW PROCESSLIST 默认是从线程管理器中获取线程信息。这种实现方式会持有全局互斥锁,对数据库的性能会有一定的影响。

所以一般都推荐使用 performance_schema.processlist,这种方式不会持有全局锁。

在 MySQL 8.0.22 中,引入了 performance_schema_show_processlist 参数,用来设置 SHOW PROCESSLIST 的实现方式。设置为 ON,则会使用 performance_schema.processlist 这种实现方式,默认为 OFF。

在 MySQL 8.0.27 中,引入了 innodb_ddl_threads 和 innodb_ddl_buffer_size 提升索引的创建速度。

从 MySQL 8.0.12 开始,Online DDL 开始支持 INSTANT 算法。

使用这个算法进行加列操作,只需修改表的元数据信息,操作瞬间就能完成。不过在 MySQL 8.0.29 之前,列只能添加到表的最后位置。

从 MySQL 8.0.29 开始,则移除了这一限制,新增列可以添加到表的任何位置。

不仅如此,从 MySQL 8.0.29 开始,删列操作也可以使用 INSTANT 算法。

这个优化是 MySQL 8.0.23 引入的。在之前的版本中,这些操作会遍历整个 Buffer Pool,删除对应表(或表空间)的数据页。在遍历的过程中,会加锁(latch)。加锁期间,会阻塞所有的 DML 操作。

注意,阻塞时间与 Buffer Pool 的大小有关,与表的大小无关。Buffer Pool 越大,遍历时间会越长,相应的,阻塞时间也会越久。

优化后,待删除的数据页会做异步处理。

从 MySQL 8.0.27 开始,通过 ps 命令可以直接查看 MySQL 的线程名。

# ps -p 22307 H -o "pid tid cmd comm"

PID TID CMD COMMAND

22307 22307 /usr/local/mysql/bin/mysqld mysqld

22307 22316 /usr/local/mysql/bin/mysqld ib_io_ibuf

22307 22318 /usr/local/mysql/bin/mysqld ib_io_log

22307 22319 /usr/local/mysql/bin/mysqld ib_io_rd-1

22307 22331 /usr/local/mysql/bin/mysqld ib_io_rd-2

...

从 MySQL 8.0.28 开始,引入了 connection_memory_limit 参数限制单个用户连接可以使用的最大内存量,global_connection_memory_limit 参数限制所有用户连接可以使用的内存总量。

mysql> SELECT LENGTH(GROUP_CONCAT(f1 ORDER BY f2)) FROM t1;

ERROR 4082 (HY000): Connection closed. Connection memory limit 2097152 bytes exceeded. Consumed 2456976 bytes.

注意,这里说的内存不包括 InnoDB Buffer Pool。

在 MySQL 8.0.14 中,引入了 log_slow_extra 参数,可以将更详细的信息记录到慢日志中。

看下面这个示例,对比下参数开启前后的输出。

# Time: 2022-12-11T08:19:52.135515Z

# User@Host: root[root] @ localhost [] Id: 660

# Query_time: 10.000188 Lock_time: 0.000000 Rows_sent: 1 Rows_examined: 1

SET timestamp=1670746782;

select sleep(10);

# Time: 2022-12-11T08:20:54.397597Z

# User@Host: root[root] @ localhost [] Id: 662

# Query_time: 10.000194 Lock_time: 0.000000 Rows_sent: 1 Rows_examined: 1 Thread_id: 662 Errno: 0 Killed: 0 Bytes_received: 23 Bytes_sent: 57 Read_first: 0 Read_last: 0 Read_key: 0 Read_next: 0 Read_prev: 0 Read_rnd: 0 Read_rnd_next: 0 Sort_merge_passes: 0 Sort_range_count: 0 Sort_rows: 0 Sort_scan_count: 0 Created_tmp_disk_tables: 0 Created_tmp_tables: 0 Start: 2022-12-11T08:20:44.397403Z End: 2022-12-11T08:20:54.397597Z

SET timestamp=1670746844;

select sleep(10);

除此之外,SET timestamp 现在记录的是语句的开始时间,不再是语句的结束时间。

在 MySQL 8.0.30 中,mysqldump 新增了 --mysqld-long-query-time 选项,允许自定义 long_query_time 的会话值。

这样可避免将备份相关的查询语句记录在慢日志中。

克隆插件(Clone Plugin)是 MySQL 8.0.17 引入的一个重大特性。

有了克隆插件,只需一条命令就能很方便地添加一个新的节点,无论是在组复制还是普通的主从环境中。

克隆插件的具体用法及实现细节可参考:MySQL 8.0 新特性之 Clone Plugin

注意,引入备份锁是为了阻塞备份过程中的 DDL,不是为了替代全局读锁。

之所以 XtraBackup 8.0 及 MySQL Enterprise Backup 在备份的过程中不再加全局读锁,主要是因为 performance_schema.log_status 的引入。

数据库升级无需再执行 mysql_upgrade 脚本。升级逻辑已内置到 mysqld 的启动流程中。

升级之前,可通过 MySQL Shell 中的 util.checkForServerUpgrade() 检查实例是否满足升级条件。

mysql 客户端默认会开启 --binary-as-hex。

开启后,mysql 客户端会使用十六进制表示法显示二进制数据。例如,

mysql8.0> SELECT UNHEX(41);

+----------------------+